vectorwin - stock.adobe.com

Storage-Virtualisierung: Vorteile, Einsatz und Anbieter

Speichervirtualisierung fasst heterogene Speicher zu Pools, vereinfacht Betrieb und Migration. Der Vergleich zeigt DataCore, ONTAP, vSAN und Starwind für Cloud und On-Premises.

Speichervirtualisierung bündelt heterogene Datenträger und Arrays zu einem logisch einheitlichen Ressourcenpool. Anwendungen adressieren virtuelle Volumes und LUNs, die Orchestrierung lenkt die I/Os auf die physische Ebene. Das senkt Verwaltungsaufwand, glättet Lastspitzen durch Caching und Tiering und eröffnet Migrationspfade ohne Unterbrechung. In hybriden Architekturen bleibt dieser Layer zentral, auch wenn Cloud-Speicher dominiert. Wer Latenz, Datenhoheit oder spezielle Protokolle am eigenen Standort braucht, virtualisiert gezielt.

Funktionsprinzip und Architektur

Zwischen Host und Speicher liegt eine Virtualisierungsschicht, die Kapazitäten aus lokalen Disks, SAN (Storage Area Network) oder HCI (Hyper-Converged Infrastructure) zusammenführt und in logisch getrennte Einheiten zerlegt. RAID, Snapshots und Replikation schützen die Datenpfade. Thin Provisioning vermeidet Vorabzuweisungen und Quality-of-Service-Funktionen (QoS) priorisieren Workloads.

Netzwerkbasiert geschieht die Abstraktion auf dedizierten Knoten im SAN über Fibre Channel (FC) oder iSCSI. Array-basiert virtualisieren Controller externe Systeme und stellen konsolidierte Volumes bereit. Hostbasiert implementieren HCI-Stacks den Layer im Hypervisor-Cluster und exportieren gemeinsam genutzten Block oder Datei-Storage. Compute-Virtualisierung wie Kernel- oder Paravirtualisierung gehört nicht in diese Kategorie, sie wird nur abgegrenzt.

Datenservices, Latenz und Resilienz

Leistung entsteht aus RAM-Cache, NVMe und Parallelisierung der I/Os. Auto-Tiering und adaptives Placement verschieben heiße Daten auf schnelle Medien. Synchrone Spiegelung erlaubt transparentes Failover ohne Datenverlust, asynchrone Replikation spannt DR-Szenarien über Standorte. Continuous Data Protection (CDP) ergänzt Snapshots für enge Wiederherstellungsziele. Der zusätzliche Layer kann Latenz einführen, die Praxis zeigt aber, dass optimierte Pfade und RDMA die Mehrkosten minimieren. Zentralisierung verlangt Härtung, Verschlüsselung und saubere Rollenmodelle, da der Controller als kritische Instanz agiert.

Die wichtigsten Anbieter im Kurzüberblick

Es gibt verschiedene Anbieter für Storage-Virtualisierung, die sich über Jahre am Markt etabliert haben. An dieser Stelle seien nur einige stellvertretend aufgezählt und umrissen. Die Reihenfolge entspricht keiner Wertung und die Liste hat keinen Anspruch auf Vollständigkeit

IBM SAN Volume Controller abstrahiert seit Jahren große, herstellerübergreifende Landschaften. Der netzwerkbasierte Ansatz steht für klassische Virtualisierung im SAN, gebündelte Pools, stringente Migration und konsistente Services über Fabrics hinweg. In Rechenzentren mit vielen Legacy-Arrays gilt SVC als beliebte Lösung, wenn Konsolidierung ohne Plattformwechsel gefordert ist.

DataCore SANsymphony liefert eine hardwareunabhängige Blockvirtualisierung für SAN und HCI. Die Plattform bündelt heterogene Systeme, steuert Auto Tiering und adaptives Data Placement, beschleunigt durch RAM-Cache und Parallel I/O und bietet synchrone Spiegelung mit transparentem Failover, asynchrone Replikation, Snapshots und Continuous Data Protection. Die Plattform lässt sich über eine Konsole, eine REST API und PowerShell steuern. Sie unterstützt die Protokolle FC, iSCSI und NVMe sowie SAS und SATA, NFS und SMB über Windows File Server. Die Lizenzierung erfolgt kapazitätsbasiert in den Stufen Business Essentials, Standard und Enterprise, ergänzt um eine Backup Repository Edition. DataCore Insight Services analysiert Telemetriedaten mit Machine Learning (ML) und prognostiziert Engpässe. Der Hersteller bietet sowohl einen netzwerkbasierten Ansatz als auch hostbasierte Virtualisierung.

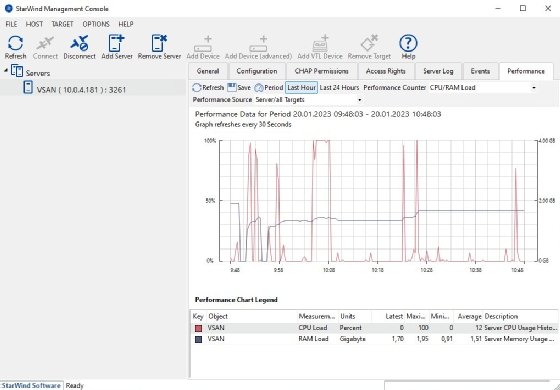

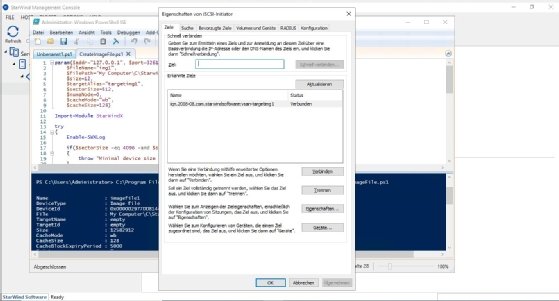

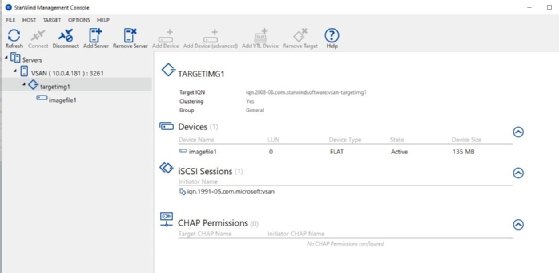

StarWind gehört seit Mai 2025 zu DataCore. Das Portfolio ergänzt SANsymphony um eine kompakte HCI-Schiene für Edge, ROBO und kleinere Umgebungen. Die HyperConverged Appliance setzt auf All-Flash und Zwei-Knoten-Hochverfügbarkeit mit synchroner Replikation. StarWind Virtual SAN bildet gemeinsamen Speicher aus internen Disks der Hosts und adressiert hyperkonvergierte und disaggregierte Topologien. Mit der Übernahme sind diese Funktionen als DataCore-Komponenten verankert und schließen die Lücke zwischen Kernrechenzentrum und Außenstandorten.

VMware vSAN steht seit Jahren für hostbasierte Virtualisierung im vSphere-Cluster. Die enge Verzahnung mit ESXi liefert Policy-basiertes Storage-Management und skaliert linear über Knoten. Der Fokus liegt auf VM-zentrierten Workflows in hyperkonvergierten Umgebungen. Externe Third-Party-Arrays werden nicht virtualisiert, lokale Serverlaufwerke werden zu gemeinsam nutzbaren Datastores konsolidiert.

NetApp ONTAP agiert als einheitliches Storage-Betriebssystem für Block, Datei und Objekt mit nativer Hybrid-Cloud-Integration. FlexVol, FlexClone und Storage Virtual Machines bilden die interne Virtualisierung. AFF und ASA Plattformen liefern niedrige Latenz für geschäftskritische Workloads, FAS-Systeme decken hybriden Sekundärspeicher ab. ONTAP One bündelt Datenservices inklusive Snapshots, Disaster Recovery (DR) und Ransomwarehttps://www.computerweekly.com/de/definition/Hyperscale-Computing-Schutz in einer Lizenz. BlueXP steuert Umgebungen vor Ort und in der Cloud. ONTAP Select bringt den Stack auf Standardserver und Cloud Volumes ONTAP stellt die gleichen Funktionen in Hyperscalern bereit. Die Lösung ist ein Beispiel für Array-basierte Virtualisierung.

Nutanix kombiniert Virtualisierung und Speicher zu einer Web-Scale-Architektur. Die Distributed Storage Fabric aggregiert lokale Flash-Ressourcen der Knoten zu einem Pool und exportiert diesen per NFS, SMB oder iSCSI. Prism vereinfacht Betrieb und Kapazitätsplanung. App Mobility Fabric automatisiert Hochverfügbarkeit und Wiederanlauf und erleichtert einen Hypervisor-Wechsel. Nutzungsnahe Lizenzmodelle und Portabilität unterstützen variable Lastprofile. Auch dies ist eine hostbasierte Virtualisierungslösung.

Segmente und Einsatzprofile

Im Enterprise-Segment dominieren drei Muster. Erstens die netzwerkbasierte Abstraktion heterogener Bestände über IBM SVC für konsolidiert Betrieb über viele Systemgenerationen. Zweitens die softwaredefinierte Virtualisierung über DataCore SANsymphony, die Altinvestitionen mit neuen Medien verbindet und Migrationen ohne Unterbrechung orchestriert. Drittens das einheitliche Betriebssystem ONTAP mit konsistenten Policies für Block, Datei und Objekt bis in die Cloud.

Im Midrange-Bereich setzen viele Umgebungen auf HCI. VMware vSAN und Nutanix adressieren konsistente VM-Workloads mit planbarer Skalierung Knoten für Knoten. DataCore SANsymphony Standard integriert vorhandene Arrays und erweitert Datenservices ohne Hardwarebindung. ONTAP in C-Serien oder FAS konsolidiert Unified-Workloads mit AIOps-gestützter Verwaltung.

Im SMB- und ROBO-Kontext zählen einfache Betriebsmodelle und geringe Stellfläche. StarWind HCA liefert Zwei-Knoten-Hochverfügbarkeit mit synchroner Replikation. StarWind Virtual SAN formt gemeinsamen Speicher aus bestehenden Hosts. DataCore Business Essentials bringt die gleiche Virtualisierungsschicht in kleine Installationen mit hohen Verfügbarkeitsanforderungen. ONTAP Select punktet dort, wo Unified-Features auf Standardservern gefragt sind.

Cloud und Betrieb

ONTAP Select und Cloud Volumes ONTAP sichern identische Datenpfade vor Ort und in Public Clouds. DataCore koppelt Telemetrie und Auswertung in die Cloud und bleibt vor Ort kapazitätslizenziert. Nutanix erweitert HCI-Betrieb auf Bare-Metal-Instanzen in der Public Cloud. Diese Optionen vermeiden Insellösungen und sichern Reversibilität. ONTAP One bündelt Services in einem Paket. DataCore rechnet Kapazität nach Terabyte mit Term- und unbefristeten Lizenzen ab und staffelt Funktionen nach Edition. Nutanix bietet verbrauchsnahe Modelle und Portabilität. Die Wahl folgt der Budgetlogik und dem gewünschten Freiheitsgrad bei Hardware und Hypervisor.

Sonderfall KI und GPU-Workloads

Im Bereich der künstlichen Intelligenz (KI) verlangen Training, Fine Tuning und Inferenz konsistente Durchsätze, kurze Latenzen und deterministisches Verhalten über viele parallele Datenströme hinweg. Speichervirtualisierung stellt dafür einen flachen, hochperformanten Datenpfad bereit und kapselt physische Vielfalt hinter einem einheitlichen Namespace. GPU Direct Storage reduziert Kopierpfade zwischen Storage und GPU-Speicher und entlastet CPUs. RDMA über InfiniBand oder RoCE minimieren Latenz und Jitter.

Parallele Dateisysteme und skalierte Blockpools liefern breite, gleichzeitige I/Os für Datenvorbereitung, Sharding und Checkpointing, während ein mehrstufiges Tiering schnelle NVMe-Schichten für aktive Datensätze und günstigere Kapazität für Archive kombiniert. In Kubernetes-Umgebungen binden CSI-Treiber virtuelle Volumes als persistente oder kurzlebige Speicher ein und erlauben es, Workloads mit ihren Daten zu platzieren. QoS und Quotas sichern Fairness im Mandantenbetrieb, während Snapshots und WORM-Verfahren Modellartefakte und Datasets schützen.

Inferenz profitiert von Caching-Strategien für KV-Caches und Tokenizer-Daten, die lokal auf NVMe vorgehalten und bei Bedarf aus dem virtualisierten Backend aufgefüllt werden. Entscheidend bleibt die Topologie. Der Virtualisierungs-Layer sollte Pfade bevorzugen, die Datenlokalität erhalten, Multipathing und Netzwerkkonvergenz nutzen und Telemetrie in die Orchestrierung zurückspielen, sodass Scheduler-Daten und GPU-Ressourcen zusammengeführt werden. So entsteht ein konsistentes Leistungsprofil vom Edge Cluster bis zum Kernrechenzentrum, ohne die Portabilität von Modellen und Daten zu verlieren.

Fazit

Speichervirtualisierung entkoppelt physische Vielfalt von logischen Anforderungen, hält Migrationen im Fluss und stellt Leistung dort bereit, wo Workloads sie benötigen. IBM SVC konsolidiert bewährt im SAN. DataCore verbindet herstellerneutrale Virtualisierung mit Edge-fähiger HCI durch die Integration von StarWind. VMware vSAN und Nutanix strukturieren HCI in klaren Clustern. NetApp ONTAP bringt Block, Datei, Objekt und Cloud zusammen. Die Entscheidung folgt drei Leitfragen. Wie heterogen ist der Bestand? Welche Latenzziele gelten? Welche Betriebsmodelle sollen von Kern bis Edge ohne Bruch funktionieren?

Aus den drei Leitfragen entsteht ein belastbares Auswahlmuster. Hohe Heterogenität im Bestand und strikte Vorgaben an Verfügbarkeit sprechen für netzwerkbasierte Virtualisierung mit herstellerübergreifender Abstraktion. Hier spielen IBM SAN Volume Controller und DataCore SANsymphony ihre Stärken aus, weil sie gewachsene Landschaften konsolidieren, Funktionen vereinheitlichen und Migrationen ohne Unterbrechung führen.

Klar VM-zentrierte Umgebungen mit homogener Virtualisierung profitieren von hostbasierter Virtualisierung. VMware vSAN und Nutanix bieten ein konsistentes Betriebsmodell, skalieren Knoten für Knoten und bringen Policy-Steuerung nahe an die Workloads. Wer Block, Datei und Objekt unter einem Betriebssystem führen und identische Datenpfade bis in Public Clouds verlängern will, wählt NetApp ONTAP mit Select und Cloud-Variants.

DataCore bindet mit StarWind kompakte HCI für ROBO und KMU an das zentrale Datenfundament an und reduziert Aufwand, Stellfläche und Kosten, ohne auf synchrone Replikation und hohe Verfügbarkeit zu verzichten. Für KI-Arbeitslasten sichern RDMA, GPU Direct Storage und parallele Dateisysteme kurze Pfade und deterministische Latenz; der Virtualisierungslayer priorisiert Datenlokalität und bündelt Telemetrie für den Scheduler, damit Daten und Beschleuniger zusammenfinden.

Kapazitätsbasierte Modelle wie bei DataCore erlauben herstellerneutrale Hardwareentscheidungen. Paketlizenzen wie ONTAP One bündeln Datenservices ohne Nachlizenzierung. Verbrauchsnahe Modelle wie bei Nutanix adressieren variable Lastprofile und Cloud-Nähe. Heterogenität verlangt SAN-zentrierte Abstraktion. Homogenität und VM-Fokus begünstigen HCI. Einheitliche Datenservices über Protokolle und Clouds führen zu ONTAP. Edge Anforderungen können mit DataCore plus StarWind umgesetzt werden. Speichervirtualisierung bleibt die tragende Schicht, die physische Vielfalt in eine beherrschbare, performante und revisionssichere Datenplattform übersetzt.

Storage-Virtualisierung im Kurzüberblick

Prinzip: Bündelt heterogene Speicherressourcen zu logischen Volumes, entkoppelt physische Vielfalt von Anwendungen.

Vorteile: Weniger Verwaltungsaufwand, flexible Migrationen, Lastverteilung durch Caching und Tiering, hohe Verfügbarkeit durch Spiegelung und Replikation.

Ansätze:

- Netzwerkbasiert – zum Beispiel IBM SVC, DataCore SANsymphony

- Array-basiert – beispielsweise NetApp ONTAP, Dell EMC, HPE

- Hostbasiert (HCI) – zum Beispiel VMware vSAN, Nutanix, DataCore/StarWind

Einsatzfelder:

- Enterprise: Konsolidierung heterogener Landschaften

- Midrange: HCI für VM-Workloads

- SMB/ROBO: kompakte Lösungen mit hoher Verfügbarkeit

Trends: Integration in Cloud-Umgebungen, optimierte Pfade für KI- und GPU-Workloads, flexible Lizenz- und Betriebsmodelle.