Virtualisierung

Unter Virtualisierung versteht man die Erstellung einer virtuellen - und nicht einer realen - Version von etwas, zum Beispiel eines Betriebssystems (OS), eines Servers, eines Speichergeräts oder von Netzwerkressourcen.

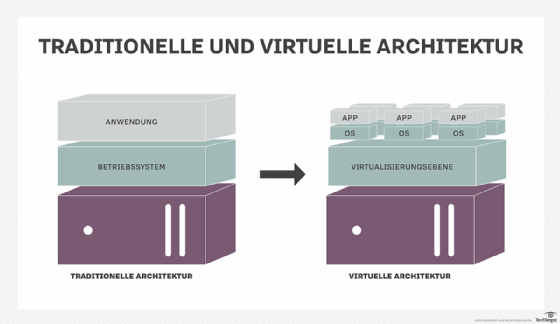

Bei der Virtualisierung wird Software eingesetzt, die Hardwarefunktionen simuliert, um ein virtuelles System zu erstellen. Auf diese Weise können IT-Organisationen mehrere Betriebssysteme, mehr als ein virtuelles System und verschiedene Anwendungen auf einem einzigen Server betreiben. Zu den Vorteilen der Virtualisierung gehören eine höhere Effizienz und Größenvorteile.

Unter Betriebssystemvirtualisierung versteht man den Einsatz von Software, die es einer Hardware ermöglicht, mehrere Betriebssystem-Images gleichzeitig auszuführen. Die Technologie wurde vor Jahrzehnten auf Mainframes eingeführt, damit Administratoren keine teure Rechenleistung verschwenden mussten.

Die Funktionsweise von Virtualisierung erklärt

Virtualisierung beschreibt eine Technologie, die eine Anwendung, ein Gastbetriebssystem (Guest) oder einen Datenspeicher von der tatsächlich zugrunde liegenden Hardware oder Software abstrahiert. Ein wichtiges Anwendungsgebiet ist die Servervirtualisierung, bei der eine Softwareschicht – Hypervisor genannt –die zugrunde liegende Hardware emuliert. Das umfasst häufig den Arbeitsspeicher, die Ein- und Ausgabe (E/A, Input/Output, I/O) und den Netzwerkverkehr der CPU (Central Processing Unit, Prozessor). Hypervisoren nehmen die physischen Ressourcen und trennen sie, damit die virtuelle Umgebung sie verwenden kann. Sie können auf einem Betriebssystem sitzen oder direkt auf der Hardware installiert werden. Letzteres ist die weiter verbreitete Variante.

Mit der Hilfe des Hypervisors führt das Gastbetriebssystem, das normalerweise direkt mit Hardware interagiert, seine Operationen jetzt mit einer Softwareemulation dieser Hardware durch. Auf der Ebene des Gastbetriebssystem ist nicht sichtbar, ob es sich um physische oder virtuelle Hardware handelt. Während die Leistung dieses virtuellen Systems nicht der Leistung des Betriebssystems entspricht, das auf echter Hardware ausgeführt wird, funktioniert das Konzept der Virtualisierung, da die meisten Gastbetriebssysteme und -Anwendungen die zugrundeliegende Hardware nicht vollständig benötigen.

Das ermöglicht eine größere Flexibilität, Kontrolle und Isolation, indem die Abhängigkeit von einer bestimmten Hardwareplattform beseitigt wird. Während das Konzept der Virtualisierung ursprünglich für die Servervirtualisierung gedacht war, hat es sich auf Anwendungen, Netzwerke, Daten und Desktops ausgeweitet. Der Virtualisierungsprozess führt die folgenden Schritte aus:

- Hypervisoren trennen die physischen Ressourcen von ihren physischen Umgebungen.

- Ressourcen werden nach Bedarf von der physischen Umgebung auf die verschiedenen virtuellen Umgebungen übertragen.

- Systembenutzer arbeiten mit der virtuellen Umgebung und führen Aufgaben durch.

- Sobald die virtuelle Umgebung läuft, kann ein Benutzer oder Programm eine Anweisung senden, die zusätzliche Ressourcen für die physische Umgebung erfordert. Als Antwort leitet der Hypervisor die Nachricht an das physische System weiter und speichert die Änderungen. Dieser Prozess läuft fast genauso schnell ab, wie ohne den Hypervisor.

Die virtuelle Umgebung wird häufig als Gastmaschine oder virtuelle Maschine bezeichnet. Die VM verhält sich wie eine einzelne Datei, die von einem Computer auf einen anderen übertragen und in beiden geöffnet werden kann. Sie sollte auf jedem Computer die gleiche Leistung erbringen.

Verschiedene Typen der Virtualisierung

Jeder, der schon einmal seine Festplatte partitioniert hat, hat eine Virtualisierung durchgeführt. Eine Partition ist die logische Aufteilung eines Festplattenlaufwerks, um zwei separate Festplatten zu erstellen. Es gibt sechs Bereiche der IT, in denen die Virtualisierung eine zentrale Rolle spielt:

- Die Netzwerkvirtualisierung ist eine Methode zum Kombinieren der verfügbaren Ressourcen in einem Netzwerk, bei der die verfügbare Bandbreite in Kanäle aufgeteilt wird, von denen jeder unabhängig von den anderen ist und in Echtzeit einem bestimmten Server oder Gerät zugewiesen oder neu zugewiesen werden kann. Die Idee ist, dass die Virtualisierung die Komplexität des Netzwerks verschleiert, indem sie es in leicht zu bewältigende Teile aufteilt, ähnlich wie eine partitionierte Festplatte die Verwaltung von Dateien erleichtert.

- Bei der Speichervirtualisierung wird physischer Speicher von mehreren Netzwerkspeichergeräten zu einem einzigen Speichergerät zusammengefasst, das sich von einer zentralen Konsole aus verwalten lässt. Speichervirtualisierung wird häufig in Speichernetzwerken verwendet.

- Servervirtualisierung ist die Maskierung von Serverressourcen – einschließlich der Anzahl und Identität einzelner physischer Server, Prozessoren und Betriebssysteme – für Serverbenutzer. Ziel ist es, dem Benutzer das Erlernen und Verwalten komplizierter Serverressourceneinstellungen zu ersparen, während die gemeinsame Nutzung die Auslastung von Ressourcen erhöht und die Möglichkeit späterer Erweiterungen beibehalten wird. Die Softwareschicht, die diese Abstraktion ermöglicht, wird häufig als Hypervisor bezeichnet.

Der häufigste Hypervisor – Typ 1 – sitzt direkt auf Bare-Metal und bietet die Möglichkeit, Hardwareplattformen für die Verwendung durch die virtuellen Maschinen zu virtualisieren. Die KVM-Virtualisierung ist ein Linux-Kernel-basierter Virtualisierungshypervisor, der ähnliche Virtualisierungsvorteile wie andere Hypervisoren vom Typ 1 bietet. KVM ist Open-Source-lizenziert. Ein Hypervisor vom Typ 2 erfordert ein Host-Betriebssystem und wird häufiger für Tests und Labore verwendet. - Bei der Datenvirtualisierung werden die traditionellen technischen Details der Daten und des Datenmanagements wie Standort, Leistung oder Format zugunsten eines breiteren Zugriffs und einer höheren Ausfallsicherheit in Abhängigkeit von den Geschäftsanforderungen abstrahiert.

- Bei der Desktop-Virtualisierung wird ein Arbeitsplatt statt eines Servers virtualisiert. Auf diese Weise kann der Benutzer remote auf den Desktop zugreifen, normalerweise mit einem Thin Clients am Schreibtisch. Da die Workstation im Wesentlichen auf einem Rechenzentrumserver ausgeführt wird, kann der Zugriff darauf sowohl sicherer als auch portabler sein. Administratoren sollten auf passende Betriebssystemlizenzen und Infrastrukturen achten.

- Durch die Anwendungsvirtualisierung wird die Anwendungsschicht vom Betriebssystem abgelöst. Auf diese Weise können Nutzer die Anwendung in gekapselter Form ausführen, unabhängig vom darunter liegenden Betriebssystem. Auf diese Weise kann eine Windows-Anwendung auf Linux laufen und umgekehrt. Außerdem kann eine Isolationsschicht hinzugefügt werden.

Virtualisierung kann als Teil eines allgemeinen Trends in der Unternehmens-IT betrachtet werden, zu dem auch Autonomic Computing gehört, ein Szenario, in dem die IT-Umgebung in der Lage sein wird, sich selbst auf der Grundlage der wahrgenommenen Aktivität zu verwalten, und Utility Computing, bei dem die Rechenleistung eines Computers als ein Dienstprogramm betrachtet wird, für das Kunden nur bei Bedarf bezahlen. Das übliche Ziel der Virtualisierung ist die Zentralisierung von Verwaltungsaufgaben bei gleichzeitiger Verbesserung der Skalierbarkeit und der Arbeitslasten.

Virtualsierung offeriert mehrere Vorteile

Eine virtualisierte Umgebung bietet folgende Vorteile:

- Geringere Kosten. Durch die Virtualisierung wird die Anzahl der Hardwareserver reduziert, die in einem Unternehmen und einem Rechenzentrum erforderlich sind. Dies senkt die Gesamtkosten (TCO, Total Cost of Ownership) für den Kauf und die Wartung großer Hardwaremengen.

- Einfachere Notfallwiederherstellung. In einer virtualisierten Umgebung ist Disaster Recovery (DC) einfacher, als in nicht-virtualisierten. Regelmäßige Snapshots liefern aktuelle Daten, sodass virtuelle Maschinen problemlos gesichert und wiederhergestellt werden können. Im Notfall können Admins eine virtuelle Maschine innerhalb von Minuten an einen neuen Speicherort migrieren.

- Einfachere Tests. Das Testen ist in einer virtuellen Umgebung weniger kompliziert. Selbst bei großen Fehlern, müssen Nutzer den Test nicht anhalten und von vorne anfangen. Das System kann einfach zum vorherigen Schnappschuss zurückkehren und mit dem Test fortfahren.

- Schnellere Backups. Backups können sowohl von virtuellen Servern als auch von virtuellen Maschinen erstellt werden. Im Laufe des Tages erstellt die Virtualisierungsplattform automatische Schnappschüsse, um sicherzustellen, dass alle Daten auf dem neuesten Stand sind. Darüber hinaus können die virtuellen Maschinen problemlos migriert und effizient erneut bereitgestellt werden.

- Höhere Produktivität. Weniger physische Ressourcen führen zu weniger Zeitaufwand für die Verwaltung und Wartung der Server. Aufgaben, die in einer physischen Umgebung Tage oder Wochen dauern können, können in Minuten erledigt werden. Auf diese Weise können Mitarbeiter den größten Teil ihrer Zeit für produktivere Aufgaben wie die Steigerung der Einnahmen und die Förderung von Geschäftsinitiativen aufwenden.

Nutzen der Virtualisierung

Virtualisierung bietet Unternehmen den Vorteil, ihre Leistung zu maximieren. Zu den zusätzlichen Vorteilen für Unternehmen und Rechenzentren gehören:

- Spezialisierte Server. Die Virtualisierung bietet eine kostengünstige Möglichkeit, E-Mail-, Datenbank- und Webserver zu trennen und ein umfassenderes und zuverlässigeres System zu schaffen.

- Beschleunigte und wiederholbare Bereitstellung. Wenn ein physischer Server abstürzt, ist der Sicherungsserver möglicherweise nicht immer bereit oder aktuell. Nicht in jedem Fall ist auch ein Image oder Klon des Servers verfügbar. In einem virtuellen Rechenzentrum ist der Vorgang schnell und einfach. Virtuelle Sicherungstools wie Veeam können diesen Vorgang auf Minuten verkürzen.

- Weniger Abwärme und geringer Energiebedarf. Unternehmen, die viele Hardwareserver verwenden, haben meist mit der Hitzeabgabe ihrer physischen Ressourcen zu kämpfen. Virtualisierung reduziert die Zahl der erforderlichen Hardwaregeräte und senkt somit die Temperatur im Serverraum.

- Umweltschutz. Mit der Zahl der Server und zugehörigen Geräte steigt der Strombedarf und die Menge der zu entsorgenden und neu anzuschaffenden Hardware. Damit vergrößert sich auch der der CO2-Fußabdruck. Durch Virtualisierung können Unternehmen diese Effekte abmildern, indem die erforderliche Menge an Kühlung und Strom erheblich verringert wird,

- Einfachere Migration in die Cloud. Die Virtualisierung bringt Unternehmen einer vollständig Cloud-basierten Umgebung näher. Virtuelle Maschinen lassen sich sogar vom Rechenzentrum aus bereitstellen, um eine Cloud-basierte Infrastruktur aufzubauen. Die Möglichkeit, eine Cloud-basierte Denkweise mit Virtualisierung zu verbinden, macht die Migration in die Cloud noch einfacher.

- Geringere Abhängigkeit von Anbietern. Virtuelle Maschinen sind in der Hardwarekonfiguration agnostisch. Infolgedessen bedeutet die Virtualisierung von Hardware und Software, dass ein Unternehmen für diese physischen Ressourcen nicht von einem Anbieter abhängig sein muss.

Einschränkungen der Virtualisierung

Vor dem Wechsel auf eine virtualisierte Umgebung müssen Unternehmen die Einstiegskosten bedenken. Die erforderlichen Investitionen in Virtualisierungssoftware sowie in neue, virtualisierungsfähige Hardware können hoch sein.

Wenn die vorhandene Infrastruktur älter als fünf Jahre ist, ist meistens eine Modernisierung notwendig. Glücklicherweise ist in vielen Unternehmen bereits die Fähigkeit vorhanden, Virtualisierung zu ermöglichen, ohne viel Geld auszugeben. Darüber hinaus können die Kosten durch die Zusammenarbeit mit einem Managed Service Provider ausgeglichen werden, der monatliche Leasing- oder Kaufoptionen anbietet.

Außerdem sind Softwarelizenzen ein Faktor, der die Virtualisierung erheblich verkomplizieren kann. Unternehmen müssen sicherstellen, dass sie ein klares Verständnis davon haben, wie ihre Anbieter die Verwendung der Software in einer virtualisierten Umgebung sehen. Einschränkungen kommen immer seltener vor, da sich immer mehr Softwareanbieter sich an den zunehmenden Einsatz von Virtualisierung anpassen. Die Umstellung auf Virtualisierung nimmt Zeit in Anspruch und kann erfordern, dass Administratoren sich viel neues Wissen aneignen. Für die Implementierung und Steuerung einer virtualisierten Umgebung müssen Unternehmen ihre IT-Mitarbeiter schulen und sicherstellen, dass sie über Kenntnisse in der Virtualisierung verfügen. Darüber hinaus passen sich einige Anwendungen nicht gut an, wenn sie in eine virtuelle Umgebung gebracht werden. IT-Mitarbeiter müssen auf diese Herausforderung vorbereitet sein und sie vor der Konvertierung angehen. Mit der Virtualisierung sind auch Sicherheitsrisiken verbunden.

Daten sind entscheidend für den Erfolg eines Unternehmens und daher ein häufiges Ziel von Angriffen. Die Wahrscheinlichkeit eines Datenverstoßes steigt bei Verwendung von Virtualisierung erheblich.