Servervirtualisierung

Was ist Servervirtualisierung?

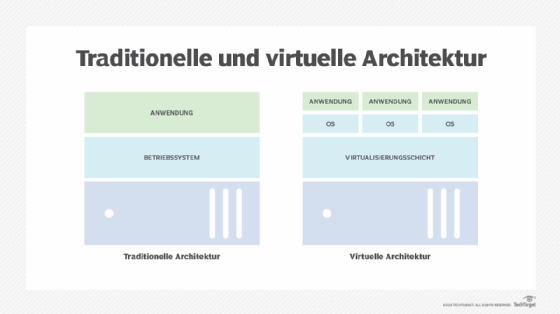

Servervirtualisierung ist ein Prozess, bei dem mehrere virtuelle Instanzen auf einem einzigen Server erstellt und abstrahiert werden. Bei der Servervirtualisierung werden auch Serverressourcen abstrahiert oder maskiert, einschließlich der Anzahl und Identität der einzelnen physischen Maschinen, Prozessoren und verschiedenen Betriebssystemen.

Herkömmliche Computerhardware und -software unterstützte in der Regel einzelne Anwendungen. Dadurch waren die Server oft gezwungen, jeweils nur eine einzige Arbeitslast auszuführen, wodurch ungenutzte Prozessoren, Memory-Kapazitäten und andere Hardwareressourcen wie die Netzwerkbandbreite verschwendet wurden. Die Anzahl der Serverhardware stieg sprunghaft an, als Unternehmen immer mehr Anwendungen und Dienste im gesamten Unternehmen einsetzten. Die entsprechenden Kosten und die steigenden Anforderungen an Platz, Strom, Kühlung und Konnektivität brachten Rechenzentren an ihre Grenzen.

Mit dem Aufkommen der Servervirtualisierung änderte sich das. Bei der Virtualisierung wird einem Computer eine Softwareschicht, ein so genannter Hypervisor, hinzugefügt, der die zugrunde liegende Hardware von der gesamten darüber laufenden Software abstrahiert. Bei der Virtualisierung werden physische Ressourcen in virtuelle – logische – Äquivalente umgewandelt. Der Hypervisor organisiert und verwaltet dann die virtualisierten Ressourcen des Computers und stellt diese virtualisierten Ressourcen in logischen Instanzen bereit, die als virtuelle Maschinen (VMs) bezeichnet werden und jeweils als separater und unabhängiger Server funktionieren können.

Der Schlüssel hierzu ist die Ressourcennutzung. Die vom Hypervisor verwaltete Virtualisierung kann mehrere VMs gleichzeitig erstellen und ausführen, die aus den verfügbaren Ressourcen des Computers aufgebaut sind. Durch Virtualisierung kann ein Computer die Arbeit von mehreren Computern übernehmen und bis zu 100 Prozent der verfügbaren Hardware des Servers nutzen, um mehrere Arbeitslasten gleichzeitig zu bewältigen. Das reduziert die Anzahl der Server, entlastet die Einrichtungen des Rechenzentrums, verbessert die IT-Flexibilität und senkt die IT-Kosten für das Unternehmen.

Virtualisierung hat das Gesicht des Enterprise Computing verändert, aber die vielen Vorteile werden manchmal durch Faktoren wie Lizenzierung und Verwaltungskomplexität sowie potenzielle Verfügbarkeits- und Ausfallzeitprobleme geschmälert. Unternehmen müssen verstehen, was Virtualisierung ist, wie sie funktioniert, welche Kompromisse sie eingeht und welche Anwendungsfälle es gibt. Nur dann kann ein Unternehmen Virtualisierung effektiv im gesamten Rechenzentrum einführen und einsetzen.

Warum ist Servervirtualisierung wichtig?

Um die Rolle der Virtualisierung im modernen Unternehmen zu verstehen, sollten Sie einen Blick in die IT-Geschichte werfen.

Virtualisierung ist keine neue Idee. Die Technologie wurde erstmals in den 1960er Jahren in der frühen Ära der Mainframes als Mittel zur Unterstützung des Mainframe-Time-Sharing eingesetzt, bei dem die beträchtlichen Hardwareressourcen des Mainframes aufgeteilt werden, um mehrere Arbeitslasten gleichzeitig auszuführen. Die Virtualisierung war eine ideale und unverzichtbare Ergänzung für Mainframes, da die beträchtlichen Kosten und die Komplexität von Mainframes deren Einsatz auf ein einziges System beschränkten – Unternehmen mussten die Investition optimal nutzen.

Mit dem Aufkommen der x86-Computerarchitekturen wurden in den 1980er Jahren leicht verfügbare, einfache und kostengünstige Computergeräte eingeführt. Unternehmen wandten sich von Mainframes ab und setzten auf individuelle Computersysteme, um jede Unternehmensanwendung für eine wachsende Zahl von Benutzer- oder Client-Endpunkt-Computern zu hosten oder bereitzustellen. Da die einzelnen x86-Computer einfach waren und nur über eine begrenzte Verarbeitungs-, Memory- und Storage-Kapazität verfügten, konnten die x86-Computer und ihre Betriebssysteme in der Regel nur eine einzige Anwendung unterstützen. Ein großer, gemeinsam genutzter Computer wurde durch viele kleine, billige Computer ersetzt. Virtualisierung war nicht mehr notwendig, und ihre Verwendung verschwand zusammen mit den Mainframes in der Versenkung.

Es gab jedoch zwei Faktoren, die die Rückkehr der Virtualisierungstechnologie in das moderne Unternehmen vorantrieben. Erstens entwickelte sich die Computerhardware schnell und dramatisch. Anfang der 2000er Jahre verfügten typische Unternehmensserver routinemäßig über mehrere Prozessoren und weit mehr Memory und Storage, als die meisten Unternehmensanwendungen realistischerweise nutzen konnten. Das führte zu einer Verschwendung von Ressourcen und Investitionen, da die überschüssige Rechenkapazität auf jedem Server ungenutzt blieb. Es kam häufig vor, dass ein Unternehmensserver nur 15 Prozent bis 25 Prozent seiner verfügbaren Ressourcen nutzte.

Der zweite Faktor war eine harte Begrenzung der Einrichtungen. Unternehmen beschafften und installierten einfach zusätzliche Server, wenn weitere Arbeitslasten zum Repertoire der Unternehmensanwendungen hinzukamen. Mit der Zeit drohte die schiere Anzahl der betriebenen Server den Platz, die Kühlkapazität und die Stromverfügbarkeit eines Rechenzentrums zu überfordern. In den frühen 2000er Jahren gab es große Probleme mit der Energieverfügbarkeit, -verteilung und -kosten. Der Trend zu immer mehr Servern und vergeudeten Ressourcen war unhaltbar.

Die Servervirtualisierung kam in den späten 1990er Jahren mit einigen grundlegenden Produkten und Services wieder auf, aber erst mit der Veröffentlichung von VMwares ESX Server 1.0 im Jahr 2001 hatten Unternehmen endlich Zugang zu einer produktionsreifen Virtualisierungsplattform. In den folgenden Jahren wurden weitere Virtualisierungsprodukte des Xen-Projekts, Microsofts Hyper-V mit Windows Server 2008 und andere eingeführt. Die Virtualisierung wurde stabiler und leistungsfähiger, und die Einführung von Docker im Jahr 2013 läutete die Ära der virtualisierten Container ein, die im Vergleich zu herkömmlichen VMs eine höhere Geschwindigkeit und Skalierbarkeit für Microservices-Anwendungsarchitekturen bieten.

Die heutigen Virtualisierungsplattformen basieren auf den gleichen funktionalen Ideen wie ihre frühen Mainframe-Pendants. Virtualisierung abstrahiert die Software von der zugrunde liegenden Hardware und ermöglicht so die Bereitstellung und Verwaltung virtualisierter Ressourcen als isolierte und unabhängige logische Instanzen – ein physischer Server wird effektiv in mehrere virtuelle Server umgewandelt, von denen jeder unabhängig arbeiten kann, um mehrere Anwendungen zu unterstützen, die gleichzeitig auf demselben physischen Computer laufen.

Die Bedeutung der Servervirtualisierung ist tiefgreifend, da sie zwei Probleme angeht, die das Enterprise Computing im 21. Jahrhundert aufweist. Die Virtualisierung verringert die Anzahl der physischen Server und ermöglicht es einem Unternehmen, die Anzahl der physischen Server im Rechenzentrum zu reduzieren – oder wesentlich mehr Arbeitslasten auszuführen, ohne zusätzliche Server zu benötigen. Diese Technik wird als Serverkonsolidierung bezeichnet. Durch die geringere Anzahl von Servern werden auch Platz, Strom und Kühlung im Rechenzentrum eingespart, wodurch der Bau neuer Rechenzentren oft vermieden oder sogar überflüssig gemacht werden kann. Darüber hinaus bieten Virtualisierungsplattformen routinemäßig leistungsstarke Funktionen wie zentralisierte VM-Verwaltung, VM-Migration – damit kann eine VM problemlos von einem System auf ein anderes verschoben werden – und Schutz von Arbeitslasten und Daten durch Backups und Snapshots.

Virtualisierung ist auch ein Eckpfeiler moderner Cloud-Dienste. Durch die Überwindung der Beschränkungen physischer Serverumgebungen stellt die Virtualisierung einen Hauptmechanismus dar, der flexible, hoch konsolidierte, hocheffiziente, softwaregesteuerte Rechenzentren ermöglicht, die für praktisches Cloud Computing unerlässlich sind. Ohne Servervirtualisierung und andere Virtualisierungstechnologien wie die Netzwerkvirtualisierung gäbe es keine Cloud.

Wie funktioniert die Servervirtualisierung?

Bei der Servervirtualisierung wird die Hardware eines Computers von der gesamten Software abstrahiert oder isoliert, die auf dieser Hardware laufen könnte. Diese Abstraktion wird durch einen Hypervisor erreicht, ein spezielles Softwareprodukt, das auf einem physischen Computer installiert werden muss. Im Unternehmensbereich gibt es zahlreiche Hypervisoren, darunter Microsoft Hyper-V und VMware vSphere.

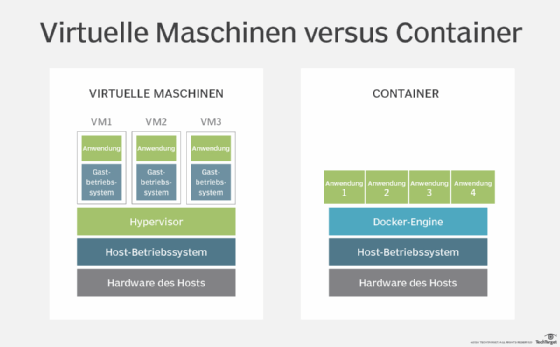

Die spätere Einführung von virtuellen Containern als Virtualisierungsalternative, verwendet eine Hypervisor-Variante, die als Container-Engine bezeichnet wird, wie zum Beispiel Docker oder Apache Mesos. Obwohl sich die Eigenschaften und das Verhalten von Containern geringfügig von denen ihrer VM-Pendants unterscheiden, sind die zugrunde liegenden Ziele der Ressourcenabstraktion, -bereitstellung und -verwaltung identisch.

Die Abstraktion erkennt die physischen Ressourcen des Computers – einschließlich Prozessoren, Memory, Storage-Volumes und Netzwerkschnittstellen – und erstellt logische Aliasnamen für diese Ressourcen. Ein physischer Prozessor kann beispielsweise in eine logische Repräsentation abstrahiert werden, die als virtuelle CPU (vCPU) bezeichnet wird. Der Hypervisor ist für die Verwaltung aller virtuellen Ressourcen zuständig, die er abstrahiert, und wickelt den gesamten Datenaustausch zwischen den virtuellen Ressourcen und ihren physischen Gegenstücken ab.

Die eigentliche Leistung eines Hypervisors liegt nicht in der Abstraktion, sondern darin, was mit diesen abstrahierten Ressourcen gemacht werden kann. Ein Hypervisor verwendet virtualisierte Ressourcen, um logische Repräsentationen von Computern, so genannte VMs, zu erstellen. Einer VM werden virtualisierte Prozessoren, Memory, Storage, Netzwerkadapter und andere virtualisierte Elemente (zum Beispiel GPUs) zugewiesen, die vom Hypervisor verwaltet werden. Wenn ein Hypervisor eine VM bereitstellt, ist die daraus resultierende logische Instanz vollständig von der zugrunde liegenden Hardware und allen anderen vom Hypervisor eingerichteten VMs isoliert. Das bedeutet, dass eine VM weder direkt vom zugrunde liegenden physischen Computer noch von anderen VMs, die die Ressourcen des physischen Computers gemeinsam nutzen, abhängig ist oder davon Kenntnis hat.

Diese logische Isolierung in Verbindung mit einer sorgfältigen Ressourcenverwaltung ermöglicht es einem Hypervisor, mehrere VMs auf demselben physischen Computer gleichzeitig zu erstellen und zu steuern, wobei jede VM als vollständiger, voll funktionsfähiger Computer fungieren kann. Die Virtualisierung ermöglicht es einem Unternehmen, aus einem einzigen physischen Server mehrere virtuelle Server zu erstellen. Sobald eine VM eingerichtet ist, benötigt sie eine komplette Softwareinstallation, einschließlich ihres eigenen Betriebssystems, Treibern, Bibliotheken und der gewünschten Unternehmensanwendung. Auf diese Weise kann ein Unternehmen mehrere Betriebssysteme verwenden, um eine breite Palette von Arbeitslasten auf demselben physischen Computer zu unterstützen. Beispielsweise kann eine VM eine Windows-Server-Version zur Ausführung einer Windows-Anwendung verwenden, während eine andere VM auf demselben Computer eine Linux-Variante zur Ausführung einer Linux-Anwendung nutzen kann.

Die durch die Virtualisierung ermöglichte Abstraktion verleiht VMs eine außerordentliche Flexibilität, die mit herkömmlichen physischen Computern und physischen Softwareinstallationen nicht möglich ist. Alle VMs existieren und laufen im physischen Memory eines Computers, so dass VMs einfach als gewöhnliche Memory-Image-Dateien gespeichert werden können. Diese gespeicherten Dateien können verwendet werden, um schnell Duplikate oder Klone von VMs auf demselben oder anderen Computern im Unternehmen zu erstellen oder um die VM zu diesem Zeitpunkt zu speichern. Ebenso kann eine VM einfach von einem virtualisierten Computer auf einen anderen verschoben werden, indem die gewünschte VM aus dem Memory-Bereich eines Quellcomputers in einen Memory-Bereich eines Zielcomputers kopiert und dann die ursprüngliche VM vom Quellcomputer gelöscht wird. In den meisten Fällen kann die Migration ohne Unterbrechung der VM oder der Benutzererfahrung erfolgen.

Obwohl es durch Virtualisierung möglich ist, mehrere logische Computer aus einem einzigen physischen Computer zu erstellen, ist die tatsächlich Anzahl der VMs, die erstellt werden können, durch die auf dem Host-Computer vorhandenen physischen Ressourcen und die von den Unternehmensanwendungen, die in diesen VMs ausgeführt werden, gestellten Rechenanforderungen begrenzt. Ein Computer mit CPUs und 64 GB Memory kann beispielsweise bis zu vier VMs mit je einer vCPU und 16 GB virtualisiertem Memory hosten. Sobald eine VM erstellt ist, können die abstrahierten Ressourcen, die der VM zugewiesen sind, geändert werden, um die Leistung der VM zu optimieren und die Anzahl der auf dem System gehosteten VMs zu maximieren.

Auf neueren und ressourcenintensiveren Computern kann eine größere Anzahl von VMs gehostet werden, während auf älteren Systemen oder solchen mit rechenintensiven Arbeitslasten möglicherweise weniger VMs gehostet werden. Es ist möglich, dass der Hypervisor Ressourcen mehr als einer VM zuweist – eine Praxis, die als Overcommitment bezeichnet wird –, aber davon wird wegen der entstehenden Leistungseinbußen abgeraten, da das System alle übermäßig belegten Ressourcen zeitlich aufteilen muss. Die schnelle Verfügbarkeit leistungsstarker Computer macht Overcommitment fast überflüssig, da die Nachteile von Overcommitment die Vorteile einer weiteren VM auf einem physischen Server bei weitem überwiegen. Es ist einfacher und besser, die zusätzliche VM einfach auf einem anderen System bereitzustellen, auf dem Ressourcen verfügbar sind.

Was sind die Vorteile der Servervirtualisierung?

Virtualisierung bringt dem Unternehmen eine ganze Reihe von technischen und geschäftlichen Vorteilen. Hier sind einige der wichtigsten und gängigsten Vorteile:

- Serverkonsolidierung: Da Virtualisierung es einem physischen Server ermöglicht, die Arbeit mehrerer Server zu übernehmen, kann die Gesamtzahl der Server im Unternehmen reduziert werden. Dieser Prozess wird als Serverkonsolidierung bezeichnet. Nehmen wir zum Beispiel an, es gibt derzeit zwölf physische Server, auf denen jeweils eine einzige Anwendung läuft. Mit Einführung der Virtualisierung kann jeder physische Server drei VMs hosten, wobei auf jeder VM eine Anwendung läuft. Dann benötigt das Unternehmen nur noch vier physische Server, um die gleichen zwölf Arbeitslasten auszuführen.

- vereinfachte physische Infrastruktur: Mit weniger Servern wird die Anzahl der Racks und Kabel im Rechenzentrum drastisch reduziert. Das vereinfacht die Bereitstellung und Fehlerbehebung. Das Unternehmen kann die gleichen Rechenziele mit einem Bruchteil des Platzes, der Energie und der Kühlung erreichen, die für die physischen Server erforderlich sind.

- geringere Kosten für Hardware und Einrichtungen: Serverkonsolidierung senkt die Kosten für die Hardware des Rechenzentrums sowie für die Einrichtungen – es werden weniger Strom und Kühlung benötigt. Serverkonsolidierung durch Virtualisierung ist für Unternehmen mit einer großen Anzahl von Servern eine wichtige Taktik zur Kosteneinsparung und war in den 2000er-Jahren einer der Hauptgründe für die frühe Einführung der Virtualisierung.

- größere Vielseitigkeit der Server: Da jede VM eine eigene, unabhängige Instanz darstellt, muss auf jeder VM ein unabhängiges Betriebssystem laufen. Das Betriebssystem kann jedoch zwischen den VMs variieren, so dass das Unternehmen jede gewünschte Anzahl von Windows, Linux und anderen Betriebssystemen auf derselben physischen Hardware einsetzen kann. Diese Flexibilität ist bei herkömmlichen physischen Serverimplementierungen unübertroffen.

- verbesserte Verwaltung: Virtualisierung zentralisiert die Ressourcensteuerung und die Erstellung von VM-Instanzen. Moderne Virtualisierung bietet eine Fülle von Tools und Funktionen, die IT-Administratoren die Kontrolle und Aufsicht über die virtualisierte Umgebung ermöglichen. Live-Migrationsfunktionen ermöglichen es beispielsweise, eine VM zwischen zwei physischen Servern zu verschieben, ohne die Arbeitslast zu unterbrechen. Datensicherungsfunktionen, wie zum Beispiel Snapshots, können den Zustand einer VM zu jedem beliebigen Zeitpunkt erfassen, so dass die VM bei unerwarteten Fehlern oder Katastrophen schnell und einfach wiederhergestellt werden kann. Virtualisierung eignet sich gut für eine zentralisierte Verwaltung, so dass Administratoren alle VMs in der Umgebung sehen und Patches oder Updates mit geringerer Fehlerwahrscheinlichkeit bereitstellen können.

Was sind die Nachteile der Servervirtualisierung?

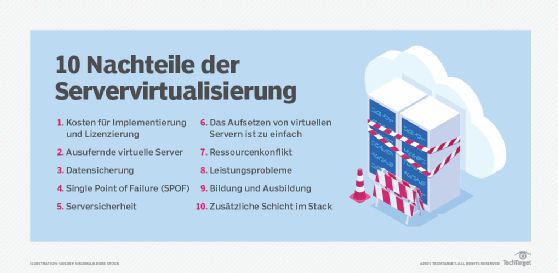

Obwohl die Servervirtualisierung eine Vielzahl potenzieller Vorteile für Unternehmen mit sich bringt, gibt es durch die zusätzlichen Software- und Verwaltungsimplikationen der Virtualisierungssoftware zahlreiche mögliche Nachteile, die Unternehmen berücksichtigen sollten:

- Risiko und Verfügbarkeit: Die Ausführung mehrerer Workloads auf demselben physischen Computer birgt Risiken für das Unternehmen. Vor der Einführung der Virtualisierung betraf ein Serverausfall nur die zugehörige Arbeitslast. Mit Virtualisierung kann ein Serverausfall mehrere Workloads betreffen, was zu größeren Unterbrechungen für ein Unternehmen, seine Mitarbeiter, Partner und Kunden führen kann. IT-Führungskräfte müssen Fragen wie die Verteilung von Workloads berücksichtigen – welche VMs sollten auf welchen physischen Servern laufen – und Wiederherstellungs- und Ausfallsicherheitstechniken implementieren, um sicherzustellen, dass kritische VMs nach einem Server- oder anderen physischen Infrastrukturfehler verfügbar sind.

- VM-Sprawl: IT-Ressourcen hängen von einer sorgfältigen Verwaltung ab, um die Verfügbarkeit, Auslastung, den Zustand und die Leistung von Ressourcen zu verfolgen. Zu wissen, was vorhanden ist, wie es genutzt wird und wie es funktioniert, ist der Schlüssel zur Effizienz des Rechenzentrums. Eine anhaltende Herausforderung bei Virtualisierung und VMs ist die Erstellung und eventuelle – wenn auch manchmal unbeabsichtigte – Aufgabe von VMs. Ungenutzte oder nicht benötigte VMs verbrauchen weiterhin wertvolle Serverressourcen, leisten aber nur wenig wertvolle Arbeit. In der Zwischenzeit sind diese Ressourcen für andere VMs nicht verfügbar. Mit der Zeit vermehren sich die VMs, und dem Unternehmen gehen die Ressourcen aus, so dass es gezwungen ist, ungeplante Investitionen in zusätzliche Kapazitäten zu tätigen. Dieses Phänomen wird als VM-Sprawl oder virtueller Server-Sprawl bezeichnet. Nicht benötigte VMs müssen identifiziert und außer Betrieb genommen werden, damit Ressourcen für die Wiederverwendung frei werden. Ein ordnungsgemäßes Lebenszyklusmanagement von Workloads und ein IT-Ressourcenmanagement tragen dazu bei, das Problem der Ausbreitung einzudämmen, aber es erfordert Anstrengung und Disziplin, um die Ausbreitung zu bekämpfen.

- Ressourcenknappheit: Virtualisierung ermöglicht es, die normale Auslastung von Serverressourcen zu überschreiten, vor allem bei Arbeitsspeicher und Netzwerken. So können sich beispielsweise VMs denselben physischen Speicherplatz teilen, wobei sie sich auf den herkömmlichen Page Swap stützen, das heißt das vorübergehende Verschieben von Speicherseiten auf eine Festplatte, damit der Speicherplatz von einer anderen Anwendung genutzt werden kann. Bei der Virtualisierung kann mehr Memory zugewiesen werden, als dem Server zur Verfügung steht. Das wird als Memory Overcommitment bezeichnet. Eine Überbelegung ist unerwünscht, da die zusätzliche Latenz des Festplattenzugriffs die Leistung der VM verlangsamen kann. Auch die Netzwerkbandbreite kann zu einem Engpass werden, wenn mehrere VMs auf demselben Server um den Netzwerkzugang konkurrieren. Beide Probleme können durch ein Upgrade des Host-Servers oder durch die Umverteilung von VMs zwischen Servern behoben werden.

- Lizenzierung: Software kostet Geld bei der Beschaffung und Lizenzierung, was leicht übersehen werden kann. Hypervisoren und zugehörige virtualisierungsfähige Management-Tools verursachen zusätzliche Kosten für das Unternehmen, und die Hypervisor-Lizenzierung muss sorgfältig überwacht werden, um die Bedingungen der Software-Lizenzvereinbarungen einzuhalten. Lizenzverstöße können zu Rechtsstreitigkeiten und beträchtlichen finanziellen Strafen für das zuwiderhandelnde Unternehmen führen. Darüber hinaus erfordern Bare-Metal-VMs unabhängige Betriebssysteme, für die Lizenzen für jedes Betriebssystem erforderlich sind.

- Erfahrung: Die erfolgreiche Implementierung und Verwaltung einer virtualisierten Umgebung hängen von der Erfahrung der IT-Mitarbeiter ab. Ausbildung und Erfahrung sind unerlässlich, um sicherzustellen, dass die Ressourcen effizient und sicher bereitgestellt, zeitnah überwacht und wiederhergestellt sowie angemessen geschützt werden, um die kontinuierliche Verfügbarkeit der einzelnen Workloads zu gewährleisten. Unternehmensrichtlinien spielen bei der Ressourcennutzung eine wichtige Rolle, da sie festlegen, wie neue VMs angefordert, genehmigt, bereitgestellt und während des Lebenszyklus der VM verwaltet werden. Glücklicherweise ist Virtualisierung heute eine ausgereifte und weit verbreitete Technologie, so dass es zahlreiche Möglichkeiten für Schulungen und Mentoring gibt.

Einsatzmöglichkeiten und Anwendungen

Virtualisierung hat sich als zuverlässige und vielseitige Technologie erwiesen, die in den letzten zwei Jahrzehnten einen Großteil der Rechenzentren durchdrungen hat. Dennoch stellen sich für Unternehmen nach wie vor wichtige Fragen zu den geeigneten Anwendungsfällen und Anwendungen für die Virtualisierungsbereitstellung. Heutzutage kann Servervirtualisierung in einem breiten Spektrum von Anwendungsfällen, Projekten und Geschäftszielen von Unternehmen eingesetzt werden, darunter:

- Serverkonsolidierung: Konsolidierung ist der wichtigste Anwendungsfall für Servervirtualisierung – sie hat der Virtualisierung zum Durchbruch verholfen. Bei der Konsolidierung werden physische Workloads in VMs umgewandelt und diese VMs dann auf weniger physische Server migriert. Dadurch wird die Anzahl der Server reduziert, die Kosten für die Anschaffung und Wartung von Servern gesenkt, Platz im Rechenzentrum geschaffen und der Energie- und Kühlungsbedarf der IT-Abteilung gesenkt. Virtualisierung ermöglicht es der IT, mit weniger mehr zu erreichen und gleichzeitig Geld zu sparen. Konsolidierung ist immer noch ein Hauptantrieb für Virtualisierung.

- Entwicklung und Tests: Obwohl Servervirtualisierung Produktionsumgebungen und Workloads unterstützt, eignet sie sich aufgrund der Flexibilität und Einfachheit, die die Virtualisierung für die Bereitstellung und den Einsatz von VMs mit sich bringt, auch für Entwicklungs- und Testinitiativen. Es ist eine einfache Angelegenheit, eine VM bereitzustellen, um einen neuen Software-Build zu testen, mit VM-Konfigurationen, Optimierungen und Integrationen zu experimentieren – mehrere VMs dazu zu bringen, miteinander zu kommunizieren – und Workload Recoveries als Teil von Disaster-Recovery-Tests zu validieren. Diese VMs sind oft temporär und können nach Abschluss der Tests wieder entfernt werden, um eine unerwünschte Ausbreitung von VMs zu vermeiden.

- verbesserte Verfügbarkeit: Virtualisierungssoftware umfasst routinemäßig eine Reihe von Merkmalen und Funktionen, die die Zuverlässigkeit und Verfügbarkeit von Workloads, die in VMs ausgeführt werden, verbessern können. Mit der Live-Migration kann eine VM beispielsweise zwischen physischen Servern verschoben werden, ohne dass der Workload angehalten werden muss. VMs können von gestörten Rechnern oder Systemen, die für die Wartung vorgesehen sind, ohne spürbare Unterbrechung verschoben werden. Funktionen wie der priorisierte VM-Neustart stellen sicher, dass die wichtigsten VMs – diejenigen mit kritischen Workloads und Services oder Abhängigkeiten – vor anderen VMs neu gestartet werden, um den Neustart nach Unterbrechungen zu rationalisieren. Funktionen wie Snapshots können aktuelle VM-Kopien aufrechterhalten, VMs schützen und schnelle Neustarts mit geringem oder gar keinem Datenverlust ermöglichen. Andere Verfügbarkeitsfunktionen helfen mehreren Instanzen desselben Workloads dabei, den Datenverkehr und die Verarbeitungslasten zu teilen und die Verfügbarkeit des Workloads aufrechtzuerhalten, falls eine VM ausfällt. Virtualisierung ist zu einem zentralen Element von Wartungs- und Katastrophenplänen geworden.

- Zentralisierung: Vor der Servervirtualisierung lag es in der Verantwortung des IT-Personals, Anwendungen und zugehörige Server zu überwachen. Virtualisierung bringt leistungsstarke Tools mit sich, die alle in der Umgebung ausgeführten VMs über ein einziges Fenster erkennen, organisieren, verfolgen und verwalten können, so dass IT-Administratoren einen umfassenden Überblick über die VM-Landschaft sowie über alle Warnungen oder Probleme erhalten, die möglicherweise Aufmerksamkeit erfordern. Darüber hinaus eignen sich Virtualisierungs-Tools hervorragend für Automatisierungs- und Orchestrierungstechnologien, die eine autonome VM-Erstellung und -Verwaltung ermöglichen, um IT-Administrationsaufgaben zu beschleunigen.

- Unterstützung mehrerer Plattformen: Jede VM führt ihr eigenes Betriebssystem aus. Virtualisierung hat sich als praktisches Mittel zur Unterstützung mehrerer Betriebssysteme auf einem einzigen physischen Server sowie auf Servern in der gesamten Rechenzentrumsumgebung erwiesen. Unternehmen können die gewünschten Kombinationen aus Windows, Linux und anderen Betriebssystemen auf derselben x86-Serverhardware ausführen, die durch den Hypervisor der Virtualisierung vollständig abstrahiert wird.

Es gibt nur wenige Unternehmens-Workloads, die nicht gut in einer VM funktionieren können. Dazu gehören Legacy-Anwendungen, die auf den direkten Zugriff auf bestimmte Serverhardwaregeräte angewiesen sind, um zu funktionieren, zum Beispiel auf ein bestimmtes Prozessormodell oder einen bestimmten Typ. Derartige Bedenken sind heute selten und dürften weiter abnehmen, da Legacy-Anwendungen im Laufe der Zeit unweigerlich überarbeitet und aktualisiert werden.

Welche Arten der Servervirtualisierung gibt es?

Virtualisierung wird durch mehrere bewährte Techniken erreicht: die Verwendung von VMs, die Verwendung von Paravirtualisierung und die Implementierung von Virtualisierung, die vom Betriebssystem gehostet wird.

VM-Modell

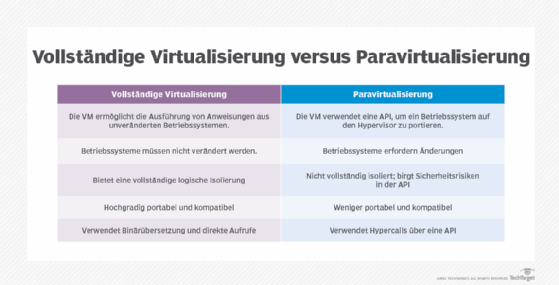

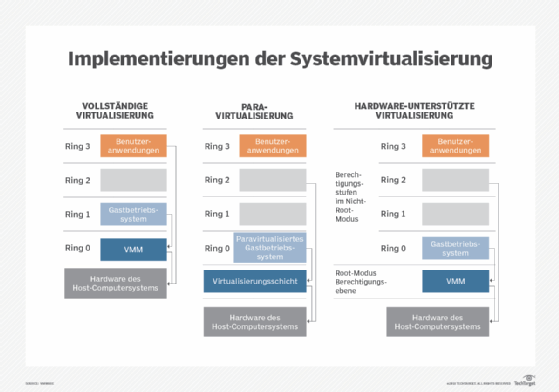

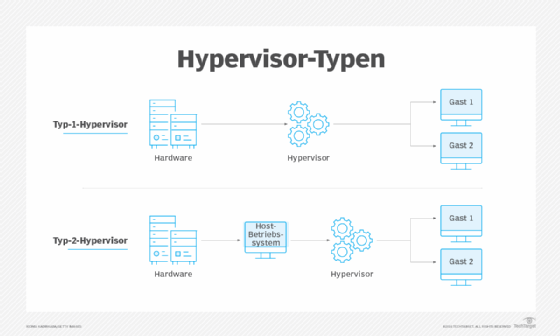

Das VM-Modell ist der beliebteste und am weitesten verbreitete Ansatz zur Virtualisierung, der von VMware und Microsoft verwendet wird. Bei diesem Ansatz kommt ein Hypervisor zum Einsatz, der auf einem Virtual Machine Monitor (VMM) basiert, welcher in der Regel direkt auf der Hardware des Computers installiert wird. Solche Hypervisoren werden in der Regel als Typ 1, Vollvirtualisierung oder Bare-Metal-Virtualisierung bezeichnet und erfordern kein eigenes Betriebssystem auf dem Host-Computer. Tatsächlich wird ein Bare-Metal-Hypervisor oft als Virtualisierungsbetriebssystem betrachtet – ein eigenständiges Betriebssystem. Der Begriff Host-VM wird häufig für eine Haupt-VM verwendet, auf der die Verwaltungssoftware des Servers oder andere Hauptarbeitslasten ausgeführt werden, obwohl Hypervisoren des Typs 1 heutzutage selten eine Host-VM bezeichnen oder erfordern.

Der Hypervisor ist für die Abstrahierung und Verwaltung der Ressourcen des Host-Computers, zum Beispiel Prozessoren und Memory, verantwortlich und stellt diese abstrahierten Ressourcen dann einer oder mehreren VM-Instanzen zur Verfügung. Jede VM existiert als Gast auf dem Hypervisor. Gast-VMs sind logisch vollständig vom Hypervisor und anderen VMs isoliert. Jede VM benötigt ihr eigenes Gastbetriebssystem, so dass Unternehmen verschiedene Betriebssystemversionen auf demselben physischen Computer einsetzen können.

Paravirtualisierung

Frühe Bare-Metal-Hypervisoren hatten mit Leistungseinschränkungen zu kämpfen. Die Paravirtualisierung wurde entwickelt, um diese Leistungsprobleme zu beheben, indem das Host-Betriebssystem so modifiziert wurde, dass es einen Hypervisor erkennt und mit ihm über Befehle, so genannte Hypercalls, zusammenarbeitet. Nach erfolgreicher Modifizierung konnte der virtualisierte Computer Gast-VMs erstellen und verwalten. Die in den Gast-VMs installierten Betriebssysteme können unterschiedliche, nicht modifizierte Betriebssysteme und nicht modifizierte Anwendungen verwenden.

Die größte Herausforderung der Paravirtualisierung ist die Notwendigkeit eines Host-Betriebssystems – und die Notwendigkeit, dieses Host-Betriebssystem zu modifizieren – um die Virtualisierung zu unterstützen. Unveränderte proprietäre Betriebssysteme wie Microsoft Windows unterstützen eine paravirtualisierte Umgebung nicht, und ein paravirtualisierter Hypervisor wie Xen erfordert Unterstützung und in den Linux-Kernel integrierte Treiber. Das stellt ein erhebliches Risiko für Betriebssystem-Updates und -Änderungen dar. Ein Unternehmen, das von einem Betriebssystem zu einem anderen wechselt, riskiert den Verlust der Unterstützung für Paravirtualisierung. Die Popularität der Paravirtualisierung nahm schnell ab, als die Computerhardware weiterentwickelt wurde, um die VMM-basierte Virtualisierung direkt zu unterstützen, zum Beispiel durch die Einführung von Virtualisierungserweiterungen für den Befehlssatz der Prozessoren.

Gehostete Virtualisierung

Obwohl es am üblichsten ist, einen Hypervisor direkt auf der Hardware eines Computers zu hosten – ohne dass ein Host-Betriebssystem erforderlich ist – kann ein Hypervisor auch auf einem vorhandenen Host-Betriebssystem installiert werden, um Virtualisierungsdienste für eine oder mehrere VMs bereitzustellen. Das wird als Typ 2 oder gehostete Virtualisierung bezeichnet und von Produkten wie Virtuozzo und Solaris Zones eingesetzt. Der Hypervisor vom Typ 2 ermöglicht es jeder VM, den zugrunde liegenden Kernel des Host-Betriebssystems zusammen mit gemeinsamen Binärdateien und Bibliotheken gemeinsam zu verwenden, während Hypervisoren vom Typ 1 eine solche gemeinsame Nutzung nicht zulassen.

Die gehostete Virtualisierung macht Gast-VMs potenziell ressourceneffizienter, da die VMs ein gemeinsames Betriebssystem nutzen – das Betriebssystem muss nicht für jede VM dupliziert werden. Folglich kann die gehostete Virtualisierung potenziell Hunderte, sogar Tausende von VM-Instanzen auf demselben System unterstützen. Das gemeinsame Betriebssystem bietet jedoch eine einzige Angriffsfläche für Fehler: Wenn das Host-Betriebssystem angegriffen wird, sind alle VMs, die auf dem Hypervisor laufen, potenziell ebenfalls gefährdet.

Die Effizienz von gehosteten VMs hat die Entwicklung von Containern gefördert. Das Grundkonzept von Containern ist identisch mit der gehosteten Virtualisierung, bei der ein Hypervisor auf einem Host-Betriebssystem installiert wird und alle virtuellen Instanzen dasselbe Betriebssystem nutzen. Die Hypervisor-Schicht – zum Beispiel Docker und Apache Mesos – ist jedoch speziell auf große Mengen kleiner, effizienter VMs zugeschnitten, die gemeinsame Komponenten oder Abhängigkeiten wie Binärdateien und Bibliotheken nutzen sollen. Container haben bei Microservices-basierten Softwarearchitekturen, bei denen flexible, hoch skalierbare Komponenten schnell bereitgestellt und aus der Umgebung entfernt werden, ein erhebliches Wachstum erfahren.

Best Practices für Migration und Bereitstellung

Virtualisierung bietet der Unternehmens-IT leistungsstarke Funktionen, aber sie erfordert eine zusätzliche Softwareschicht, die ein sorgfältiges und überlegtes Management erfordert – insbesondere in den Bereichen VM-Bereitstellung und -Migration.

Eine VM kann bei Bedarf erstellt werden, wobei die VM manuell durch die Bereitstellung von Ressourcen und die Festlegung einer Reihe von Konfigurationselementen konstruiert und dann das Betriebssystem und die Anwendung installiert werden. Obwohl ein manueller Prozess für Ad-hoc-Tests oder spezielle Anwendungsfälle, wie zum Beispiel Softwareevaluierung, gut funktionieren kann, lässt sich die Bereitstellung mit Vorlagen, welche die Ressourcen, die Konfiguration und den Inhalt einer gewünschten VM vordefinieren, erheblich beschleunigen. Eine Vorlage definiert die VM, die dann automatisch schnell und präzise erstellt und bei Bedarf dupliziert werden kann. Die wichtigsten Hypervisoren und die zugehörigen Verwaltungs-Tools unterstützen die Verwendung von Vorlagen, darunter Hyper-V und vSphere.

Vorlagen sind in Unternehmensumgebungen von großer Bedeutung. Sie sorgen für Konsistenz und Vorhersehbarkeit bei der Erstellung von VMs und gewährleisten Folgendes:

- Die Ressourcen werden optimal bereitgestellt.

- Die Sicherheit ist korrekt konfiguriert, wie zum Beispiel das Hinzufügen von abgeschirmten VMs in Hyper-V.

- Alle der VM hinzugefügten Inhalte, wie zum Beispiel Betriebssysteme, sind ordnungsgemäß lizenziert.

- Die VM wird auf geeigneten Servern bereitstellt, um die Serverlast, den Netzwerklastausgleich und andere Faktoren im Rechenzentrum zu berücksichtigen.

Vorlagen optimieren nicht nur den IT-Aufwand und verbessern die Workload-Leistung, sondern spiegeln auch die Geschäftsrichtlinien des Unternehmens wider und stärken die Compliance-Anforderungen. Tools wie Microsoft System Center Virtual Machine Manager, Packer und PowerCLI können bei der Erstellung und Bereitstellung von Vorlagen helfen.

Die Migration ist ein zweiter wichtiger Aspekt des Virtualisierungsprozesses und der Virtualisierungspraxis. Verschiedene Hypervisoren können unterschiedliche Funktionen bieten und sind nicht zu 100 Prozent interoperabel. Ein Unternehmen kann sich für die Verwendung mehrerer Hypervisoren entscheiden, aber das Verschieben einer vorhandenen VM von einem Hypervisor auf einen anderen erfordert eine Möglichkeit zur Migration von VMs, die für einen Hypervisor erstellt wurden, um auf einem anderen Hypervisor zu funktionieren. Bei einer Migration von Hyper-V zu VMware kann ein Tool wie VMware vCenter Converter helfen, VMs massenweise zu migrieren.

Migrationen beinhalten in der Regel eine Betrachtung des aktuellen VM-Bestands, der die Anzahl der VMs, die Kapazität des Zielsystems und die Abhängigkeiten aufzeigen sollte. Administratoren können Quell-VMs auswählen, Ziel-VMs festlegen – einschließlich aller Zielordner – alle für die Konvertierung erforderlichen Agenten installieren, Migrationsoptionen wie das VM-Format festlegen und den Migrationsauftrag zur Ausführung übermitteln. Oft ist es möglich, Migrationszeitpläne festzulegen, so dass Administratoren die gewünschten Migrationszeiten und -gruppen festlegen können, damit zusammengehörige VMs in der besten Reihenfolge und zu einem Zeitpunkt verschoben werden können, an dem die Auswirkungen minimal sind.

Solche Hypervisor-Migrationen sind weder schnell noch einfach. Die Entscheidung, den Hypervisor zu wechseln und VMs von einem Hypervisor auf einen anderen zu migrieren, sollte lange vor der eigentlichen Migrationsinitiative sorgfältig getestet und validiert werden.

Verwaltung der Servervirtualisierung

Die Verwaltung der Virtualisierung in einem Unternehmen erfordert eine Kombination aus praktischer Erfahrung, klaren Richtlinien, gewissenhafter Planung und leistungsfähigen Tools. Das Virtualisierungsmanagement lässt sich in der Regel durch eine Reihe allgemeiner Best Practices klären, die sowohl die Rolle der Infrastruktur als auch die des Unternehmens betonen:

- Haben Sie einen Plan: Führen Sie die Virtualisierung nicht um ihrer selbst willen ein. Die Servervirtualisierung bietet einige bedeutende Vorteile, aber es sind auch Kosten und Komplexität zu berücksichtigen. Ein Unternehmen, das die Virtualisierung zum ersten Mal einführen möchte, sollte sich darüber im Klaren sein, warum und wo die Technologie in den Geschäftsplan passt. Ebenso sollten Unternehmen, die bereits Teile ihrer Umgebung virtualisieren, verstehen, warum und wie eine Ausweitung der Rolle der Virtualisierung für das Unternehmen von Vorteil ist. Die Antwort kann so offensichtlich sein wie ein Serverkonsolidierungsprojekt, um Geld zu sparen, oder ein Mittel zur Unterstützung aktiver Softwareentwicklungsprojekte außerhalb der Produktionsumgebung. Unabhängig von den Beweggründen sollten Sie einen Plan haben, bevor Sie eine Virtualisierungsinitiative starten.

- Beurteilen Sie die Hardware: Machen Sie sich ein Bild vom Umfang. Virtualisierungssoftware, sowohl Hypervisoren als auch Verwaltungs-Tools, müssen gekauft und gewartet werden. Machen Sie sich ein Bild von der Anzahl der Systeme und der Anwendungen, die virtualisiert werden sollen, und untersuchen Sie die Infrastruktur, um zu prüfen, ob die Hardware die Virtualisierung unterstützt. Fast die gesamte aktuelle Rechenzentrumshardware ist für die Virtualisierung geeignet, aber führen Sie im Vorfeld eine Due Diligence durch, um zu vermeiden, dass während der Installation eine Inkompatibilität oder unzureichende Hardware entdeckt wird.

- Testen und lernen Sie: Jeder neuen Virtualisierungseinführung geht in der Regel eine Phase des Testens und Experimentierens voraus, insbesondere wenn die Technologie für das Unternehmen und das IT-Team neu ist. IT-Teams sollten sich mit einer Virtualisierungsplattform gründlich vertraut machen, bevor sie in einer Produktionsumgebung eingesetzt wird. Selbst wenn die Virtualisierung bereits vorhanden ist, sollte der Schritt zur Virtualisierung neuer Workloads – insbesondere unternehmenskritischer Workloads – detaillierte Proof-of-Principle-Projekte beinhalten, um die Tools zu erlernen und den Prozess zu validieren. Kleinere Unternehmen können sich bei Bedarf an Service Provider und Berater wenden.

- Konzentrieren Sie sich auf das Geschäft: Virtualisierung sollte entsprechend den Anforderungen des Unternehmens eingesetzt und genutzt werden, einschließlich einer sorgfältigen Berücksichtigung von Sicherheit, Einhaltung gesetzlicher Vorschriften, Business Continuance, Disaster Recovery und VM-Lebenszyklen – Bereitstellung, Nutzung und spätere Wiederherstellung von Ressourcen. IT-Management-Tools sollten die Virtualisierung unterstützen und all diese geschäftlichen Überlegungen angemessen berücksichtigen.

- Fangen Sie klein an und bauen Sie aus: Unternehmen, die neu in die Servervirtualisierung einsteigen, sollten eine Test- und Experimentierphase mit kleinen, nicht kritischen Virtualisierungsimplementierungen, wie zum Beispiel Test- und Entwicklungsservern, durchlaufen. Suchen Sie nach kleinen und schnellen Erfolgen, um Erfahrungen zu sammeln, die Fehlerbehebung zu erlernen und den Wert der Virtualisierung zu demonstrieren und gleichzeitig das Risiko zu minimieren. Sobald ein gewisses Maß an Fachwissen vorhanden ist, kann das Unternehmen komplexere Virtualisierungsprojekte planen und durchführen.

- Verabschieden Sie Richtlinien: Während das Unternehmen die Servervirtualisierung einführt, sollten Richtlinien für die Bereitstellung, Überwachung und den Lebenszyklus von VMs erstellt und verabschiedet werden. Computing-Ressourcen kosten Geld. Richtlinien können dazu beitragen, die Prozesse und Praktiken zu kodifizieren, die es einem Unternehmen ermöglichen, diese Kosten zu verwalten, Ressourcenverschwendung zu vermeiden, indem eine übermäßige Bereitstellung und ein Ausufern von VMs verhindert wird, und konsistente Verhaltensweisen aufrechtzuerhalten, die mit Sicherheits- und Compliance-Fragen zusammenhängen. Die Richtlinien sollten regelmäßig überprüft und im Laufe der Zeit aktualisiert werden.

- Wählen Sie ein Tool aus: Virtualisierungsmanagement-Tools sind in der Regel nicht die erste Überlegung im Rahmen der Virtualisierungsstrategie eines Unternehmens. Virtualisierungsplattformen umfassen in der Regel grundlegende Tools, und es ist sinnvoll, sich in der Anfangsphase der Virtualisierungseinführung mit diesen Tools vertraut zu machen. Mit der Zeit kann es für Unternehmen von Vorteil sein, umfassendere und leistungsfähigere Tools einzusetzen, die große und anspruchsvolle Virtualisierungsumgebungen unterstützen. Bis dahin haben das Unternehmen und die IT-Mitarbeiter ein klares Bild davon, welche Funktionen ein Tool haben muss, warum diese Funktionen benötigt werden und welchen Nutzen diese Funktionen für das Unternehmen haben. Die Auswahl von Tools für die Servervirtualisierung erfolgt anhand einer Vielzahl von Kriterien, wie zum Beispiel Lizenzkosten, plattformübergreifende Kompatibilität mit mehreren Hypervisoren verschiedener Anbieter, Unterstützung von Vorlagen und Automatisierung, direkte Kontrolle über VMs und Storage und sogar die Möglichkeit für Self-Service und Rückbuchung, so dass andere Abteilungen oder Anwender VMs bereitstellen und auf Wunsch eine Rechnung erhalten können. Unternehmen können aus einer Vielzahl von Tools zur Überwachung der Servervirtualisierung wählen, die sich in Bezug auf Funktionen, Komplexität, Kompatibilität und Kosten unterscheiden. Virtualisierungsanbieter bieten in der Regel Tools an, die für die spezifischen Hypervisoren des Anbieters bestimmt sind. So unterstützt Microsoft System Center beispielsweise Hyper-V, während vCenter Server für VMware-Hypervisoren geeignet ist. Unternehmen können sich aber auch für Tools von Drittanbietern entscheiden, darunter ManageEngine Applications Manager, SolarWinds Virtualization Manager und Veaam One.

- Unterstützen Sie durch Automatisierung: Die Virtualisierung eignet sich für Automatisierungs- und Orchestrierungstechniken, die allgemeine Bereitstellungs- und Managementaufgaben beschleunigen und gleichzeitig eine konsistente Ausführung sicherstellen, Fehler minimieren, Sicherheitsrisiken mindern und die Compliance verbessern können. Im Allgemeinen unterstützen Tools die Automatisierung, aber es bedarf menschlicher Erfahrung und Einsicht, um etablierte Praktiken und Prozesse in eine geeignete Automatisierung zu kodifizieren. Die Einführung von virtuellen Containern hängt stark von der Automatisierung und Orchestrierung ab – und nutzt gut konzipierte Tools wie Kubernetes – um eine containerisierte Umgebung zu verwalten.

Anbieter und Produkte

Es gibt zahlreiche Virtualisierungsangebote auf dem aktuellen Markt, aber die Wahl der Anbieter und Produkte hängt oft stark von den Virtualisierungszielen und den bestehenden IT-Infrastrukturen ab. Unternehmen, die Bare-Metal-Hypervisoren (Typ 1) für Produktions-Workloads benötigen, können in der Regel zwischen VMware vSphere, Microsoft Hyper-V, Citrix Hypervisor, IBM Red Hat Enterprise Virtualization (RHEV) und Oracle VM Server x86 wählen. VMware dominiert die derzeitige Virtualisierungslandschaft aufgrund seines umfangreichen Funktionsumfang und seiner Vielseitigkeit. Microsoft Hyper-V ist eine gängige Wahl für Unternehmen, die bereits auf Microsoft-Windows-Server-Plattformen standardisiert sind. RHEV wird üblicherweise in Linux-Umgebungen eingesetzt.

Gehostete Hypervisoren (Typ 2) sind auch in Test- und Entwicklungsumgebungen sowie an plattformübergreifenden Endpunkten üblich, zum Beispiel auf PCs, auf denen Windows- und Mac-Anwendungen ausgeführt werden müssen. Zu den beliebten Angeboten gehören VMware Workstation, VMware Fusion, VMware Horizon, Oracle VM VirtualBox und Parallels Desktop. Die zahlreichen Angebote von VMware bieten eine universelle Virtualisierung, die Windows- und Linux-Betriebssysteme und -Anwendungen auf Mac-Hardware unterstützt, sowie die Bereitstellung einer virtuellen Desktop-Infrastruktur im gesamten Unternehmen. Das Produkt von Oracle ist ebenfalls universell einsetzbar und unterstützt mehrere Betriebssysteme auf einem einzigen Desktop-System. Die Hypervisoren von Parallels unterstützen nicht-Mac-Betriebssysteme auf Mac-Hardware.

Hypervisoren können sich in Bezug auf Merkmale und Funktionalität erheblich unterscheiden. Beim Vergleich von vSphere und Hyper-V berücksichtigen Entscheidungsträger in der Regel Aspekte wie die Art und Weise, wie beide Hypervisoren die Skalierbarkeit verwalten – die Gesamtzahl der vom Hypervisor unterstützten Prozessoren und Cluster –, die dynamische Memory-Verwaltung, Kosten- und Lizenzierungsfragen sowie die Verfügbarkeit und Vielfalt von Virtualisierungsmanagement-Tools.

Einige Produkte sind jedoch auch für fortgeschrittene unternehmensspezifische Aufgaben konzipiert. Im Vergleich zwischen vSphere ESXi und Nutanix bietet Nutanix AHV eine hyperkonvergente Infrastruktur (HCI), softwaredefinierten Storage (SDS) und die Prism-Managementplattform für die Enterprise-Virtualisierung. AHV ist jedoch nur für HCI gedacht. Unternehmen, die eine universelle Virtualisierung und Tools benötigen, können sich stattdessen an die ausgereiftere VMware-Plattform wenden.

Unternehmen können auch zwischen Xen – im Handel als Citrix Hypervisor bezeichnet – und Linux KVM Hypervisoren wählen. Beide können mehrere Betriebssysteme gleichzeitig ausführen und bieten so Netzwerkflexibilität, aber die Entscheidung hängt oft von der zugrunde liegenden Infrastruktur und dem Interesse an einer Cloud ab. Heute reduziert Amazon die Unterstützung für Xen und entscheidet sich für KVM, was die Wahl des Hypervisors für Unternehmen beeinflussen kann, die sich Sorgen über die Integration von Virtualisierungssoftware mit einem potenziellen Cloud-Anbieter machen.

Die Entscheidung für einen Hypervisor sollte erst nach einer längeren Evaluierungs-, Test- und Experimentierphase getroffen werden. IT- und Unternehmensleiter sollten die Kompatibilitäten, die Leistung und die technischen Feinheiten des bevorzugten Hypervisors genau kennen und sich ein umfassendes Bild von den Kosten und den lizenzrechtlichen Auswirkungen des Hypervisors und der Verwaltungs-Tools machen.

Was ist die Zukunft der Servervirtualisierung?

Servervirtualisierung hat in den letzten zwei Jahrzehnten einen langen Weg zurückgelegt. Heute wird Servervirtualisierung weitgehend als Standardlösung betrachtet. Sie ist ein gängiges, fast obligatorisches Element jeder modernen Unternehmens-IT-Infrastruktur. Hypervisoren sind ebenfalls zu Standardprodukten geworden, die kaum neue oder innovative Funktionen bieten, mit denen sie sich von ihren Konkurrenten auf dem Markt unterscheiden. Die Zukunft der Servervirtualisierung liegt nicht in den Hypervisoren, sondern darin, wie Servervirtualisierung wichtige Geschäftsinitiativen unterstützen kann.

Erstens ist Servervirtualisierung keine Technologie, die sich gegenseitig ausschließt. Ein Hypervisor-Typ ist nicht unbedingt ideal für jede Aufgabe, und Bare-Metal-, Hosted- und Container-basierte Hypervisoren können im selben Rechenzentrum nebeneinander existieren, um eine Reihe von spezifischen Aufgaben zu erfüllen. Unternehmen, die eine Art der Virtualisierung standardisiert haben, könnten Gründe finden, in Zukunft weitere Hypervisor-Typen einzusetzen und zu verwalten.

Denken Sie an den zunehmenden Einfluss von Containern. VMs und Container sind zwei verschiedene Arten der Virtualisierung, die von zwei unterschiedlichen Hypervisor-Typen gehandhabt werden – dennoch können VMs und Container in einem Rechenzentrum durchaus nebeneinander betrieben werden, um verschiedene Arten von Unternehmens-Workloads zu verarbeiten.

Zweitens wird der anhaltende Einfluss und die Weiterentwicklung von Technologien wie HCI die Grenzen des Virtualisierungsmanagements austesten. Jüngste Trends in Richtung Disaggregation oder HCI 2.0 funktionieren beispielsweise durch die Trennung von Computing- und Storage-Ressourcen, und Virtualisierungs-Tools müssen diese disaggregierten Ressourcen effizient in Pools und Tiers organisieren, für Workloads bereitstellen und genau überwachen.

Die anhaltende Bedrohung durch Sicherheitsverletzungen und böswillige Angriffe wird den Bedarf an Protokollierung, Analysen und Berichten, Änderungsmanagement und Automatisierung weiter erhöhen. Diese Faktoren werden die Entwicklung von Management-Tools für die Servervirtualisierung vorantreiben – wenn auch nicht den Hypervisor selbst – und den Einblick in die Umgebung für geschäftliche Erkenntnisse und Analysen verbessern.

Blicken Sie in die Zukunft des Virtualisierungsmanagements. Der Schwerpunkt der Virtualisierung verlagert sich von den Hypervisoren – was Sie tun müssen – auf die Automatisierung, Orchestrierung und allgemeine Intelligenz, die verfügbar sind, um die tägliche Arbeit der Administratoren zu optimieren und zu unterstützen – wie Sie es tun müssen. Tools wie Kubernetes für Docker-Container sowie Skripte und Vorlagen sind für eine erfolgreiche Container-Bereitstellung unerlässlich. Achten Sie auf KI-Technologien, die dynamische virtualisierte Umgebungen um Autonomie, Analysen und Vorhersagefunktionen erweitern.

Schließlich wird die herkömmliche Servervirtualisierung weiterhin mit Clouds und Cloud-Plattformen integriert werden, was eine einfachere und flüssigere Migration zwischen Rechenzentren und Clouds ermöglicht. Beispiele für solche Integrationen sind VMware Cloud on AWS und Microsoft Azure Stack.