png-jpeg-vector - stock.adobe.co

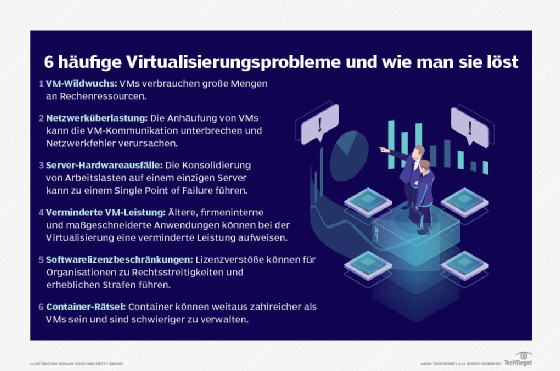

6 häufige Virtualisierungsprobleme und wie man sie löst

Häufige Probleme bei der Virtualisierung können durch die richtigen Geschäftsrichtlinien gelöst werden, ohne dass zusätzliche Technologie angeschafft werden muss.

IT-Administratoren müssen sich häufig mit Virtualisierungsproblemen auseinandersetzen, wie zum Beispiel VM-Sprawl, Netzwerküberlastung, Serverhardwareausfälle, verringerte VM-Leistung, Softwarelizenzierungsbeschränkungen und Containerprobleme. Unternehmen können diese Probleme jedoch mit Lifecycle-Management-Tools und Unternehmensrichtlinien entschärfen, bevor sie auftreten.

Die Servervirtualisierung bringt zahlreiche Vorteile, darunter eine weitaus bessere Systemauslastung und Workload-Flexibilität für das Rechenzentrum. Doch trotz ihrer Vorteile ist die Virtualisierung nicht perfekt: Die Hypervisoren selbst sind solide, aber die Probleme, die sich aus der Virtualisierung ergeben, können Ressourcen verschwenden und die Administratoren an ihre Grenzen bringen.

Hier sind sechs häufige Virtualisierungsprobleme, auf die Administratoren stoßen, und wie sie diese effektiv angehen können.

1. VM-Sprawl verschwendet wertvolle Computerressourcen

Unternehmen virtualisieren oft eine bestimmte Anzahl von Workloads und müssen dann weitere Server kaufen, um mehr Workloads unterzubringen. Das ist darauf zurückzuführen, dass Unternehmen in der Regel nicht über die erforderlichen Geschäftsrichtlinien verfügen, um die Erstellung von VMs zu planen oder zu verwalten.

Vor der Virtualisierung dauerte die Bereitstellung eines neuen Servers Wochen, wenn nicht sogar Monate, weil die Unternehmen ein Budget für Systeme einplanen und die Bereitstellung koordinieren mussten. Die Inbetriebnahme eines neues Workloads war eine große Sache, die von IT-Fachleuten und Managern genauestens geprüft wurde. Bei der Virtualisierung kann ein Hypervisor Rechenressourcen zuweisen und innerhalb von Minuten eine neue VM auf einem verfügbaren Server aufsetzten. Zu den Hypervisoren gehören Angebote wie Microsoft Hyper-V und VMware vSphere sowie eine Reihe von bewährten Open-Source-Alternativen.

Sobald jedoch VMs in der Umgebung vorhanden sind, gibt es selten Standardprozesse oder eine Überwachung, um festzustellen, ob jemand sie benötigt oder nutzt. Das führt dazu, dass VMs potenziell nicht mehr genutzt werden. Diese nicht mehr genutzten VMs sammeln sich jedoch im Laufe der Zeit an und verbrauchen Rechen-, Backup- und Disaster-Recovery-Ressourcen. Dieses Phänomen wird als VM-Sprawl bezeichnet und verursacht Betriebskosten und Overhead für diese ungenutzten VMs, bringt dem Unternehmen aber keinen greifbaren Wert.

Da VMs so einfach zu erstellen und zu zerstören sind, benötigen Unternehmen Richtlinien und Verfahren, die ihnen dabei helfen, zu erkennen, wann sie eine neue VM benötigen, wie lange sie sie brauchen und wie sie einen neuen Server zu rechtfertigen. Unternehmen sollten auch in Erwägung ziehen, VMs mit Lebenszyklus-Management-Tools zu verfolgen. Es sollte klare Überprüfungs- und Entfernungsdaten geben, damit das Unternehmen die VM entweder verlängern oder stilllegen kann. Andere Tools, wie zum Beispiel Application-Performance-Management-Plattformen, können ebenfalls dazu beitragen, Auslastungs- und Leistungskennzahlen zu jeder in der Infrastruktur betriebenen Arbeitslast zu erfassen.

All das trägt dazu bei, VMs bestimmten Abteilungen, Bereichen oder anderen Beteiligten zuzuordnen, so dass Unternehmen genau sehen können, wie viel von der IT-Umgebung dieser Teil des Unternehmens benötigt und wie die IT-Infrastruktur genutzt wird. Einige Unternehmen nutzen sogar Chargeback-Taktiken, um Abteilungen die von ihnen genutzte Rechenleistung in Rechnung zu stellen. Die Chancen stehen gut, dass ein Workload-Eigentümer, der für VMs zahlen muss, sich jede einzelne davon genau ansieht.

2. VMs können den Netzwerkverkehr stören

Netzwerküberlastung ist ein weiteres häufiges Problem. Ein Unternehmen, das seine Systemzahlen routinemäßig ausführt, könnte zum Beispiel feststellen, dass es über genügend Memory und CPU-Kerne verfügt, um 25 VMs auf einem einzigen Server zu hosten. Sobald die IT-Administratoren diese VMs jedoch auf den Server laden, stellen sie möglicherweise fest, dass der einzige Network-Interface-Card-Port (NIC) des Servers bereits überlastet ist, was die Kommunikation der VMs beeinträchtigen und dazu führen kann, dass einige VMs Netzwerkfehler melden oder Leistungsprobleme haben.

Vor der Virtualisierung beanspruchte eine Anwendung auf einem einzelnen Server normalerweise nur einen Bruchteil der Netzwerkbandbreite des Servers. Wenn sich jedoch mehrere VMs auf dem virtualisierten Server ansiedeln, benötigt jede VM auf dem Server einen Teil der verfügbaren Netzwerkbandbreite. Die meisten Server sind nur mit einem einzigen NIC-Port ausgestattet, und es dauert nicht lange, bis der Netzwerkverkehr auf einem virtualisierten Server einen Engpass verursacht, der die NIC überlastet. Workloads, die empfindlich auf Netzwerklatenz reagieren, können Fehler melden oder sogar abstürzen.

Standard-Gigabit-Ethernet-Ports können in der Regel den Datenverkehr von mehreren VMs unterstützen, aber Unternehmen, die ein hohes Maß an Konsolidierung planen, müssen möglicherweise Server mit mehreren NIC-Ports aufrüsten – oder eine NIC und ein LAN-Segment mit höherer Bandbreite –, um eine angemessene Netzwerkkonnektivität zu gewährleisten. Unternehmen können kurzfristige Überlastungsprobleme manchmal dadurch lösen, dass sie die Arbeitslasten neu verteilen, um die bandbreitenintensiven VMs auf mehrere Server zu verteilen.

Als alternative Rebalancing-Strategie können zwei bandbreitenintensive VMs, die routinemäßig über zwei verschiedene physische Server kommunizieren, so migriert werden, dass beide VMs auf demselben physischen Server platziert werden. Dadurch wird die viel genutzte VM-zu-VM-Kommunikation nicht mehr über das LAN, sondern über den physischen Server selbst abgewickelt, wodurch die von diesen anspruchsvollen VMs verursachte Überlastung des LANs verringert wird.

Denken Sie daran, dass NIC-Upgrades auch zusätzliche Switch-Ports oder Switch-Upgrades erforderlich machen können. In einigen Fällen müssen Unternehmen den Datenverkehr von mehreren NICs auf mehrere Switches verteilen, um eine Sättigung der Switch-Backplane zu verhindern. Das erfordert die Aufmerksamkeit eines Netzwerkarchitekten, der bereits in der frühesten Planungsphase in die Virtualisierungs- und Konsolidierungsbemühungen einbezogen wird.

3. Konsolidierung vervielfacht die Auswirkungen von Hardwareausfällen

Stellen Sie sich zehn VMs vor, die alle auf demselben physischen Server laufen. Die Virtualisierung bietet Tools wie Snapshots und Live-Migration, die VMs schützen und ihren weiteren Betrieb unter normalen Bedingungen gewährleisten können. Aber die Virtualisierung schützt nicht die zugrunde liegende Hardware. Was passiert also, wenn der Server ausfällt?

Die physische Hardwareplattform wird zum Single Point of Failure und beeinträchtigt alle auf der Plattform ausgeführten Workloads. Ein höherer Konsolidierungsgrad bedeutet mehr Arbeitslasten auf jedem Server, und Serverausfälle wirken sich auf diese Arbeitslasten aus. Das ist ein wesentlicher Unterschied zu herkömmlichen physischen Implementierungen, bei denen ein einzelner Server eine Anwendung unterstützte. Ähnliche Auswirkungen können im LAN auftreten, wo ein Fehler in einem Switch oder einer anderen Netzwerkausrüstung einen oder mehrere Server isolieren kann – und die Aktivität aller VMs auf diesen Servern unterbricht.

In einer ordnungsgemäß konzipierten und eingerichteten Umgebung wird die betroffene Arbeitslast auf andere Server übertragen und neu gestartet. Allerdings ist die Verfügbarkeit des Workloads während des Neustarts etwas beeinträchtigt. Denken Sie daran, dass der Workload von einem Snapshot im Storage neu gestartet und von der Festplatte ins Memory eines verfügbaren Servers verschoben werden muss. Der Wiederherstellungsprozess kann je nach Größe des Abbilds und der Menge des Datenverkehrs im Netzwerk mehrere Minuten dauern. In einem bereits überlasteten Netzwerk kann es viel länger dauern, den Snapshot in das Memory eines anderen Servers zu verschieben. Ein Netzwerkfehler könnte eine Wiederherstellung überhaupt verhindern.

Es gibt verschiedene Taktiken, um Serverhardwareausfälle und Ausfallzeiten abzumildern. Kurzfristig können Unternehmen die Arbeitslasten auf mehrere Server – vielleicht in verschiedenen LAN-Segmenten – umverteilen, um zu verhindern, dass mehrere kritische Anwendungen auf einem einzigen Server laufen. Kurzfristig ist es auch möglich, das Konsolidierungsniveau zu senken, um die Anzahl der Workloads auf jedem physischen System zu begrenzen.

Langfristig können Unternehmen Hochverfügbarkeitsserver für wichtige Konsolidierungsplattformen bereitstellen. Diese Server können redundante Netzteile und zahlreiche Memory-Schutztechnologien wie Memory Sparing und Memory Mirroring enthalten.

Diese Serverhardwarefunktionen helfen, Fehler zu vermeiden oder zumindest zu verhindern, dass sie sich fatal auswirken. Die kritischsten Arbeitslasten können auf Server-Clustern liegen, die mehrere Kopien jeder Arbeitslast synchron halten. Wenn ein Server ausfällt, übernimmt ein anderer Knoten im Cluster und setzt den Betrieb ohne Unterbrechung fort. IT-Infrastrukturingenieure müssen die potenziellen Auswirkungen von Hardwarefehlern in einer virtualisierten Umgebung berücksichtigen und die Architekturen, Hardware und Richtlinien implementieren, die erforderlich sind, um Fehler zu beheben, bevor sie auftreten.

4. Die Anwendungsleistung kann in einer VM immer noch gering sein

Organisationen, die sich dafür entscheiden, ihren 25 Jahre alten, maßgeschneiderten Unternehmensdatenbankserver in eine VM zu verschieben, stellen möglicherweise fest, dass die Datenbank langsamer arbeitet. Oder wenn Organisationen beschließen, eine moderne Anwendung zu virtualisieren, stellen sie möglicherweise fest, dass sie unregelmäßig oder langsam läuft. Es gibt mehrere Möglichkeiten, wenn es um Leistungsprobleme bei VMs geht.

Bei älteren, firmeninternen und maßgeschneiderten Anwendungen ist eine der effizientesten Methoden zur Programmierung von Software die Verwendung spezifischer Hardwareaufrufe. Leider können einfache Lift-and-Shift-Migrationen für viele ältere Anwendungen tückisch sein. Jedes Mal, wenn Unternehmen die Hardware ändern oder sie von der Anwendung abstrahieren, funktioniert die Software möglicherweise nicht mehr richtig und muss in der Regel neu programmiert werden.

Es ist möglich, dass veraltete Software einfach nicht mit Virtualisierung kompatibel ist. Unternehmen müssen sie möglicherweise aktualisieren, auf ein anderes kommerzielles Softwareprodukt oder SaaS-Angebot umsteigen, das die gleiche Aufgabe erfüllt, oder das alte physische System, auf dem die Anwendung zuvor ausgeführt wurde, weiterhin verwenden. Aber keine dieser Optionen ist besonders attraktiv oder praktisch für Unternehmen mit einem knappen Budget.

Bei Organisationen mit einer modernen Anwendung, die nach der Virtualisierung eine schlechte Leistung erbringt, kann es sein, dass die Arbeitslast mehr Rechenressourcen wie Memory-Platz, CPU-Zyklen und Kerne benötigt. Organisationen können in der Regel ein Benchmark-Dienstprogramm ausführen und alle Ressourcen identifizieren, die überlastet sind, und dann zusätzliche Rechenressourcen bereitstellen, um etwas Spielraum zu schaffen. Wenn beispielsweise das Memory zu knapp ist, kann die Anwendung auf das Auslagern von Dateien auf die Festplatte angewiesen sein, was die Leistung beeinträchtigen kann. Durch das Hinzufügen von ausreichend Memory, um das Auslagern auf die Festplatte zu vermeiden, kann die Leistung verbessert werden. In manchen Fällen kann das Problem durch die Migration einer leistungsschwachen VM auf einen anderen Server – vielleicht einen neueren oder weniger ausgelasteten Server – gelöst werden.

Unabhängig davon, ob es sich bei der betreffenden Anwendung um eine moderne oder ältere Anwendung handelt, hätte ein Test in einer Laborumgebung vor der Virtualisierung dazu beitragen können, problematische Anwendungen zu identifizieren und Unternehmen die Möglichkeit zu geben, Probleme zu erkennen und Lösungen für Virtualisierungsprobleme zu finden, bevor die VM in die Produktion eingeführt wird.

5. Die Softwarelizenzierung ist in einer virtuellen Umgebung ein heikles Thema

Softwarelizenzierung war schon immer verwirrend und teuer, aber Softwarenanbieter haben sich schnell auf die Virtualisierungstechnologie eingestellt und ihre Lizenzierungsregeln aktualisiert, um VMs, mehrere CPUs und andere Ressourcenbereitstellungslücken zu berücksichtigen, die durch die Virtualisierung entstehen. Das Fazit ist, dass Unternehmen nicht erwarten können, VMs unendlich oft zu klonen, ohne Lizenzen für das Betriebssystem und die Anwendung zu kaufen, die in jeder VM ausgeführt werden.

Unternehmen müssen stets die Lizenzierungsregeln für jede eingesetzte Software überprüfen und verstehen. Große Unternehmen könnten sogar einen Beauftragten für die Einhaltung der Lizenzbestimmungen einstellen, der die Softwarelizenzierung überwacht und Unterstützung bei der Softwareimplementierung, einschließlich der Virtualisierung, bietet. Unternehmen sollten diese Fachleute einbeziehen, wenn sie verfügbar sind. Moderne Systemverwaltungs-Tools bieten zunehmend Funktionen für die Nachverfolgung und Berichterstattung von Softwarelizenzen.

Lizenzverstöße können für Unternehmen zu Rechtsstreitigkeiten und erheblichen Strafen führen. Große Softwareanbieter behalten sich oft das Recht vor, Unternehmen zu überprüfen und ihre Lizenzierung zu verifizieren. Die meisten Anbieter sind mehr an ihren Lizenzgebühren als an Rechtsstreitigkeiten interessiert, insbesondere bei erstmaligen Verstößen. Wenn Unternehmen jedoch bedenken, dass eine einzige Lizenz Tausende von Euro kosten kann, kann eine unbedachte VM-Vermehrung finanziell verheerend sein.

6. Container können zu Problemen führen

Das Aufkommen virtueller Container hat die traditionellen Herausforderungen bei VMs nur noch verschärft. Container, wie sie beispielsweise von Docker und Apache Mesos verwendet werden, sind im Wesentlichen kleine und ressourcenintensive VMs, die in Sekundenschnelle generiert werden können und je nach Bedarf Minuten oder Stunden lang aktiv sind. Folglich können Container in enormer Anzahl mit erstaunlich kurzen Lebenszyklen vorhanden sein. Das erfordert ein hohes Maß an Automatisierung und Orchestrierung mit spezialisierten Tools wie Kubernetes.

Bei richtiger Implementierung und Verwaltung bieten Container einen attraktiven und effektiven Mechanismus für die Anwendungsbereitstellung – oft parallel zu herkömmlichen VMs. Container unterliegen jedoch denselben Risiken und Einschränkungen wie VMs. Wenn man bedenkt, dass Container weitaus zahlreicher und schwieriger zu verwalten sein können, erfordern die Herausforderungen für Container eine noch sorgfältigere Aufmerksamkeit des IT-Personals.

Die Servervirtualisierung hat das Gesicht der modernen Unternehmensinformatik mit VMs und Containern verändert. Sie ermöglicht eine effiziente Nutzung von Rechenressourcen auf weniger physischen Systemen und bietet mehr Möglichkeiten, Daten zu schützen und die Verfügbarkeit sicherzustellen. Aber Virtualisierung ist nicht perfekt und schafft neue Probleme, die Unternehmen verstehen und angehen müssen, damit das Rechenzentrum reibungslos funktioniert.