Künstliche Intelligenz (KI)

Was ist Künstliche Intelligenz (KI)?

Künstliche Intelligenz (KI) ist die Simulation menschlicher Denkprozesse durch Maschinen, insbesondere Computersysteme. Dazu gehören Lernen, Schlussfolgern und Selbstkorrektur. Beispiele für KI-Anwendungen sind Expertensysteme, natürliche Sprachverarbeitung (Natural Language Processing, NLP), Spracherkennung, maschinelles Sehen und generative Tools wie ChatGPT und Perplexity.

Mit dem zunehmenden Hype um KI haben Anbieter begonnen, die Integration dieser Technologie in ihre Produkte und Dienstleistungen zu bewerben. Oftmals handelt es sich dabei jedoch um etablierte Technologien wie maschinelles Lernen.

KI erfordert spezielle Hardware und Software zum Schreiben und Trainieren von Algorithmen für maschinelles Lernen. Es gibt keine Programmiersprache, die ausschließlich in der KI verwendet wird, aber Python, R, Java, C++ und Julia sind beliebte Sprachen unter KI-Entwicklern.

Wie funktioniert KI?

Im Allgemeinen funktionieren KI-Systeme, indem sie große Mengen an gekennzeichneten Trainingsdaten (gelabelte Daten) aufnehmen, diese Daten auf Korrelationen und Muster analysieren und diese Muster verwenden, um Vorhersagen über zukünftige Zustände zu treffen.

Ein KI-Chatbot, der mit Textbeispielen gefüttert wird, kann beispielsweise lernen, lebensechte Dialoge mit Menschen zu führen, und ein Bilderkennungsprogramm kann durch die Auswertung von Millionen von Beispielen lernen, Objekte in Bildern zu identifizieren und zu beschreiben. Generative KI-Techniken, die in den letzten Jahren rasante Fortschritte gemacht haben, können realistische Texte, Bilder, Musik und andere Medien erstellen.

Die Programmierung von KI-Systemen konzentriert sich auf kognitive Fähigkeiten wie die folgenden:

- Lernen: Dieser Aspekt der KI-Programmierung umfasst das Sammeln von Daten und das Erstellen von Regeln, sogenannten Algorithmen, um diese in verwertbare Informationen umzuwandeln. Diese Algorithmen liefern Computergeräten Schritt-für-Schritt-Anweisungen zur Ausführung bestimmter Aufgaben.

- Schlussfolgern: Dieser Aspekt umfasst die Auswahl des richtigen Algorithmus, um ein gewünschtes Ergebnis zu erzielen.

- Selbstkorrektur: Dieser Aspekt umfasst Algorithmen, die kontinuierlich lernen und sich selbst optimieren, um möglichst genaue Ergebnisse zu liefern.

- Kreativität: Dieser Aspekt nutzt neuronale Netze, regelbasierte Systeme, statistische Methoden und andere KI-Techniken, um zum Beispiel neue Bilder, Texte, Musik und Ideen zu generieren.

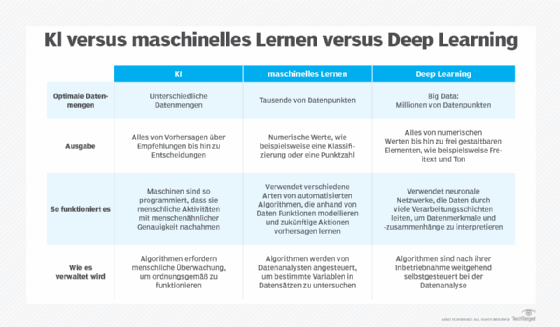

Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Die Begriffe KI, maschinelles Lernen und Deep Learning werden oft synonym verwendet, insbesondere in Marketingmaterialien von Unternehmen, aber sie haben unterschiedliche Bedeutungen. Kurz gesagt beschreibt KI das allgemeine Konzept von Maschinen, die menschliche Intelligenz simulieren, während maschinelles Lernen und Deep Learning spezifische Techniken innerhalb dieses Bereichs sind.

Der Begriff KI, der in den 1950er Jahren geprägt wurde, umfasst eine sich weiterentwickelnde und breite Palette von Technologien, die darauf abzielen, menschliche Intelligenz zu simulieren, darunter maschinelles Lernen und Deep Learning. Maschinelles Lernen ermöglicht es Software, anhand historischer Daten autonom Muster zu lernen und Ergebnisse vorherzusagen. Dieser Ansatz wurde mit der Verfügbarkeit großer Trainingsdatensätze immer effektiver. Deep Learning, ein Teilbereich des maschinellen Lernens, zielt darauf ab, die Struktur des Gehirns mithilfe von mehrschichtigen neuronalen Netzen nachzubilden. Es bildet die Grundlage für viele wichtige Durchbrüche und aktuelle Fortschritte in der KI, darunter autonome Fahrzeuge und ChatGPT.

Warum ist KI wichtig?

KI ist wichtig, weil sie das Potenzial hat, unser Leben, unsere Arbeit und unsere Freizeit zu verändern. Sie wird in Unternehmen effektiv eingesetzt, um Aufgaben zu automatisieren, die traditionell von Menschen ausgeführt werden, darunter Kundenservice, Leadgenerierung, Betrugserkennung und Qualitätskontrolle.

In einer Reihe von Bereichen kann KI Aufgaben effizienter und genauer ausführen als Menschen. Sie ist besonders nützlich für repetitive, detailorientierte Aufgaben wie die Analyse großer Mengen von Rechtsdokumenten, um sicherzustellen, dass relevante Felder korrekt ausgefüllt sind. Die Fähigkeit der KI, riesige Datenmengen zu verarbeiten, verschafft Unternehmen Einblicke in ihre Abläufe, die ihnen sonst möglicherweise nicht aufgefallen wären. Die schnell wachsende Palette generativer KI-Tools gewinnt auch in Bereichen wie Bildung, Marketing und Produktdesign zunehmend an Bedeutung.

Fortschritte in der KI-Technik haben nicht nur zu einer explosionsartigen Steigerung der Effizienz beigetragen, sondern auch einigen größeren Unternehmen völlig neue Geschäftsmöglichkeiten eröffnet. Vor der aktuellen KI-Welle wäre es beispielsweise kaum vorstellbar gewesen, dass eine Computersoftware Fahrgäste auf Abruf mit Taxis verbindet, doch genau damit ist Uber zu einem Fortune-500-Unternehmen geworden.

KI ist heute für viele der größten und erfolgreichsten Unternehmen von zentraler Bedeutung, darunter Alphabet, Apple, Microsoft und Meta, die KI einsetzen, um ihre Abläufe zu verbessern und wettbewerbsfähig zu sein. Bei der Alphabet-Tochter Google beispielsweise spielt KI eine zentrale Rolle für die gleichnamige Suchmaschine, und das Unternehmen Waymo, das selbstfahrende Autos herstellt, begann als eine Abteilung von Alphabet. Das Forschungslabor Google Brain hat auch die Transformer-Architektur erfunden, die den jüngsten Durchbrüchen im Bereich NLP wie ChatGPT von OpenAI zugrunde liegt.

Was sind die Vor- und Nachteile künstlicher Intelligenz?

KI-Technologien, insbesondere Deep-Learning-Modelle wie künstliche neuronale Netze, können große Datenmengen viel schneller verarbeiten und genauere Vorhersagen treffen als Menschen. Während die täglich anfallenden riesigen Datenmengen einen menschlichen Forscher überfordern, können KI-Anwendungen mit maschinellem Lernen diese Daten schnell in verwertbare Informationen umwandeln.

Ein wesentlicher Nachteil der KI ist, dass die Verarbeitung der großen Datenmengen, die KI benötigt, teuer ist. Da KI-Techniken in immer mehr Produkte und Dienstleistungen integriert werden, müssen Unternehmen auch auf das Potenzial der KI achten, absichtlich oder unabsichtlich voreingenommene und diskriminierende Systeme zu schaffen.

Vorteile von KI

Im Folgenden sind einige Vorteile von KI aufgeführt:

- Exzellenz bei detailorientierten Aufgaben. KI eignet sich gut für Aufgaben, bei denen es darum geht, subtile Muster und Zusammenhänge in Daten zu erkennen, die von Menschen übersehen werden können. In der Onkologie beispielsweise haben KI-Systeme eine hohe Genauigkeit bei der Erkennung von Krebserkrankungen im Frühstadium, wie Brustkrebs und Melanomen, gezeigt, indem sie Bereiche hervorheben, die für eine weitere Untersuchung durch medizinisches Fachpersonal relevant sind.

- Effizienz bei datenintensiven Aufgaben. KI-Systeme und Automatisierungs-Tools reduzieren den Zeitaufwand für die Datenverarbeitung erheblich. Dies ist besonders nützlich in Branchen wie dem Finanzwesen, dem Versicherungswesen und dem Gesundheitswesen, in denen routinemäßig große Datenmengen eingegeben und analysiert werden und datengestützte Entscheidungen getroffen werden müssen. Im Bank- und Finanzwesen können beispielsweise prädiktive KI-Modelle riesige Datenmengen verarbeiten, um Markttrends zu prognostizieren und Investitionsrisiken zu analysieren.

- Zeitersparnis und Produktivitätssteigerungen. KI und Robotik können nicht nur Abläufe automatisieren, sondern auch die Sicherheit und Effizienz verbessern. In der Fertigung werden beispielsweise zunehmend KI-gestützte Roboter eingesetzt, um gefährliche oder repetitive Aufgaben im Rahmen der Lagerautomatisierung zu übernehmen, wodurch das Risiko für menschliche Mitarbeiter verringert und die Gesamtproduktivität gesteigert wird.

- Konsistenz der Ergebnisse. Heutige Analysewerkzeuge nutzen KI und maschinelles Lernen, um umfangreiche Datenmengen auf einheitliche Weise zu verarbeiten und gleichzeitig durch kontinuierliches Lernen an neue Informationen angepasst werden zu können. So liefern KI-Anwendungen beispielsweise konsistente und zuverlässige Ergebnisse bei der Prüfung von Rechtsdokumenten und bei der Übersetzung von Texten.

- Anpassung und Personalisierung. KI-Systeme können die Benutzererfahrung verbessern, indem sie Interaktionen und die Bereitstellung von Inhalten auf digitalen Plattformen personalisieren. Auf E-Commerce-Plattformen analysieren KI-Modelle beispielsweise das Nutzerverhalten, um Produkte zu empfehlen, die den Vorlieben einer Person entsprechen, und so die Kundenzufriedenheit und -bindung zu erhöhen.

- Verfügbarkeit. KI-Programme brauchen weder Schlaf noch Pausen. KI-gestützte virtuelle Assistenten können beispielsweise auch bei hohem Interaktionsaufkommen einen unterbrechungsfreien Kundenservice rund um die Uhr bieten, wodurch die Reaktionszeiten verbessert und Kosten gesenkt werden.

- Skalierbarkeit. KI-Systeme können skaliert werden, um wachsende Arbeits- und Datenmengen zu bewältigen. Dadurch eignet sich KI besonders für Szenarien, in denen Datenmengen und Arbeitslasten exponentiell wachsen können, wie beispielsweise bei der Internetsuche und der Geschäftsanalyse.

- Beschleunigte Forschung und Entwicklung. KI kann das Tempo von Forschung und Entwicklung in Bereichen wie der Pharmazie und Materialwissenschaften beschleunigen. Durch die schnelle Simulation und Analyse vieler möglicher Szenarien können KI-Modelle Forschern helfen, neue Medikamente, Materialien oder Verbindungen schneller als mit herkömmlichen Methoden zu entdecken.

- Nachhaltigkeit und Umweltschutz. KI und maschinelles Lernen werden zunehmend eingesetzt, um Umweltveränderungen zu überwachen, zukünftige Wetterereignisse vorherzusagen und Umweltschutzmaßnahmen zu steuern. Maschinelle Lernmodelle können beispielsweise Satellitenbilder und Sensordaten verarbeiten, um Waldbrandrisiken, Verschmutzungsgrade und Populationen gefährdeter Arten zu verfolgen.

- Prozessoptimierung. KI wird eingesetzt, um komplexe Prozesse in verschiedenen Branchen zu rationalisieren und zu automatisieren. KI-Modelle können beispielsweise Ineffizienzen identifizieren und Engpässe in Fertigungsabläufen vorhersagen, während sie im Energiesektor den Strombedarf prognostizieren und die Versorgung in Echtzeit zuweisen können.

Nachteile von KI

Im Folgenden sind einige Nachteile von KI aufgeführt:

- Hohe Kosten. Die Entwicklung von KI kann sehr teuer sein. Der Aufbau eines KI-Modells erfordert erhebliche Vorabinvestitionen in Infrastruktur, Rechenressourcen und Software, um das Modell zu trainieren und seine Trainingsdaten zu speichern. Nach dem ersten Training fallen weitere laufende Kosten für die Modellinferenz und das Retraining an. Infolgedessen können die Kosten schnell in die Höhe schnellen, insbesondere bei fortschrittlichen, komplexen Systemen wie generativen KI-Anwendungen. Sam Altman, CEO von OpenAI, hat erklärt, dass das Training des GPT-4-Modells des Unternehmens über 100 Millionen US-Dollar gekostet hat.

- Technische Komplexität. Die Entwicklung, der Betrieb und die Fehlerbehebung von KI-Systemen – insbesondere in realen Produktionsumgebungen – erfordern ein hohes Maß an technischem Know-how. In vielen Fällen unterscheidet sich dieses Wissen von dem, das für die Entwicklung von Nicht-KI-Software erforderlich ist. Beispielsweise umfasst die Entwicklung und Bereitstellung einer Anwendung für maschinelles Lernen einen komplexen, mehrstufigen und hochtechnischen Prozess, der von der Datenaufbereitung über die Auswahl der Algorithmen bis hin zur Parameteroptimierung und Modellprüfung reicht.

- Fachkräftemangel. Das Problem der technischen Komplexität wird durch einen erheblichen Mangel an Fachkräften mit Kenntnissen in KI und maschinellem Lernen verschärft, während der Bedarf an solchen Fähigkeiten stetig wächst. Diese Diskrepanz zwischen Angebot und Nachfrage nach KI-Fachkräften bedeutet, dass viele Unternehmen trotz des wachsenden Interesses an KI-Anwendungen nicht genügend qualifizierte Mitarbeiter für ihre KI-Initiativen finden.

- Algorithmische Verzerrungen. KI- und maschinelle Lernalgorithmen spiegeln die Verzerrungen in ihren Trainingsdaten wider – und wenn KI-Systeme in großem Maßstab eingesetzt werden, vergrößern sich auch diese Verzerrungen. In einigen Fällen können KI-Systeme sogar subtile Verzerrungen in ihren Trainingsdaten verstärken, indem sie diese in verstärkbare und pseudo-objektive Muster kodieren. In einem bekannten Beispiel entwickelte Amazon ein KI-gesteuertes Rekrutierungs-Tool zur Automatisierung des Einstellungsprozesses, das unbeabsichtigt männliche Bewerber bevorzugte und damit das allgemeine Ungleichgewicht zwischen den Geschlechtern in der Tech-Branche widerspiegelte.

- Schwierigkeiten bei der Verallgemeinerung. KI-Modelle sind oft hervorragend für die spezifischen Aufgaben geeignet, für die sie trainiert wurden, haben jedoch Schwierigkeiten, wenn sie mit neuen Szenarien konfrontiert werden. Diese mangelnde Flexibilität kann die Nützlichkeit von KI einschränken, da neue Aufgaben die Entwicklung eines völlig neuen Modells erfordern können. Ein NLP-Modell, das mit englischsprachigen Texten trainiert wurde, kann beispielsweise ohne umfangreiches zusätzliches Training bei Texten in anderen Sprachen schlechte Ergebnisse liefern. Zwar wird daran gearbeitet, die Generalisierungsfähigkeit von Modellen zu verbessern – bekannt als Domänenadaption oder Transferlernen –, doch bleibt dies ein offenes Forschungsproblem.

- Verlagerung von Arbeitsplätzen. KI kann zum Verlust von Arbeitsplätzen führen, wenn Unternehmen menschliche Arbeitskräfte durch Maschinen ersetzen – ein Bereich, der zunehmend Anlass zur Sorge gibt, da die Fähigkeiten von KI-Modellen immer ausgefeilter werden und Unternehmen zunehmend versuchen, Arbeitsabläufe mithilfe von KI zu automatisieren. So berichten beispielsweise einige Texter, dass sie durch Large Language Models (LLMs) wie ChatGPT ersetzt wurden. Die flächendeckende Einführung von KI kann zwar auch neue Berufsgruppen schaffen, diese überschneiden sich jedoch möglicherweise nicht mit den wegfallenden Arbeitsplätzen, was Bedenken hinsichtlich wirtschaftlicher Ungleichheit und Umschulungen aufwirft.

- Sicherheitslücken. KI-Systeme sind anfällig für eine Vielzahl von Cyberbedrohungen, darunter Data Poisoning und Adversarial Machine Learning. Hacker können beispielsweise sensible Trainingsdaten aus einem KI-Modell extrahieren oder KI-Systeme dazu bringen, falsche und schädliche Ergebnisse zu liefern. Dies ist besonders in sicherheitssensiblen Bereichen wie Finanzdienstleistungen und Behörden von Bedeutung.

- Auswirkungen auf die Umwelt. Die Rechenzentren und Netzwerkinfrastrukturen, die den Betrieb von KI-Modellen unterstützen, verbrauchen große Mengen an Energie und Wasser. Folglich hat das Training und der Betrieb von KI-Modellen erhebliche Auswirkungen auf das Klima. Der CO2-Fußabdruck von KI ist besonders besorgniserregend bei großen generativen Modellen, die für das Training und den laufenden Betrieb enorme Rechenressourcen benötigen.

- Rechtliche Fragen. KI wirft komplexe Fragen zum Datenschutz und zur rechtlichen Haftung auf, insbesondere angesichts einer sich weiterentwickelnden KI-Regulierung, die sich von Region zu Region unterscheidet. Die Verwendung von KI zur Analyse und Entscheidungsfindung auf der Grundlage personenbezogener Daten hat beispielsweise schwerwiegende Auswirkungen auf den Datenschutz, und es bleibt unklar, wie Gerichte die Urheberschaft von Materialien beurteilen werden, die von LLMs erstellt wurden, die mit urheberrechtlich geschützten Werken trainiert wurden.

Starke KI versus schwache KI

KI kann im Allgemeinen in zwei Typen unterteilt werden: schwache (oder schmale) KI und starke (oder allgemeine) KI.

- Schwache KI. Diese Form der KI bezieht sich auf Modelle, die für die Ausführung bestimmter Aufgaben trainiert wurden. Schwache KI arbeitet im Rahmen der Aufgaben, für die sie programmiert wurde, ohne die Fähigkeit, zu verallgemeinern oder über ihre ursprüngliche Programmierung hinaus zu lernen. Beispiele für schwache oder schmale KI sind virtuelle Assistenten wie Apple Siri und Amazon Alexa sowie Empfehlungsmaschinen, wie sie auf Streaming-Plattformen wie Spotify und Netflix zu finden sind.

- Starke KI. Diese Art von KI, die derzeit noch nicht existiert, wird häufiger als künstliche allgemeine Intelligenz bezeichnet. Wenn sie geschaffen würde, wäre künstliche allgemeine Intelligenz in der Lage, alle intellektuellen Aufgaben zu erfüllen, die ein Mensch ausführen kann. Dazu müsste künstliche allgemeine Intelligenz in der Lage sein, Schlussfolgerungen über einen breiten Bereich von Domänen hinweg zu ziehen, um komplexe Probleme zu verstehen, für deren Lösung sie nicht speziell programmiert wurde. Dies würde wiederum etwas erfordern, das in der KI als Fuzzy Logic bekannt ist: einen Ansatz, der Grauzonen und Abstufungen der Unsicherheit zulässt, anstatt binäre, schwarz-weiße Ergebnisse.

Wichtig ist, dass die Frage, ob künstliche allgemeine Intelligenz geschaffen werden kann – und welche Folgen dies hätte –, unter KI-Experten nach wie vor heiß diskutiert wird. Selbst die fortschrittlichsten KI-Technologien von heute, wie ChatGPT und andere hochleistungsfähige LLMs, zeigen keine kognitiven Fähigkeiten, die denen des Menschen entsprechen, und können nicht auf unterschiedliche Situationen verallgemeinert werden. ChatGPT beispielsweise ist für die Generierung natürlicher Sprache konzipiert und nicht in der Lage, über seine ursprüngliche Programmierung hinaus Aufgaben wie komplexe mathematische Schlussfolgerungen auszuführen.

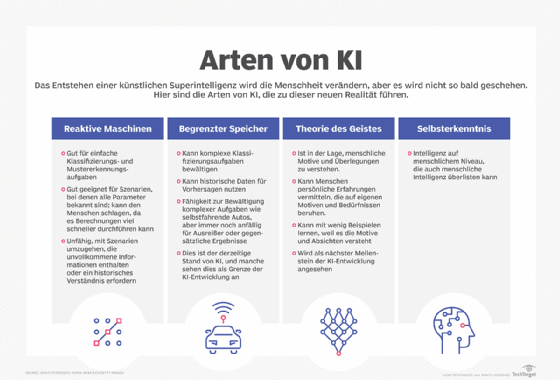

4 Arten von KI

KI lässt sich in vier Arten einteilen, angefangen bei den heute weit verbreiteten aufgabenspezifischen intelligenten Systemen bis hin zu empfindungsfähigen Systemen, die noch nicht existieren.

Die Kategorien lauten wie folgt:

- Typ 1: Reaktive Maschinen. Diese KI-Systeme haben kein Gedächtnis und sind auf bestimmte Aufgaben spezialisiert. Ein Beispiel ist Deep Blue, das Schachprogramm von IBM, das in den 1990er Jahren den russischen Schachgroßmeister Garry Kasparov besiegte. Deep Blue war in der Lage, Figuren auf einem Schachbrett zu identifizieren und Vorhersagen zu treffen, aber da es kein Gedächtnis hatte, konnte es vergangene Erfahrungen nicht für zukünftige Entscheidungen nutzen.

- Typ 2: Begrenzter Speicher. Diese KI-Systeme verfügen über ein Gedächtnis, sodass sie vergangene Erfahrungen für zukünftige Entscheidungen nutzen können. Einige der Entscheidungsfunktionen in selbstfahrenden Autos sind auf diese Weise konzipiert.

- Typ 3: Theorie des Geistes. Theorie des Geistes (Theory of Mind) ist ein Begriff aus der Psychologie. In Bezug auf KI bezeichnet er ein System, das in der Lage ist, Emotionen zu verstehen. Diese Art von KI kann menschliche Absichten ableiten und Verhalten vorhersagen – eine Fähigkeit, die KI-Systeme benötigen, um zu integralen Mitgliedern historisch menschlicher Teams zu werden.

- Typ 4: Selbstbewusstsein. In dieser Kategorie verfügen KI-Systeme über ein Selbstbewusstsein, das ihnen Bewusstsein verleiht. Maschinen mit Selbstbewusstsein verstehen ihren eigenen aktuellen Zustand. Diese Art von KI existiert noch nicht.

Was sind Beispiele für KI-Technologie und wie wird sie heute eingesetzt?

KI-Technologien können die Funktionen bestehender Tools verbessern und verschiedene Aufgaben und Prozesse automatisieren, was sich auf zahlreiche Aspekte des täglichen Lebens auswirkt. Im Folgenden finden Sie einige prominente Beispiele.

Automatisierung

KI verbessert Automatisierungstechnologien, indem sie den Umfang, die Komplexität und die Anzahl der Aufgaben erweitert, die automatisiert werden können. Ein Beispiel ist die robotergestützte Prozessautomatisierung (Robotic Process Automation, RPA), die repetitive, regelbasierte Datenverarbeitungsaufgaben automatisiert, die traditionell von Menschen ausgeführt werden. Da KI RPA-Bots dabei hilft, sich an neue Daten anzupassen und dynamisch auf Prozessänderungen zu reagieren, ermöglicht die Integration von KI- und maschinellen Lernfähigkeiten RPA die Verwaltung komplexerer Arbeitsabläufe.

Maschinelles Lernen

Maschinelles Lernen ist die Wissenschaft, Computern beizubringen, aus Daten zu lernen und Entscheidungen zu treffen, ohne dass sie dafür explizit programmiert wurden. Deep Learning, ein Teilbereich des maschinellen Lernens, nutzt komplexe neuronale Netze, um im Wesentlichen eine fortgeschrittene Form der prädiktiven Analytik durchzuführen.

Algorithmen für maschinelles Lernen lassen sich grob in drei Kategorien einteilen: überwachtes Lernen, unüberwachtes Lernen und bestärkendes Lernen.

- Beim überwachten Lernen werden Modelle anhand von gekennzeichneten Datensätzen trainiert, sodass sie Muster genau erkennen, Ergebnisse vorhersagen oder neue Daten klassifizieren können.

- Beim unüberwachten Lernen werden Modelle trainiert, unmarkierte Datensätze zu sortieren, um zugrunde liegende Beziehungen oder Cluster zu finden.

- Das bestärkende Lernen verfolgt einen anderen Ansatz, bei dem Modelle lernen, Entscheidungen zu treffen, indem sie als Agenten agieren und Feedback zu ihren Handlungen erhalten.

Es gibt auch das halbüberwachte Lernen, das Aspekte des überwachten und des unüberwachten Ansatzes kombiniert. Diese Technik verwendet eine kleine Menge gekennzeichneter Daten und eine größere Menge ungekennzeichneter Daten, wodurch die Lerngenauigkeit verbessert und gleichzeitig der Bedarf an gekennzeichneten Daten reduziert wird, deren Beschaffung zeit- und arbeitsintensiv sein kann.

Computer Vision

Computer Vision ist ein Bereich der KI, der sich darauf konzentriert, Maschinen beizubringen, wie sie die visuelle Welt interpretieren können. Durch die Analyse visueller Informationen wie Kamerabilder und Videos mithilfe von Deep-Learning-Modellen können Computer-Vision-Systeme lernen, Objekte zu identifizieren und zu klassifizieren und auf der Grundlage dieser Analysen Entscheidungen zu treffen.

Das primäre Ziel der Computer Vision ist es, das menschliche Sehsystem mithilfe von KI-Algorithmen nachzubilden oder zu verbessern. Computer Vision wird in einer Vielzahl von Anwendungen eingesetzt, von der Unterschriftenerkennung über die medizinische Bildanalyse bis hin zu autonomen Fahrzeugen. Maschinelles Sehen, ein Begriff, der oft mit Computer Vision verwechselt wird, bezieht sich speziell auf die Verwendung von Computer Vision zur Analyse von Kamera- und Videodaten in der industriellen Automatisierung, beispielsweise in Produktionsprozessen in der Fertigung.

Natural Language Processing (NLP)

NLP bezieht sich auf die Verarbeitung menschlicher Sprache durch Computerprogramme. NLP-Algorithmen können menschliche Sprache interpretieren und mit ihr interagieren und dabei Aufgaben wie Übersetzung, Spracherkennung und Sentiment-Analyse ausführen. Eines der ältesten und bekanntesten Beispiele für NLP ist die Spam-Erkennung, bei der die Betreffzeile und der Text einer E-Mail untersucht werden, um zu entscheiden, ob es sich um Junk-Mail handelt. Zu den fortgeschritteneren Anwendungen von NLP gehören LLMs wie ChatGPT und Claude von Anthropic.

Robotik

Die Robotik ist ein Bereich der Technik, der sich mit dem Design, der Herstellung und dem Betrieb von Robotern befasst: automatisierte Maschinen, die menschliche Handlungen nachahmen und ersetzen, insbesondere solche, die für Menschen schwierig, gefährlich oder mühsam sind. Beispiele für Anwendungen der Robotik sind die Fertigung, wo Roboter repetitive oder gefährliche Aufgaben am Fließband übernehmen, und Erkundungsmissionen in weit entfernten, schwer zugänglichen Gebieten wie dem Weltraum und der Tiefsee.

Die Integration von KI und maschinellem Lernen erweitert die Fähigkeiten von Robotern erheblich, da sie dadurch fundiertere autonome Entscheidungen treffen und sich an neue Situationen und Daten anpassen können. Beispielsweise können Roboter mit maschinellem Sehen lernen, Objekte in einer Fabrikhalle nach Form und Farbe zu sortieren.

Autonome Fahrzeuge

Autonome Fahrzeuge, umgangssprachlich auch als selbstfahrende Autos bezeichnet, können ihre Umgebung mit minimalem oder gar keinem menschlichen Eingriff wahrnehmen und navigieren. Diese Fahrzeuge basieren auf einer Kombination verschiedener Technologien, darunter Radar, GPS und eine Reihe von KI- und maschinellen Lernalgorithmen, wie beispielsweise der Bilderkennung.

Diese Algorithmen lernen aus realen Fahr-, Verkehrs- und Kartendaten, um fundierte Entscheidungen darüber zu treffen, wann gebremst, abgebogen und beschleunigt werden muss, wie man in einer bestimmten Spur bleibt und wie unerwartete Hindernisse, einschließlich Fußgängern, vermieden werden können. Obwohl die Technologie in den letzten Jahren erheblich fortgeschritten ist, ist das ultimative Ziel eines autonomen Fahrzeugs, das einen menschlichen Fahrer vollständig ersetzen kann, noch nicht erreicht.

Generative KI

Der Begriff generative KI bezieht sich auf maschinelle Lernsysteme, die aus Textvorgaben neue Daten generieren können – meist Text und Bilder, aber auch Audio, Video, Softwarecode und sogar genetische Sequenzen und Proteinstrukturen. Durch das Training mit riesigen Datensätzen lernen diese Algorithmen nach und nach die Muster der Medientypen, die sie generieren sollen, sodass sie später neue Inhalte erstellen können, die den Trainingsdaten ähneln.

Generative KI erlebte nach der Einführung weit verbreiteter Text- und Bildgeneratoren im Jahr 2022, wie ChatGPT, Dall-E und Midjourney, einen rasanten Anstieg ihrer Popularität und wird zunehmend in Unternehmen eingesetzt. Die Fähigkeiten vieler generativer KI-Tools sind beeindruckend, werfen jedoch auch Fragen zu Themen wie Urheberrecht, faire Nutzung und Sicherheit auf, die in der Tech-Branche nach wie vor kontrovers diskutiert werden.

Was sind die Anwendungsbereiche von KI?

KI hat Einzug in eine Vielzahl von Branchen und Forschungsbereichen gehalten. Im Folgenden sind einige der bemerkenswertesten Beispiele aufgeführt.

KI im Gesundheitswesen

KI wird im Gesundheitswesen für eine Reihe von Aufgaben eingesetzt, mit dem übergeordneten Ziel, die Behandlungsergebnisse für Patienten zu verbessern und die systemischen Kosten zu senken. Eine wichtige Anwendung ist der Einsatz von Machine-Learning-Modellen, die auf großen medizinischen Datensätzen trainiert wurden, um medizinisches Fachpersonal bei der Erstellung besserer und schnellerer Diagnosen zu unterstützen. So kann beispielsweise KI-gestützte Software CT-Scans analysieren und Neurologen auf Verdachtsfälle von Schlaganfällen aufmerksam machen.

Auf der Patientenseite können virtuelle Online-Gesundheitsassistenten und Chatbots allgemeine medizinische Informationen bereitstellen, Termine vereinbaren, Abrechnungsprozesse erklären und andere administrative Aufgaben übernehmen. Vorhersagemodelle können auch zur Bekämpfung der Ausbreitung von Pandemien wie COVID-19 eingesetzt werden.

KI in der Wirtschaft

KI wird zunehmend in verschiedene Geschäftsbereiche und Branchen integriert, um die Effizienz, das Kundenerlebnis, die strategische Planung und die Entscheidungsfindung zu verbessern. Beispielsweise sind viele der heutigen Datenanalyse- und Customer-Relationship-Management-Plattformen (CRM) mit maschinellen Lernmodellen ausgestattet, die Unternehmen dabei unterstützen, ihre Kunden besser zu verstehen, um ihnen durch personalisierte Angebote und maßgeschneiderte Marketingmaßnahmen einen besseren Service zu bieten.

Virtuelle Assistenten und Chatbots werden auch auf Unternehmenswebsites und in mobilen Anwendungen eingesetzt, um einen Kundenservice rund um die Uhr zu bieten und häufig gestellte Fragen zu beantworten. Darüber hinaus untersuchen immer mehr Unternehmen die Möglichkeiten generativer KI-Tools wie ChatGPT für die Automatisierung von Aufgaben wie der Erstellung und Zusammenfassung von Dokumenten, dem Produktdesign und der Ideenfindung sowie der Computerprogrammierung.

KI im Bildungswesen

KI hat eine Reihe potenzieller Anwendungsmöglichkeiten in der Bildungstechnologie. Sie kann Aspekte der Benotung automatisieren und Lehrkräften so mehr Zeit für andere Aufgaben verschaffen. KI-Tools können auch die Leistungen von Schülern bewerten und sich an ihre individuellen Bedürfnisse anpassen, wodurch personalisiertere Lernerfahrungen ermöglicht werden, bei denen die Schüler in ihrem eigenen Tempo arbeiten können. KI-Tutoren können Schülern zusätzliche Unterstützung bieten und so sicherstellen, dass sie auf Kurs bleiben. Die Technologie kann auch verändern, wo und wie Schüler lernen, und damit möglicherweise die traditionelle Rolle von Lehrkräften verändern.

Mit den wachsenden Fähigkeiten von LLMs wie ChatGPT und Google Gemini können solche Tools Pädagogen dabei helfen, Unterrichtsmaterialien zu erstellen und Schüler auf neue Weise zu motivieren. Die Einführung dieser Tools zwingt Pädagogen jedoch auch dazu, Hausaufgaben und Prüfungsmethoden zu überdenken und Plagiatsrichtlinien zu überarbeiten, insbesondere angesichts der Tatsache, dass KI-Erkennungs- und KI-Wasserzeichen-Tools derzeit noch unzuverlässig sind.

KI im Finanz- und Bankwesen

Banken und andere Finanzorganisationen nutzen KI, um ihre Entscheidungsfindung bei Aufgaben wie der Kreditvergabe, der Festlegung von Kreditlimits und der Identifizierung von Investitionsmöglichkeiten zu verbessern. Darüber hinaus hat der algorithmische Handel, der auf fortschrittlicher KI und maschinellem Lernen basiert, die Finanzmärkte verändert und ermöglicht es, Transaktionen mit einer Geschwindigkeit und Effizienz auszuführen, die weit über das hinausgeht, was menschliche Händler manuell leisten können.

KI und maschinelles Lernen haben auch Einzug in den Bereich der Konsumentenfinanzierung gehalten. Beispielsweise nutzen Banken KI-Chatbots, um Kunden über Dienstleistungen und Angebote zu informieren und Transaktionen und Fragen zu bearbeiten, die kein menschliches Eingreifen erfordern. In ähnlicher Weise bietet Intuit in seinem E-Filing-Produkt TurboTax generative KI-Funktionen, die den Nutzern personalisierte Beratung auf der Grundlage von Daten wie dem Steuerprofil des Nutzers und den Steuergesetzen seines Wohnorts bieten.

KI im Rechtswesen

KI verändert den Rechtssektor durch die Automatisierung arbeitsintensiver Aufgaben wie die Überprüfung von Dokumenten und die Beantwortung von Auskunftsersuchen, die für Anwälte und Rechtsassistenten mühsam und zeitaufwendig sein können. Anwaltskanzleien nutzen KI und maschinelles Lernen heute für eine Vielzahl von Aufgaben, darunter Analytik und prädiktive KI zur Analyse von Daten und Rechtsprechung, Computer Vision zur Klassifizierung und Extraktion von Informationen aus Dokumenten sowie NLP zur Interpretation und Beantwortung von Auskunftsersuchen.

Neben der Verbesserung der Effizienz und Produktivität entlastet diese Integration von KI die juristischen Fachkräfte, sodass sie mehr Zeit für ihre Mandanten haben und sich auf kreativere, strategische Aufgaben konzentrieren können, für die KI weniger geeignet ist. Mit dem Aufkommen generativer KI im Rechtswesen prüfen Kanzleien auch den Einsatz von LLMs für die Erstellung gängiger Dokumente wie Standardverträge.

KI in Unterhaltung und Medien

Die Unterhaltungs- und Medienbranche nutzt KI-Techniken für gezielte Werbung, Inhaltsempfehlungen, Vertrieb und Betrugserkennung. Die Technologie ermöglicht es Unternehmen, das Erlebnis ihrer Zielgruppen zu personalisieren und die Bereitstellung von Inhalten zu optimieren.

Generative KI ist auch ein heißes Thema im Bereich der Inhaltserstellung. Werbefachleute nutzen diese Tools bereits zur Erstellung von Marketingmaterialien und zur Bearbeitung von Werbebildern. In Bereichen wie dem Drehbuchschreiben für Film und Fernsehen sowie bei visuellen Effekten ist ihr Einsatz jedoch umstrittener, da sie zwar die Effizienz steigern, aber auch die Existenzgrundlage und das geistige Eigentum von Menschen in kreativen Berufen gefährden.

KI im Journalismus

Im Journalismus kann KI Arbeitsabläufe rationalisieren, indem sie Routineaufgaben wie die Dateneingabe und das Korrekturlesen automatisiert. Investigative Journalisten und Datenjournalisten nutzen KI auch, um Geschichten zu finden und zu recherchieren, indem sie mithilfe von Modellen des maschinellen Lernens große Datenmengen durchforsten und so Trends und versteckte Zusammenhänge aufdecken, deren manuelle Identifizierung sehr zeitaufwendig wäre. So gaben beispielsweise fünf Finalisten für den Pulitzer-Preis für Journalismus 2024 an, KI in ihrer Berichterstattung eingesetzt zu haben, um Aufgaben wie die Analyse umfangreicher Polizeiaufzeichnungen zu erledigen. Während der Einsatz traditioneller KI-Tools immer häufiger wird, ist der Einsatz generativer KI zum Verfassen journalistischer Inhalte fragwürdig, da er Bedenken hinsichtlich Zuverlässigkeit, Genauigkeit und Ethik aufwirft.

KI in der Softwareentwicklung und IT

KI wird zur Automatisierung vieler Prozesse in der Softwareentwicklung, DevOps und IT eingesetzt. Beispielsweise ermöglichen AIOps-Tools die vorausschauende Wartung von IT-Umgebungen, indem sie Systemdaten analysieren, um potenzielle Probleme vorherzusagen, bevor sie auftreten, und KI-gestützte Überwachungs-Tools können dabei unterstützen, potenzielle Anomalien in Echtzeit auf der Grundlage historischer Systemdaten zu erkennen. Generative KI-Tools wie GitHub Copilot und Tabnine werden zunehmend auch zur Erstellung von Anwendungscode auf der Grundlage von Eingaben in natürlicher Sprache eingesetzt. Diese Tools sind zwar vielversprechend und stoßen bei Entwicklern auf großes Interesse, werden Softwareentwickler jedoch wahrscheinlich nicht vollständig ersetzen. Vielmehr dienen sie als nützliche Produktivitätshilfen, die repetitive Aufgaben und das Schreiben von Boilerplate-Code automatisieren.

KI in der Sicherheit

KI und maschinelles Lernen sind wichtige Schlagworte im Marketing von Sicherheitsanbietern, daher sollten Käufer vorsichtig sein. Dennoch ist KI in vielen Bereichen der Cybersicherheit eine nützliche Technologie, darunter die Erkennung von Anomalien, die Reduzierung von Fehlalarmen und die Analyse von Verhaltensbedrohungen. Beispielsweise nutzen Unternehmen maschinelles Lernen in SIEM-Software (Security Information and Event Management), um verdächtige Aktivitäten und potenzielle Bedrohungen zu erkennen. Durch die Analyse großer Datenmengen und das Erkennen von Mustern, die bekannten Schadcodes ähneln, können KI-Tools Sicherheitsteams auf neue und aufkommende Angriffe aufmerksam machen, oft viel früher als menschliche Mitarbeiter und bisherige Technologien.

KI in der Fertigung

Die Fertigung ist seit jeher führend bei der Integration von Robotern in Arbeitsabläufe, wobei der Schwerpunkt der jüngsten Entwicklungen auf kollaborativen Robotern, sogenannten Cobots, liegt. Im Gegensatz zu herkömmlichen Industrierobotern, die für die Ausführung einzelner Aufgaben programmiert wurden und getrennt von menschlichen Mitarbeitern arbeiten, sind Cobots kleiner, vielseitiger und für die Zusammenarbeit mit Menschen konzipiert. Diese Multitasking-Roboter können in Lagerhäusern, Fabrikhallen und anderen Arbeitsbereichen mehr Aufgaben übernehmen, darunter Montage, Verpackung und Qualitätskontrolle. Insbesondere der Einsatz von Robotern zur Ausführung oder Unterstützung repetitiver und körperlich anstrengender Aufgaben kann die Sicherheit und Effizienz der menschlichen Mitarbeiter verbessern.

KI im Transportwesen

Neben ihrer grundlegenden Rolle beim Betrieb autonomer Fahrzeuge werden KI-Technologien im Automobilverkehr eingesetzt, um den Verkehr zu steuern, Staus zu reduzieren und die Verkehrssicherheit zu verbessern. Im Flugverkehr kann KI Flugverspätungen vorhersagen, indem sie Datenpunkte wie Wetter- und Flugverkehrsbedingungen analysiert. In der Überseefracht kann KI die Sicherheit und Effizienz verbessern, indem sie Routen optimiert und den Zustand der Schiffe automatisch überwacht.

In Lieferketten ersetzt KI traditionelle Methoden der Nachfrageprognose und verbessert die Genauigkeit von Vorhersagen über potenzielle Störungen und Engpässe. Die COVID-19-Pandemie hat die Bedeutung dieser Fähigkeiten deutlich gemacht, da viele Unternehmen von den Auswirkungen einer globalen Pandemie auf das Angebot und die Nachfrage von Gütern überrascht wurden.

Augmented Intelligence versus künstliche Intelligenz

Der Begriff künstliche Intelligenz ist eng mit der Populärkultur verbunden, was in der Öffentlichkeit zu unrealistischen Erwartungen hinsichtlich der Auswirkungen von KI auf die Arbeit und das tägliche Leben führen kann. Ein vorgeschlagener alternativer Begriff, Augmented Intelligence (erweiterte Intelligenz), unterscheidet maschinelle Systeme, die Menschen unterstützen, von den vollständig autonomen Systemen aus der Science-Fiction – man denke an HAL 9000 aus 2001: Odyssee im Weltraum oder Skynet aus den Terminator-Filmen.

Die beiden Begriffe lassen sich wie folgt definieren:

- Augmented Intelligence: Mit seiner neutraleren Konnotation deutet der Begriff Augmented Intelligence darauf hin, dass die meisten KI-Implementierungen darauf abzielen, menschliche Fähigkeiten zu verbessern, anstatt sie zu ersetzen. Diese eng gefassten KI-Systeme verbessern in erster Linie Produkte und Dienstleistungen, indem sie bestimmte Aufgaben ausführen. Beispiele hierfür sind das automatische Aufzeigen wichtiger Daten in Business-Intelligence-Berichten oder das Hervorheben wichtiger Informationen in Rechtsdokumenten. Die rasche Einführung von Tools wie ChatGPT und Gemini in verschiedenen Branchen zeigt eine wachsende Bereitschaft, KI zur Unterstützung menschlicher Entscheidungsprozesse einzusetzen.

- Künstliche Intelligenz: In diesem Rahmen bleibt der Begriff KI für fortgeschrittene allgemeine KI reserviert, um die Erwartungen der Öffentlichkeit besser zu steuern und die Unterscheidung zwischen aktuellen Anwendungsfällen und dem Ziel der Verwirklichung von künstlicher allgemeiner Intelligenz zu verdeutlichen. Das Konzept der künstlichen allgemeinen Intelligenz ist eng mit dem Konzept der technologischen Singularität verbunden – einer Zukunft, in der eine künstliche Superintelligenz die kognitiven Fähigkeiten des Menschen weit übertrifft und unsere Realität auf eine Weise verändern kann, die wir uns heute noch nicht vorstellen können. Die Singularität ist seit langem ein fester Bestandteil der Science-Fiction, aber einige KI-Entwickler arbeiten heute aktiv an der Schaffung einer künstlichen allgemeinen Intelligenz.

Ethischer Einsatz künstlicher Intelligenz

KI-Tools bieten Unternehmen zwar eine Reihe neuer Funktionen, ihre Nutzung wirft jedoch erhebliche ethische Fragen auf. KI-Systeme verstärken, im Guten wie im Schlechten, das, was sie bereits gelernt haben, was bedeutet, dass diese Algorithmen in hohem Maße von den Daten abhängig sind, mit denen sie trainiert wurden. Da diese Trainingsdaten von Menschen ausgewählt werden, besteht ein inhärentes Potenzial für Verzerrungen, das genau überwacht werden muss.

Generative KI fügt eine weitere Ebene ethischer Komplexität hinzu. Diese Tools können äußerst realistische und überzeugende Texte, Bilder und Audiodateien erstellen – eine nützliche Funktion für viele legitime Anwendungen, aber auch ein potenzieller Vektor für Falschinformationen und schädliche Inhalte wie Deepfakes.

Daher muss jeder, der maschinelles Lernen in realen Produktionssystemen einsetzen möchte, ethische Aspekte in seine KI-Trainingsprozesse einbeziehen und sich bemühen, unerwünschte Verzerrungen zu vermeiden. Dies ist besonders wichtig für KI-Algorithmen, denen es an Transparenz mangelt, wie beispielsweise komplexe neuronale Netze, die im Deep Learning verwendet werden.

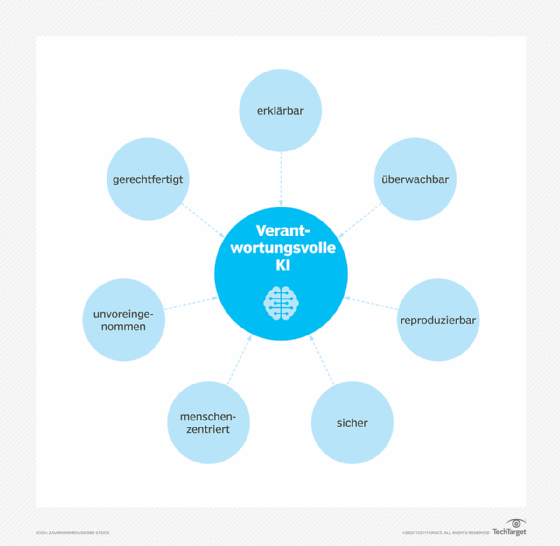

Verantwortungsvolle KI bezieht sich auf die Entwicklung und Implementierung sicherer, konformer und sozialverträglicher KI-Systeme. Sie wird durch Bedenken hinsichtlich algorithmischer Verzerrungen, mangelnder Transparenz und unbeabsichtigter Folgen vorangetrieben. Das Konzept basiert auf langjährigen Ideen aus der KI-Ethik, gewann jedoch an Bedeutung, als generative KI-Tools weit verbreitet wurden – und damit auch ihre Risiken. Die Integration verantwortungsvoller KI-Grundsätze in Geschäftsstrategien hilft Unternehmen, Risiken zu minimieren und das Vertrauen der Öffentlichkeit zu stärken.

Erklärbarkeit, also die Fähigkeit zu verstehen, wie ein KI-System Entscheidungen trifft, ist ein Bereich, der in der KI-Forschung zunehmend an Bedeutung gewinnt. Die mangelnde Erklärbarkeit stellt ein potenzielles Hindernis für den Einsatz von KI in Branchen mit strengen regulatorischen Anforderungen dar. Beispielsweise sind US-Finanzinstitute aufgrund von Gesetzen zur fairen Kreditvergabe verpflichtet, Kredit- und Kreditkartenantragstellern ihre Kreditentscheidungen zu erklären. Wenn KI-Programme solche Entscheidungen treffen, können jedoch die subtilen Zusammenhänge zwischen Tausenden von Variablen zu einem Black-Box-Problem führen, bei dem der Entscheidungsprozess des Systems undurchsichtig ist.

Zusammenfassend lassen sich folgende ethische Herausforderungen für KI nennen:

- Verzerrungen aufgrund unsachgemäß trainierter Algorithmen und menschlicher Vorurteile oder Versehen.

- Missbrauch generativer KI zur Erstellung von Deepfakes, Phishing-Betrug und anderen schädlichen Inhalten.

- Rechtliche Bedenken, darunter Verleumdung durch KI und Urheberrechtsfragen.

- Arbeitsplatzverluste aufgrund des zunehmenden Einsatzes von KI zur Automatisierung von Arbeitsaufgaben.

- Bedenken hinsichtlich des Datenschutzes, insbesondere in Bereichen wie dem Bankwesen, dem Gesundheitswesen und dem Rechtswesen, in denen sensible personenbezogene Daten verarbeitet werden.

KI-Governance und Regulierung

Trotz der potenziellen Risiken gibt es derzeit nur wenige Vorschriften für den Einsatz von KI-Tools, und viele bestehende Gesetze gelten eher indirekt als explizit für KI. Wie bereits erwähnt, verpflichten beispielsweise die US-amerikanischen Vorschriften zur fairen Kreditvergabe, wie der Equal Credit Opportunity Act, Finanzinstitute dazu, potenziellen Kunden ihre Kreditentscheidungen zu erklären. Dies schränkt den Umfang ein, in dem Kreditgeber Deep-Learning-Algorithmen einsetzen können, die naturgemäß undurchsichtig und nicht erklärbar sind.

Die Europäische Union hat sich proaktiv mit der KI-Governance befasst. Die Datenschutz-Grundverordnung (DSGVO) der EU legt bereits strenge Grenzen für die Verwendung von Verbraucherdaten durch Unternehmen fest, was sich auf das Training und die Funktionalität vieler KI-Anwendungen mit Kundenkontakt auswirkt. Darüber hinaus trat im August 2024 der EU AI Act in Kraft, der einen umfassenden Rechtsrahmen für die Entwicklung und den Einsatz von KI schaffen soll. Das Gesetz sieht je nach Risikograd unterschiedliche Regulierungsstufen für KI-Systeme vor, wobei Bereiche wie Biometrie und kritische Infrastrukturen einer strengeren Kontrolle unterliegen.

Die USA machen zwar Fortschritte, aber es fehlt noch immer eine spezielle Bundesgesetzgebung, die mit dem EU AI Act vergleichbar ist. Die Politik hat noch keine umfassende KI-Gesetzgebung verabschiedet, und die bestehenden Vorschriften auf Bundesebene konzentrieren sich auf bestimmte Anwendungsfälle und das Risikomanagement, ergänzt durch Initiativen der Bundesstaaten. Allerdings könnten die strengeren Vorschriften der EU letztendlich zu De-facto-Standards für multinationale Unternehmen mit Sitz in den USA werden, ähnlich wie die DSGVO die globale Datenschutzlandschaft geprägt hat.

Die Ausarbeitung von Gesetzen zur Regulierung der KI wird nicht einfach sein, zum einen, weil KI eine Vielzahl von Technologien umfasst, die für unterschiedliche Zwecke eingesetzt werden, und zum anderen, weil Vorschriften den Fortschritt und die Entwicklung der KI behindern und zu Gegenreaktionen der Industrie führen können. Die rasante Entwicklung der KI-Technologien ist ein weiteres Hindernis für die Schaffung sinnvoller Vorschriften, ebenso wie die mangelnde Transparenz der KI, die es schwierig macht, zu verstehen, wie Algorithmen zu ihren Ergebnissen gelangen. Darüber hinaus können technologische Durchbrüche und neuartige Anwendungen wie ChatGPT und Dall-E bestehende Gesetze schnell überflüssig machen. Und natürlich ist es unwahrscheinlich, dass Gesetze und andere Vorschriften böswillige Akteure davon abhalten werden, KI für schädliche Zwecke einzusetzen.

Wie ist die Geschichte der KI?

Das Konzept von unbelebten Objekten, die mit Intelligenz ausgestattet sind, gibt es schon seit der Antike. Der griechische Gott Hephaistos wurde in Mythen als roboterähnlicher Diener aus Gold dargestellt, während Ingenieure im alten Ägypten Götterstatuen bauten, die sich bewegen konnten und durch versteckte, von Priestern bediente Mechanismen zum Leben erweckt wurden.

Im Laufe der Jahrhunderte verwendeten Denker – vom griechischen Philosophen Aristoteles über den spanischen Theologen Ramon Llull im 13. Jahrhundert bis hin zum Mathematiker René Descartes und dem Statistiker Thomas Bayes – die Werkzeuge und die Logik ihrer Zeit, um menschliche Denkprozesse als Symbole zu beschreiben. Ihre Arbeit legte den Grundstein für KI-Konzepte wie allgemeine Wissensrepräsentation und logisches Denken.

Im späten 19. und frühen 20. Jahrhundert entstanden grundlegende Arbeiten, aus denen der moderne Computer hervorgehen sollte. Im Jahr 1836 erfanden der Mathematiker Charles Babbage und Augusta Ada King, Countess of Lovelace, von der Universität Cambridge den ersten Entwurf für eine programmierbare Maschine, die als Analytical Engine bekannt wurde. Babbage entwarf den ersten mechanischen Computer, während Lovelace – die oft als erste Computerprogrammiererin angesehen wird – die Fähigkeit der Maschine erkannte, über einfache Berechnungen hinauszugehen und alle algorithmisch beschreibbaren Operationen auszuführen.

Im Laufe des 20. Jahrhunderts prägten wichtige Entwicklungen in der Informatik das Gebiet, aus dem später die KI hervorgehen sollte. In den 1930er Jahren stellte der britische Mathematiker und Codeknacker des Zweiten Weltkriegs Alan Turing das Konzept einer universellen Maschine vor, die jede andere Maschine simulieren konnte. Seine Theorien waren entscheidend für die Entwicklung digitaler Computer und schließlich auch für die KI.

1940er

Der Princeton-Mathematiker John Von Neumann konzipierte die Architektur für den speicherprogrammierbaren Computer – die Idee, dass das Programm eines Computers und die von ihm verarbeiteten Daten im Speicher des Computers gespeichert werden können. Warren McCulloch und Walter Pitts schlugen ein mathematisches Modell künstlicher Neuronen vor und legten damit den Grundstein für neuronale Netze und andere zukünftige Entwicklungen der KI.

1950er

Mit dem Aufkommen moderner Computer begannen Wissenschaftler, ihre Ideen zur maschinellen Intelligenz zu testen. 1950 entwickelte Turing eine Methode, um festzustellen, ob ein Computer intelligent ist. Er nannte sie Imitationsspiel, doch heute ist sie besser bekannt als Turing-Test. Dieser Test bewertet die Fähigkeit eines Computers, seine Fragesteller davon zu überzeugen, dass seine Antworten auf ihre Fragen von einem Menschen stammen.

Der Beginn des modernen Bereichs der KI wird allgemein auf das Jahr 1956 während einer Sommerkonferenz am Dartmouth College datiert. Die von der Defense Advanced Research Projects Agency gesponserte Konferenz wurde von zehn Koryphäen auf diesem Gebiet besucht, darunter die KI-Pioniere Marvin Minsky, Oliver Selfridge und John McCarthy, dem die Prägung des Begriffs künstliche Intelligenz (artificial intelligence) zugeschrieben wird. Ebenfalls anwesend waren der Informatiker Allen Newell und der Ökonom, Politikwissenschaftler und Kognitionspsychologe Herbert A. Simon.

Die beiden stellten ihren bahnbrechenden Logic Theorist vor, ein Computerprogramm, das bestimmte mathematische Theoreme beweisen konnte und oft als erstes KI-Programm bezeichnet wird. Ein Jahr später, 1957, entwickelten Newell und Simon den Algorithmus General Problem Solver, der zwar komplexere Probleme nicht lösen konnte, aber den Grundstein für die Entwicklung ausgefeilterer kognitiver Architekturen legte.

1960er

Nach der Konferenz am Dartmouth College sagten führende Köpfe des noch jungen Fachgebiets der KI voraus, dass eine vom Menschen geschaffene Intelligenz, die der des menschlichen Gehirns gleichkommt, kurz bevorstehe, was große Unterstützung seitens der Regierung und der Industrie nach sich zog. Tatsächlich führten fast 20 Jahre gut finanzierte Grundlagenforschung zu bedeutenden Fortschritten in der KI. McCarthy entwickelte Lisp, eine Sprache, die ursprünglich für die KI-Programmierung entwickelt wurde und noch heute verwendet wird. Mitte der 1960er Jahre entwickelte der MIT-Professor Joseph Weizenbaum Eliza, ein frühes NLP-Programm, das den Grundstein für die heutigen Chatbots legte.

1970er

In den 1970er Jahren erwies sich die Verwirklichung der künstlichen allgemeinen Intelligenz aufgrund der Beschränkungen der Rechenleistung und Speicherkapazität von Computern sowie der Komplexität des Problems als schwer erreichbar und nicht unmittelbar bevorstehend. Infolgedessen ließ die Unterstützung der Regierung und der Unternehmen für die KI-Forschung nach, was zu einer Brachphase von 1974 bis 1980 führte, die als erster KI-Winter bekannt ist. Während dieser Zeit verzeichnete das noch junge Gebiet der KI einen erheblichen Rückgang der Finanzmittel und des Interesses.

1980er

In den 1980er Jahren lösten die Forschung zu Deep-Learning-Techniken und die Einführung von Edward Feigenbaums Expertensystemen in der Industrie eine neue Welle der Begeisterung für KI aus. Expertensysteme, die regelbasierte Programme verwenden, um die Entscheidungsfindung menschlicher Experten nachzuahmen, wurden für Aufgaben wie Finanzanalysen und klinische Diagnosen eingesetzt. Da diese Systeme jedoch kostspielig und in ihren Fähigkeiten begrenzt blieben, war der Aufschwung der KI nur von kurzer Dauer und es folgte ein weiterer Einbruch der staatlichen Finanzierung und der Unterstützung durch die Industrie. Diese Phase des rückläufigen Interesses und der sinkenden Investitionen, bekannt als der zweite KI-Winter, dauerte bis Mitte der 1990er Jahre.

1990er

Die zunehmende Rechenleistung und die explosionsartige Zunahme von Daten lösten Mitte bis Ende der 1990er Jahre eine Renaissance der KI aus und bereiteten den Weg für die bemerkenswerten Fortschritte, die wir heute in diesem Bereich erleben. Die Kombination aus Big Data und gesteigerter Rechenleistung führte zu Durchbrüchen in den Bereichen NLP, Computer Vision, Robotik, maschinelles Lernen und Deep Learning. Ein bedeutender Meilenstein wurde 1997 erreicht, als Deep Blue Kasparov besiegte und damit als erstes Computerprogramm einen Schachweltmeister schlug.

2000er

Weitere Fortschritte in den Bereichen maschinelles Lernen, Deep Learning, NLP, Spracherkennung und Computer Vision führten zu Produkten und Dienstleistungen, die unser heutiges Leben prägen. Zu den wichtigsten Entwicklungen zählen die Einführung der Suchmaschine von Google im Jahr 2000 und die Einführung der Empfehlungsmaschine von Amazon im Jahr 2001.

Ebenfalls in den 2000er Jahren entwickelte Netflix sein Filmempfehlungssystem, Facebook führte sein Gesichtserkennungssystem ein und Microsoft brachte sein Spracherkennungssystem für die Transkription von Audioaufnahmen auf den Markt. IBM lancierte sein Frage-Antwort-System Watson und Google startete seine Initiative für selbstfahrende Autos, Waymo.

2010er

In den zehn Jahren zwischen 2010 und 2020 gab es eine ganze Reihe von Entwicklungen im Bereich der KI. Dazu gehören die Einführung der Sprachassistenten Siri von Apple und Alexa von Amazon, die Siege von IBM Watson bei Jeopardy, die Entwicklung von Funktionen für selbstfahrende Autos und die Implementierung von KI-basierten Systemen, die Krebserkrankungen mit hoher Genauigkeit erkennen. Das erste Generative Adversarial Network wurde entwickelt, und Google brachte TensorFlow auf den Markt, ein Open-Source-Framework für maschinelles Lernen, das in der KI-Entwicklung weit verbreitet ist.

Ein wichtiger Meilenstein war 2012 das bahnbrechende AlexNet, ein Convolutional Neural Network (CNN), das den Bereich der Bilderkennung erheblich vorantrieb und den Einsatz von GPUs für das Training von KI-Modellen populär machte. Im Jahr 2016 besiegte das AlphaGo-Modell von Google DeepMind den Go-Weltmeister Lee Sedol und demonstrierte damit die Fähigkeit der KI, komplexe strategische Spiele zu meistern. Im Jahr zuvor wurde das Forschungslabor OpenAI gegründet, das in der zweiten Hälfte dieses Jahrzehnts wichtige Fortschritte im Bereich des bestärkenden Lernens und der NLP erzielen sollte.

2020er

Das aktuelle Jahrzehnt ist bislang geprägt von der Einführung generativer KI, die auf Basis von Nutzeranweisungen neue Inhalte erstellen kann. Diese Anweisungen erfolgen häufig in Form von Text, können aber auch Bilder, Videos, Entwürfe, Musik oder andere Eingaben sein, die das KI-System verarbeiten kann. Die erzeugten Inhalte reichen von Aufsätzen über Erklärungen zur Problemlösung bis hin zu realistischen Bildern, die auf Fotos einer Person basieren.

Im Jahr 2020 veröffentlichte OpenAI die dritte Version seines GPT-Sprachmodells, doch erst 2022 fand die Technologie breite Beachtung. In diesem Jahr begann die Welle der generativen KI mit der Einführung der Bildgeneratoren Dall-E 2 und Midjourney im April beziehungsweise Juli. Die Begeisterung und der Hype erreichten ihren Höhepunkt mit der allgemeinen Veröffentlichung von ChatGPT im November.

Die Konkurrenten von OpenAI reagierten schnell auf die Veröffentlichung von ChatGPT und brachten konkurrierende LLM-Chatbots auf den Markt, darunter Claude von Anthropic und Gemini von Google. Audio- und Videogeneratoren wie ElevenLabs und Runway folgten 2023 und 2024.

Die generative KI-Technologie steckt noch in den Kinderschuhen, was sich an ihrer anhaltenden Neigung zu Halluzinationen und der fortwährenden Suche nach praktischen, kostengünstigen Anwendungen zeigt. Dennoch haben diese Entwicklungen KI auf neue Weise in die öffentliche Diskussion gebracht und sowohl Begeisterung als auch Besorgnis ausgelöst.

KI-Tools und -Dienste: Entwicklung und Ökosysteme

KI-Tools und -Dienste entwickeln sich rasant weiter. Die aktuellen Innovationen lassen sich bis zum neuronalen Netzwerk AlexNet aus dem Jahr 2012 zurückverfolgen, das eine neue Ära der leistungsstarken KI auf Basis von GPUs und großen Datensätzen einläutete. Der entscheidende Fortschritt war die Entdeckung, dass neuronale Netzwerke parallel auf mehreren GPU-Kernen mit riesigen Datenmengen trainiert werden können, wodurch der Trainingsprozess skalierbarer wurde.

Im 21. Jahrhundert hat sich eine symbiotische Beziehung zwischen den algorithmischen Fortschritten von Unternehmen wie Google, Microsoft und OpenAI einerseits und den Hardware-Innovationen von Infrastruktur Anbietern wie Nvidia andererseits entwickelt. Diese Entwicklungen haben es möglich gemacht, immer größere KI-Modelle auf besser vernetzten GPUs auszuführen, was zu bahnbrechenden Verbesserungen in Bezug auf Leistung und Skalierbarkeit geführt hat. Die Zusammenarbeit zwischen diesen KI-Koryphäen war entscheidend für den Erfolg von ChatGPT, ganz zu schweigen von Dutzenden anderer bahnbrechender KI-Dienste. Hier sind einige Beispiele für Innovationen, die die Entwicklung von KI-Tools und -Diensten vorantreiben.

Transformer

Google war führend bei der Suche nach einem effizienteren Prozess für die Bereitstellung von KI-Training in großen Clustern von handelsüblichen PCs mit GPUs. Dies wiederum ebnete den Weg für die Entdeckung der Transformers, die viele Aspekte des Trainings von KI mit unbeschrifteten Daten automatisieren. Mit dem 2017 veröffentlichten Artikel Attention Is All You Need stellten Google-Forscher eine neuartige Architektur vor, die Selbstaufmerksamkeitsmechanismen nutzt, um die Modellleistung bei einer Vielzahl von NLP-Aufgaben wie Übersetzung, Textgenerierung und Zusammenfassung zu verbessern. Diese Transformer-Architektur war für die Entwicklung moderner LLMs, darunter ChatGPT, von entscheidender Bedeutung.

Hardware-Optimierung

Hardware ist für die Entwicklung effektiver, effizienter und skalierbarer KI ebenso wichtig wie die algorithmische Architektur. GPUs, die ursprünglich für die Grafikwiedergabe entwickelt wurden, sind für die Verarbeitung riesiger Datensätze unverzichtbar geworden. Tensor-Prozessoren und neuronale Prozessoren, die speziell für Deep Learning entwickelt wurden, haben das Training komplexer KI-Modelle beschleunigt. Anbieter wie Nvidia haben den Mikrocode für die parallele Ausführung auf mehreren GPU-Kernen für die gängigsten Algorithmen optimiert. Chiphersteller arbeiten außerdem mit großen Cloud-Anbietern zusammen, um diese Funktion als AI as a Service (AIaaS) über IaaS-, SaaS- und PaaS-Modelle zugänglicher zu machen.

Generative Pre-Trained Transformer (GPT) und Feinabstimmung

Der KI-Stack hat sich in den letzten Jahren rasant weiterentwickelt. Früher mussten Unternehmen ihre KI-Modelle von Grund auf trainieren. Heute bieten Anbieter wie OpenAI, Nvidia, Microsoft und Google Generative Pre-Trained Transformer (GPT) an, die für bestimmte Aufgaben mit deutlich geringeren Kosten, weniger Fachwissen und weniger Zeitaufwand fein abgestimmt werden können.

KI-Cloud-Services und AutoML

Eines der größten Hindernisse für den effektiven Einsatz von KI in Unternehmen ist die Komplexität der Data-Engineering- und Data-Science-Aufgaben, die erforderlich sind, um KI-Funktionen in neue oder bestehende Anwendungen zu integrieren. Alle führenden Cloud-Anbieter bringen eigene AIaaS-Angebote auf den Markt, um die Datenaufbereitung, Modellentwicklung und Anwendungsbereitstellung zu optimieren. Beispiele sind Amazon, Google, Microsoft Azure und Azure ML, IBM Watson und die KI-Funktionen von Oracle Cloud.

In ähnlicher Weise bieten die großen Cloud-Anbieter und andere Anbieter automatisierte Machine-Learning-Plattformen (AutoML) an, um viele Schritte der ML- und KI-Entwicklung zu automatisieren. AutoML-Tools demokratisieren KI-Funktionen und verbessern die Effizienz bei KI-Implementierungen.

Moderne KI-Modelle als Service

Führende Entwickler von KI-Modellen bieten zusätzlich zu diesen Cloud-Services auch modernste KI-Modelle an. OpenAI verfügt über mehrere LLMs, die für Chat, NLP, Multimodalität und Codegenerierung optimiert sind und über Azure bereitgestellt werden. Nvidia verfolgt einen eher Cloud-unabhängigen Ansatz und verkauft KI-Infrastruktur und Basismodelle, die für Text, Bilder und medizinische Daten über alle Cloud-Anbieter hinweg optimiert sind. Viele kleinere Anbieter bieten ebenfalls Modelle an, die auf verschiedene Branchen und Anwendungsfälle zugeschnitten sind.