KI-Ethik

Was ist KI-Ethik?

KI-Ethik ist ein System moralischer Grundsätze und Techniken, das die Entwicklung und verantwortungsvolle Nutzung von Technologien der künstlichen Intelligenz unterstützen soll. Da KI zu einem integralen Bestandteil von Produkten und Dienstleistungen geworden ist, beginnen auch Organisationen mit der Entwicklung von KI-Ethikkodizes.

Ein KI-Ethikkodex, auch KI-Werteplattform genannt, ist eine Grundsatzerklärung, die die Rolle der künstlichen Intelligenz in Bezug auf die Entwicklung und das Wohlergehen des Menschen formal definiert. Der Zweck eines KI-Ethikkodex besteht darin, Interessengruppen bei ethischen Entscheidungen über den Einsatz künstlicher Intelligenz eine Orientierungshilfe zu bieten.

Isaac Asimov, ein Science-Fiction-Autor, sah die potenziellen Gefahren autonomer KI-Agenten bereits 1942 voraus, lange vor der Entwicklung von KI-Systemen. Er schuf die drei Gesetze der Robotik, um diese Risiken zu begrenzen. In Asimovs Ethikkodex verbietet das erste Gesetz Robotern, Menschen aktiv Schaden zuzufügen oder durch Untätigkeit Schaden zuzulassen. Das zweite Gesetz befiehlt Robotern, Menschen zu gehorchen, es sei denn, die Befehle stehen nicht im Einklang mit dem ersten Gesetz. Das dritte Gesetz befiehlt Robotern, sich selbst zu schützen, soweit dies mit den ersten beiden Gesetzen vereinbar ist.

Zu den potenziellen Gefahren von KI-Systemen gehören heute der Ersatz menschlicher Arbeitsplätze durch KI, KI-Halluzinationen, Deepfakes und KI-Voreingenommenheit. Diese Probleme können für Entlassungen von Menschen, irreführende Informationen, die falsche Nachahmung von Bildern oder Stimmen anderer oder voreingenommene Entscheidungen verantwortlich sein, die sich negativ auf das Leben von Menschen auswirken können.

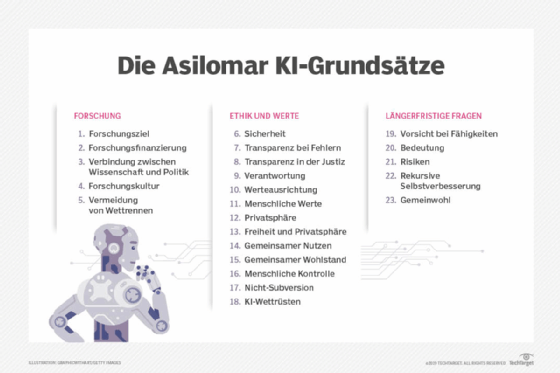

Der rasante Fortschritt der KI in den letzten zehn Jahren hat Expertengruppen dazu veranlasst, Schutzmaßnahmen gegen die Risiken der KI für den Menschen zu entwickeln. Eine dieser Gruppen ist das gemeinnützige Future of Life Institute, das vom Kosmologen Max Tegmark vom Massachusetts Institute of Technology, dem Skype-Mitbegründer Jaan Tallinn und der Google-DeepMind-Forscherin Victoria Krakovna gegründet wurde. Das Institut arbeitete mit KI-Forschern und -Entwicklern sowie Wissenschaftlern aus vielen Fachrichtungen zusammen, um die 23 Richtlinien zu erstellen, die heute als Asilomar AI Principles bezeichnet werden.

Kelly Combs, Director Advisory von Emerging Technology Risk Services für KPMG US, sagt, dass es bei der Entwicklung eines KI-Ethikkodexes „unerlässlich ist, klare Richtlinien darüber festzulegen, wie die Technologie eingesetzt und kontinuierlich überwacht wird.“ Diese Richtlinien sollten Maßnahmen vorschreiben, die vor unbeabsichtigten Verzerrungen in Algorithmen für maschinelles Lernen (ML) schützen, Abweichungen in Daten und Algorithmen kontinuierlich erkennen und sowohl die Herkunft der Daten als auch die Identität derjenigen, die Algorithmen trainieren, nachverfolgen.

Grundsätze der KI-Ethik

Es gibt viele unterschiedliche ethische Grundsätze für KI, an die sich jemand bei der Implementierung eines KI-Systems halten kann. Einige Grundsätze orientieren sich beispielsweise am Belmont Report. Der Belmont Report ist ein 1979 von der National Commission for the Protection of Human Subjects of Biomedical and Behavioral Research erstelltes Dokument. Darin werden die folgenden drei Leitprinzipien für den ethischen Umgang mit Menschen genannt:

- Respekt vor Personen. Dies erkennt die Autonomie des Einzelnen an und steht im Zusammenhang mit dem Konzept der informierten Einwilligung.

- Wohltätigkeit. Dies steht im Zusammenhang mit dem Konzept, keinen Schaden anzurichten.

- Gerechtigkeit. Dieses Prinzip konzentriert sich auf Fairness und Gleichheit.

Obwohl der Belmont Report ursprünglich für die Humanforschung entwickelt wurde, wurde er von akademischen Forschern und politischen Instituten auf die KI-Entwicklung angewendet. Der erste Punkt bezieht sich auf die Einwilligung und Transparenz in Bezug auf die Rechte des Einzelnen bei der Nutzung von KI-Systemen. Der zweite Punkt bezieht sich darauf, sicherzustellen, dass KI-Systeme keinen Schaden anrichten, wie zum Beispiel die Verstärkung von Vorurteilen. Und der dritte Punkt bezieht sich darauf, wie der Zugang zu KI gleichmäßig verteilt wird.

Zu den weiteren gängigen Vorstellungen in Bezug auf KI-Ethikgrundsätze gehören:

- Transparenz und Rechenschaftspflicht

- Auf den Menschen ausgerichtete Entwicklung und Nutzung

- Sicherheit

- Nachhaltigkeit und Wirkung

Warum ist KI-Ethik wichtig?

KI ist eine von Menschen entwickelte Technologie, die menschliche Intelligenz replizieren, erweitern oder ersetzen soll. Diese Tools stützen sich in der Regel auf große Mengen verschiedener Datentypen, um Erkenntnisse zu gewinnen. Schlecht konzipierte Projekte, die auf fehlerhaften, unzureichenden oder voreingenommenen Daten basieren, können unbeabsichtigte, potenziell schädliche Folgen haben. Darüber hinaus bedeutet der rasche Fortschritt bei algorithmischen Systemen, dass in einigen Fällen nicht klar ist, wie die KI zu ihren Schlussfolgerungen gelangt ist, sodass sich Menschen im Wesentlichen auf Systeme verlassen, die sie nicht erklären können, um Entscheidungen zu treffen, die sich auf die Gesellschaft auswirken können.

Ein KI-Ethik-Framework ist wichtig, da es die Risiken und Vorteile von KI-Tools aufzeigt und Richtlinien für deren verantwortungsvollen Einsatz festlegt. Um ein System moralischer Grundsätze und Techniken für den verantwortungsvollen Einsatz von KI zu entwickeln, müssen die Branche und interessierte Parteien wichtige gesellschaftliche Fragen untersuchen und sich letztlich mit der Frage auseinandersetzen, was uns zu Menschen macht.

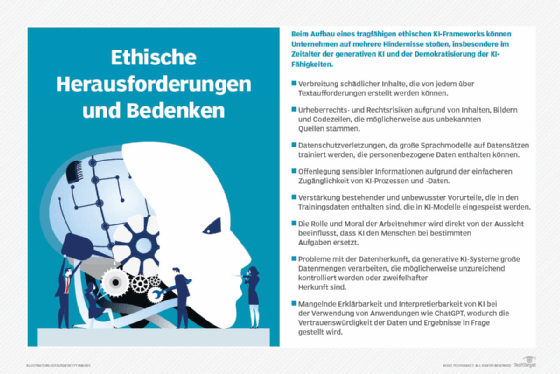

Was sind die Herausforderungen bei ethischer KI?

Unternehmen stehen bei der Nutzung von KI-Technologien vor folgenden ethischen Herausforderungen:

- Erklärbarkeit. Wenn KI-Systeme fehlschlagen, müssen Teams in der Lage sein, eine komplexe Kette algorithmischer Systeme und Datenprozesse zu durchlaufen, um herauszufinden, warum dies der Fall ist. Organisationen, die KI einsetzen, sollten in der Lage sein, die Quelldaten, die resultierenden Daten, die Funktionsweise ihrer Algorithmen und die Gründe dafür zu erklären. „KI muss ein hohes Maß an Rückverfolgbarkeit aufweisen, um sicherzustellen, dass Schäden auf die Ursache zurückgeführt werden können“, sagt Adam Wisniewski, CTO und Mitbegründer von AI Clearing.

- Verantwortung. Die Gesellschaft ist noch dabei, die Verantwortung zu klären, wenn Entscheidungen, die von KI-Systemen getroffen werden, katastrophale Folgen haben, einschließlich des Verlusts von Kapital, Gesundheit oder Leben. An der Klärung der Verantwortlichkeit für die Folgen KI-basierter Entscheidungen sollten eine Reihe von Interessengruppen beteiligt sein, darunter Anwälte, Regulierungsbehörden, KI-Entwickler, Ethikgremien und Bürger. Eine Herausforderung besteht darin, das richtige Gleichgewicht zu finden, wenn ein KI-System sicherer ist als die menschliche Tätigkeit, die es dupliziert, aber dennoch Probleme verursacht, wie zum Beispiel die Abwägung der Vorzüge autonomer Fahrsysteme, die zwar Todesfälle verursachen, aber weitaus weniger als Menschen.

- Fairness. Bei Datensätzen, die personenbezogene Daten enthalten, ist es äußerst wichtig, sicherzustellen, dass es keine Vorurteile in Bezug auf Rasse, Geschlecht oder ethnische Zugehörigkeit gibt.

- Ethik. KI-Algorithmen können für andere Zwecke verwendet werden als die, für die sie entwickelt wurden. Beispielsweise können Menschen die Technologie nutzen, um Deepfakes von anderen zu erstellen oder andere durch die Verbreitung von Fehlinformationen zu manipulieren. Wisniewski sagt, dass diese Szenarien in der Designphase analysiert werden sollten, um die Risiken zu minimieren und Sicherheitsmaßnahmen einzuführen, um die negativen Auswirkungen in solchen Fällen zu verringern.

- Privatsphäre. Da KI riesige Datenmengen benötigt, um richtig trainiert zu werden, verwenden einige Unternehmen öffentlich zugängliche Daten, wie zum Beispiel Daten aus Webforen oder Social-Media-Beiträgen, für das Training. Andere Unternehmen wie Facebook, Google und Adobe haben in ihre Richtlinien aufgenommen, dass sie Benutzerdaten für das Training ihrer KI-Modelle verwenden können, was zu Kontroversen beim Schutz von Benutzerdaten führt.

- Arbeitsplatzverlagerung. Anstatt KI zu nutzen, um menschliche Arbeit zu erleichtern, können einige Organisationen KI-Tools einsetzen, um menschliche Arbeitsplätze vollständig zu ersetzen. Diese Praxis ist umstritten, da sie sich direkt auf diejenigen auswirkt, die ersetzt werden, und KI-Systeme sind immer noch anfällig für Halluzinationen und andere Unzulänglichkeiten.

- Umwelt. KI-Modelle benötigen viel Energie zum Trainieren und Ausführen, was einen großen CO2-Fußabdruck hinterlässt. Wenn der Strom, den sie verbrauchen, hauptsächlich aus Kohle oder fossilen Brennstoffen erzeugt wird, verursacht dies noch mehr Umweltverschmutzung.

Die Veröffentlichung und schnelle Einführung generativer KI-Anwendungen wie ChatGPT und Dall-E, die auf der Grundlage vorhandener Daten trainiert werden, um neue Inhalte zu generieren, verstärken die ethischen Probleme im Zusammenhang mit KI und bringen Risiken im Zusammenhang mit Fehlinformationen, Plagiaten, Urheberrechtsverletzungen und schädlichen Inhalten mit sich.

Was sind die Vorteile einer KI-Ethik?

Die rasche Beschleunigung der KI-Einführung in Unternehmen fällt mit zwei wichtigen Trends zusammen – und hat in vielen Fällen dazu beigetragen, diese zu befeuern: dem Aufstieg der Kundenorientierung und dem Anstieg des sozialen Aktivismus.

„Unternehmen werden nicht nur für die Bereitstellung personalisierter Produkte und Dienstleistungen belohnt, sondern auch dafür, dass sie die Werte der Kunden wahren und Gutes für die Gesellschaft tun, in der sie tätig sind“, sagt Sudhir Jha, CEO von Brighterion und Executive Vice President von Mastercard.

KI spielt eine große Rolle dabei, wie Verbraucher mit einer Marke interagieren und sie wahrnehmen. Ein verantwortungsvoller Einsatz ist notwendig, um eine positive Wirkung zu erzielen. Neben den Verbrauchern möchten auch die Mitarbeiter ein gutes Gefühl bei den Unternehmen haben, für die sie arbeiten. „Eine verantwortungsvolle KI kann einen großen Beitrag dazu leisten, Talente zu binden und einen reibungslosen Ablauf der Geschäftstätigkeit eines Unternehmens zu gewährleisten“, erläutert Jha.

Was ist ein KI-Ethikkodex?

Ein proaktiver Ansatz zur Gewährleistung einer ethischen KI erfordert laut Jason Shepherd, CEO von Atym, die Berücksichtigung der folgenden drei Schlüsselbereiche:

- Policy. Dazu gehört die Entwicklung eines geeigneten Rahmens zur Förderung der Standardisierung und zur Festlegung von Vorschriften. Dokumente wie die Asilomar AI-Prinzipien können nützlich sein, um das Gespräch zu beginnen. Regierungsbehörden in den USA, Europa und anderswo haben Anstrengungen unternommen, um eine ethische KI sicherzustellen, und eine Reihe von Standards, Tools und Techniken von Forschungseinrichtungen, Anbietern und akademischen Institutionen stehen zur Verfügung, um Organisationen bei der Ausarbeitung von KI-Richtlinien zu unterstützen. Siehe den Abschnitt Ressourcen für die Entwicklung ethischer KI weiter unten. Ethische KI-Richtlinien müssen sich mit dem Umgang mit rechtlichen Fragen befassen, wenn etwas schief geht. Unternehmen sollten in Erwägung ziehen, KI-Richtlinien in ihre eigenen Verhaltenskodizes aufzunehmen. Die Wirksamkeit hängt jedoch davon ab, dass die Mitarbeiter die Regeln befolgen, was nicht immer realistisch ist, wenn es um Geld oder Prestige geht.

- Bildung. Führungskräfte, Datenwissenschaftler, Unternehmensanwender und Verbraucher müssen alle die Richtlinien, die wichtigsten Überlegungen und die potenziellen negativen Auswirkungen von unethischer KI und gefälschten Daten verstehen. Ein großes Problem ist der Kompromiss zwischen der einfachen Nutzung beim Datenaustausch und der KI-Automatisierung und den potenziellen negativen Auswirkungen von übermäßigem Austausch oder nachteiliger Automatisierung. „Letztendlich ist die Bereitschaft der Verbraucher, proaktiv die Kontrolle über ihre Daten zu übernehmen und auf potenzielle Bedrohungen zu achten, die durch KI ermöglicht werden, eine komplexe Gleichung, die auf einer Kombination aus sofortiger Befriedigung, Wert, Wahrnehmung und Risiko basiert“, erklärt Shepherd.

- Technologie. Führungskräfte müssen auch KI-Systeme entwickeln, die gefälschte Daten und unethisches Verhalten automatisch erkennen. Dazu muss nicht nur die KI eines Unternehmens selbst betrachtet werden, sondern auch die Lieferanten und Partner auf den böswilligen Einsatz von KI überprüft werden. Beispiele hierfür sind die Verbreitung von Deepfake-Videos und -Texten, um einen Konkurrenten zu untergraben, oder der Einsatz von KI zur Durchführung ausgeklügelter Cyberangriffe. Dies wird mit zunehmender Kommerzialisierung von KI-Tools zu einem immer größeren Problem werden. Um diesem potenziellen Schneeballeffekt entgegenzuwirken, müssen Unternehmen in Abwehrmaßnahmen investieren, die auf einer offenen, transparenten und vertrauenswürdigen KI-Infrastruktur basieren. Shepherd glaubt, dass dies zu einem Vertrauensverhältnis führen wird, das einen systemweiten Ansatz zur Automatisierung der Datenschutzsicherung, zur Gewährleistung der Datenvertraulichkeit und zur Erkennung einer unethischen Nutzung von KI bietet.

Beispiele für KI-Ethikkodizes

Ein KI-Ethikkodex kann die Grundsätze darlegen und die Motivation für angemessenes Verhalten liefern. Im Folgenden wird beispielsweise der KI-Ethikkodex von Mastercard zusammengefasst:

- Ein ethisches KI-System muss inklusiv, erklärbar und positiv sein und verantwortungsvoll mit Daten umgehen.

- Ein inklusives KI-System ist unvoreingenommen. KI-Modelle müssen mit großen und vielfältigen Datensätzen trainiert werden, um Voreingenommenheit zu verringern. Außerdem ist eine kontinuierliche Aufmerksamkeit und Feinabstimmung erforderlich, um problematische Eigenschaften, die im Trainingsprozess erlernt wurden, zu ändern.

- Ein erklärbares KI-System sollte beherrschbar sein, um sicherzustellen, dass Unternehmen es ethisch umsetzen können. Systeme sollten transparent und erklärbar sein.

- Ein KI-System sollte einen positiven Zweck haben und diesen beibehalten. In vielen Fällen kann dies beispielsweise dazu dienen, Menschen bei ihrer Arbeit zu unterstützen. KI-Systeme sollten so implementiert werden, dass sie nicht für negative Zwecke eingesetzt werden können.

- Ethische KI-Systeme sollten auch die Datenschutzrechte einhalten. Auch wenn KI-Systeme in der Regel eine große Datenmenge zum Training benötigen, sollten Unternehmen dafür nicht die Datenschutzrechte ihrer Benutzer oder anderer Personen opfern.

Unternehmen wie Mastercard, Salesforce und Lenovo haben sich zur Unterzeichnung eines freiwilligen KI-Verhaltenskodex verpflichtet, was bedeutet, dass sie sich für die verantwortungsvolle Entwicklung und Verwaltung generativer KI-Systeme einsetzen. Der Kodex basiert auf der Entwicklung eines kanadischen Ethikkodex für generative KI sowie auf Beiträgen einer Reihe von Interessengruppen.

Google hat auch seine eigenen KI-Leitprinzipien, die die Verantwortlichkeit der KI, potenzielle Vorteile, Fairness, Datenschutz, Sicherheit, soziale und andere menschliche Werte betonen.

Ressourcen für die Entwicklung ethischer KI

Im Folgenden finden Sie eine Auswahl aus der wachsenden Zahl von Organisationen, politischen Entscheidungsträgern und Regulierungsstandards, die sich auf die Entwicklung ethischer KI-Praktiken konzentrieren:

- AI Now Institute. Das Institut konzentriert sich auf die sozialen Auswirkungen von KI und die politische Forschung im Bereich verantwortungsbewusste KI. Zu den Forschungsbereichen gehören algorithmische Rechenschaftspflicht, kartellrechtliche Bedenken, Biometrie, Arbeitnehmerdatenrechte, groß angelegte KI-Modelle und Datenschutz. Der Bericht AI Now 2023 Landscape: Confronting Tech Power (PDF) bietet einen tiefen Einblick in viele ethische Fragen, die bei der Entwicklung ethischer KI-Richtlinien hilfreich sein können.

- Berkman Klein Center for Internet & Society an der Harvard University. Das Center fördert die Forschung zu den großen Fragen im Zusammenhang mit der Ethik und Steuerung von KI. Die vom Center unterstützte Forschung hat sich mit Themen wie Informationsqualität, Algorithmen in der Strafjustiz, Entwicklung von KI-Steuerungsrahmen und algorithmischer Rechenschaftspflicht befasst.

- CEN-CENELEC Joint Technical Committee 21 Artificial Intelligence. JTC 21 ist eine laufende Initiative der Europäischen Union (EU) für verschiedene verantwortungsvolle KI-Standards. Die Gruppe erstellt Standards für den europäischen Markt und informiert über die Gesetzgebung, Politik und Werte der EU. Sie legt auch technische Anforderungen zur Charakterisierung von Transparenz, Robustheit und Genauigkeit in KI-Systemen fest.

- Institute for Technology, Ethics and Culture (ITEC). Das ITEC-Handbuch ist ein Gemeinschaftsprojekt des Markkula-Zentrums für angewandte Ethik der Santa Clara University und des Vatikans zur Entwicklung eines praktischen, schrittweisen Fahrplans für die Technologieethik. Das ITEC-Handbuch enthält ein fünfstufiges Reifegradmodell mit spezifischen, messbaren Schritten, die Unternehmen auf jeder Reifegradstufe unternehmen können. Es fördert auch einen operativen Ansatz zur Umsetzung von Ethik als fortlaufende Praxis, ähnlich wie DevSecOps für Ethik. Die Kernidee besteht darin, Rechts-, Technik- und Geschäftsteams in den frühen Phasen der ethischen KI zusammenzubringen, um Fehler zu einem Zeitpunkt zu beseitigen, an dem ihre Behebung noch viel kostengünstiger ist als nach dem verantwortungsvollen Einsatz von KI.

- ISO/IEC 23894:2023 IT-AI-Guidance on risk management. Die International Organization for Standardization (ISO) und die International Electrotechnical Commission (IEC) beschreiben, wie eine Organisation Risiken speziell im Zusammenhang mit KI managen kann. Der Leitfaden kann dazu beitragen, die Fachsprache zu standardisieren, die die zugrunde liegenden Prinzipien und ihre Anwendung bei der Entwicklung, Bereitstellung oder dem Angebot von KI-Systemen charakterisiert. Er behandelt auch Richtlinien, Verfahren und Praktiken zur Bewertung, Behandlung, Überwachung, Überprüfung und Aufzeichnung von Risiken. Es ist sehr technisch und eher auf Ingenieure als auf Wirtschaftsexperten ausgerichtet.

- NIST AI Risk Management Framework. Dieser Leitfaden des National Institute of Standards and Technology für Regierungsbehörden und den Privatsektor konzentriert sich auf das Management neuer KI-Risiken und die Förderung verantwortungsvoller KI. Abhishek Gupta, Gründer und leitender Forscher am Montreal AI Ethics Institute, weist auf die Tiefe des NIST-Frameworks hin, insbesondere auf seine Spezifität bei der Umsetzung von Kontrollen und Richtlinien zur besseren Steuerung von KI-Systemen in verschiedenen organisatorischen Kontexten.

- Nvidia NeMo Guardrails. Dieses Toolkit bietet eine flexible Schnittstelle zur Definition spezifischer Verhaltensregeln, die Bots befolgen müssen. Es unterstützt die Modellierungssprache Colang. Ein leitender Datenwissenschaftler gab in einem Anwendungsbeispiel an, dass sein Unternehmen das Open-Source-Toolkit verwendet, um zu verhindern, dass ein Support-Chatbot auf der Website eines Anwalts Antworten gibt, die als Rechtsberatung ausgelegt werden können.

- Stanford Institute for Human-Centered Artificial Intelligence (HAI). Die Aufgabe des HAI besteht darin, fortlaufend Forschung zu betreiben und Leitlinien für bewährte Verfahren für menschenzentrierte KI bereitzustellen. Eine frühe Initiative in Zusammenarbeit mit Stanford Medicine ist Responsible AI for Safe and Equitable Health, die sich mit ethischen und sicherheitsrelevanten Fragen im Zusammenhang mit KI im Gesundheits- und Medizinwesen befasst.

- Towards Unified Objectives for Self-Reflective AI. Dieses von Matthias Samwald, Robert Praas und Konstantin Hebenstreit verfasste Dokument verfolgt einen sokratischen Ansatz, um zugrunde liegende Annahmen, Widersprüche und Fehler durch Dialog und Hinterfragen von Wahrhaftigkeit, Transparenz, Robustheit und Angleichung ethischer Grundsätze zu identifizieren. Ein Ziel ist die Entwicklung von KI-Metasystemen, in denen zwei oder mehr KI-Komponentenmodelle ihre gegenseitige Leistung ergänzen, kritisieren und verbessern.

- The Presidio Recommendations on Responsible Generative AI des Weltwirtschaftsforums. Diese 30 handlungsorientierten Empfehlungen helfen dabei, die Komplexität der KI zu bewältigen und ihr Potenzial ethisch zu nutzen. Dieses Whitepaper enthält auch Abschnitte über die verantwortungsvolle Entwicklung und Freigabe generativer KI, offene Innovation, internationale Zusammenarbeit und sozialen Fortschritt.

Diese Organisationen stellen eine Reihe von Ressourcen bereit, die als solide Grundlage für die Entwicklung ethischer KI-Praktiken dienen. Die Nutzung dieser Ressourcen als Framework kann Organisationen dabei unterstützen, sicherzustellen, dass sie KI auf ethische Weise entwickeln und einsetzen.

Die Zukunft der ethischen KI

Einige argumentieren, dass ein Ethikkodex für KI schnell veraltet sein kann und dass ein proaktiverer Ansatz erforderlich ist, um sich an ein sich schnell entwickelndes Feld anzupassen. Arijit Sengupta, Gründer und CEO von Aible, einer KI-Entwicklungsplattform, sagt: „Das grundlegende Problem eines Ethikkodex für KI ist, dass er reaktiv und nicht proaktiv ist. Wir neigen dazu, Dinge wie Voreingenommenheit zu definieren und nach Voreingenommenheit zu suchen und zu versuchen, sie zu beseitigen – als ob das möglich wäre.“

Ein reaktiver Ansatz kann Schwierigkeiten haben, mit in den Daten eingebetteten Vorurteilen umzugehen. Wenn Frauen beispielsweise in der Vergangenheit keine Kredite zu angemessenen Zinssätzen erhalten haben, wird dies auf verschiedene Weise in die Daten eingewoben. „Wenn Sie Variablen im Zusammenhang mit dem Geschlecht entfernen, wird die KI einfach andere Variablen heranziehen, die als Stellvertreter für das Geschlecht dienen“, so Sengupta.

Er ist der Meinung, dass die Zukunft der ethischen KI darin bestehen muss, über die Definition von Fairness und gesellschaftlichen Normen zu sprechen. So müssten beispielsweise bei einer Kreditbank die Geschäftsführung und die KI-Teams entscheiden, ob sie eine gleichberechtigte Berücksichtigung anstreben. Der Fokus muss auf einem Leitprinzip liegen und nicht auf etwas, das es zu vermeiden gilt, argumentiert Sengupta.

Die meisten Menschen sind sich einig, dass es einfacher und effektiver ist, Kindern beizubringen, welche Leitprinzipien sie befolgen sollten, als jede mögliche Entscheidung, mit der sie konfrontiert werden könnten, aufzulisten und ihnen zu sagen, was sie tun und was sie nicht tun sollten. „Das ist der Ansatz, den wir bei der KI-Ethik verfolgen“, sagt Sengupta. „Wir sagen einem Kind, was es tun und was es nicht tun kann, anstatt ihm Leitprinzipien an die Hand zu geben und es dann selbst herausfinden zu lassen.“

Vorerst entwickeln Menschen Regeln und Technologien, die eine verantwortungsvolle KI fördern. Shepherd verweist darauf, dass dazu die Programmierung von Produkten und Angeboten gehöre, die die Interessen der Menschen schützen und nicht gegen bestimmte Gruppen wie Minderheiten, Menschen mit besonderen Bedürfnissen und Arme voreingenommen sind. Letzteres ist besonders besorgniserregend, da KI das Potenzial hat, massive soziale und wirtschaftliche Konflikte zu schüren und die Kluft zwischen denen, die sich Technologie leisten können, und denen, die das nicht können, zu vergrößern.

Die Gesellschaft muss auch dringend Vorkehrungen für den unethischen Einsatz von KI durch Kriminelle treffen. Die heutigen KI-Systeme reichen von ausgeklügelten Regelwerken über Machine-Learning-Modelle, die einfache Aufgaben automatisieren, bis hin zu generativen KI-Systemen, die menschliche Intelligenz nachahmen. „Es kann Jahrzehnte dauern, bis empfindungsfähige KIs entstehen, die ihr eigenes unethisches Verhalten in einem Ausmaß automatisieren können, mit dem Menschen nicht mithalten können“, so Shepherd. Angesichts der rasanten Entwicklung der KI ist es jedoch an der Zeit, Leitplanken zu entwickeln, um dieses Szenario zu verhindern.

In Zukunft kann es zu einer Zunahme von Klagen kommen, wie sie beispielsweise die New York Times gegen OpenAI und Microsoft im Zusammenhang mit der Verwendung von New-Times-Artikeln als KI-Trainingsdaten angestrengt hat. OpenAI hat sich auch in weitere Kontroversen verwickelt, welche die Zukunft beeinflussen können, wie beispielsweise die Überlegung, zu einem gewinnorientierten Geschäftsmodell überzugehen. Elon Musk hat außerdem ein KI-Modell angekündigt, das sowohl durch die Bilder, die es erstellen kann, als auch durch die ökologischen und sozialen Auswirkungen des physischen Standorts, an dem es aufgestellt wird, für Kontroversen sorgte. Die Zukunft der KI wird von diesem Vorstoß an ethische Grenzen sowie von einem Aufbegehren gegen ethische, soziale und wirtschaftliche Bedenken und einem Ruf nach ethischeren Umsetzungen durch Regierungen und Bürger geprägt sein.