Kaspars Grinvalds - stock.adobe.

Wie Entwickler Verzerrungen in KI-Algorithmen bekämpfen

Da KI alle Arten von Software durchdringt, sollten Tester einen Plan zur Überprüfung der Ergebnisse entwickeln. Entwickler sollten aber zuerst das Bias beseitigen.

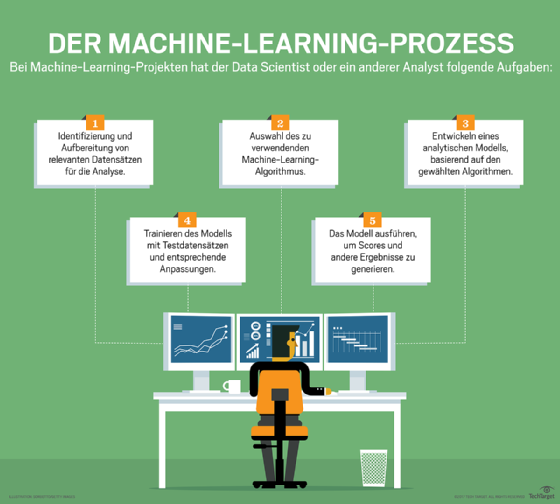

Viele moderne Softwaresysteme aus den Bereichen Finanzen, E-Commerce, Fertigung, Transport und anderen Branchen beinhalten inzwischen KI-Technologie. Anwendungen, die künstliche Intelligenz (KI) – oder insbesondere Machine Learning – verwenden, stellen für Tester ein neuartiges Problem dar: systematische Verzerrung.

Algorithmusverzerrungen beruhen ähnlich wie menschliche Vorurteile auf subjektiven Erfahrungen. Wie Vorurteile bestimmte soziale Sachverhalte verzerren, geschieht dies analog auch im Softwarebereich.

Bei KI-Software liegen die Erfahrungen der Vergangenheit in Form von Daten vor. Diese werden zur Validierung und zum Training der Systeme verwendet. Allerdings können Entwickler und Architekten versehentlich oder unwissentlich den Input der Daten so auswählen oder beeinflussen, dass sie die Problemdomäne nicht exakt repräsentieren. Dann würde der KI-Algorithmus etwa beim Machine Learning ein Bias erzeugen, der die Ausgabe und damit den Nutzen eines KI-Systems beeinträchtigt.

Durch die Medien ging vor einiger Zeit die Meldung, dass die KI-Algorithmen von Google, Facebook und Co. hauptsächlich von jungen, männlichen, weißen Personen aus Kalifornien trainiert werden. Da diese die Trainingsdaten nach ihren Vorlieben einseitig auswählen, benachteiligen sie Personen aus anderen Kulturkreisen und Ländern – Frauen, Afroamerikaner, Chinesen. Bilden die Daten keinen repräsentativen Querschnitt der Bevölkerung, verzerrt dies die KI-Algorithmen.

Unzählige Beispiele zeugen von solchen Verzerrungen. Viele Websites und Suchmaschinen versuchen zum Beispiel, Benutzermerkmale zu identifizieren, um den Anwendern geeignete Produkte und Dienstleistungen anzubieten. Dabei machen Datenanalysten jedoch oft Annahmen, die die Ergebnisse verzerren. Weil zum Beispiel Männer eher Softwareentwicklungs-Websites aufrufen, könnte das System weibliche Benutzer als männlich kategorisieren. Diese Ungenauigkeit beeinflusst die Entscheidungen einer KI-Anwendung.

Außerdem werden häufig Korrelationen – also statistische Zusammenhänge – mit Ursachen verwechselt. Um ein plakatives Beispiel zu benutzen: Schuhgröße korreliert mit Einkommen. Je größer die Schuhe, umso mehr verdient der Schuhträger. Natürlich ist die Schuhgröße nicht die Ursache für die Einkommensunterschiede. Die Ursache ist das Geschlecht – und da Männer im Durchschnitt größere Schuhe tragen und mehr verdienen als Frauen, ergibt sich diese Korrelation.

Auch unvollständige Daten für eine Problemdomäne können Ungenauigkeiten verursachen, die zu einer Verzerrung des Algorithmus in Form von schädlichen Feedbackschleifen führen. Die realen Auswirkungen der Verzerrung auf die Trainingsdaten der Software sind tiefgreifend. Wenn niemand ihre Ergebnisse in Frage stellt, können prädiktive KI-basierte Anwendungen ihre eigenen Vorurteile im Laufe der Zeit verschärfen.

Schädliche Rückkopplungsschleifen

Ein Paradebeispiel für eine Art von schädlicher Rückkopplungsschleife, die zu Algorithmenverzerrungen führen kann, wurde in dem Buch Weapons of Math Destruction von der Mathematikerin Cathy O'Neil analysiert. Sie verweist auf KI-Systeme, die das Rückfallrisiko von verurteilten Straftätern bewerten. Menschen, in diesem Fall ein Richter, der die Strafe eines Gefangenen bestimmt, akzeptieren die Vorhersagen der Software als wahr – oder zumindest als wahr genug, um nützlich zu sein – und stellen die Entscheidungen der Software selten in Frage.

Verwenden Sie die richtigen Daten und Tests

Tester müssen Algorithmen und damit zusammenhängende Verzerrungen in KI-Anwendungen aufspüren. Nur so lassen sich die schädlichen Auswirkungen verhindern, die durch ungenaue Ergebnisse verursacht werden. Sie suchen nach Bugs, Logikfehlern und nach grundlegenden Defekten in der Software oder den Daten.

Es ist jedoch nahezu unmöglich, eine Vorhersage zurückzuverfolgen und einen Algorithmus so durchzugehen, dass man erkennt, warum sich dieses bestimmte Resultat ergeben hat. Algorithmen sind für diese Art von Analyse zu komplex, weshalb die Menschen von der Richtigkeit der Ergebnisse des maschinellen Lernens ausgehen.

Um die Genauigkeit einer KI-Anwendung zu bestimmen, sollten Sie Daten über die Algorithmusverzerrung sammeln – also was er falsch gemacht oder ignoriert hat. Verwenden Sie diese Informationen dann, um sie zu analysieren und zu verbessern. Sammeln Sie nicht nur Daten aus genauen Vorhersagen. Akzeptieren und erwarten Sie eine bestimmte Fehlerwahrscheinlichkeit.

Überprüfen Sie auch sorgfältig die Trainingsdaten und Validierungssätze, die zum Aufbau des Wissensbestandes einer KI-Anwendung verwendet werden. Untersuchen Sie, was die Trainingsdaten tatsächlich messen und ob sie sowohl einen logischen als auch einen praktischen Bezug zum Endergebnis haben.

Beginnen Sie keinen Proxy-Krieg

In mathematischen Modellen entscheiden sich Data Scientists manchmal für Proxy-Messungen oder -Metriken, wenn keine neueren und relevanteren Daten verfügbar sind. Proxy- Metriken messen Eigenschaften, die in der Regel einer direkten Messung nicht zugänglich ist.

Solche Proxy-Messungen können allerdings schief gehen. Wenn Sie Daten verwenden, um Vorhersagen über etwas anderes zu ersetzen, gibt es Einschränkungen. Häufig sind diese Daten nicht zu 100 Prozent auf die Vorhersage eines Modells anwendbar. Viele prüfen nicht genügend, ob es einen ausreichenden Zusammenhang zwischen Proxy-Metriken und der Vorhersage selbst gibt. Und wenn doch, gehen sie oft davon aus, dass eine Korrelation hinreichend ist.

Softwareentwickler in der Qualitätssicherung müssen auch normale Testfälle und Edge Cases untersuchen, um sicherzustellen, dass die richtigen Entscheidungen getroffen werden. Diese Testfälle können ihnen helfen, festzustellen, ob die Ergebnisse eines KI-Algorithmus korrekt und nicht verzerrt sind.

Es kann schwierig sein, einen Algorithmus oder die in ihn eingespeisten Trainingsdaten wiederherzustellen oder zu verwerfen, da das bedeutet, dass das KI-Modell komplett neu überdacht werden muss – was teuer wird. Aber dieses Ergebnis ist besser als ein Softwareprodukt, das ohne Erklärung falsche Ergebnisse liefert.

Die Tester müssen ihre Rolle von der traditionellen Überprüfung der Funktionalität und der Anforderungen an die User Story auf die Algorithmusintegrität erweitern. Wer auf ein Algorithmen-Bias testet, muss prüfen, was schiefgelaufen ist, und was die Auswirkungen neuer Eingabedaten und die Beziehungen zwischen einzelnen Systemen ist. In diesem Zusammenhang sollten die Tester bei der Bestimmung der Softwarequalität diskret sein und mit viel Feingefühl eruieren, ob die KI-Algorithmen tatsächlich die bestmöglichen Entscheidungen treffen.

Fakten versus Fiktion bei Händlerwerbung

Softwareprodukte in verschiedenen Branchen werben heute oft mit ihren KI-Fähigkeiten, die dem Endanwender die Arbeit erleichtern sollen. Natürlich versuchen einige Anbieter einfach, den aktuelle KI-Trend auszunutzen, ohne dass das vielleicht einen großen Nutzen hat. Andere hingegen können ihren Kunden über die KI tatsächlich einen echten Wettbewerbsvorteil verschaffen.