Jintana - stock.adobe.com

Model Context Protocol (MCP): wenn Sprachmodelle handeln

Sprachmodelle lernen nicht nur, sie steuern und wandeln Sprache in Aktionen um. Das Model Context Protocol liefert das verbindende Protokoll zwischen Modell und Funktion.

Sprachmodelle berechnen Text. Jede Handlung, die darüber hinausgeht, muss über Sprache initiiert werden. Werkzeuge, die in der physischen oder digitalen Welt operieren, lassen sich von einem Large Language Model (LLM) nicht direkt ansprechen. Sie müssen als Text beschrieben, kodiert und aufgerufen werden.

Hier setzt das Model Context Protocol (MCP) an. MCP definiert einen klaren Mechanismus, um aus natürlicher Sprache strukturierte Aktionen zu erzeugen, die ein Tool, ein Server oder eine Ressource verarbeiten kann. Es stellt keine neue Schnittstelle bereit, sondern beschreibt den Aufbau einer bestehenden. Es bildet den Rahmen, in dem Modelle, Clients und externe Systeme sinnvoll interagieren können.

Technische Struktur und Grundprinzipien

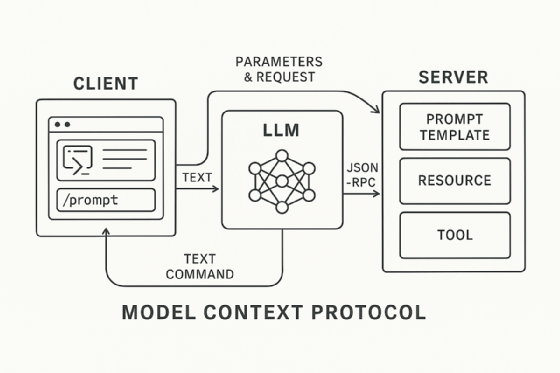

Das Setup des Model Context Protocols besteht immer aus einem Client, einem Modell und einem oder mehreren Servern. Der Client dient als Interaktionspunkt, oft in Form eines LLM-Frontends wie Goose oder Claude Desktop. Die Server implementieren Funktionen, stellen Daten bereit oder definieren Prompt-Vorlagen. Die Kommunikation erfolgt über JSON-RPC. Inhalte werden als Textobjekte übertragen und Aufbau und Funktionsweise orientieren sich am Language Server Protocol. Server und Client müssen sich nicht auf unterschiedlichen Maschinen befinden. Viele Server laufen lokal, operieren über StandardIO und nutzen kein Netzwerkinterface. Dadurch können selbst einfache Programme im Terminal zu vollwertigen MCP-Komponenten werden.

Model Context Protocol kennt drei zentrale Objekttypen:

- Tools fassen konkrete Handlungen zusammen, die das Modell anstoßen kann. Sie kapseln Funktionen, wie zum Beispiel das Steuern eines Programms, das Modifizieren eines Dateisystems oder das Starten eines externen Dienstes.

- Ressourcen liefern unstrukturierte oder strukturierte Daten, die als Kontext in eine Aufgabe einfließen können. Dazu zählen Dateien, Dokumentationen oder dynamisch generierte Inhalte.

- Prompts dienen der Interaktion und bilden anpassbare Vorlagen, die Nutzer selbst verändern oder direkt abrufen können. Die Eingabe erfolgt über einfache Kommandos. Ein Slash-Befehl ruft einen Prompt auf, der anschließend an das Modell übergeben wird.

Standardisierung als Antrieb

Die Idee von MCP stammt von Entwicklern bei Anthropic, die nach einem effizienteren Weg suchten, Inhalte zwischen Claude Desktop und ihrer Entwicklungsumgebung zu synchronisieren. Kopieren, Einfügen, Umformatieren, der Aufwand war hoch, der Nutzen gering. Die Lösung bestand darin, eine textbasierte Zwischenschicht zu definieren, die beide Systeme verstehen. Was als internes Tool begann, entwickelte sich rasch zur treibenden Kraft für ein neues Paradigma. Beim Hackathon im Herbst 2024 entstanden nahezu alle Projekte auf Basis des Model Context Protocols. Ohne Vorgabe oder Strategiepapier. Nur aus dem Wunsch heraus, Werkzeuge einfacher verfügbar zu machen. Integration wurde zum dominierenden Thema, Standardisierung zur gemeinsamen Sprache.

Die offene Spezifikation trug wesentlich zur schnellen Verbreitung bei. Entwickler können sofort loslegen: Server aufsetzen, Tools definieren und Kontexte laden. Wer Claude auf einem lokalen System nutzt, kann mit wenigen Zeilen Python ein neues Tool anbinden. Claude erkennt die Funktionen automatisch, analysiert deren Beschreibungen und ruft sie bei Bedarf auf. Die Server können lokal laufen oder remote bereitgestellt werden. Die Bereitstellung eines Remote MCP Server ist ein zentrales Feature. Claude kann über das Internet mit Webservern interagieren, die das Protokoll unterstützen. Diese Fähigkeit eröffnet neue Möglichkeiten für verteilte Architekturen.

MCP in der Anwendung

Der Zugriff auf Systemfunktionen ist nur ein Teil des Spektrums. Mit Goose lassen sich Audioeinstellungen ändern, Programme starten oder Dateien verwalten. Doch MCP reicht weit darüber hinaus. In einer Anwendung erzeugt Claude per Textbefehl 3D-Objekte in Blender. Die Anbindung erfolgt über einen MCP-Server, der Python-Code generiert und an Blender weiterleitet. Ein anderes Beispiel nutzt das Protokoll, um Musiksequenzen auf einem Hardware-Synthesizer zu programmieren. Auch Türöffner, CAD-Systeme oder vollständige Geschäftsanwendungen lassen sich anbinden. MCP wird zur semantischen Steuerungsschicht, die zwischen Modell und realer Auswirkung vermittelt.

Die Architektur erlaubt ein hohes Maß an Parallelität. Ein Modell kann gleichzeitig auf zahlreiche Server zugreifen, Funktionen priorisieren, kombinieren oder sequenziell ausführen. Die Auswahl erfolgt textbasiert. Das Modell entscheidet anhand der internen Beschreibung der Tools, welche Aktion zum jeweiligen Kontext passt. Voraussetzung ist eine eindeutige semantische Signatur. Überschneidungen können zu Verwirrung führen. Doch bei klar getrennten Aufgabenfeldern lässt sich eine Vielzahl an Servern integrieren.

Von Claude gesteuerte Serverauswahl und Tool-Differenzierung

Modelle wie Claude müssen nicht passiv auf vordefinierte Server limitiert sein. Sie können bei Bedarf aus einer Vielzahl von angebundenen Servern selbstständig die passenden auswählen und aufrufen. Die Entscheidung erfolgt semantisch, anhand der Beschreibung der Tools und ihrer Funktionalität. Dabei ist nicht die Anzahl der Server entscheidend, sondern deren inhaltliche Trennung.

Überlappen sich Aufgabenbereiche, etwa bei mehreren Issue-Trackern, steigt die Wahrscheinlichkeit für Fehlentscheidungen. Liegen die Domänen dagegen klar auseinander, lassen sich problemlos Dutzende Server gleichzeitig integrieren. Diese Fähigkeit zur Tool-Differenzierung wird mit zunehmender Modellintelligenz robuster. Je präziser ein Tool beschrieben ist, desto zuverlässiger trifft das Modell die richtige Auswahl.

Lang laufende Aufgaben und agentische Erweiterung

Mit wachsender Modellintelligenz verschiebt sich der Fokus von unmittelbaren Werkzeugaufrufen hin zu komplexeren Abläufen über längere Zeithorizonte. MCP trägt dieser Entwicklung durch spezifische Primitive Rechnung, etwa für Zustandsmanagement und prozedurales Sampling. Besonders relevant wird das in agentischen Kontexten, in denen LLMs nicht nur Befehle reaktiv ausführen, sondern aktiv nach passenden Servern suchen, Kontext nachfordern oder Aufgaben zwischenspeichern. Die Einführung der Registry API eröffnet diese Spielräume. Damit kann ein Modell zur Laufzeit eigenständig neue MCP-Server auffinden und einbinden. Diese Fähigkeit markiert den Übergang vom Tool zum selbstorganisierenden Systemakteur mit Zugriff auf offene Funktionsräume.

MCP wurde von Anfang an so konzipiert, dass auch komplexere Interaktionsmuster unterstützt werden. Dazu zählen langlaufende Aufgaben, Zustandsverwaltung und die Fähigkeit, gezielt Rückfragen an Nutzer zu stellen. Diese sogenannten Elicitation-Primitive ermöglichen es einem Server, aktiv Informationen einzuholen, bevor er eine Aktion ausführt. Noch werden diese Funktionen selten genutzt, doch mit der Einführung leistungsfähigerer Modelle wie Claude Opus oder GPT-4o wächst das Interesse an zustandsbehafteten Agentensystemen. Das Protokoll unterstützt diese Entwicklung durch die geplante Registry API. Ein Modell kann darüber gezielt neue Server suchen, anbinden und in laufende Prozesse einbinden. Der Zugriff auf Funktionalität wird damit dynamisch und bedarfsgetrieben.

Auch die Sicherheit erhält mehr Gewicht. Themen wie Autorisierung, Identitätsprüfung und Zugriffskontrolle rücken in den Mittelpunkt, insbesondere im Unternehmenskontext. Die Standardisierung dieser Mechanismen ist in Arbeit, ebenso wie eine präzisere Beschreibung der Tool-Schnittstellen. Ziel ist ein System, in dem Modelle eigenständig, aber kontrollierbar handeln können. Nicht über spontane Eingaben, sondern durch strukturierte Entscheidungsbäume, die in textuelle Form gegossen sind.

Didaktischer Zugriff über bestehende Server und Lernmuster

Der Einstieg in die Arbeit mit MCP beginnt nicht bei der eigenen Server-Implementierung, sondern beim Erkunden bereits existierender Instanzen. Viele Entwickler nutzen zunächst öffentliche MCP-Server im Zusammenspiel mit Claude Desktop, um das Interaktionsmuster nachzuvollziehen. Dabei lassen sich reale Antworten erzeugen, Parameter studieren und typische Abläufe beobachten. Das vereinfacht später das Schreiben eigener Komponenten. Besonders niedrigschwellig sind Server, die bewusst einfach gehalten sind, zum Beispiel mit einer einzigen Tool-Funktion oder einer exemplarischen Ressourcenantwort. Diese reduzierten Konfigurationen machen die Prinzipien des Protokolls unmittelbar erfahrbar, ohne dass eine vollständige Integration notwendig ist.

Die Einstiegshürde ist gering. Erste Tests lassen sich lokal umsetzen. Claude Code verarbeitet die offizielle Dokumentation, generiert funktionsfähige Server und erlaubt schnelle Experimente. Wer mehr möchte, kombiniert Tools, Ressourcen und Prompts zu eigenen Workflows. Die Geschwindigkeit, mit der sich funktionierende Szenarien realisieren lassen, trägt entscheidend zur Verbreitung bei.

Zwischen Protokoll und Plattform

MCP ist kein Tool. Es ist ein Format, das Werkzeuge zugänglich macht. Es definiert nicht, was eine Anwendung tut, sondern wie ein Modell erfährt, was verfügbar ist. Ähnlich wie HTTP nicht Inhalte vorgibt, sondern deren Transport regelt, beschreibt MCP keine Funktionen, sondern deren Einbettung in kontextgesteuerte Modellinteraktion. Wer mit Claude einen Synthesizer programmiert, tut das nicht über ein spezielles Interface, sondern über Sprache, Text und semantische Steuerung. MCP liefert das Regelwerk, das diesen Zugriff strukturiert.

Was daraus entsteht, ist offen: Agentensysteme, modulare Automatisierung und anpassbare Schnittstellenlandschaften. Für Unternehmen eröffnet sich ein Weg, komplexe Prozesse über KI-gesteuerte Chatinteraktion zu orchestrieren, ohne neue Tools zu entwickeln. Bestehende Systeme lassen sich anbinden, kombinieren und vereinfachen. Die KI wird nicht ersetzt, sie wird eingebettet. Der Nutzer muss keine Befehle mehr kennen. Nur noch das Ziel formulieren.