Getty Images/iStockphoto

Wie man KI-Systeme auf Transparenz und Compliance überprüft

KI-Audits unterstützen Unternehmen dabei, bei der Einführung von KI-Systemen Funktionalität, Transparenz und Compliance sicherzustellen. Erfahren Sie, wie Sie KI-Audits angehen.

KI-Audits sind ein wesentlicher Bestandteil der KI-Strategie eines Unternehmens, egal ob bei Anwenderfirmen oder KI-Anbieter.

KI-Audits stützen sich sowohl auf traditionelle Audit-Methoden als auch auf Governance Frameworks und stellen sicher, dass diese Systeme die Standards für Funktionalität, Transparenz, Ethik und Compliance erfüllen. Es gibt zwar keinen einheitlichen Ansatz, aber bewährte Verfahren wie die Definition des Umfangs, die Durchführung gründlicher Bewertungen und die Dokumentation der Ergebnisse können ein Unternehmen auf Erfolgskurs bringen.

Nachdem Sie sich mit den wichtigsten Schritten eines KI-Audits vertraut gemacht haben, erfahren Sie mehr über die Gründe für die Durchführung eines solchen Audits sowie über interne und regulatorische Aspekte, die zu beachten sind.

7 wichtige Schritte zur Durchführung eines KI-Audits

Diese sieben Schritte können Unternehmen beim Einstieg in ein KI-Audit unterstützen:

- Definieren Sie den Umfang des Audits. Legen Sie den Hauptzweck des Audits, die zu bewertenden KI-Systeme oder -Anwendungen sowie die zu bewertenden Risiken und Auswirkungen fest.

- Dokumentieren Sie. Sammeln Sie detaillierte Informationen über die Funktionalität des KI-Systems, den Verwendungszweck sowie die internen und externen Nutzer.

- Bewerten Sie die Datenqualität und die Vorverarbeitung. Identifizieren Sie die Quellen und die Herkunft der Trainingsdaten, einschließlich der Rechte zur Verwendung dieser Daten für das Training von KI-Modellen. Überprüfen Sie, ob Datenschutzverletzungen vorliegen, und analysieren Sie, ob die Zusammensetzung der Daten zu Verzerrungen und Fehlern führen kann.

- Bewerten Sie die Entwicklungs- und Bereitstellungsprozesse. Untersuchen Sie die verwendeten Algorithmen und deren Transparenz. Bewerten Sie, ob geschützte Kategorien wie personenbezogene Daten indirekt über korrelierte Variablen verwendet werden, und stellen Sie fest, ob Standardprozesse für die Bereitstellung und die Überwachung der Leistung vorhanden sind.

- Analysieren Sie die Auswirkungen auf die Nutzer. Überprüfen Sie, ob es Beschwerden von Nutzern gegeben hat, und stellen Sie sicher, dass die Endanwender über den Einsatz von KI in der Organisation informiert sind. Überprüfen Sie je nach Anwendungsfall anhand relevanter Fairness-Metriken, ob Verzerrungen vorliegen, und testen Sie den Datenschutz und die Anwendungssicherheit.

- Überprüfen Sie die Compliance. Die geltenden Vorschriften variieren je nach Branche, Land und KI-System. Befolgen Sie daher die spezifischen Vorschriften und verwenden Sie gegebenenfalls maßgeschneiderte Checklisten.

- Dokumentieren Sie die Ergebnisse und entwickeln Sie einen Aktionsplan. Erstellen Sie einen Bericht, in dem die festgestellten Probleme, Belege und Empfehlungen detailliert aufgeführt sind. Besprechen Sie die Ergebnisse mit den wichtigsten Stakeholdern und entwickeln Sie Roadmaps für Verbesserungen, gegebenenfalls unter der Leitung des internen Auditors oder des Auditteams.

Was ist ein KI-Audit?

Ein KI-Audit – manchmal auch als Bias- oder Algorithmus-Audit bezeichnet – ist ein strukturierter Prozess zur Bewertung von Aspekten eines KI-Systems, einschließlich seines Designs, seiner Algorithmen, Daten, Entwicklung und seines Betriebs. Das Ziel besteht darin, zu bestätigen, dass das System die Leistungskriterien erfüllt und den regulatorischen Anforderungen entspricht.

Ein KI-Audit ist eine ganzheitliche Bewertung. Beispielsweise resultiert KI-Bias nicht nur aus den Trainingsdaten, sondern auch aus Designentscheidungen, algorithmischen Architekturen, Systementwicklungs- und -bereitstellungspraktiken sowie Fehlerbehandlungs- und Sicherheitsmechanismen. Durch die Betrachtung aller Aspekte eines KI-Systems können Audits solche Risiken identifizieren und mindern.

Die Hauptziele von KI-Audits bestehen darin, zu überprüfen, ob das System die folgenden Merkmale aufweist:

- Funktionalität. Das KI-System ist für die vorgesehenen Aufgaben genau und zuverlässig.

- Transparenz. Die Funktionsweise des Systems, einschließlich seiner Algorithmen, Eingaben und Ausgaben, ist ausreichend verständlich. Dies wird häufig anhand der Interpretierbarkeit oder Erklärbarkeit bewertet.

- Ethisches Verhalten. Das System minimiert Verzerrungen, Schäden und diskriminierende Ergebnisse für Einzelpersonen oder Gruppen.

- Compliance. Das KI-System hält alle geltenden Standards und Vorschriften ein.

Warum gibt es KI-Audits?

Unternehmen führen KI-Audits in verschiedenen Kontexten durch:

- Vor der Bereitstellung, um Probleme zu identifizieren und zu beheben, bevor die Systeme in Produktion gehen.

- Nach der Bereitstellung, um die Leistung in der Praxis zu überwachen.

- Als Teil von Betriebsprüfungen oder aufgrund gesetzlicher Vorschriften.

- Als Teil der Ursachenanalyse nach einem Vorfall.

- Als Teil der Due Diligence bei Fusionen und Übernahmen.

- Durch Versicherungsgesellschaften bei der Übernahme von Risiken.

Der Umfang und die Kriterien des Audits werden auf den jeweiligen Zweck zugeschnitten.

Methoden und Frameworks für KI-Audits

Die Methoden für KI-Audits basieren auf bewährten Auditpraktiken aus den Bereichen Technologie, Risikomanagement und Sicherheit. Beispiele hierfür sind:

- Control Objectives for Information and Related Technologies (COBIT)

- COSO Enterprise Risk Management Framework

- Standards des Institute of Internal Auditors

- Framework des National Institute of Standards and Technology (NIST)

Für die Einhaltung spezifischer Vorschriften stehen auch spezielle Frameworks und Tools zur Verfügung. Das CapAI-Tool der Universität Oxford bewertet beispielsweise KI-Systeme gemäß dem EU AI Act.

KI-Audits und Governance

KI-Audits sind ein integraler Bestandteil der KI-Governance. So schreibt beispielsweise der neu verabschiedete EU AI Act Audits als obligatorisches Element vor.

Interne KI-Audits

Unternehmen können KI-Audits durch die Einrichtung eines internen KI-Auditors oder eines Auditteams verwalten. Dieses Team sollte mit den Bereichen KI, IT, Risiko, Recht und den einzelnen Geschäftsbereichen zusammenarbeiten, um Mängel in KI-Systemen zu identifizieren und zu beheben. Die Rolle eines internen KI-Audit-Teams ist vergleichbar mit der eines internen Auditors in einer Finanzabteilung, der interne Überprüfungen durchführt und sein Unternehmen bei der Vorbereitung auf externe Audits unterstützt.

Auch KI-Anbieter profitieren von der Durchführung interner KI-Audits für ihre Produkte, da sie damit ihr Engagement für verantwortungsvolle KI-Praktiken unter Beweis stellen. Solche Auditberichte werden zunehmend sowohl von Behörden als auch von privaten Unternehmen bei der Beschaffung von KI-Produkten verlangt.

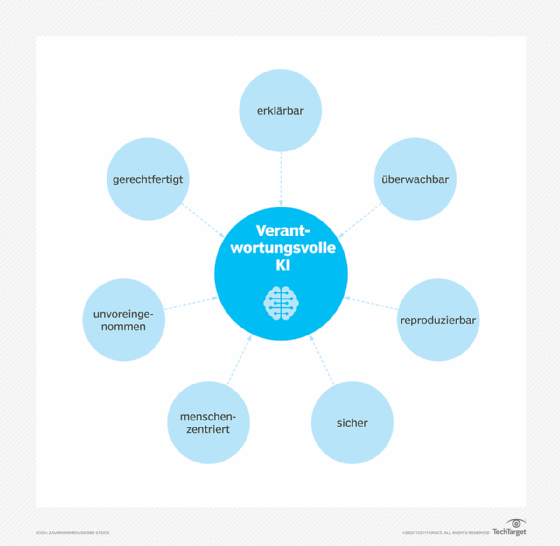

KI-Audits können auch bewerten, ob Unternehmen verantwortungsvolle KI-Praktiken befolgen, erklärbare KI-Methoden anwenden, KI-Governance-Tools implementieren und bewährte Verfahren für maschinelles Lernen und Sicherheit einhalten. Freiwillige Standards für das KI-Risikomanagement, wie das NIST AI Risk Management Framework und ISO/IEC 42001, bieten zusätzliche Leitlinien für diese Art von Audits.

Audits für generative KI oder Large Language Models (LLM) erfordern zusätzliche Überlegungen. Diese Audits umfassen die Bewertung potenzieller Probleme im Zusammenhang mit geistigen Eigentumsrechten, den Umgang mit Halluzinationen, die Offenlegung von KI-generierten Inhalten sowie die Gewährleistung des Datenschutzes und der Datensicherheit.