Generative KI (GenAI, generative künstliche Intelligenz)

Was ist generative KI?

Generative KI ist eine Technologie der künstlichen Intelligenz, die in der Lage ist, verschiedene Arten von Inhalten zu erzeugen, einschließlich Text, Bilder, Audio und synthetische Daten. Der große Hype um die generative KI im Jahr 2023 wurde durch die Einführung neuer, benutzerfreundlicher Oberflächen ausgelöst, die es ermöglichen, hochwertige Texte, Grafiken und Videos in Sekundenschnelle zu erstellen.

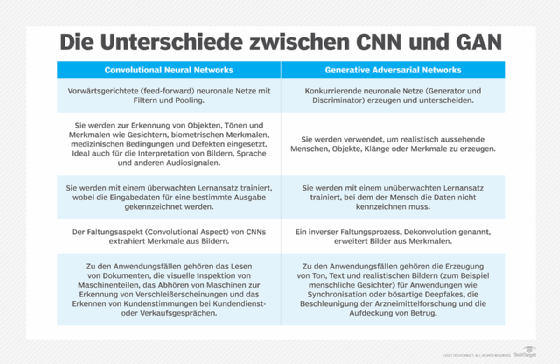

Obwohl die Technologie nicht gänzlich neu ist und bereits in den 1960er Jahren in Chatbots eingesetzt wurde, erlebte sie einen bedeutenden Durchbruch im Jahr 2014. Mit der Einführung von generativen gegensätzlichen Netzwerken (Generative Adversarial Networks, GANs), einer speziellen Art von maschinellen Lernalgorithmen, wurde es möglich, überzeugend authentische Bilder, Videos und Audiodateien von echten Menschen zu erstellen.

Diese neu entdeckte Fähigkeit eröffnete einerseits vielversprechende Möglichkeiten, wie beispielsweise eine verbesserte Synchronisation von Filmen und die Erstellung reichhaltiger Bildungsinhalte. Andererseits hat sie auch Bedenken hervorgerufen, insbesondere im Hinblick auf Deepfakes – digital gefälschte Bilder oder Videos – und potenzielle schädliche Cyberangriffe auf Unternehmen. Ein Beispiel für solche Angriffe sind bösartige Anfragen, die den Vorgesetzten eines Mitarbeiters täuschend echt imitieren können.

Zwei weitere Fortschritte, auf die im Folgenden näher eingegangen wird, haben entscheidend dazu beigetragen, dass sich generative KI durchgesetzt hat: Transformer und die bahnbrechenden Sprachmodelle, die erstere ermöglicht haben. Transformer sind eine Art des maschinellen Lernens, die es den Forschern erlaubt, immer größere Modelle zu trainieren, ohne alle Daten im Voraus kennzeichnen zu müssen. Neue Modelle konnten so mit Milliarden von Textseiten trainiert werden, was zu Antworten mit größerer Tiefe führte. Darüber hinaus haben die Transformer ein neues Konzept, die so genannte Attention (Aufmerksamkeit), entwickelt, die es den Modellen ermöglicht, die Verbindungen zwischen Wörtern über Seiten, Kapitel und Bücher hinweg zu verfolgen und nicht nur in einzelnen Sätzen. Und nicht nur Wörter: Die Transformer konnten ihre Fähigkeit, Verbindungen zu verfolgen, auch zur Analyse von Code, Proteinen, Chemikalien und DNA nutzen.

Die rasanten Fortschritte bei den so genannten großen Sprachmodellen (Large Language Models, LLMs) – Modelle mit Milliarden oder sogar Billionen von Parametern – haben eine neue Ära eingeleitet, in der generative KI-Modelle fesselnde Texte schreiben, fotorealistische Bilder malen und sogar einigermaßen unterhaltsame Sitcoms im Handumdrehen erstellen können. Darüber hinaus ermöglichen Innovationen im Bereich der multimodalen KI den Teams die Generierung von Inhalten über mehrere Medientypen hinweg, einschließlich Text, Grafik und Video. Dies ist die Grundlage für Tools wie Dall-E, die automatisch Bilder auf Basis einer Textbeschreibung oder Textunterschriften auf Bildern basierend erstellen.

Trotz dieser Durchbrüche stehen wir bei der Nutzung generativer KI zur Erstellung lesbarer Texte und fotorealistischer stilisierter Grafiken noch ganz am Anfang. Frühe Implementierungen hatten Probleme mit der Genauigkeit und Verzerrung, neigten zu Halluzinationen und spuckten seltsame Antworten aus. Dennoch deuten die bisherigen Fortschritte darauf hin, dass die inhärenten Fähigkeiten dieser Art von KI die Wirtschaft grundlegend verändern könnten. In Zukunft könnte diese Technologie dabei helfen, Code zu schreiben, neue Medikamente zu entwerfen, Produkte zu entwickeln, Geschäftsprozesse neu zu gestalten und Lieferketten zu verändern.

Die Funktionsweise generativer KI

Generative KI beginnt mit einer Eingabeaufforderung, die in Form eines Textes, eines Bildes, eines Videos, eines Designs, von Musiknoten oder jeder anderen Eingabe, die das KI-System verarbeiten kann, erfolgen kann. Verschiedene KI-Algorithmen liefern dann als Antwort auf die Aufforderung neue Inhalte. Zu den Inhalten können Aufsätze, Problemlösungen oder realistische Fälschungen gehören, die aus Bildern oder Audioaufnahmen einer Person erstellt werden.

Frühe Versionen der generativen KI erforderten die Übermittlung von Daten über eine API oder einen anderen komplizierten Prozess. Die Entwickler mussten sich mit speziellen Tools vertraut machen und Anwendungen in Sprachen wie Python schreiben.

Jetzt entwickeln Pioniere der generativen KI bessere Benutzererfahrungen, die es Ihnen ermöglichen, eine Anfrage in einfacher Sprache zu beschreiben. Nach einer ersten Antwort können Sie die Ergebnisse mit Feedback zu Stil, Ton und anderen Elementen, die der generierte Inhalt widerspiegeln soll, anpassen.

Modelle generativer KI

Modelle der generativen KI kombinieren verschiedene KI-Algorithmen zur Darstellung und Verarbeitung von Inhalten. Um beispielsweise Text zu generieren, werden verschiedene Verfahren zur Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) eingesetzt, die rohe Zeichen (zum Beispiel Buchstaben, Satzzeichen und Wörter) in Sätze, Teile von Sprache, Entitäten und Aktionen umwandeln, die mithilfe verschiedener Codierungstechniken als Vektoren dargestellt werden. In ähnlicher Weise werden Bilder in verschiedene visuelle Elemente umgewandelt, die ebenfalls als Vektoren dargestellt werden. Eine Warnung ist, dass diese Techniken auch die in den Trainingsdaten enthaltenen Vorurteile, Rassismus, Täuschungen und Prahlerei (Übertreibungen) codieren können.

Sobald sich die Entwickler auf eine Methode zur Darstellung der Welt geeinigt haben, wenden sie ein bestimmtes neuronales Netz an, um als Reaktion auf eine Abfrage oder Aufforderung neue Inhalte zu erzeugen. Techniken wie GANs und Variational Autoencoders (VAEs) – neuronale Netze mit einem Decoder und einem Encoder – eignen sich zur Erzeugung realistischer menschlicher Gesichter, synthetischer Daten für das KI-Training oder sogar von Faksimiles bestimmter Menschen.

Die Fortschritte bei Transformers wie Googles Bidirectional Encoder Representations from Transformers (BERT), OpenAIs GPT und Google AlphaFold haben auch zu neuronalen Netzen geführt, die nicht nur Sprache, Bilder und Proteine codieren, sondern auch neue Inhalte erzeugen können.

Wie neuronale Netze die generative KI verändern

Seit den Anfängen der KI haben Forscher KI und andere Tools zur programmatischen Generierung von Inhalten entwickelt. Die ersten Ansätze, die als regelbasierte Systeme und später als Expertensysteme bekannt wurden, verwendeten explizit ausgearbeitete Regeln zur Generierung von Antworten oder Datensätzen.

Neuronale Netze, die heute die Grundlage eines Großteils der KI- und ML-Anwendungen bilden, kehrten das Problem um. Neuronale Netze sollen die Funktionsweise des menschlichen Gehirns nachahmen und lernen die Regeln durch die Suche nach Mustern in vorhandenen Datensätzen. Die ersten neuronalen Netze, die in den 1950er und 1960er Jahren entwickelt wurden, waren durch einen Mangel an Rechenleistung und kleine Datensätze eingeschränkt. Erst mit dem Aufkommen von Big Data Mitte der 2000er Jahre und der Verbesserung der Computerhardware wurden neuronale Netze für die Erstellung von Inhalten praktisch.

Die Entwicklung beschleunigte sich, als Forscher einen Weg fanden, neuronale Netze parallel auf den Grafikprozessoren(GPUs) laufen zu lassen, die in der Computerspielindustrie zum Rendern von Videospielen verwendet werden. Neue Techniken des maschinellen Lernens, die in den letzten zehn Jahren entwickelt wurden, darunter die bereits erwähnten GANs und Transformers, haben die Voraussetzungen für die jüngsten bemerkenswerten Fortschritte bei KI-generierten Inhalten geschaffen.

Dall-E, ChatGPT und Gemini im Kurzüberblick

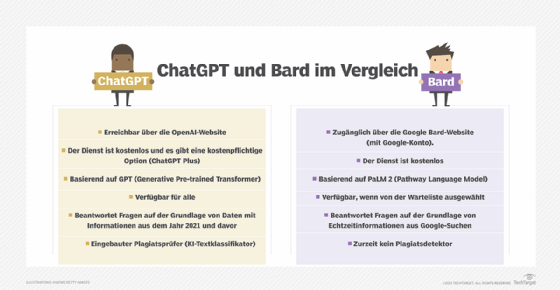

ChatGPT, Dall-E und Gemini sind beliebte generative KI-Schnittstellen.

Dall-E. Dall-E ist ein Beispiel für eine multimodale KI-Anwendung, die anhand eines großen Datensatzes von Bildern und den dazugehörigen Textbeschreibungen trainiert wurde und Verbindungen zwischen verschiedenen Medien wie Bild, Text und Audio erkennt. In diesem Fall verbindet sie die Bedeutung von Wörtern mit visuellen Elementen. Sie wurde unter Verwendung der GPT-Implementierung von OpenAI im Jahr 2021 entwickelt. Dall-E 2, eine zweite, leistungsfähigere Version, wurde 2022 veröffentlicht. Sie ermöglicht es den Benutzern, Bilder in verschiedenen Stilen zu erzeugen, die durch Benutzeraufforderungen gesteuert werden.

ChatGPT. Der KI-gestützte Chatbot, der im November 2022 erschien, basiert auf der GPT-3.5-Implementierung von OpenAI. OpenAI bietet eine Möglichkeit zur Interaktion und Feinabstimmung von Textantworten über eine Chat-Schnittstelle mit interaktivem Feedback. Frühere Versionen von GPT waren nur über eine API zugänglich. GPT-4 wurde am 14. März 2023 veröffentlicht. ChatGPT bezieht den Verlauf der Konversation mit einem Nutzer in seine Ergebnisse ein und simuliert so eine echte Konversation. Nach der unglaublichen Popularität der verbesserten GPT-Schnittstelle kündigte Microsoft eine neue Investition in OpenAI an und integrierte eine Version von GPT in seine Suchmaschine Bing.

Gemini. Google war ein weiterer Vorreiter bei der Entwicklung von KI-Techniken für die Verarbeitung von Sprache, Proteinen und anderen Arten von Inhalten. Einige dieser Modelle wurden als Open Source für Forscher zur Verfügung gestellt. Es hat jedoch nie eine öffentliche Schnittstelle für diese Modelle veröffentlicht. Microsofts Entscheidung, GPT in Bing zu implementieren, veranlasste Google, in aller Eile einen öffentlich zugänglichen Chatbot, Google Gemini, auf den Markt zu bringen, der auf einer abgespeckten Version seiner LaMDA-Familie großer Sprachmodelle basiert. Google musste nach dem überstürzten Debüt von Gemini einen erheblichen Kursverlust hinnehmen, nachdem das Sprachmodell fälschlicherweise behauptet hatte, das Webb-Teleskop sei das erste, das einen Planeten in einem fremden Sonnensystem entdeckt habe. Auch die Implementierungen von Microsoft und ChatGPT verloren bei ihren ersten Auftritten aufgrund ungenauer Ergebnisse und unberechenbaren Verhaltens ihr Gesicht. Google hat inzwischen eine neue Version von Gemini vorgestellt, die auf seinem weiterentwickelten LLM, PaLM 2, aufbaut und die es Gemini ermöglicht, effizienter und visueller auf Nutzeranfragen zu reagieren.

Einsatzmöglichkeiten für generative KI

Generative KI kann in verschiedenen Anwendungsfällen eingesetzt werden, um praktisch jede Art von Inhalt zu generieren. Dank bahnbrechender Entwicklungen wie GPT, die für verschiedene Anwendungen angepasst werden können, wird die Technologie für Nutzer aller Art immer zugänglicher. Einige der Anwendungsfälle für generative KI sind die folgenden:

- Implementierung von Chatbots für den Kundendienst und technischen Support.

- Einsatz von Deepfakes zur Nachahmung von Menschen oder sogar bestimmten Personen.

- Verbesserung der Synchronisation von Filmen und Bildungsinhalten in verschiedenen Sprachen.

- Schreiben von E-Mail-Antworten, Dating-Profilen, Lebensläufen und Hausarbeiten.

- Erstellen von fotorealistischer Kunst in einem bestimmten Stil.

- Verbesserung von Produktdemonstrationsvideos.

- Vorschläge für neue zu testende Arzneimittel.

- Entwerfen physischer Produkte und Gebäude.

- Optimieren neuer Chip-Designs.

- Schreiben von Musik in einem bestimmten Stil oder Ton.

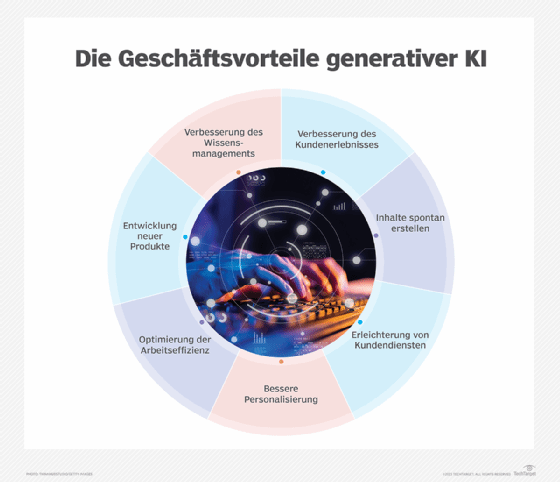

Vorteile generativer KI

Generative KI kann in vielen Bereichen der Wirtschaft umfassend eingesetzt werden. Sie kann die Interpretation und das Verständnis vorhandener Inhalte erleichtern und automatisch neue Inhalte erstellen. Entwickler erforschen, wie generative KI bestehende Arbeitsabläufe verbessern kann, mit dem Ziel, Arbeitsabläufe komplett anzupassen, um die Vorteile dieser Technologie zu nutzen. Zu den potenziellen Vorteilen der Implementierung generativer KI gehören unter anderem folgende:

- Automatisierung des manuellen Prozesses der Inhaltserstellung.

- Verringerung des Aufwands für die Beantwortung von E-Mails.

- Verbesserung der Beantwortung spezifischer technischer Anfragen.

- Erstellung realistischer Darstellungen von Menschen.

- Zusammenfassen komplexer Informationen zu einer kohärenten Erzählung.

- Vereinfachung des Prozesses der Erstellung von Inhalten in einem bestimmten Stil.

Einschränkungen der generativen KI

Frühe Implementierungen der generativen KI zeigen anschaulich ihre vielen Grenzen auf. Einige der Herausforderungen, die generative KI mit sich bringt, ergeben sich aus den spezifischen Ansätzen, die zur Umsetzung bestimmter Anwendungsfälle verwendet werden. So ist beispielsweise eine Zusammenfassung eines komplexen Themas leichter zu lesen als eine Erklärung, die verschiedene Quellen zur Untermauerung der wichtigsten Punkte enthält. Die Lesbarkeit der Zusammenfassung geht jedoch auf Kosten der Möglichkeit des Benutzers, zu überprüfen, woher die Informationen stammen.

Im Folgenden sind einige der Einschränkungen aufgeführt, die bei der Implementierung oder Verwendung einer generativen KI-App zu beachten sind:

- Es wird nicht immer die Quelle des Inhalts identifiziert.

- Es kann schwierig sein, die Voreingenommenheit von Originalquellen zu beurteilen.

- Realistisch klingende Inhalte erschweren die Erkennung ungenauer Informationen.

- Es kann schwierig sein zu verstehen, wie man sich auf neue Umstände einstellt.

- Die Ergebnisse können Voreingenommenheit, Vorurteile und Hass überdecken.

Attention ist alles, was Sie brauchen: Transformer bringen neue Fähigkeiten

Im Jahr 2017 berichtete Google über eine neue Art von neuronaler Netzwerkarchitektur, die Aufgaben wie die Verarbeitung natürlicher Sprache (Natural Language Processing) erheblich effizienter und genauer macht. Der bahnbrechende Ansatz, Transformers genannt, basierte auf dem Konzept der Aufmerksamkeit (attention).

Auf einer höheren Ebene bezieht sich Attention auf die mathematische Beschreibung, wie sich Dinge (zum Beispiel Wörter) zueinander verhalten, einander ergänzen und verändern. Die Forscher beschrieben die Architektur in ihrer Arbeit Attention is all you need (Aufmerksamkeit ist alles, was man braucht), in der sie zeigten, wie ein neuronales Transformer-Netz in der Lage war, zwischen Englisch und Französisch mit größerer Genauigkeit und in nur einem Viertel der Trainingszeit zu übersetzen als andere neuronale Netze. Die Technik konnte auch Beziehungen oder verborgene Ordnungen zwischen anderen, in den Daten verborgenen Dingen aufdecken, die dem Menschen möglicherweise nicht bewusst waren, weil sie zu kompliziert auszudrücken oder zu erkennen waren.

Die Transformer-Architektur hat sich seit ihrer Einführung rasch weiterentwickelt und zu LLMs wie GPT-3 und besseren Pre-Training-Techniken wie BERT von Google geführt.

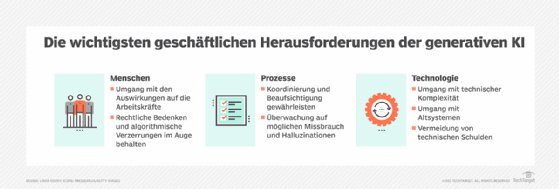

Bedenken beim Einsatz von generativer KI

Die Verbreitung der generativen KI weckt auch verschiedene Bedenken. Diese beziehen sich auf die Qualität der Ergebnisse, die Möglichkeit des Missbrauchs und das Potenzial, bestehende Geschäftsmodelle zu stören. Im Folgenden werden einige der spezifischen Arten von Problemen aufgeführt, die der aktuelle Stand der generativen KI mit sich bringt:

- Sie kann ungenaue und irreführende Informationen liefern.

- Es ist schwieriger, ihr zu vertrauen, ohne die Quelle und Herkunft der Informationen zu kennen.

- Sie kann neue Arten von Plagiaten fördern, die die Rechte der Urheber von Inhalten und der Künstler von Originalinhalten ignorieren.

- Sie kann bestehende Geschäftsmodelle, die auf Suchmaschinenoptimierung und Werbung basieren, stören.

- Sie macht es einfacher, Fake News zu erzeugen.

- Es macht es einfacher zu behaupten, dass echte fotografische Beweise für ein Fehlverhalten nur eine von der KI generierte Fälschung waren.

- Sie könnte sich für effektivere Social-Engineering-Cyberangriffe als Menschen ausgeben.

Angesichts der Neuheit von GenAI-Tools und ihrer raschen Verbreitung sollten sich Unternehmen auf das unvermeidliche "Tal der Ernüchterung" vorbereiten, das ein fester Bestandteil neuer Technologien ist, indem sie solide KI-Engineering-Praktiken anwenden und verantwortungsvolle KI zu einem Eckpfeiler ihrer GenAI-Bemühungen machen.

Beispiele für generative KI

Tools für generative KI gibt es für verschiedene Modalitäten, zum Beispiel für Text, Bilder, Musik, Code und Stimmen. Einige beliebte KI-Inhaltsgeneratoren, die Sie sich ansehen sollten, sind die folgenden:

- Texterzeugungs-Tools wie GPT, Jasper, AI-Writer und Lex.

- Zu den Tools zur Bilderzeugung gehören Dall-E 2, Midjourney und Stable Diffusion.

- Tools zur Erzeugung von Musik: Amper, Dadabots und MuseNet.

- Tools zur Codegenerierung: CodeStarter, Codex, GitHub Copilot und Tabnine.

- Zu den Tools für die Sprachsynthese gehören Descript, Listnr und Podcast.ai.

- Zu den Anbietern von KI-Chipdesign-Tools gehören Synopsys, Cadence, Google und Nvidia.

Industrierelevante Einsatzgebiete für generative KI

Neue Technologien für generative KI werden manchmal als Allzwecktechnologien (general-purpose) beschrieben, ähnlich wie Dampfkraft, Elektrizität und Computer, da sie viele Branchen und Anwendungsfälle tiefgreifend beeinflussen können. Es ist wichtig, sich vor Augen zu halten, dass es wie bei früheren Allzwecktechnologien oft Jahrzehnte gedauert hat, bis die Menschen den besten Weg gefunden hatten, ihre Arbeitsabläufe so zu organisieren, dass sie die Vorteile des neuen Ansatzes nutzen konnten, anstatt nur kleine Teile der bestehenden Arbeitsabläufe zu beschleunigen. Hier sind einige Möglichkeiten, wie sich Anwendungen generativer KI auf verschiedene Branchen auswirken könnten:

- Das Finanzwesen kann Transaktionen im Kontext der Historie einer Person betrachten, um bessere Systeme zur Betrugserkennung zu entwickeln.

- Anwaltskanzleien können generative KI nutzen, um Verträge zu entwerfen und zu interpretieren, Beweise zu analysieren und Argumente vorzuschlagen.

- Hersteller können generative KI nutzen, um Daten von Kameras, Röntgenbildern und anderen Messinstrumenten zu kombinieren, um fehlerhafte Teile und deren Ursachen genauer und kostengünstiger zu identifizieren.

- Film- und Medienunternehmen können generative KI nutzen, um Inhalte kostengünstiger zu produzieren und sie mit den Stimmen der Schauspieler in andere Sprachen zu übersetzen.

- Die Medizinindustrie kann generative KI nutzen, um vielversprechende Arzneimittelkandidaten effizienter zu identifizieren.

- Architekturbüros können generative KI nutzen, um Prototypen schneller zu entwerfen und anzupassen.

- Spielehersteller können generative KI nutzen, um Spielinhalte und Levels zu entwerfen.

Ethische Betrachtungen und Vorurteile in der generativen KI

Trotz ihrer vielversprechenden Eigenschaften eröffnen die neuen generativen KI-Tools ein Wespennest in Bezug auf Genauigkeit, Vertrauenswürdigkeit, Voreingenommenheit, Halluzinationen und Plagiate – ethische Fragen, deren Klärung wahrscheinlich Jahre dauern wird. Keines dieser Probleme ist für KI besonders neu. Microsofts erster Versuch mit Chatbots im Jahr 2016, genannt Tay, musste beispielsweise abgeschaltet werden, nachdem er auf Twitter hetzerische Äußerungen von sich gab.

Neu ist, dass die generativen KI-Anwendungen oberflächlich betrachtet kohärenter klingen. Doch diese Kombination aus menschenähnlicher Sprache und Kohärenz ist nicht gleichbedeutend mit menschlicher Intelligenz, und es wird derzeit heftig darüber diskutiert, ob generative KI-Modelle so trainiert werden können, dass sie logisch denken können. Ein Google-Ingenieur wurde sogar gefeuert, nachdem er öffentlich erklärt hatte, die generative KI-Anwendung des Unternehmens, Language Models for Dialog Applications (LaMDA), sei empfindungsfähig.

Der überzeugende Realismus generativer KI-Inhalte birgt eine Reihe neuer KI-Risiken. Es wird schwieriger, KI-generierte Inhalte zu erkennen, und – was noch wichtiger ist – es wird schwieriger zu erkennen, wenn etwas falsch ist. Dies kann ein großes Problem darstellen, wenn wir uns auf die Ergebnisse generativer KI verlassen, um Code zu schreiben oder medizinischen Rat zu erteilen. Viele Ergebnisse generativer KI sind nicht transparent, so dass es schwierig ist, festzustellen, ob sie beispielsweise gegen Urheberrechte verstoßen oder ob es Probleme mit den Originalquellen gibt, aus denen die Ergebnisse stammen. Wenn man nicht weiß, wie die KI zu einer Schlussfolgerung gekommen ist, kann man nicht erklären, warum sie falsch sein könnte.

KI und generative KI im Vergleich

Generative KI erzeugt neue Inhalte, Chatantworten, Designs, synthetische Daten oder Deepfakes. Traditionelle KI hingegen konzentriert sich auf das Erkennen von Mustern, das Treffen von Entscheidungen, das Verfeinern von Analysen, das Klassifizieren von Daten und das Aufdecken von Betrug.

Generative KI verwendet, wie bereits erwähnt, häufig neuronale Netztechniken wie Transformer, GANs und VAEs. Andere Arten der KI verwenden Techniken wie Convolutional Neural Networks (CNN), Recurrent Neural Networks und Reinforcement Learning.

Generative KI beginnt oft mit einer Eingabeaufforderung, bei der ein Benutzer oder eine Datenquelle eine Anfangsabfrage oder einen Datensatz einreicht, um die Inhaltsgenerierung zu steuern. Dabei kann es sich um einen iterativen Prozess handeln, bei dem Variationen von Inhalten untersucht werden. Traditionelle KI-Algorithmen verarbeiten neue Daten, um ein einfaches Ergebnis zu liefern.

Beide Ansätze haben je nach dem zu lösenden Problem ihre Stärken und Schwächen, wobei sich generative KI gut für Aufgaben eignet, die NLP beinhalten und die Erstellung neuer Inhalte erfordern, während traditionelle Algorithmen effektiver für Aufgaben sind, die regelbasierte Verarbeitung und vorbestimmte Ergebnisse beinhalten.

Generative KI vs. prädiktive KI vs. konversationelle KI

Im Gegensatz zur generativen KI nutzt die prädiktive KI Muster in historischen Daten, um Ergebnisse vorherzusagen, Ereignisse zu klassifizieren und umsetzbare Erkenntnisse zu gewinnen. Unternehmen nutzen prädiktive KI, um die Entscheidungsfindung zu verbessern und datengesteuerte Strategien zu entwickeln.

Konversationelle KI hilft KI-Systemen wie virtuellen Assistenten, Chatbots und Kundenservice-Apps dabei, auf natürliche Weise mit Menschen zu interagieren und zu interagieren. Sie nutzt Techniken aus NLP und maschinellem Lernen, um Sprache zu verstehen und menschenähnliche Text- oder Sprachantworten zu geben.

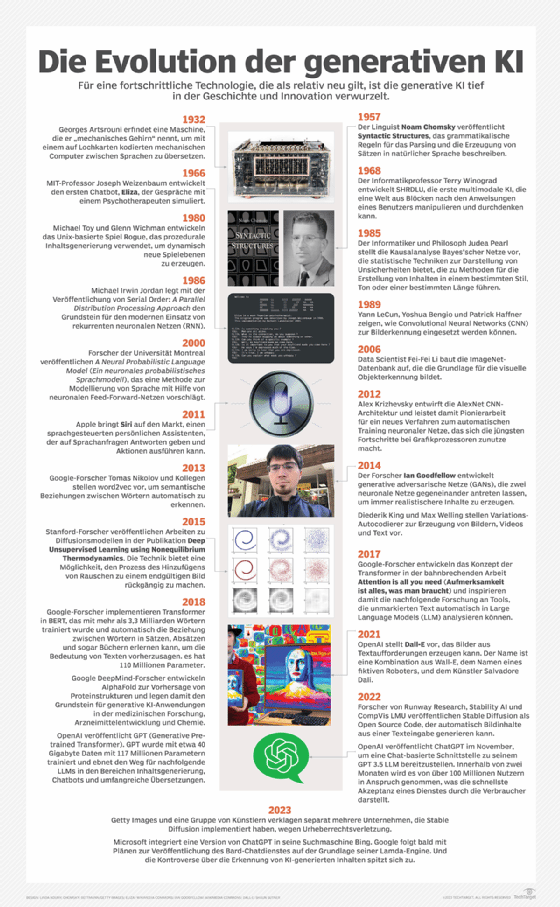

Eine kurze Historie der generativen KI

Der von Joseph Weizenbaum in den 1960er Jahren entwickelte Chatbot Eliza war eines der frühesten Beispiele für generative KI. Diese frühen Implementierungen verwendeten einen regelbasierten Ansatz, der unter anderem aufgrund eines begrenzten Vokabulars, fehlenden Kontexts und übermäßiger Abhängigkeit von Mustern leicht scheiterte. Frühe Chatbots ließen sich auch nur schwer anpassen und erweitern.

Einen Aufschwung erlebte das Feld im Zuge der Fortschritte bei neuronalen Netzen und Deep Learning im Jahr 2010, die es der Technologie ermöglichten, automatisch zu lernen, vorhandenen Text zu analysieren, Bildelemente zu klassifizieren und Audio zu transkribieren.

Ian Goodfellow stellte GANs im Jahr 2014 vor. Diese Deep-Learning-Technik bot einen neuartigen Ansatz für die Organisation konkurrierender neuronaler Netze zur Erzeugung und anschließenden Bewertung von Inhaltsvariationen. Diese können realistische Menschen, Stimmen, Musik und Text erzeugen. Dies weckte das Interesse – und die Befürchtung – wie generative KI verwendet werden könnte, um realistische Deepfakes zu erstellen, die Stimmen und Personen in Videos imitieren.

Seitdem haben Fortschritte bei anderen neuronalen Netzwerktechniken und -architekturen dazu beigetragen, die Möglichkeiten der generativen KI zu erweitern. Zu diesen Techniken gehören VAEs, Long Short-Term Memory, Transformer, Diffusionsmodelle und neuronale Strahlungsfelder (Radience Field).

Best Practises für generative KI

Die besten Praktiken für den Einsatz generativer KI variieren je nach Modalitäten, Arbeitsablauf und gewünschten Zielen. Dennoch ist es wichtig, bei der Arbeit mit generativer KI wesentliche Faktoren wie Genauigkeit, Transparenz und Benutzerfreundlichkeit zu berücksichtigen. Die folgenden Praktiken helfen, diese Faktoren zu erreichen:

- Klare Kennzeichnung aller generativen KI-Inhalte für Nutzer und Verbraucher.

- Überprüfen Sie die Genauigkeit der generierten Inhalte anhand von Primärquellen, wo dies möglich ist.

- Überlegen Sie, wie Voreingenommenheit/Vorurteile in die generierten KI-Ergebnisse eingewoben werden kann.

- Überprüfen Sie die Qualität von KI-generiertem Code und Inhalten mit anderen Tools.

- Lernen Sie die Stärken und Grenzen jedes generativen KI-Tools kennen.

- Machen Sie sich mit häufigen Fehlermöglichkeiten in den Ergebnissen vertraut und umgehen Sie diese.

Die Aussichten für generative KI

Die unglaubliche Tiefe und Einfachheit von ChatGPT hat gezeigt, wie vielversprechend die generative KI für eine breite Anwendung ist. Allerdings hat es auch einige Schwierigkeiten bei der sicheren und verantwortungsbewussten Einführung dieser Technologie aufgezeigt. Aber diese frühen Implementierungsprobleme haben die Forschung zu besseren Werkzeugen für die Erkennung von KI-generierten Texten, Bildern und Videos angeregt. Die Industrie und die Gesellschaft werden auch bessere Tools für die Rückverfolgung der Herkunft von Informationen entwickeln, um eine vertrauenswürdigere KI zu schaffen.

Darüber hinaus werden Verbesserungen bei den KI-Entwicklungsplattformen dazu beitragen, die Forschung und Entwicklung besserer generativer KI-Funktionen für Texte, Bilder, Videos, 3D-Inhalte, Arzneimittel, Lieferketten, Logistik und Geschäftsprozesse zu beschleunigen. So gut diese neuen einmaligen Tools auch sein mögen, die größte Auswirkung der generativen KI wird die direkte Einbettung dieser Fähigkeiten in die Versionen der von uns bereits verwendeten Tools haben.

Grammatikprüfprogramme werden besser werden. Design-Tools werden nahtlos mehr nützliche Empfehlungen direkt in Arbeitsabläufe einbetten. Schulungs-Tools werden in der Lage sein, automatisch bewährte Verfahren in einem Teil des Unternehmens zu ermitteln, um andere effizienter zu schulen. Und das ist nur ein Bruchteil der Möglichkeiten, wie generative KI unsere Arbeitsweise verändern wird.

Wie sich die generative KI in Zukunft auswirken wird, ist schwer zu sagen. Aber wenn wir diese Werkzeuge weiterhin nutzen, um menschliche Aufgaben zu automatisieren und zu ergänzen, werden wir unweigerlich die Art und den Wert menschlichen Fachwissens neu bewerten müssen.

FAQ: Die häufigsten Fragen erklärt

Nachfolgend finden Sie einige häufig gestellte Fragen zu generativer KI.

Wer hat generative KI entwickelt?

Joseph Weizenbaum schuf die erste generative KI in den 1960er Jahren als Teil des Chatbots Eliza. Ian Goodfellow demonstrierte 2014 generative Adversarial Networks zur Erzeugung realistisch aussehender und klingender Menschen.

Die anschließende Forschung an LLMs von Open AI und Google löste den großen Enthusiasmus aus, der sich in Tools wie ChatGPT, Google Bard und Dall-E niedergeschlagen hat.

Wie könnte generative KI Arbeitsplätze ersetzen?

Generative KI hat das Potenzial, eine Vielzahl von Berufen zu ersetzen, darunter die folgenden:

- Schreiben von Produktbeschreibungen.

- Erstellen von Marketingtexten.

- Generierung einfacher Webinhalte.

- Initiierung interaktiver Vertriebskontakte.

- Beantwortung von Kundenfragen.

- Erstellen von Grafiken für Webseiten.

Einige Unternehmen werden nach Möglichkeiten suchen, Menschen zu ersetzen, wo immer dies möglich ist, während andere generative KI nutzen werden, um die Fähigkeiten des bestehenden Personals zu erweitern und zu verbessern.

Wie baut man ein Modell für generative KI auf?

Ein generatives KI-Modell beginnt mit der effizienten Codierung einer Darstellung dessen, was Sie generieren möchten. Ein generatives KI-Modell für Text könnte zum Beispiel damit beginnen, einen Weg zu finden, die Wörter als Vektoren darzustellen, die die Ähnlichkeit zwischen Wörtern charakterisieren, die häufig im selben Satz verwendet werden oder ähnliche Bedeutungen haben.

Fortschritte in der LLM-Forschung haben der Industrie geholfen, das gleiche Verfahren zur Darstellung von Mustern in Bildern, Tönen, Proteinen, DNA, Medikamenten und 3D-Designs einzusetzen. Dieses generative KI-Modell bietet eine effiziente Möglichkeit, die gewünschte Art von Inhalt darzustellen und nützliche Variationen effizient zu iterieren.

Wie trainiert man ein Modell für generatives KI?

Das Modell für generative KI muss für einen bestimmten Anwendungsfall trainiert werden. Die Fortschritte bei LLMs bieten einen idealen Ausgangspunkt für die Anpassung von Anwendungen an verschiedene Anwendungsfälle. Das populäre GPT-Modell, das von OpenAI entwickelt wurde, wurde beispielsweise zum Schreiben von Text, zur Codegenerierung und zur Erstellung von Bildern auf der Grundlage schriftlicher Beschreibungen verwendet.

Beim Training werden die Parameter des Modells für verschiedene Anwendungsfälle eingestellt und die Ergebnisse dann anhand eines bestimmten Satzes von Trainingsdaten fein abgestimmt. Ein Callcenter könnte beispielsweise einen Chatbot anhand der Fragen, die Service-Agenten von verschiedenen Kundentypen erhalten, und der Antworten, die Service-Agenten darauf geben, trainieren. Eine App, die Bilder generiert, könnte im Gegensatz zu Text mit Etiketten beginnen, die Inhalt und Stil von Bildern beschreiben, um das Modell für die Generierung neuer Bilder zu trainieren.

Wie verändert generative KI die kreative Arbeit?

Generative KI verspricht, Kreativschaffende bei der Erforschung von Ideenvariationen zu unterstützen. Künstler könnten mit einem grundlegenden Designkonzept beginnen und dann Variationen erforschen. Industriedesigner könnten Produktvariationen erforschen. Architekten könnten verschiedene Gebäudelayouts erforschen und sie als Ausgangspunkt für weitere Verfeinerungen visualisieren.

Es könnte auch dazu beitragen, einige Aspekte der kreativen Arbeit zu demokratisieren. Geschäftskunden könnten zum Beispiel Produktmarketingbilder anhand von Textbeschreibungen untersuchen. Sie könnten diese Ergebnisse mit einfachen Befehlen oder Vorschlägen weiter verfeinern.

Wohin kann sich generative KI entwickeln?

Die Fähigkeit von ChatGPT, menschenähnlichen Text zu erzeugen, hat die Neugier auf das Potenzial generativer KI geweckt. Sie hat auch ein Licht auf die vielen Probleme und Herausforderungen der Zukunft geworfen.

Kurzfristig wird sich die Arbeit darauf konzentrieren, die Benutzererfahrung und die Arbeitsabläufe mit generativen KI-Tools zu verbessern. Es wird auch wichtig sein, Vertrauen in die Ergebnisse generativer KI aufzubauen.

Viele Unternehmen werden generative KI auch an ihre eigenen Daten anpassen, um ihr Branding und ihre Kommunikation zu verbessern. Programmierteams werden generative KI nutzen, um unternehmensspezifische Best Practices für das Schreiben und Formatieren von besser lesbarem und konsistentem Code durchzusetzen.

Anbieter werden generative KI-Funktionen in ihre zusätzlichen Tools integrieren, um die Arbeitsabläufe bei der Erstellung von Inhalten zu optimieren. Dies wird die Innovation vorantreiben, wie diese neuen Funktionen die Produktivität steigern können.

Generative KI könnte auch bei verschiedenen Aspekten der Datenverarbeitung, -umwandlung, -kennzeichnung und -überprüfung im Rahmen von Augmented-Analytics-Workflows eine Rolle spielen. Semantische Webanwendungen könnten generative KI nutzen, um interne Taxonomien, die berufliche Qualifikationen beschreiben, automatisch verschiedenen Taxonomien auf Websites für Qualifikationsschulungen und Personalbeschaffung zuzuordnen. In ähnlicher Weise werden Unternehmensteams diese Modelle nutzen, um Daten von Drittanbietern umzuwandeln und zu kennzeichnen, um anspruchsvollere Risikobewertungen und Chancenanalysen durchführen zu können.

Künftig werden generative KI-Modelle zur Unterstützung von 3D-Modellierung, Produktdesign, Arzneimittelentwicklung, digitalen Zwillingen, Lieferketten und Geschäftsprozessen erweitert. Dies wird es einfacher machen, neue Produktideen zu entwickeln, mit verschiedenen Organisationsmodellen zu experimentieren und verschiedene Geschäftsideen zu erkunden.

Neueste generative AI-Technologie definiert

AgentGPT

AgentGPT ist ein generatives KI-Tool, mit dem Benutzer autonome KI-Agenten erstellen können, denen eine Reihe von Aufgaben übertragen werden kann.

KI-Kunst (Kunst der künstlichen Intelligenz)

KI-Kunst ist jede Form von digitaler Kunst, die mit KI-Tools erstellt oder verbessert wurde.

KI-Prompt

Ein Prompt der künstlichen Intelligenz (KI) ist eine Interaktionsform zwischen einem Menschen und einem LLM, die es dem Modell ermöglicht, die gewünschte Ausgabe zu erzeugen. Diese Interaktion kann in Form einer Frage, eines Textes, von Codeschnipseln oder Beispielen erfolgen.

KI-Prompt-Ingenieur

Ein KI-Prompt-Ingenieur ist ein Experte für die Erstellung von textbasierten Prompts oder Hinweisen, die von großen Sprachmodellen und generativen KI-Tools interpretiert und verstanden werden können.

KI-Red-Teaming

Beim KI-Red-Teaming werden Angriffsszenarien auf eine Anwendung der künstlichen Intelligenz simuliert, um Schwachstellen zu ermitteln und Präventivmaßnahmen zu planen. Dieser Prozess hilft, das KI-Modell gegen eine Reihe möglicher Infiltrationstaktiken und Funktionsprobleme abzusichern.

Amazon Bedrock

Amazon Bedrock – auch bekannt als AWS Bedrock – ist eine Plattform für maschinelles Lernen, mit der generative Anwendungen für künstliche Intelligenz auf der Cloud-Computing-Plattform Amazon Web Services erstellt werden können.

Apple Intelligence

Apple Intelligence ist der Plattformname für eine Reihe von generativen KI-Funktionen, die Apple in seine Produkte, einschließlich iPhone-, Mac- und iPad-Geräte, integriert.

Auto-GPT

Auto-GPT ist ein experimenteller, quelloffener (Open Source), autonomer KI-Agent auf der Grundlage des GPT-4-Sprachmodells, der selbstständig Aufgaben miteinander verknüpft, um ein vom Benutzer festgelegtes übergeordnetes Ziel zu erreichen.

Autonome künstliche Intelligenz

Autonome künstliche Intelligenz ist ein Zweig der KI, in dem Systeme und Werkzeuge so fortgeschritten sind, dass sie mit begrenzter menschlicher Aufsicht und Beteiligung handeln können.

Gedankenketten-Prompting (Chain-of-Thought Prompting)

Diese Prompt-Engineering-Technik zielt darauf ab, die Leistung von Sprachmodellen bei Aufgaben zu verbessern, die Logik, Berechnung und Entscheidungsfindung erfordern, indem die Eingabeaufforderung so strukturiert wird, dass sie das menschliche Denken nachahmt.

Datenvergiftung (Data Poisoning)

Daten- oder KI-Vergiftungsangriffe sind absichtliche Versuche, die Trainingsdaten von Modellen der künstlichen Intelligenz und des maschinellen Lernens (ML) zu manipulieren, um ihr Verhalten zu verfälschen und verzerrte, voreingenommene oder schädliche Ergebnisse zu erzielen.

Einbettung von Modellen für die semantische Suche

Mit Einbettungsmodellen für die semantische Suche werden Daten in effizientere Formate für die symbolische und statistische Computerverarbeitung umgewandelt.

Gemma

Gemma ist eine Sammlung von leichtgewichtigen, quelloffenen GenAI-Modellen, die hauptsächlich für Entwickler und Forscher bestimmt sind und vom Google DeepMind-Forschungslabor erstellt wurden.

Google Gemini

Google Gemini ist eine Familie von großen multimodalen Sprachmodellen der künstlichen Intelligenz (KI), die über Fähigkeiten zum Verstehen von Sprache, Audio, Code und Video verfügen.

Generative Sucherfahrung von Google

Google Search Generative Experience (SGE) ist eine Reihe von Such- und Schnittstellenfunktionen, die generative, KI-gestützte Ergebnisse in die Antworten der Google-Suchmaschine integrieren.

Google Search Labs (GSE)

GSE ist eine Initiative der Google-Abteilung von Alphabet, um neue Funktionen und Experimente für die Google-Suche in einem Vorschauformat bereitzustellen, bevor sie öffentlich verfügbar werden.

Neuronale Graphen-Netzwerke (GNNs)

Neuronale Graphen-Netzwerke (Graph Neural Networks) sind eine Art von neuronaler Netzwerkarchitektur und eine Deep-Learning-Methode, die Nutzern bei der Analyse von Graphen helfen kann, indem sie ihnen ermöglicht, Vorhersagen auf der Grundlage der Daten zu treffen, die durch die Knoten und Kanten (Edges) eines Graphen beschrieben werden.

Bild-zu-Bild-Übersetzung

Die Bild-zu-Bild-Übersetzung ist eine generative Technik der künstlichen Intelligenz (KI), die ein Quellbild in ein Zielbild übersetzt, wobei bestimmte visuelle Eigenschaften des Originalbildes erhalten bleiben.

Inception Score

Der Inception Score (IS) ist ein mathematischer Algorithmus zur Messung oder Bestimmung der Qualität von Bildern, die durch generative KI mittels eines generativen adversen Netzwerks (GAN) erzeugt wurden. Das Wort Inception bezieht sich auf den Funken der Kreativität oder den ersten Beginn eines Gedankens oder einer Handlung, wie er traditionell von Menschen erlebt wird.

Wissensgraph im ML

Im Bereich des maschinellen Lernens ist ein Wissensgraph eine grafische Darstellung, die die Verbindungen zwischen verschiedenen Entitäten erfasst. Er besteht aus Knoten, die Entitäten oder Konzepte darstellen, und Kanten, die die Beziehungen zwischen diesen Entitäten darstellen.

LangChain

LangChain ist ein Open-Source-Framework, das es Softwareentwicklern, die mit künstlicher Intelligenz (KI) und ihrer Untergruppe des maschinellen Lernens arbeiten, ermöglicht, große Sprachmodelle mit anderen externen Komponenten zu kombinieren, um LLM-gestützte Anwendungen zu entwickeln.

Maskierte Sprachmodelle (MLMs)

MLMs werden bei der Verarbeitung natürlicher Sprache für das Training von Sprachmodellen verwendet. Bestimmte Wörter und Token in einer bestimmten Eingabe werden bei diesem Ansatz zufällig maskiert oder versteckt, und das Modell wird dann darauf trainiert, diese maskierten Elemente unter Verwendung des durch die umgebenden Wörter bereitgestellten Kontexts vorherzusagen.

Neuro-symbolische KI

Neurosymbolische KI kombiniert neuronale Netze mit regelbasierten symbolischen Verarbeitungstechniken, um die Genauigkeit, Erklärbarkeit und Präzision von Systemen der künstlichen Intelligenz zu verbessern.

Prompt Engineering

Prompt-Engineering ist eine KI-Technik, die mehreren Zwecken dient. Sie umfasst den Prozess der Verfeinerung von LLMs mit spezifischen Aufforderungen und empfohlenen Ausgaben sowie den Prozess der Verfeinerung von Eingaben für verschiedene generative KI-Dienste zur Erzeugung von Text oder Bildern.

Q Learning

Q Learning ist ein maschineller Lernansatz, der es einem Modell ermöglicht, iterativ zu lernen und sich im Laufe der Zeit zu verbessern, indem es die richtigen Maßnahmen ergreift.

Reinforcement Learning from Human Feedback (RLHF)

RLHF (Verstärkungslernen durch menschliches Feedback) ist ein Ansatz des maschinellen Lernens, der Techniken des Verstärkungslernens, wie Belohnungen und Vergleiche, mit menschlicher Anleitung kombiniert, um einen KI-Agenten zu trainieren.

Retrieval-Augmented Generation

Retrieval-Augmented Generation (RAG) ist ein Framework für künstliche Intelligenz, das Daten aus externen Wissensquellen abruft, um die Qualität der Antworten zu verbessern.

Retrieval-Augmented Language Model Pre-Training

Ein Retrieval-Augmented Language Model, auch REALM oder RALM genannt, ist ein KI-Sprachmodell, das entwickelt wurde, um Text abzurufen und diesen dann zur Durchführung von fragebasierten Aufgaben zu verwenden.

Semantisches Netzwerk (Wissensgraph)

Ein semantisches Netz ist eine Wissensstruktur, die darstellt, wie Konzepte miteinander in Beziehung stehen und wie sie miteinander verknüpft sind. Semantische Netze nutzen die KI-Programmierung, um Daten zu durchsuchen, Konzepte zu verbinden und auf Beziehungen aufmerksam zu machen.

Semantische Suche

Die semantische Suche ist eine Technik der Datensuche, bei der die Verarbeitung natürlicher Sprache (NLP) und Algorithmen des maschinellen Lernens eingesetzt werden, um die Genauigkeit der Suchergebnisse zu verbessern, indem die Absicht des Suchenden und die kontextuelle Bedeutung der in seiner Anfrage verwendeten Begriffe berücksichtigt werden.

Variationaler Autoencoder (VAE)

Ein Variational Autoencoder ist ein generativer KI-Algorithmus, der Deep Learning einsetzt, um neue Inhalte zu generieren, Anomalien zu erkennen und Rauschen zu entfernen.

Vektor-Einbettungen

Vektoreinbettungen sind numerische Darstellungen, die die Beziehungen und die Bedeutung von Wörtern, Phrasen und anderen Datentypen erfassen.

Bildgebende Sprachmodelle (VLMs)

VLMs (Vision Language Models) kombinieren maschinelles Sehen und semantische Verarbeitungstechniken, um die Beziehungen innerhalb und zwischen Objekten in Bildern zu erfassen.

Was sind einige generative Modelle für die Verarbeitung natürlicher Sprache?

Zu den generativen Modellen für die Verarbeitung natürlicher Sprache (Natural Language Processing) gehören die folgenden:

- XLNet der Carnegie Mellon University

- GPT (Generative Pre-trained Transformer) von OpenAI

- ALBERT von Google ("A Lite" BERT)

- Google BERT

- Google LaMDA

Wird KI jemals ein Bewusstsein erlangen?

Einige KI-Befürworter sind der Meinung, dass generative KI ein wesentlicher Schritt auf dem Weg zur allgemeinen KI und sogar zum Bewusstsein ist. Ein früher Tester des Chatbots LaMDA von Google sorgte sogar für Aufsehen, als er öffentlich erklärte, der Chatbot sei empfindungsfähig. Dann wurde er von dem Unternehmen entlassen.

1993 postulierte der amerikanische Science-Fiction-Autor und Informatiker Vernor Vinge, dass wir in 30 Jahren technologisch in der Lage sein werden, eine übermenschliche Intelligenz zu schaffen – eine KI, die intelligenter ist als der Mensch –, nach der die menschliche Ära enden würde. Der KI-Pionier Ray Kurzweil sagte eine solche Singularität für das Jahr 2045 voraus.

Viele andere KI-Experten glauben, dass es noch viel weiter weg sein könnte. Der Roboterpionier Rodney Brooks sagte voraus, dass die KI zu seinen Lebzeiten nicht die Empfindungsfähigkeit eines Sechsjährigen erreichen wird, aber bis 2048 so intelligent und aufmerksam wie ein Hund sein könnte.

Verantwortungsvolle generative KI

Das wachsende Interesse an generativer KI hat Unternehmen dazu veranlasst, die KI-Ethik ernster zu nehmen. Technologieunternehmen wie Salesforce haben ethische Richtlinien und Governance-Maßnahmen für Urheberrechte, Fehlinformationen und potenzielle Verzerrungen/Vorurteile in KI-Modellen entwickelt. Der Mensch im Mittelpunkt, Genauigkeit, Sicherheit, Transparenz, Sicherheit und Verantwortlichkeit sind die häufigsten ethischen Prinzipien, die den moralischen Einsatz von KI leiten, während Unternehmen die Verzerrung von Daten in der Technologie sowie in den Mitarbeitern und Unternehmensprozessen berücksichtigen müssen.