Google Gemini (ehemals Bard)

Was ist das Google Gemini (ehemals Bard)?

Google Gemini – früher bekannt als Bard – ist ein von Google entwickeltes Chatbot-Tool mit künstlicher Intelligenz (KI), das mithilfe von natürlicher Sprachverarbeitung (Natural Language Processing, NLP) und maschinellem Lernen menschliche Gespräche simuliert. Gemini ergänzt nicht nur die Google-Suche, sondern kann auch in Websites, Messaging-Plattformen oder Anwendungen integriert werden, um realistische, natürliche Antworten auf Nutzerfragen zu geben.

Google Gemini ist eine Familie von Large Language Models (LLMs), die über Fähigkeiten im Bereich Sprache, Audio, Code und Video verfügen.

Gemini 1.0 wurde am 6. Dezember 2023 angekündigt und von der Alphabet-Geschäftseinheit DeepMind entwickelt, die sich auf fortschrittliche KI-Forschung und -Entwicklung konzentriert. Google-Mitbegründer Sergey Brin hat zusammen mit anderen Google-Mitarbeitern die Entwicklung der Gemini-LLMs mitgeprägt.

Bei seiner Veröffentlichung war Gemini das fortschrittlichste LLM bei Google, das Bard vor dessen Umbenennung antrieb und das Pathways Language Model (Palm 2) des Unternehmens ablöste. Wie Palm 2 wurde Gemini in mehrere Google-Technologien integriert, um generative KI-Funktionen bereitzustellen.

Am 11. Dezember 2024 veröffentlichte Google mit Gemini 2.0 Flash eine aktualisierte Version seines LLM, eine experimentelle Version, die in Google AI Studio und die Programmierschnittstelle (API) Vertex AI Gemini integriert ist.

Gemini integriert NLP-Funktionen, die das Verstehen und Verarbeiten von Sprache ermöglichen. Gemini wird auch zum Verstehen von Eingabeabfragen und Daten verwendet. Es ist in der Lage, Bilder zu verstehen und zu erkennen, sodass es komplexe visuelle Elemente wie Diagramme und Abbildungen ohne externe optische Zeichenerkennung (Optical Character Recognition, OCR) analysieren kann. Darüber hinaus verfügt es über umfassende mehrsprachige Fähigkeiten für Übersetzungsaufgaben und Funktionen in verschiedenen Sprachen.

Im Gegensatz zu früheren KI-Modellen von Google ist Gemini von Grund auf multimodal, das heißt, es wurde durchgängig mit Datensätzen trainiert, die mehrere Datentypen umfassen. Als multimodales Modell ermöglicht Gemini crossmodale Schlussfolgerungen. Das bedeutet, dass Gemini eine Reihe unterschiedlicher Eingabedatentypen, darunter Audio, Bilder und Text, miteinander verknüpfen kann. So kann Gemini beispielsweise handschriftliche Notizen, Grafiken und Diagramme verstehen, um komplexe Probleme zu lösen. Die Gemini-Architektur unterstützt die direkte Eingabe von Text, Bildern, Audio-Wellenformen und Videobildern als verschachtelte Sequenzen.

Wie funktioniert Google Gemini?

Google Gemini wird zunächst anhand eines riesigen Datenkorpus trainiert. Nach dem Training verwendet das Modell mehrere neuronale Netzwerktechniken, um Inhalte zu verstehen, Fragen zu beantworten, Texte zu generieren und Ergebnisse zu produzieren.

Insbesondere verwenden die Gemini-LLMs eine auf einem Transformer-Modell basierende neuronale Netzwerkarchitektur. Die Gemini-Architektur wurde verbessert, um lange Kontextsequenzen über verschiedene Datentypen hinweg zu verarbeiten, darunter Text, Audio und Video. Google DeepMind verwendet effiziente Aufmerksamkeitsmechanismen im Transformer-Decoder, um den Modellen zu helfen, lange Kontexte zu verarbeiten, die sich über verschiedene Modalitäten erstrecken.

Gemini-Modelle wurden mit Google DeepMind auf vielfältigen multimodalen und mehrsprachigen Datensätzen aus Text, Bildern, Audio und Video trainiert, wobei fortschrittliche Datenfilterung zur Optimierung des Trainings eingesetzt wurde. Da verschiedene Gemini-Modelle zur Unterstützung spezifischer Google-Dienste eingesetzt werden, gibt es einen Prozess der gezielten Feinabstimmung, mit dem ein Modell für einen Anwendungsfall weiter optimiert werden kann. Sowohl in der Trainings- als auch in der Inferenzphase profitiert Gemini von der Verwendung der neuesten Tensor Processing Unit-Chips von Google, Trillium, der sechsten Generation von Google Cloud TPU. Trillium-TPUs bieten im Vergleich zu TPU v5 eine verbesserte Leistung, geringere Latenzzeiten und niedrigere Kosten. Außerdem sind sie energieeffizienter als die Vorgängerversion.

Eine zentrale Herausforderung für LLMs ist das Risiko von Voreingenommenheit und potenziell toxischen Inhalten. Laut Google wurde Gemini umfangreichen Sicherheitstests und Maßnahmen zur Risikominderung unterzogen, um ein gewisses Maß an LLM-Sicherheit zu gewährleisten.

Um sicherzustellen, dass Gemini wie vorgesehen funktioniert, wurden die Modelle anhand akademischer Benchmarks aus den Bereichen Sprache, Bild, Audio, Video und Code getestet. Google hat der Öffentlichkeit versichert, dass es sich an eine Liste von KI-Grundsätzen hält.

Bei der Vorstellung am 6. Dezember 2023 gab Google bekannt, dass Gemini eine Reihe verschiedener Modellgrößen umfassen wird, die jeweils für bestimmte Anwendungsfälle und Einsatzumgebungen konzipiert sind. Das Ultra-Modell ist das Spitzenmodell und für hochkomplexe Aufgaben ausgelegt. Das Pro-Modell ist auf Leistung und den Einsatz in großem Maßstab ausgelegt. Seit dem 13. Dezember 2023 ermöglicht Google den Zugriff auf Gemini Pro in Google Cloud Vertex AI und Google AI Studio. Für Code wird eine Version von Gemini verwendet, um die generative KI-Codierungstechnologie Google AlphaCode 2 zu unterstützen.

Das Nano-Modell ist für Anwendungsfälle auf Geräten vorgesehen. Es gibt zwei verschiedene Versionen von Gemini Nano: Das Modell Nano-1 verfügt über 1,8 Milliarden Parameter, während Nano-2 3,25 Milliarden Parameter hat. Nano wird unter anderem in das Smartphone Google Pixel 9 integriert.

Wann wurde Google Bard erstmals veröffentlicht?

Google kündigte Bard, seinen KI-gestützten Chatbot, erstmals am 6. Februar 2023 mit einem vagen Veröffentlichungsdatum an. Am 21. März 2023 wurde der Zugang zu Bard freigeschaltet und Nutzer konnten sich auf eine Warteliste setzen lassen. Am 10. Mai 2023 entfernte Google die Warteliste und machte Bard in mehr als 180 Ländern und Gebieten verfügbar. Fast genau ein Jahr nach der ersten Ankündigung wurde Bard in Gemini umbenannt.

Viele glaubten, dass Google den Druck durch den Erfolg und die positive Presse von ChatGPT gespürt hatte und das Unternehmen Bard deshalb vorzeitig auf den Markt gebracht hatte. So gab Bard beispielsweise während einer Live-Demo von Google und Alphabet-CEO Sundar Pichai eine falsche Antwort auf eine Frage.

In der Demo stellte ein Nutzer Bard die Frage: „Welche neuen Entdeckungen des James-Webb-Weltraumteleskops kann ich meinem 9-jährigen Kind erzählen?“ In der Antwort von Bard hieß es, dass das Teleskop „die ersten Bilder eines Planeten außerhalb unseres Sonnensystems aufgenommen hat“. Astronomen wiesen in den sozialen Medien schnell darauf hin, dass das erste Bild eines Exoplaneten bereits 2004 von einem Observatorium auf der Erde aufgenommen wurde, sodass die Antwort von Bard falsch war. Am nächsten Tag verlor Google 100 Milliarden Dollar an Marktwert – ein Rückgang, der auf diesen peinlichen Fehler zurückgeführt wurde.

Warum hat Google Bard in Gemini umbenannt und wann geschah dies?

Bard wurde am 8. Februar 2024 in Gemini umbenannt. Gemini war bereits die LLM, die Bard antrieb. Einige glauben, dass die Umbenennung der Plattform in Gemini möglicherweise erfolgte, um die Aufmerksamkeit vom Namen Bard und der Kritik abzulenken, der der Chatbot bei seiner Einführung ausgesetzt war. Außerdem vereinfachte dies die KI-Bemühungen von Google und konzentrierte sich auf den Erfolg der Gemini-LLM.

Die Namensänderung war auch aus Marketing-Sicht sinnvoll, da Google seine KI-Dienste ausbauen möchte. Auf diese Weise kann Google das Bewusstsein für sein fortschrittliches LLM-Angebot schärfen, da die Demokratisierung der KI und die Fortschritte in diesem Bereich keine Anzeichen einer Verlangsamung zeigen.

Wer kann Google Gemini nutzen?

Gemini ist weltweit verfügbar. Gemini Pro ist in mehr als 230 Ländern und Gebieten verfügbar. Gemini Advanced, ein Dienst, der Zugriff auf die fortschrittlichsten KI-Modelle von Google bietet, ist in mehr als 150 Ländern und Gebieten verfügbar.

Google Gemini ist kostenlos für Nutzer verfügbar, die mindestens 18 Jahre alt sind und über ein persönliches Google-Konto, ein Google Workspace-Konto mit Gemini-Zugang, ein Google AI Studio-Konto oder ein Schulkonto verfügen. Die Gemini-API bietet ebenfalls eine kostenlose Version.

Die fortschrittlichste Version von Gemini ist über die Option Gemini Advanced verfügbar, die Nutzern mit einem Google Workspace-Konto zur Verfügung steht. Google bietet eine kostenlose einmonatige Testversion der Option Advanced an. Nach Ablauf der Testphase fallen Kosten an. Eine Übersicht der Preise findet man auf der Google-Seite.

In welchen Sprachen ist Gemini verfügbar?

Gemini kann in 46 Sprachen verwendet werden. Es kann textbasierte Eingaben mit nahezu menschlicher Genauigkeit in verschiedene Sprachen übersetzen. Google plant, die Sprachverständnisfähigkeiten von Gemini zu erweitern und es allgegenwärtig zu machen. Es gibt jedoch wichtige Faktoren zu berücksichtigen, wie zum Beispiel Verbote von LLM-generierten Inhalten oder laufende Regulierungsbemühungen in verschiedenen Ländern, die die zukünftige Nutzung von Gemini einschränken oder verhindern können.

Gemini bietet neben der Übersetzung weitere Funktionen in verschiedenen Sprachen. So ist es beispielsweise in der Lage, mathematische Schlussfolgerungen zu ziehen und Zusammenfassungen in mehreren Sprachen zu erstellen. Außerdem kann es Bildunterschriften in verschiedenen Sprachen generieren.

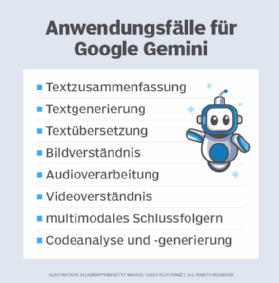

Wofür können Sie Gemini verwenden? Anwendungsfälle und Anwendungen

Die Google Gemini-Modelle werden auf vielfältige Weise eingesetzt, darunter zum Verstehen von Text, Bildern, Audio und Video. Dank der multimodalen Natur von Gemini können diese verschiedenen Arten von Eingaben auch kombiniert werden, um Ausgaben zu generieren.

Anwendungsfälle

Unternehmen können Gemini für verschiedene Aufgaben einsetzen, darunter

- Textzusammenfassung. Gemini-Modelle können Inhalte aus verschiedenen Datentypen zusammenfassen.

- Textgenerierung. Gemini kann auf Basis von Benutzeranweisungen Text generieren. Dieser Text kann auch über eine Chatbot-Oberfläche im Frage-Antwort-Format gesteuert werden.

- Textübersetzung. Die Gemini-Modelle verfügen über umfassende Mehrsprachigkeitsfunktionen und ermöglichen die Übersetzung und das Verständnis von mehr als 100 Sprachen.

- Bildverständnis. Gemini kann komplexe visuelle Elemente wie Diagramme, Abbildungen und Schemata ohne externe OCR-Tools analysieren. Es kann für Bildbeschriftungen und visuelle Frage-Antwort-Funktionen verwendet werden.

- Audioverarbeitung. Gemini unterstützt die Spracherkennung in mehr als 100 Sprachen und Audioübersetzungsaufgaben.

- Videoverständnis. Gemini kann Videoclips verarbeiten und verstehen, um Fragen zu beantworten und Beschreibungen zu generieren.

- Multimodales Denken. Eine wesentliche Stärke von Gemini ist die Verwendung multimodaler KI-Denkprozesse, bei denen verschiedene Datentypen für eine Eingabe gemischt werden können, um eine Ausgabe zu generieren.

- Code-Analyse und -Generierung. Gemini kann Code in gängigen Programmiersprachen wie Python, Java, C++ und Go verstehen, erklären und generieren.

Anwendungen

Google hat Gemini als Basismodell entwickelt, das in verschiedene Google-Dienste integriert werden kann. Es steht auch Entwicklern zur Verfügung, die damit ihre eigenen Anwendungen erstellen können. Zu den Anwendungen, die Gemini verwenden, gehören:

- AlphaCode 2. Das Code-Generierungs-Tool AlphaCode 2 von Google DeepMind nutzt eine angepasste Version von Gemini Pro.

- Google Pixel. Das von Google entwickelte Smartphone Pixel 8 Pro war das erste Gerät, auf dem Gemini Nano ausgeführt wurde. Gemini unterstützt neue Funktionen in bestehenden Google-Apps, wie zum Beispiel die Zusammenfassung in Recorder und Smart Reply in Gboard für Messaging-Apps.

- Android. Das Pixel 8 Pro war das erste Android-Smartphone, das von Gemini profitierte. Android-Entwickler können mit Gemini Nano über die AICore-Systemfunktion des Android-Betriebssystems entwickeln.

- Vertex AI. Der Vertex AI-Dienst von Google Cloud, der Basismodelle für die Entwicklung von Anwendungen bereitstellt, bietet auch Zugriff auf Gemini Pro.

- Google AI Studio. Entwickler können mit dem webbasierten Tool Google AI Studio Prototypen und Apps mit Gemini erstellen.

- Suche. Google hat Gemini in seine Suche integriert, um die Latenz zu reduzieren und die Qualität zu verbessern.

Was sind die Einschränkungen von Gemini?

Einige Einschränkungen könnten potenzielle Endnutzer zögern lassen. Dazu gehören die folgenden:

- Trainingsdaten. Wie alle KI-Chatbots muss Gemini lernen, richtige Antworten zu geben. Dazu müssen die Modelle mit korrekten Informationen trainiert werden, die nicht ungenau oder irreführend sind. Sie müssen jedoch auch in der Lage sein, falsche oder irreführende Informationen zu erkennen, wenn sie ihnen begegnen.

- Voreingenommenheit und potenzieller Schaden. Das Training von KI ist ein endloser, rechenintensiver Prozess, da ständig neue Informationen gelernt werden müssen. Google hat erklärt, dass es bei allen Gemini-Modellen verantwortungsbewusste Entwicklungspraktiken befolgt hat, darunter umfangreiche Evaluierungen, um das Risiko von Voreingenommenheit und potenziellem Schaden zu begrenzen.

- Originalität und Kreativität. Die Originalität und Kreativität der von Gemini produzierten Inhalte sind begrenzt. Dies gilt insbesondere für die kostenlose Version, die Schwierigkeiten hatte, komplizierte Eingaben mit mehreren Schritten und Nuancen zu verarbeiten und angemessene Ergebnisse zu liefern. Die kostenlose Version basiert auf Gemini Pro LLM, das in seinen Funktionen eingeschränkter ist; die kostenpflichtigen Versionen der Plattform bieten Zugriff auf erweiterte Funktionen.

Was sind die Bedenken hinsichtlich Gemini?

Eine Sorge im Zusammenhang mit Gemini betrifft das Potenzial, dass den Nutzern voreingenommene oder falsche Informationen präsentiert werden. Jede Voreingenommenheit, die den Trainingsdaten von Gemini innewohnt, kann zu Problemen führen. Wie bei jeder fortschrittlichen KI-Software führen beispielsweise Trainingsdaten, die bestimmte Gruppen innerhalb einer bestimmten Population ausschließen, zu verzerrten Ergebnissen.

Die Neigung von Gemini, Halluzinationen und andere Erfindungen zu generieren und diese als wahr an die Nutzer weiterzugeben, gibt ebenfalls Anlass zur Sorge. Dies ist seit seiner Einführung eines der größten Risiken bei den Antworten von ChatGPT, wie auch bei anderen KI-Tools. Da Gemini den Kontext nicht immer versteht, sind seine Antworten möglicherweise nicht relevant für die Prompts und Fragen der Nutzer.

Ist die Bildgenerierung in Gemini verfügbar?

Bei der Veröffentlichung von Gemini lobte Google seine Fähigkeit, Bilder auf die gleiche Weise zu generieren wie andere generative KI-Tools, beispielsweise Dall-E, Midjourney und Stable Diffusion. Gemini verwendet derzeit das Text-zu-Bild-Modell Imagen 3 von Google, das dem Tool Bildgenerierungsfunktionen verleiht.

Die Ergebnisse von Gemini reichen von einfach bis komplex, je nach den Eingaben des Endnutzers. Benutzer geben beschreibende Prompts ein, um bestimmte Bilder zu erhalten. Benutzer folgen einem einfachen schrittweisen Prozess, um einen Prompt einzugeben, das von Gemini generierte Bild anzuzeigen, es zu bearbeiten und für die spätere Verwendung zu speichern.

Von Ende Februar 2024 bis Ende August 2024 wurde die Bildgenerierungsfunktion von Gemini eingestellt, um sie zu überarbeiten, nachdem generierte Bilder faktische Ungenauigkeiten aufwiesen. Google verbesserte die Bildgenerierungsfunktion und aktualisierte sie auf Imagen 3.

Gemini versus GPT-3 und GPT-4

Google Gemini ist ein direkter Konkurrent zu den Modellen GPT-3 und GPT-4 von OpenAI. In der folgenden Tabelle werden einige wichtige Funktionen von Google Gemini und OpenAI-Produkten verglichen.

Tabelle

Gemini GPT-3 und GPT-4

Entwickler Google DeepMind

OpenAI

Chatbot-Schnittstelle Gemini; früher Bard

ChatGPT

Modalität Multimodal; trainiert mit Text, Bildern, Audio und Video

Ursprünglich als reines Text-Sprachmodell entwickelt; GPT-4 ist multimodal

Modellvarianten Größenbasierte Varianten, darunter Ultra, Pro und Nano

Optimierungen hinsichtlich der Größe, darunter GPT-3.5 Turbo und GPT-4o

Kontextfensterlänge Gemini 1.5 Pro verfügt über ein Kontextfenster mit 2 Millionen Token

GPT-4o verfügt über ein Kontextfenster mit 128.000 Token

Google Gemini versus ChatGPT

Sowohl Gemini als auch ChatGPT sind KI-Chatbots, auch bekannt als KI-Assistenten, die für die Interaktion mit Menschen durch NLP und maschinelles Lernen entwickelt wurden. Beide verwenden ein zugrunde liegendes LLM zur Generierung und Erstellung von Konversationstexten.

ChatGPT verwendet generative KI, um originelle Inhalte zu produzieren. Benutzer können beispielsweise darum bitten, eine Abhandlung über die Vorteile von KI zu verfassen. Gemini verwendet ebenfalls generative KI. Beide sind darauf ausgerichtet, die Suche natürlicher und hilfreicher zu gestalten und neue Informationen in ihren Antworten zusammenzufassen.

Im Januar 2023 unterzeichnete Microsoft einen Vertrag mit OpenAI im Wert von geschätzt zehn Milliarden US-Dollar, um ChatGPT zu lizenzieren und in seine Bing-Suchmaschine zu integrieren, um mehr dialogorientierte Suchergebnisse zu liefern, ähnlich wie Google Bard zu diesem Zeitpunkt. Damit wurde anderen Suchmaschinen die Tür für die Lizenzierung von ChatGPT geöffnet, während Gemini nur Google unterstützt.

Eine weitere Ähnlichkeit zwischen den beiden Chatbots ist ihr Potenzial, plagiierte Inhalte zu generieren, und ihre Fähigkeit, dieses Problem zu kontrollieren. Weder Gemini noch ChatGPT verfügen über integrierte Plagiatserkennungsfunktionen, mit denen Nutzer überprüfen können, ob die Ergebnisse original sind. Es gibt jedoch separate Tools zur Erkennung von Plagiaten in KI-generierten Inhalten, sodass Nutzer andere Optionen haben. Gemini ist in der Lage, andere Inhalte in seinen Antworten zu zitieren und auf Quellen zu verlinken. Die Doppelprüfungsfunktion von Gemini liefert URLs zu den Informationsquellen, aus denen es Inhalte auf der Grundlage einer Eingabe generiert.

Alternativen zu Google Gemini

Gemini ist nicht aus dem Nichts entstanden. KI-Chatbots gibt es schon seit einiger Zeit, allerdings in weniger vielseitigen Formen. Mehrere Start-up-Unternehmen verfügen über ähnliche Chatbot-Technologien, stehen jedoch nicht so im Rampenlicht wie ChatGPT.

Beispiele für Chatbot-Konkurrenten von Gemini, die originelle Texte oder Codes generieren, sind laut Audrey Chee-Read, Principal Analyst bei Forrester Research, sowie anderen Branchenexperten unter anderem die folgenden:

- Chatsonic. Chatsonic von Writesonic wird als „ChatGPT-Alternative mit Superkräften” vermarktet und ist ein KI-Chatbot, der auf der Google-Suche basiert und über einen KI-basierten Textgenerator verfügt, mit dem Nutzer in Echtzeit über Themen diskutieren und Texte oder Bilder erstellen können.

- Claude. Claude von Anthropic ist ein KI-gesteuerter Chatbot, der nach dem zugrunde liegenden LLM benannt ist, der ihn antreibt. Er wurde strengen Tests unterzogen, um sicherzustellen, dass er ethische KI-Standards einhält und keine beleidigenden oder sachlich unrichtigen Ergebnisse liefert.

- Copy.ai. Copy.ai wurde ursprünglich entwickelt, um Vertriebs- und Marketingteams zu unterstützen. Es generiert Originaltexte, wie Social-Media-Beiträge, Blogs, E-Mails und andere Arten von Inhalten, und automatisiert außerdem Workflow-Aufgaben.

- GitHub Copilot. GitHub Copilot ist auf die Codegenerierung für Entwickler spezialisiert. Ziel ist es, die ansonsten mühsamen Softwareentwicklungsaufgaben bei der Erstellung moderner Software zu vereinfachen. Obwohl es nicht für die Textgenerierung gedacht ist, dient es als praktikable Alternative zu ChatGPT oder Gemini für die Codegenerierung.

- Jasper Chat. Jasper Chat von Jasper ist ein dialogorientiertes KI-Tool, das sich auf die Textgenerierung konzentriert. Es richtet sich an Unternehmen, die markenrelevante Inhalte erstellen und mit Kunden kommunizieren möchten. Es ermöglicht Content-Erstellern, Suchmaschinenoptimierungs-Keywords und den Tonfall in ihren Eingabeaufforderungen festzulegen.

- Microsoft Bing. Microsoft und OpenAI bieten ebenfalls das, was Google mit Gemini tut: eine KI-gestützte Suche, die natürliche Sprachabfragen erkennt und Antworten in natürlicher Sprache gibt. Wenn ein Nutzer eine Suchanfrage stellt, erhält er die üblichen Bing-Suchergebnisse und eine von GPT-4 generierte Antwort sowie die Möglichkeit, mit der KI über ihre Antwort zu interagieren.

- SpinBot. Dieses generative KI-Tool ist auf die Erstellung von Originaltexten sowie das Umschreiben von Inhalten und die Vermeidung von Plagiaten spezialisiert. Es übernimmt auch andere einfache Aufgaben, um Fachleute beim Verfassen von Texten zu unterstützen, beispielsweise das Korrekturlesen.

- YouChat. Dieser KI-Chatbot stammt von der Suchmaschine You.com. YouChat beantwortet Fragen und liefert Quellenangaben für seine Antworten, sodass Nutzer die Quellen überprüfen und die Antworten auf ihre Richtigkeit hin überprüfen können.

Die Geschichte von Gemini

Gemini wurde unter seinem ursprünglichen Namen Bard im März 2023 für die Suche entwickelt. Das Ziel war es, Suchanfragen in einer natürlicheren Sprache zu ermöglichen, anstatt Schlüsselwörter zu verwenden. Die KI wurde mit natürlich klingenden Gesprächsfragen und Antworten trainiert. Anstatt eine Liste mit Antworten zu liefern, gab Bard Antworten mit Kontext. Die KI von Bard wurde entwickelt, um bei Folgefragen zu helfen – etwas Neues für die Suche. Sie verfügte außerdem über eine Funktion zum Teilen von Unterhaltungen und eine Doppelprüfungsfunktion, mit der Nutzer die generierten Ergebnisse auf ihre Richtigkeit überprüfen konnten.

Bard wurde in mehrere Google-Apps und -Dienste integriert, darunter YouTube, Maps, Hotels, Flights, Gmail, Docs und Drive. Durch diese Integrationen konnten Nutzer das KI-Tool auf ihre persönlichen Inhalte anwenden.

Die erste Version von Bard verwendete eine abgespeckte Version der Lamda-Konversationstechnologie von Google, die weniger Rechenleistung benötigte, um mehr gleichzeitige Nutzer zu skalieren. Durch die anschließende Verwendung des Palm 2-Sprachmodells wurden die Antworten von Bard auf Nutzeranfragen visueller. Bard integrierte auch Google Lens, sodass Nutzer zusätzlich zu schriftlichen Eingaben auch Bilder hochladen konnten. Später wurde das Gemini-Sprachmodell hinzugefügt, das fortgeschrittenere Schlussfolgerungen, Planungen und Verständnis ermöglichte.

Im Rahmen der ersten Einführung von Gemini am 6. Dezember 2023 kündigte Google Gemini Ultra, Pro und Nano an, stellte Ultra jedoch nicht gleichzeitig mit Pro und Nano zur Verfügung. Ultra war zunächst nur für ausgewählte Kunden, Entwickler, Partner und Experten verfügbar und wurde im Februar 2024 vollständig veröffentlicht.

Google integriert Gemini nun in das gesamte Google-Portfolio, einschließlich des Chrome-Browsers und der Google Ads-Plattform, und bietet Werbetreibenden damit neue Möglichkeiten, mit Nutzern in Kontakt zu treten und zu interagieren.

Aktuelle Updates für Google Gemini

Im Mai 2024 kündigte Google auf der Google I/O-Konferenz Verbesserungen für Gemini 1.5 Pro an. Zu den Upgrades gehörten Leistungsverbesserungen bei den Übersetzungs-, Codierungs- und Schlussfolgerungsfunktionen. Das aktualisierte Google 1.5 Pro verbesserte auch das Verständnis von Bildern und Videos, einschließlich der Fähigkeit, Spracheingaben mithilfe der nativen Audioerkennung direkt zu verarbeiten. Das Kontextfenster des Modells wurde auf 2 Millionen Tokens erweitert, sodass es bei der Beantwortung von Prompts viel mehr Informationen speichern kann.

Ebenfalls im Mai 2024 wurde Gemini 1.5 Flash veröffentlicht, ein kleineres Modell mit einer durchschnittlichen Latenzzeit von weniger als einer Sekunde für das erste Token und einem Kontextfenster von 1 Million Tokens. Zusätzlich zu den Upgrades des Kernmodells kündigte Google im Mai neue Funktionen für die Gemini-API an, darunter die folgenden:

- Video-Frame-Extraktion, mit der Benutzer ein Video hochladen können, um Inhalte zu generieren.

- Parallele Funktionsaufrufe, mit denen Benutzer mehr als einen Funktionsaufruf gleichzeitig ausführen können.

Im Juni 2024 fügte Google die Kontext-Zwischenspeicherung hinzu, um sicherzustellen, dass Benutzer nur Teile eines Prompts einmal an ein Modell senden müssen.

Google stellte Gemini 2.0 Flash am 11. Dezember 2024 in einer experimentellen Vorschau über die Vertex AI Gemini API und AI Studio vor. Gemini 2.0 Flash ist doppelt so schnell wie 1.5 Pro und verfügt über neue Funktionen wie multimodale Ein- und Ausgabe und langes Kontextverständnis. Zu den weiteren neuen Funktionen gehören Text-to-Speech-Funktionen für die Bildbearbeitung und Kunst. Die neue API verfügt über Audio-Streaming-Anwendungen, die die Verwendung nativer Tools unterstützen und die Latenz verbessern. Google plant, dieses neue Modell im Januar 2025 für ein breiteres Publikum verfügbar zu machen.