Edge-KI

Was ist Edge-KI?

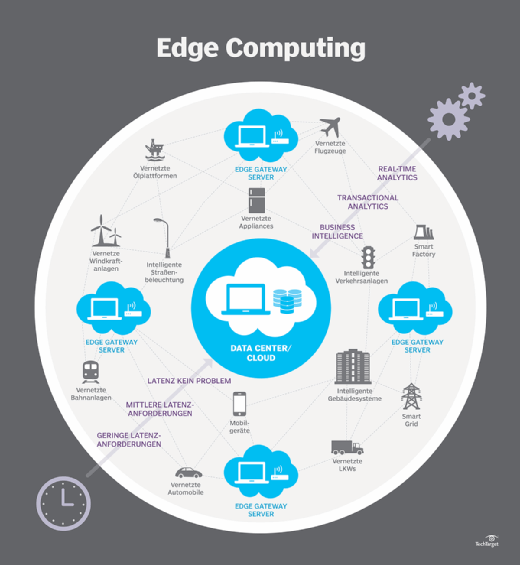

Edge-KI (künstliche Intelligenz) ist ein Paradigma für die Erstellung von KI-Workflows. Es ist Teil zentralisierter Cloud-Rechenzentren und Edge-Geräte außerhalb der Cloud, die näher am Menschen und physischen Dingen sind.

Dies steht im Gegensatz zu der gängigeren Praxis, KI-Anwendungen vollständig in der Cloud zu entwickeln und auszuführen, was als Cloud-KI bezeichnet wird. Es unterscheidet sich auch von älteren KI-Entwicklungsansätzen, bei denen Menschen KI-Algorithmen auf Desktops erstellen und sie auf Desktops oder spezieller Hardware für Aufgaben wie das Lesen von Schecknummern einsetzen.

Das Konzept des Edge wird oft als physisches Objekt charakterisiert, wie zum Beispiel ein Netzwerk-Gateway, ein Smart Router oder ein intelligenter 5G-Mobilfunkmast. Dabei wird jedoch der Wert der Edge-KI für Geräte wie Mobiltelefone, autonome Autos und Roboter übersehen. Um die Bedeutung von Edge-Umgebungen besser zu verstehen, sollte man sie als Mittel betrachten, um die in der Cloud innovierten Praktiken der digitalen Transformation auf die Welt auszuweiten.

Andere Arten von Edge-Innovationen verbesserten die Effizienz, Leistung, Verwaltung, Sicherheit und den Betrieb von Computern, Smartphones, Fahrzeugen, Geräten und anderen Geräten, die Cloud-Best-Practices nutzen. Edge-KI konzentriert sich auf Best Practices, Architekturen und Prozesse zur Erweiterung von Datenwissenschaft, maschinellem Lernen und KI außerhalb der Cloud.

So funktioniert Edge-KI

Bis vor kurzem wurden die meisten KI-Anwendungen, wie Expertensysteme oder Algorithmen zur Betrugserkennung, unter Verwendung symbolischer KI-Techniken entwickelt, bei denen Regeln fest in sie einprogrammiert wurden. In einigen Fällen wurden nicht-symbolische KI-Techniken – zum Beispiel neuronale Netze – für Anwendungen wie die optische Zeichenerkennung für Schecknummern oder getippten Text entwickelt.

Im Laufe der Zeit entdeckten Forscher Möglichkeiten, tiefe neuronale Netze in der Cloud zu skalieren, um KI-Modelle zu trainieren und auf der Grundlage von Eingabedaten Antworten zu generieren. Edge-KI erweitert die KI-Entwicklung und -Bereitstellung außerhalb der Cloud.

Edge-KI wird in der Regel für die Inferenz verwendet, während Cloud-KI neue Algorithmen trainiert. Inferenzalgorithmen benötigen weniger Rechenleistung und Energie als Trainingsalgorithmen. Daher werden gut konzipierte Inferenzalgorithmen manchmal auf vorhandenen Prozessoren oder sogar auf weniger leistungsfähigen Mikrocontrollern in Edge-Geräten ausgeführt. In anderen Fällen verbessern hocheffiziente KI-Chips die Inferenzleistung, reduzieren den Stromverbrauch oder beides.

Vorteile von Edge-KI

Edge-KI hat gegenüber Cloud-KI mehrere Vorteile, darunter die folgenden:

- Geringere Latenz und höhere Geschwindigkeiten. Die Inferenz wird lokal durchgeführt, wodurch Kommunikationsverzögerungen mit der Cloud und das Warten auf die Antwort entfallen.

- Geringerer Bandbreitenbedarf und geringere Kosten. Edge-KI reduziert die Bandbreite und die damit verbundenen Kosten für die Übertragung von Sprach-, Video- und hochauflösenden Sensordaten über Mobilfunknetze.

- Erhöhte Datensicherheit. Die Daten werden lokal verarbeitet, wodurch das Risiko verringert wird, dass sensible Daten in der Cloud gespeichert oder während der Übertragung abgefangen werden.

- Verbesserte Zuverlässigkeit. Die KI kann auch dann weiterarbeiten, wenn das Netzwerk oder der Cloud-Dienst ausfällt. Dies ist für Anwendungen wie autonome Technologien, insbesondere autonome Autos und Industrieroboter, von entscheidender Bedeutung.

- Geringerer Stromverbrauch. Viele KI-Aufgaben können mit weniger Energie auf dem Gerät ausgeführt werden, als für die Übertragung der Daten in die Cloud erforderlich ist, wodurch die Akkulaufzeit verlängert wird.

Anwendungsfälle und Beispiele für Edge-KI

Zu den gängigen Anwendungsfällen für Edge-KI gehören Spracherkennung, Fingerabdruckerkennung, Gesichtserkennung, Betrugserkennung und autonome Fahrsysteme. Edge-KI kombiniert die Leistungsfähigkeit der Cloud mit den Vorteilen des lokalen Betriebs, um die Leistung von KI-Algorithmen im Laufe der Zeit zu verbessern.

Beispielsweise trainiert ein autonomes Navigationssystem KI-Algorithmen in der Cloud, aber die Inferenz werden im Auto ausgeführt, um Lenkung, Beschleunigung und Bremsen zu steuern. Datenwissenschaftler entwickeln in der Cloud bessere Algorithmen für autonomes Fahren und übertragen diese Modelle auf das Fahrzeug.

In einigen Autos simulieren diese Systeme auch dann weiterhin die Steuerung des Autos, wenn eine Person fährt. Das System merkt sich, wenn der Mensch etwas tut, was die KI nicht erwartet hat, nimmt ein entsprechendes Video auf und lädt es in die Cloud hoch, um den Algorithmus zu verbessern. Die Eingaben aller Fahrzeuge der Flotte tragen zur Verbesserung des Hauptsteuerungsalgorithmus bei, und diese Verbesserungen werden beim nächsten Update übertragen.

Im Folgenden sind einige weitere Bereiche aufgeführt, in denen Edge-KI zum Einsatz kommt:

- Spracherkennungsalgorithmen transkribieren Sprache auf Mobilgeräten.

- Google AI generiert realistische Hintergrundbilder, um Personen oder Objekte zu ersetzen, die aus einem Bild entfernt wurden.

- Tragbare Gesundheitsmonitore messen Herzfrequenz, Blutdruck, Blutzuckerspiegel und Atmung lokal mithilfe von KI-Modellen, die in der Cloud entwickelt wurden.

- Ein Roboterarm lernt nach und nach, wie er bestimmte Verpackungstypen besser greifen kann, und teilt diese Erkenntnisse mit der Cloud, um andere Roboter zu verbessern.

- Amazon Go ist ein in der Cloud trainierter kassenloser Service, der mithilfe von Edge-KI automatisch die in die Einkaufstasche eines Kunden gelegten Artikel zählt, ohne dass ein separater Kassiervorgang erforderlich ist.

- Intelligente Verkehrskameras passen die Ampelphasen automatisch an, um den Verkehr zu optimieren.

Edge-KI versus Cloud-KI

Der Unterschied zwischen Edge-KI und Cloud-KI beginnt mit der Entwicklung dieser Konzepte. Lange vor der Cloud oder Edge gab es Mainframes, Desktop-Computer, Smartphones und eingebettete Systeme. Die Anwendungen für all diese Geräte wurden langsam unter Verwendung von Wasserfallentwicklungsmethoden entwickelt. Die Entwickler versuchten, so viele Funktionen und Tests wie möglich in die jährlichen Updates zu packen.

Die Cloud hat die Aufmerksamkeit auf Möglichkeiten zur Automatisierung von Rechenzentrumsprozessen gelenkt. Dadurch können Entwicklungsteams agilere Entwicklungsmethoden anwenden. Einige große Cloud-Anwendungen werden mittlerweile dutzende Male am Tag aktualisiert, was die Entwicklung von Anwendungsfunktionen in kleineren Einheiten erleichtert. Edge-KI bietet eine Möglichkeit, diese modularen Entwicklungs- und Bereitstellungsmethoden über die Cloud hinaus auf Edge-Geräte wie Mobiltelefone, intelligente Geräte, autonome Fahrzeuge, Fabrikausrüstung und Remote-Edge-Rechenzentren auszuweiten.

Dies kann in unterschiedlichem Maße geschehen. Ein Edge-Gerät wie ein Smart Speaker kann beispielsweise mindestens alle Sprachdaten an die Cloud senden. Ausgefeiltere Edge-KI-Geräte wie 5G-Zugangsserver könnten KI-Funktionen für Geräte in der Nähe bereitstellen. Die LF Edge-Gruppe der Linux Foundation umfasst Glühbirnen, Mobilgeräte, lokale Server, 5G-Zugangsgeräte und kleinere regionale Rechenzentren als Edge-Geräte.

Edge-KI und Cloud-KI arbeiten zusammen, wobei sowohl die Edge als auch die Cloud zu Training und Inferenz beitragen. An einem Ende sendet das Edge-Gerät Rohdaten zur Inferenz an die Cloud und wartet auf eine Antwort. In der Mitte führt die Edge-KI möglicherweise lokal auf dem Gerät eine Inferenz durch, wobei sie in der Cloud trainierte Modelle verwendet. Am anderen Ende spielt die Edge-KI eine größere Rolle beim Training von KI-Modellen.

Unterschied zwischen Edge-KI und verteilter KI

Edge-KI führt KI-Prozesse direkt auf lokalen Geräten am Rand des Netzwerks aus, zum Beispiel auf IoT-Sensoren (Internet of Things, Internets der Dinge). Dies reduziert die Abhängigkeit von der Cloud-Konnektivität, was zu schnelleren Support-Antworten und einer geringeren Bandbreitennutzung führt. Edge-KI eignet sich am besten für Umgebungen, in denen Latenz und Autonomie entscheidend sind.

Verteilte KI (Distributed AI) verteilt ihre Arbeit auf mehrere Knoten, in der Regel innerhalb von Cloud-Infrastrukturen. Verteilte KI eignet sich am besten für zentralisierte Systeme mit starker Konnektivität; in Umgebungen mit geringer Bandbreite oder hoher Latenz schneidet sie schlecht ab.

Der wichtigste Unterschied zwischen Edge-KI und verteilter KI besteht darin, wo die Daten verarbeitet werden. Edge-KI verarbeitet sie lokal und ermöglicht so Entscheidungen in Echtzeit ohne externe Abhängigkeiten. Verteilte KI verarbeitet Daten über miteinander verbundene Systeme hinweg und nutzt diese Systeme, um die Skalierbarkeit zu priorisieren. Edge-KI eignet sich am besten für Remote- und Echtzeitanwendungen, wie selbstfahrende Fahrzeuge und industrielle Automatisierung. Verteilte KI ist am besten für Szenarien geeignet, die kollaborative Verarbeitung, Skalierbarkeit und zentralisierte Steuerung erfordern.

Die Zukunft der Edge-Technologie

Edge-KI ist ein aufstrebender Bereich, der schnell wächst. Geräte wie Smartphones, Wearables und Smart Devices machen den Großteil der Anwendungsfälle für Edge-KI aus. Aber auch Edge-KI in Unternehmen wird wahrscheinlich mit der Verbreitung von kassenlosen Checkouts, intelligenten Krankenhäusern, Smart Cities, Industrie 4.0 und der Automatisierung von Lieferketten wachsen.

KI-Technologien wie föderiertes Lernen (Deep Learning) verbessern die Privatsphäre und Sicherheit von Edge-KI. Bei der traditionellen KI wird ein relevanter Teil der Rohdaten in die Cloud übertragen, um das Training zu verbessern. Beim föderierten Lernen führt das Edge-Gerät die KI-Trainingsaktualisierungen lokal durch. Anstelle der Daten werden Modellaktualisierungen in die Cloud übertragen, wodurch Datenschutzbedenken verringert werden.

Eine weitere bedeutende Veränderung kann eine verbesserte Edge-KI-Orchestrierung sein. Die meisten Edge-KI-Algorithmen führen lokale Inferenzberechnungen für die vom Gerät erfassten Daten durch. In Zukunft können komplexere Tools wahrscheinlich lokale Inferenzberechnungen unter Verwendung von Daten aus Sensoren durchführen, die sich in der Nähe des Geräts befinden.

Die Entwicklung und der Betrieb von KI-Modellen befinden sich in einem früheren Stadium als die DevOps-Praktiken zur Erstellung von Anwendungen. Im Gegensatz zu traditionellen Anwendungsentwicklungspraktiken stehen Datenwissenschaftler und Dateningenieure vor zahlreichen Herausforderungen im Bereich des Datenmanagements. Diese sind kompliziert, wenn es um die Verwaltung von Edge-KI-Workflows geht, die die Orchestrierung von Daten, Modellierungs- und Bereitstellungsprozessen umfassen, die sich über Edge-Geräte und die Cloud erstrecken.

Im Laufe der Zeit werden sich die Tools für diese Prozesse wahrscheinlich verbessern. Dadurch wird es einfacher, Edge-KI-Anwendungen zu skalieren und neue KI-Architekturen zu erforschen. Beispielsweise suchen Experten bereits nach Möglichkeiten, Edge-KI in 5G-Edge-Rechenzentren näher an Mobil- und IoT-Geräten einzusetzen. Mit neuen Tools können Unternehmen neue Arten von föderierten Data Warehouses mit Daten erkunden, die näher am Edge gespeichert sind.