sabida - stock.adobe.com

Die Geschichte der künstlichen Intelligenz: eine Zeitleiste

Von der Einführung des Turing-Tests bis zur Veröffentlichung von ChatGPT hat KI den Lebensstil der Menschen und die Betriebsabläufe von Unternehmen für immer verändert.

Künstliche Intelligenz (KI), oder zumindest das moderne Konzept davon, gibt es schon seit mehreren Jahrzehnten, aber erst in jüngster Zeit hat KI das kollektive Gedächtnis des Geschäftsalltags und der Gesellschaft erobert.

KI bezeichnet die Fähigkeit von Computern und Systemen, Aufgaben auszuführen, die normalerweise menschliche kognitive Fähigkeiten erfordern. Unsere Beziehung zu KI ist symbiotisch. Ihre Fühler reichen in jeden Aspekt unseres Lebens und unserer Existenz, von der Früherkennung und besseren Behandlung von Krebspatienten bis hin zu neuen Einnahmequellen und reibungsloseren Abläufen für Unternehmen jeder Art und Größe.

KI kann als der große Gleichmacher von Big Data angesehen werden, wenn es um die Erfassung, Analyse, Demokratisierung und Monetarisierung von Informationen geht. Die Flut von Daten, die wir täglich generieren, ist unerlässlich für das Training und die Verbesserung von KI-Systemen für Aufgaben wie die effizientere Automatisierung von Prozessen, die Erstellung zuverlässigerer Vorhersagen und die Gewährleistung einer höheren Netzwerksicherheit.

Eine Reise durch die Geschichte der KI

Die Einführung von KI in den 1950er Jahren verlief parallel zu den Anfängen des Atomzeitalters. Obwohl sich ihre Entwicklungswege unterschieden, werden beide Technologien als existenzielle Bedrohung für die Menschheit angesehen.

Im Laufe der Jahre wurden künstliche Intelligenz und die Spaltung des Atoms von Weltuntergangspropheten mehr oder weniger gleich behandelt. Ihrer Ansicht nach ist die Menschheit dazu verdammt, sich in einem nuklearen Holocaust zu vernichten, der durch die Übernahme unseres Planeten durch Roboter ausgelöst wird. Die Ängste rund um generative KI (GenAI) haben wenig dazu beigetragen, diese Befürchtungen zu zerstreuen.

Abgesehen von den negativen Vorstellungen über KI haben KI-Tools und -Technologien seit der Einführung des Turing-Tests im Jahr 1950 unglaubliche Fortschritte gemacht – trotz der zeitweiligen Höhen und Tiefen, die hauptsächlich auf die unregelmäßige Finanzierung der KI-Forschung zurückzuführen sind. Viele dieser bahnbrechenden Fortschritte blieben unbemerkt und waren bis vor etwa zehn Jahren, als KI praktisch auf die Wünsche und Bedürfnisse der Massen angewendet wurde, vor allem in akademischen, staatlichen und wissenschaftlichen Forschungskreisen sichtbar. KI-Produkte wie Apples Siri und Amazons Alexa, Online-Shopping, Social-Media-Feeds und selbstfahrende Autos haben den Lebensstil der Verbraucher und die Arbeitsweise von Unternehmen für immer verändert.

Zu den bemerkenswertesten Entwicklungen der letzten Jahrzehnte zählen unter anderem

- Neuronale Netze und die Prägung der Begriffe künstliche Intelligenz und maschinelles Lernen in den 1950er Jahren.

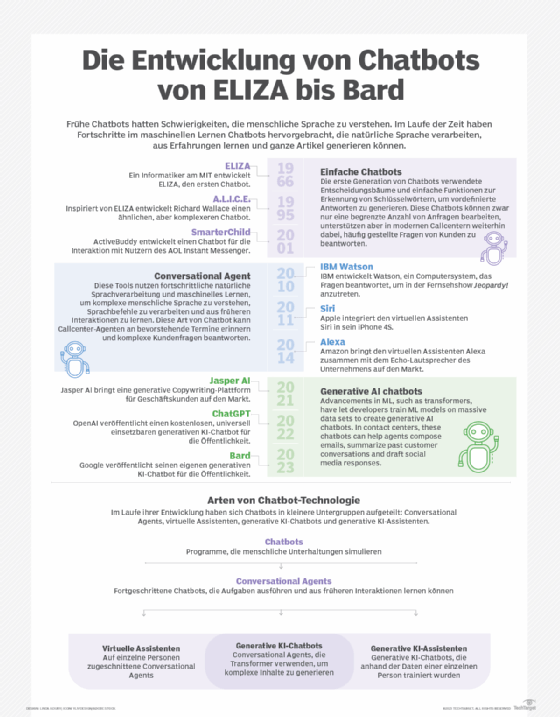

- Eliza, der Chatbot mit kognitiven Fähigkeiten, und Shakey, der erste mobile intelligente Roboter, in den 1960er Jahren.

- Der KI-Winter, gefolgt von einer KI-Renaissance in den 1970er und 1980er Jahren.

- Sprach- und Videoverarbeitung in den 1990er Jahren.

- IBM Watson, persönliche Assistenten, Gesichtserkennung, Deepfakes, autonome Fahrzeuge, GPT-Inhalte und Bildgenerierung sowie lebensechte GenAI-Klone in den 2000er Jahren.

1950

Alan Turing veröffentlichte Computing Machinery and Intelligence (PDF), in dem er den Turing-Test vorstellte und damit den Weg für die KI ebnete.

1951

Marvin Minsky und Dean Edmonds entwickelten das erste künstliche neuronale Netzwerk (KNN) namens SNARC, das mit 3.000 Vakuumröhren ein Netzwerk von 40 Neuronen simulierte.

1952

Arthur Samuel entwickelte das Samuel Checkers-Playing Program, das weltweit erste Programm, das selbstständig Spiele spielen konnte.

1956

John McCarthy, Marvin Minsky, Nathaniel Rochester und Claude Shannon prägten den Begriff künstliche Intelligenz in einem Vorschlag für einen Workshop, der weithin als Gründungsereignis des KI-Feldes anerkannt ist.

1958

Frank Rosenblatt entwickelte das Perzeptron, ein frühes KNN, das aus Daten lernen konnte und zur Grundlage für moderne neuronale Netzwerke wurde.

John McCarthy entwickelte die Programmiersprache Lisp, die schnell von der KI-Branche übernommen wurde und sich bei Entwicklern großer Beliebtheit erfreute.

1959

Arthur Samuel prägte in einer wegweisenden Abhandlung den Begriff maschinelles Lernen und erklärte, dass Computer so programmiert werden können, dass sie ihren Programmierer übertrumpfen.

Oliver Selfridge veröffentlichte Pandemonium: A Paradigm for Learning, einen Meilenstein im Bereich des maschinellen Lernens, in dem er ein Modell beschrieb, das sich selbst adaptiv verbessern kann, um Muster in Ereignissen zu finden.

1964

Daniel Bobrow entwickelte STUDENT, ein frühes Programm zur Verarbeitung natürlicher Sprache (Natural Language Processing, NLP), das zur Lösung algebraischer Textaufgaben entwickelt wurde, während er Doktorand am MIT war.

1965

Edward Feigenbaum, Bruce G. Buchanan, Joshua Lederberg und Carl Djerassi entwickelten das erste Expertensystem, Dendral, das organische Chemiker bei der Identifizierung unbekannter organischer Moleküle unterstützte.

1966

Joseph Weizenbaum schuf Eliza, eines der berühmtesten Computerprogramme aller Zeiten, das in der Lage war, Gespräche mit Menschen zu führen und ihnen vorzugaukeln, die Software habe menschenähnliche Emotionen.

Das Stanford Research Institute entwickelte Shakey, den weltweit ersten mobilen intelligenten Roboter, der KI, Computer Vision, Navigation und NLP kombinierte. Er ist der Vorläufer von selbstfahrenden Autos und Drohnen.

1968

Terry Winograd schuf SHRDLU, die erste multimodale KI, die eine Welt aus Blöcken gemäß den Anweisungen eines Benutzers manipulieren und erschließen konnte.

1969

Arthur Bryson und Yu-Chi Ho beschrieben einen Backpropagation-Lernalgorithmus, der mehrschichtige KNNs ermöglichte, eine Weiterentwicklung des Perzeptrons und eine Grundlage für Deep Learning.

Marvin Minsky und Seymour Papert veröffentlichten das Buch Perceptrons, in dem sie die Grenzen einfacher neuronaler Netze beschrieben, was zu einem Rückgang der Forschung im Bereich neuronaler Netze und zu einem Aufschwung der symbolischen KI-Forschung führte.

1973

James Lighthill veröffentlichte den Bericht Artificial Intelligence: A General Survey (PDF), der die britische Regierung dazu veranlasste, die Unterstützung für die KI-Forschung erheblich zu reduzieren.

1980

Symbolics Lisp-Maschinen wurden kommerzialisiert, was eine Renaissance der KI einläutete. Jahre später brach der Markt für Lisp-Maschinen zusammen.

1981

Danny Hillis entwarf Parallelrechner für KI und andere Rechenaufgaben, deren Architektur den modernen GPUs ähnelt.

1984

Marvin Minsky und Roger Schank prägten bei einer Tagung der Association for the Advancement of Artificial Intelligence den Begriff KI-Winter und warnten die Wirtschaft, dass der KI-Hype zu Enttäuschungen und zum Zusammenbruch der Branche führen würde, was drei Jahre später auch eintrat.

1985

Judea Pearl führte die kausale Analyse mit Bayesschen Netzwerken ein, die statistische Verfahren zur Darstellung von Unsicherheit in Computern bereitstellt.

1988

Peter Brown et al. veröffentlichten A Statistical Approach to Language Translation und ebneten damit den Weg für eine der am häufigsten untersuchten Methoden der maschinellen Übersetzung.

1989

Yann LeCun, Yoshua Bengio und Patrick Haffner demonstrierten, wie Convolutional Neural Networks (CNN) zur Erkennung handgeschriebener Zeichen eingesetzt werden können, und zeigten damit, dass neuronale Netze auf Probleme der realen Welt angewendet werden können.

1997

Sepp Hochreiter und Jürgen Schmidhuber schlugen das rekurrente neuronale Netz (RNN) Long Short-Term Memory vor, das ganze Datensequenzen wie Sprache oder Videos verarbeiten kann.

Deep Blue von IBM besiegte Garry Kasparov in einer historischen Schach-Revanche und besiegte damit erstmals einen amtierenden Schachweltmeister unter Turnierbedingungen.

2000

Forscher der Universität Montreal veröffentlichten A Neural Probabilistic Language Model (PDF), das eine Methode zur Modellierung von Sprache mithilfe von Feedforward-Neuralnetzwerken vorschlug.

2006

Fei-Fei Li begann mit der Arbeit an der visuellen Datenbank ImageNet, die 2009 eingeführt wurde und zum Katalysator für den KI-Boom und zur Grundlage für einen jährlichen Wettbewerb für Bilderkennungsalgorithmen wurde.

IBM Watson entstand mit dem ursprünglichen Ziel, einen Menschen in der legendären Quizshow Jeopardy! zu schlagen. Im Jahr 2011 besiegte das Frage-Antwort-Computersystem den bisherigen (menschlichen) Champion der Show, Ken Jennings.

2009

Rajat Raina, Anand Madhavan und Andrew Ng veröffentlichten Large-Scale Deep Unsupervised Learning Using Graphics Processors (PDF) und stellten darin die Idee vor, GPUs zum Trainieren großer neuronaler Netze zu verwenden.

2011

Jürgen Schmidhuber, Dan Claudiu Cireșan, Ueli Meier und Jonathan Masci entwickelten das erste CNN, das „übermenschliche” Leistungen erzielte und den deutschen Wettbewerb zur Verkehrszeichenerkennung gewann.

Apple brachte Siri auf den Markt, einen sprachgesteuerten persönlichen Assistenten, der auf Sprachbefehle reagieren und entsprechende Aktionen ausführen kann.

2012

Geoffrey Hinton, Ilya Sutskever und Alex Krizhevsky stellten eine Deep-CNN-Architektur vor, die den ImageNet-Wettbewerb gewann und eine explosionsartige Zunahme der Forschung und Implementierung im Bereich Deep Learning auslöste.

2013

Chinas Tianhe-2 verdoppelte mit 33,86 Petaflops die weltweit höchste Supercomputing-Geschwindigkeit und behielt damit zum dritten Mal in Folge den Titel des schnellsten Systems der Welt.

DeepMind führte Deep Reinforcement Learning ein, ein CNN, das auf der Grundlage von Belohnungen lernte und durch Wiederholung das Spielen von Spielen erlernte und dabei das Niveau menschlicher Experten übertraf.

Der Google-Forscher Tomas Mikolov und seine Kollegen stellten Word2vec vor, um semantische Beziehungen zwischen Wörtern automatisch zu identifizieren.

2014

Ian Goodfellow und seine Kollegen erfanden Generative Adversarial Networks (GAN), eine Klasse von Frameworks für maschinelles Lernen, die zur Erzeugung von Fotos, zur Transformation von Bildern und zur Erstellung von Deepfakes verwendet werden.

Diederik Kingma und Max Welling stellten variationale Autoencoder (VAE) zur Erzeugung von Bildern, Videos und Texten vor.

Facebook entwickelte das Deep-Learning-Gesichtserkennungssystem DeepFace, das menschliche Gesichter in digitalen Bildern mit nahezu menschlicher Genauigkeit identifiziert.

2016

DeepMinds AlphaGo besiegte den Spitzen-Go-Spieler Lee Sedol in Seoul, Südkorea, was Vergleiche mit dem Schachmatch zwischen Kasparov und Deep Blue fast 20 Jahre zuvor hervorrief.

Uber startete in Pittsburgh ein Pilotprogramm für selbstfahrende Autos für eine ausgewählte Gruppe von Nutzern.

2017

Forscher der Stanford University veröffentlichten in der Arbeit Deep Unsupervised Learning Using Nonequilibrium Thermodynamics ihre Forschungsergebnisse zu Diffusionsmodellen. Die Technik ermöglicht es, den Prozess des Hinzufügens von Rauschen zu einem endgültigen Bild zurückzuentwickeln.

Google-Forscher entwickelten in der bahnbrechenden Veröffentlichung Attention Is All You Need das Konzept der Transformer und inspirierten damit weitere Forschungen zu Tools, die nicht gekennzeichneten Text automatisch in Large Language Models (LLM) zerlegen können.

Der britische Physiker Stephen Hawking warnte: „Wenn wir nicht lernen, uns auf die potenziellen Risiken vorzubereiten und sie zu vermeiden, könnte KI das schlimmste Ereignis in der Geschichte unserer Zivilisation sein.”

2018

Cimon, entwickelt von IBM, Airbus und dem Deutschen Zentrum für Luft- und Raumfahrt (DLR), war der erste Roboter, der zur Unterstützung von Astronauten ins All geschickt wurde.

OpenAI veröffentlichte GPT (Generative Pre-trained Transformer) und ebnete damit den Weg für nachfolgende LLMs.

Groove X stellte einen Heim-Miniroboter namens Lovot vor, der Stimmungsschwankungen bei Menschen wahrnehmen und beeinflussen kann.

2019

Microsoft brachte das generative Sprachmodell Turing Natural Language Generation mit 17 Milliarden Parametern auf den Markt.

Der Deep-Learning-Algorithmus von Google AI und dem Langone Medical Center übertraf Radiologen bei der Erkennung potenzieller Lungenkrebsfälle.

2020

Die Universität Oxford entwickelte einen KI-Test namens Curial, um COVID-19 bei Patienten in Notaufnahmen schnell zu erkennen.

OpenAI veröffentlichte das LLM GPT-3 mit 175 Milliarden Parametern zur Generierung menschenähnlicher Textmodelle.

Nvidia kündigte die Beta-Version seiner Omniverse-Plattform zur Erstellung von 3D-Modellen in der physischen Welt an.

Das AlphaFold-System von DeepMind gewann den Wettbewerb Critical Assessment of Protein Structure Prediction zur Vorhersage von Proteinfaltungen.

2021

OpenAI stellte das multimodale KI-System Dall-E vor, das aus Textvorgaben Bilder generieren kann.

Die University of California in San Diego entwickelte einen vierbeinigen Soft-Roboter, der statt mit Elektronik mit Druckluft funktioniert.

2022

Der Google-Softwareentwickler Blake Lemoine wurde entlassen, weil er Geheimnisse über Lamda preisgegeben und behauptet hatte, dass es empfindungsfähig sei.

DeepMind stellte AlphaTensor „zur Entdeckung neuartiger, effizienter und nachweislich korrekter Algorithmen” vor.

Intel gab an, dass sein Echtzeit-Deepfake-Detektor FakeCatcher eine Genauigkeit von 96 Prozent erreicht.

OpenAI veröffentlichte am 30. November ChatGPT, eine chatbasierte Schnittstelle zu seinem GPT-3.5 LLM, und signalisierte damit die Demokratisierung der KI für die breite Masse.

2023

OpenAI kündigte das multimodale LLM GPT-4 an, das sowohl Text- als auch Bildvorgaben verarbeitet. Microsoft integrierte ChatGPT in seine Suchmaschine Bing, und Google veröffentlichte seinen GPT-Chatbot Bard.

Elon Musk, Steve Wozniak und Tausende weitere Unterzeichner forderten eine sechsmonatige Pause beim Training von „KI-Systemen, die leistungsfähiger sind als GPT-4”.

2024

Generative KI-Tools entwickelten sich dank verbesserter Modellarchitekturen, Effizienzsteigerungen und besserer Trainingsdaten rasant weiter. Intuitive Schnittstellen trieben die breite Akzeptanz voran, trotz anhaltender Bedenken hinsichtlich Problemen wie Voreingenommenheit, Energieverbrauch und Arbeitsplatzverlagerungen.

Die Umbenennung des Chatbots Bard GenAI durch Google verlief holprig, da der neu benannte Gemini heftige Kritik für die Erstellung ungenauer Bilder mehrerer historischer Persönlichkeiten, darunter George Washington und andere Gründerväter, sowie für zahlreiche andere sachliche Ungenauigkeiten erhielt. Die Einführung von AI Overviews durch Google, das kurze Zusammenfassungen von Themen und Links zu Dokumenten für weiterführende Recherchen bietet, verstärkte die Bedenken hinsichtlich der Monopolstellung der Suchmaschine und warf bei traditionellen und Online-Verlagen weitere Fragen zur Kontrolle des geistigen Eigentums auf.

Das Europäische Parlament verabschiedete den AI Act mit Bestimmungen, die schrittweise umgesetzt werden sollen, darunter Verhaltenskodizes, das Verbot von KI-Systemen, die „inakzeptable Risiken“ bergen, und Transparenzanforderungen für allgemeine KI-Systeme.

Delphi hat GenAI-Klone auf den Markt gebracht, mit denen Nutzer lebensechte digitale Versionen von sich selbst erstellen können, von Abbildern von Unternehmenschefs, die an Zoom-Meetings teilnehmen, bis hin zu Prominenten, die Fragen auf YouTube beantworten.

2025 und darüber hinaus

Die Unternehmensausgaben für generative KI werden in den kommenden Jahren voraussichtlich 1 Billion US-Dollar übersteigen. Bloomberg prognostiziert, dass GenAI-Produkte durch spezialisierte Assistenten, neue Infrastrukturprodukte und Copiloten, die die Codierung beschleunigen, etwa 280 Milliarden US-Dollar an neuen Softwareumsätzen generieren können.

Im Zuge der GenAI stehen die kontinuierlichen technologischen Fortschritte und Einflüsse der künstlichen Intelligenz noch am Anfang ihrer Anwendung in Geschäftsprozessen, autonomen Systemen, Fertigung, Gesundheitswesen, Finanzdienstleistungen, Marketing, Kundenerfahrung, Arbeitsumgebungen, Bildung, Landwirtschaft, Recht, IT-Systemen und -Management, Cybersicherheit sowie Boden-, Luft- und Raumtransport.

Bis 2026 werden laut Gartner Unternehmen, die „Transparenz, Vertrauen und Sicherheit im Bereich KI operationalisieren, eine 50-prozentige Verbesserung ihrer KI-Modelle in Bezug auf Akzeptanz, Geschäftsziele und Nutzerakzeptanz erzielen“.

Rita Sallam, Analystin bei Gartner, gab jedoch auf dem Data and Analytics Summit im Juli bekannt, dass Führungskräfte in Unternehmen „ungeduldig auf die Rendite ihrer GenAI-Investitionen warten ... [und] Unternehmen Schwierigkeiten haben, den Wert zu beweisen und zu realisieren“. Infolgedessen prognostiziert das Forschungsunternehmen, dass bis Ende 2025 mindestens 30 Prozent der GenAI-Projekte aufgrund „mangelhafter Datenqualität, unzureichender Risikokontrollen, steigender Kosten oder unklarem geschäftlichem Nutzen“ aufgegeben werden.

Die konkreten Entwicklungen von heute – einige davon schrittweise, andere disruptiv – bringen das ultimative Ziel der KI, die künstliche allgemeine Intelligenz, näher. In diesem Zusammenhang ist die neuromorphe Verarbeitung vielversprechend, da sie menschliche Gehirnzellen nachahmt und es Computerprogrammen ermöglicht, gleichzeitig statt nacheinander zu arbeiten. Inmitten dieser und anderer verblüffender Fortschritte sind Fragen des Vertrauens, der Privatsphäre, der Transparenz, der Verantwortlichkeit, der Ethik und der Menschlichkeit aufgetaucht, die weiterhin aufeinanderprallen und nach einem akzeptablen Niveau in Wirtschaft und Gesellschaft suchen werden.