GPT-3

Was ist GPT-3?

GPT-3, oder Generative Pre-trained Transformer (GPT) der dritten Generation, ist ein Machine-Learning-Modell mit neuronalen Netzen, das mit Internetdaten trainiert wurde, um jede Art von Text zu generieren. Es wurde von OpenAI entwickelt und benötigt eine kleine Menge an Eingabetext, um große Mengen an relevantem und anspruchsvollem maschinell generiertem Text zu erzeugen.

Das Deep Learning Neural Network von GPT-3 ist ein Modell mit über 175 Milliarden Parametern für maschinelles Lernen. Zum Vergleich: Das größte trainierte Sprachmodell vor GPT-3 war das Turing Natural Language Generation (NLG) Modell von Microsoft mit zehn Milliarden Parametern. Bei seiner Veröffentlichung war GPT-3 das größte jemals produzierte neuronale Netzwerk.

Was kann GPT-3?

GPT-3 verarbeitet Texteingaben, um eine Vielzahl von natürlichsprachlichen Aufgaben zu erfüllen. Es nutzt sowohl die Generierung natürlicher Sprache als auch die Verarbeitung natürlicher Sprache, um natürlichen Text in menschlicher Sprache zu verstehen und zu erzeugen. Die Generierung von Inhalten, die für Menschen verständlich sind, war in der Vergangenheit eine Herausforderung für Maschinen, welche die Komplexität und Nuancen der Sprache nicht kennen, doch GPT-3 ist darauf trainiert, realistische menschliche Texte zu generieren. GPT-3 wurde zur Erstellung von Artikeln, Gedichten, Geschichten, Nachrichtenberichten und Dialogen mit einer kleinen Menge an Eingabetext verwendet, die für die Produktion großer Textmengen verwendet werden kann.

GPT-3 kann alles erstellen, was eine Textstruktur hat – nicht nur Texte in menschlicher Sprache. Es kann auch Textzusammenfassungen und sogar Programmiercode erstellen.

GPT-3-Beispiele

Eines der bemerkenswertesten Beispiele für die Implementierung von GPT-3 ist das ChatGPT-Sprachmodell. ChatGPT ist eine Variante des GPT-3-Modells, die für den menschlichen Dialog optimiert ist, das heißt es kann Folgefragen stellen, Fehler zugeben und falsche Prämissen in Frage stellen. ChatGPT wurde während seiner Preview kostenlos der Öffentlichkeit zugänglich gemacht, um Feedback zu sammeln. ChatGPT wurde unter anderem entwickelt, um die Möglichkeit schädlicher oder betrügerischer Antworten zu verringern.

Ein weiteres bekanntes Beispiel ist Dall-E. Dall-E ist ein neuronales KI-Netzwerk zur Bilderzeugung, das auf einer 12-Milliarden-Parameter-Version von GPT-3 basiert. Dall-E wurde mit einem Datensatz von Text-Bild-Paaren trainiert und kann Bilder aus vom Benutzer eingegebenen Textaufforderungen erzeugen. ChatGPT und Dall-E wurden von OpenAI entwickelt.

GPT-3 ist auch in der Lage, mit Unterstützung einiger weniger Textfragmente funktionierenden Code zu erstellen, der ohne Fehler ausgeführt werden kann, da Programmiercode eine Form von Text ist. Ein Entwickler hat zum Beispiel das Tool Figma zur Erstellung von Benutzeroberflächen-Prototypen mit GPT-3 kombiniert, um Websites zu erstellen, indem er sie in ein oder zwei Sätzen beschrieb. GPT-3 wurde sogar zum Klonen von Websites verwendet, indem eine URL als Textvorschlag angegeben wurde. Entwickler nutzen GPT-3 auf verschiedene Weise, von der Generierung von Codeschnipseln, regulären Ausdrücken, Plots und Diagrammen aus Textbeschreibungen, Excel-Funktionen und anderen Entwicklungsanwendungen.

GPT-3 kann auch im Gesundheitswesen eingesetzt werden. In einer Studie aus dem Jahr 2022 wurde die Fähigkeit von GPT-3 untersucht, bei der Diagnose von neurodegenerativen Krankheiten wie Demenz zu helfen, indem häufige Symptome wie Sprachstörungen in der Sprache der Patienten erkannt werden.

GPT-3 kann auch:

- Memes, Quizze, Rezepte, Comics, Blogbeiträge und Werbetexte erstellen

- Musik, Witze und Beiträge für soziale Medien schreiben

- Konversationsaufgaben automatisieren, indem es auf jeden Text, den eine Person in den Computer eingibt, mit einem neuen, dem Kontext entsprechenden Textstück antwortet

- Text in programmatische Befehle übersetzen

- programmatische Befehle in Text übersetzen

- Stimmungsanalyse durchführen

- Informationen aus Verträgen extrahieren

- eine hexadezimale Farbe auf der Grundlage einer Textbeschreibung erzeugen

- Boilerplate-Code schreiben

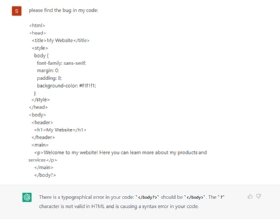

- Fehler in bestehendem Code finden

- Websites nachbilden

- vereinfachte Zusammenfassungen von Texten erstellen

- zwischen Programmiersprachen übersetzen

- bösartige Prompt-Engineering- und Phishing-Angriffe durchführen.

Wie funktioniert GPT-3?

GPT-3 ist ein Sprachvorhersagemodell. Das bedeutet, dass es über ein Machine-Learning-Modell in Form eines neuronalen Netzwerks verfügt, das einen eingegebenen Text in das umwandeln kann, was es als das nützlichste Ergebnis vorhersagt. Dies wird erreicht, indem das System mit der riesigen Menge an Internettexten trainiert wird, um Muster zu erkennen, ein Prozess, der generatives Pre-Training genannt wird. GPT-3 wurde mit mehreren Datensätzen trainiert, die jeweils unterschiedlich gewichtet wurden, darunter Common Crawl, WebText2 und Wikipedia.

GPT-3 wird zunächst in einer überwachten Testphase und dann in einer Verstärkungsphase trainiert. Beim Training von ChatGPT stellt ein Team von Trainern dem Sprachmodell eine Frage mit dem Ziel einer korrekten Ausgabe. Wenn das Modell falsch antwortet, korrigieren die Trainer das Modell, um ihm die richtige Antwort beizubringen. Das Modell kann auch mehrere Antworten geben, die von den Trainern von der besten bis zur schlechtesten eingestuft werden.

GPT-3 hat mehr als 175 Milliarden Parameter für maschinelles Lernen und ist deutlich größer als seine Vorgänger – frühere große Sprachmodelle wie Bidirectional Encoder Representations from Transformers (BERT) und Turing NLG. Parameter sind die Teile eines großen Sprachmodells, die seine Fähigkeiten bei einem Problem wie der Texterstellung definieren. Die Leistung eines großen Sprachmodells skaliert im Allgemeinen, wenn mehr Daten und Parameter zum Modell hinzugefügt werden.

Wenn ein Benutzer eine Texteingabe macht, analysiert das System die Sprache und verwendet einen Textprädiktor, der auf seinem Training basiert, um die wahrscheinlichste Ausgabe zu erstellen. Das Modell kann fein abgestimmt werden, aber auch ohne viel zusätzliches Tuning oder Training erzeugt das Modell qualitativ hochwertigen Ausgabetext, der sich ähnlich anfühlt wie das, was Menschen produzieren würden.

Was sind die Vorteile von GPT-3?

Wann immer eine große Textmenge von einer Maschine auf der Grundlage einer kleinen Menge von Texteingaben generiert werden muss, bietet GPT-3 eine gute Lösung. Große Sprachmodelle wie GPT-3 sind in der Lage, bei einer Handvoll von Trainingsbeispielen anständige Ergebnisse zu liefern.

GPT-3 ist auch für eine Vielzahl von Anwendungen im Bereich der künstlichen Intelligenz geeignet. Es ist aufgabenunabhängig, das heißt es kann eine große Bandbreite von Aufgaben ohne Feinabstimmung durchführen.

Wie bei jeder Automatisierung ist GPT-3 in der Lage, schnelle, sich wiederholende Aufgaben zu erledigen, so dass Menschen komplexere Aufgaben erledigen können, die ein höheres Maß an kritischem Denken erfordern. Es gibt viele Situationen, in denen es nicht praktikabel oder effizient ist, einen Menschen mit der Erstellung von Textausgaben zu beauftragen, oder in denen eine automatische Texterstellung erforderlich ist, die menschlich wirkt. Beispielsweise können Kundendienstzentren GPT-3 verwenden, um Kundenfragen zu beantworten oder Chatbots zu unterstützen; Vertriebsteams können damit mit potenziellen Kunden in Kontakt treten. Marketingteams können mit GPT-3 Texte verfassen. Diese Art von Inhalten erfordert ebenfalls eine schnelle Produktion und ist risikoarm, das heißt wenn ein Fehler in den Texten auftritt, sind die Folgen relativ gering.

Ein weiterer Vorteil von GPT-3 ist, dass es leichtgewichtig ist und auf einem Laptop oder Smartphone laufen kann.

Was sind die Risiken und Grenzen von GPT-3?

GPT-3 ist zwar bemerkenswert groß und leistungsfähig, hat aber auch einige Einschränkungen und Risiken, die mit seiner Verwendung verbunden sind.

Einschränkungen

Vortrainiert. GPT-3 lernt nicht ständig. Er wurde vortrainiert, das heißt er verfügt nicht über ein Langzeitgedächtnis, das aus jeder Interaktion lernt.

Begrenzte Eingabegröße. Transformer-Architekturen – einschließlich GPT-3 – haben eine begrenzte Eingabegröße. Ein Benutzer kann nicht viel Text als Eingabe für die Ausgabe bereitstellen, was bestimmte Anwendungen einschränken kann. GPT-3 hat ein Prompt-Limit von etwa 2.048 Token.

Langsame Inferenzzeit. GPT-3 leidet auch unter einer langsamen Inferenzzeit, da es lange dauert, bis das Modell Ergebnisse erzeugt.

Mangelnde Erklärbarkeit. GPT-3 leidet unter denselben Problemen, mit denen viele neuronale Netze zu kämpfen haben: Sie sind nicht in der Lage zu erklären und zu interpretieren, warum bestimmte Eingaben zu bestimmten Ausgaben führen.

Risiken

Nachahmung. Sprachmodelle wie GPT-3 werden immer präziser und maschinell erstellte Inhalte sind möglicherweise nur noch schwer von denen zu unterscheiden, die von einem Menschen geschrieben wurden. Dies kann zu Problemen mit dem Urheberrecht und Plagiaten führen.

Genauigkeit. Obwohl GPT-3 in der Lage ist, das Format eines von Menschen erstellten Textes zu imitieren, hat es bei vielen Anwendungen mit der sachlichen Richtigkeit zu kämpfen.

Verzerrung. Sprachmodelle sind anfällig für Verzerrungen beim maschinellen Lernen. Da das Modell mit Internettexten trainiert wurde, kann es viele der Verzerrungen lernen und zeigen, die auch Menschen online zeigen. Zwei Forscher des Middlebury Institute of International Studies in Monterey haben beispielsweise herausgefunden, dass GPT-2 – der Vorgänger von GPT-3 – geschickt radikale Texte generiert, wie zum Beispiel Reden, die Verschwörungstheoretiker und weiße Rassisten imitieren. Dies bietet die Möglichkeit, Hassreden zu verstärken und zu automatisieren, aber auch unbeabsichtigt zu erzeugen. ChatGPT – das auf einer Variante von GPT-3 basiert – zielt darauf ab, die Wahrscheinlichkeit, dass dies geschieht, durch intensiveres Training und Benutzer-Feedback zu verringern.

Geschichte von GPT-3

OpenAI wurde 2015 als gemeinnützige Organisation gegründet und entwickelte GPT-3 als eines seiner Forschungsprojekte. Es verfolgte das übergeordnete Ziel, eine „freundliche KI“ zu fördern und zu entwickeln, die der Menschheit als Ganzes zugutekommt.

Die erste Version von GPT wurde im Jahr 2018 veröffentlicht und enthielt 117 Millionen Parameter. Die zweite Version des Modells, GPT-2, wurde 2019 mit rund 1,5 Milliarden Parametern veröffentlicht. Als neueste Version übertrifft GPT-3 das letzte Modell mit mehr als 175 Milliarden Parametern um ein Vielfaches – mehr als das 100-fache seines Vorgängers und zehnmal mehr als vergleichbare Programme.

Frühere vortrainierte Modelle – wie BERT – haben die Machbarkeit der Textgeneratormethode demonstriert und gezeigt, dass neuronale Netze in der Lage sind, lange Textstrings zu generieren, die zuvor unerreichbar schienen.

OpenAI gab den Zugang zu dem Modell schrittweise frei, um zu sehen, wie es genutzt wird und um mögliche Probleme zu vermeiden. Das Modell wurde während einer Beta-Phase freigegeben, in der sich die Nutzer zunächst kostenlos für die Nutzung des Modells bewerben mussten. Die Beta-Phase endete jedoch im Oktober 2020 und das Unternehmen veröffentlichte ein Preismodell, das auf einem gestaffelten Kreditsystem basiert, das von einem kostenlosen Zugang für 100.000 Credits oder drei Monate Zugang bis zu Hunderten von Dollar pro Monat für einen größeren Zugang reicht. Im Jahr 2020 investierte Microsoft eine Milliarde Dollar in OpenAI, um der exklusive Lizenznehmer des GPT-3-Modells zu werden. Das bedeutet, dass Microsoft alleinigen Zugriff auf das GPT-3 zugrunde liegende Modell hat.

ChatGPT kam im November 2022 auf den Markt und war während seiner Forschungsphase für die Öffentlichkeit frei zugänglich. Dadurch erlangte GPT-3 mehr Aufmerksamkeit als zuvor und bot vielen technisch nicht versierten Nutzern die Möglichkeit, die Technologie auszuprobieren.

Die Zukunft von GPT-3

OpenAI und andere arbeiten an noch leistungsfähigeren Modellen. Es gibt eine Reihe von Open-Source-Anstrengungen, um ein kostenloses und nicht lizenziertes Modell als Gegengewicht zu den exklusiven Eigentumsrechten von Microsoft anzubieten. OpenAI plant größere und domänenspezifischere Versionen seiner Modelle, die auf verschiedene und unterschiedlichste Arten von Text trainiert werden.

Andere untersuchen verschiedene Anwendungsfälle und Anwendungen des GPT-3 Modells. Die Exklusivlizenz von Microsoft stellt jedoch diejenigen vor Herausforderungen, die die Fähigkeiten in ihre Anwendungen einbinden wollen. Microsoft hat diskutiert, eine Version von ChatGPT in Anwendungen wie Word, PowerPoint und Microsoft Power Apps einzubinden.

Es ist unklar, wie sich GPT-3 in Zukunft entwickeln wird, aber es ist wahrscheinlich, dass es weiterhin reale Anwendungen finden und in verschiedene generative KI-Anwendungen integriert werden wird.