blacksalmon - stock.adobe.com

So hoch ist der Energiebedarf von KI

KI-Anwendungen treiben den Energiebedarf die Höhe. Studien warnen vor Engpässen. Die Hyperscaler reagieren mit effizienteren Modellen oder sichern sich Kraftwerksleistung.

Auch wenn viele über ein Platzen der KI-Blase spekulieren, so ist künstliche Intelligenz (KI) mehr als ein Hype. KI wird in vielen Bereichen eingesetzt, von der Texterstellung über die Spracherkennung bis hin zur Bildanalyse. Doch so beeindruckend viele Anwendungen auch sind: KI ist nicht unumstritten. Diskussionen über Datenschutz, Urheberrechte, Jobverluste und eben auch Umweltfolgen nehmen zu. Ein Aspekt gerät dabei oft in den Hintergrund: der enorme Energiebedarf. Denn KI braucht vor allem eines, um zu funktionieren: Strom. Und davon nicht wenig. Dieser Artikel zeigt, wie hoch der Energiebedarf moderner KI-Systeme ist, wo die größten Stromfresser sitzen und warum das Thema mehr Aufmerksamkeit verdient.

KI-Energiebedarf wird unterschätzt

KI treibt den Energie- und Wasserbedarf von Rechenzentren spürbar nach oben, während viele Führungskräfte die Umweltfolgen unterschätzen. Laut der Studie Expleo AI Pulse sind in Europa nur 42 Prozent der Befragten besorgt, in Deutschland sogar nur 30 Prozent . Zwar bewerten 70 Prozent der deutschen Entscheider den geschäftlichen Nutzen von KI überwiegend positiv, doch Standardisierung und belastbare KPIs für Energie- und Nachhaltigkeitsziele fehlen oft. Expleo warnt vor regulatorischen, wirtschaftlichen und Reputationsrisiken, wenn Nachhaltigkeit in KI-Strategien ausgeblendet wird. Responsible AI bedeutet, ökologische, regulatorische und ethische Verantwortung mit tragfähigen Geschäftsmodellen zu verbinden – inklusive messbarer Energie-/Wasser-Kennzahlen, Effizienzplänen und einem sauberen Strommix.

Training vs. Inferenz: Wo die Energie hingeht

Sprachmodelle wie GPT sind die technische Grundlage vieler KI-Angebote im Internet, darunter ChatGPT, Gemini, DeepSeek und Copilot. Diese Modelle nutzen riesige Datenmengen, um Sprache zu verstehen und menschenähnliche Antworten zu generieren.

Der Energieverbrauch eines KI-Modells fällt in zwei entscheidenden Phasen an: Training und Inferenz. Das Training ist die aufwendigste Phase. Hier werden riesige Mengen an Textdaten verarbeitet, analysiert und gewichtet. Dafür laufen Hochleistungsrechner in Rechenzentren oft wochenlang auf Hochtouren. Allein das Training von GPT-3 soll rund 1.287 Megawattstunden (MWh) Strom verbraucht haben, was etwa dem Jahresverbrauch von 120 deutschen Durchschnittshaushalten entspricht. GPT-4 benötigt aufgrund seiner höheren Komplexität noch deutlich mehr Energie – es sollen bis zu 62.319 MWh sein. Allerdings sind nicht alle KI-Modelle gleich energieintensiv: Spezialisierte Systeme für die Medizin oder die Wettervorhersage verbrauchen oft weniger Energie als universelle Sprachmodelle.

Aktuelle Forschung zeigt jedoch, dass optimierte Trainingsmethoden und spezialisierte Chips den Energieverbrauch deutlich senken können. Forschende der TU München entwickelten etwa eine Technik, die das Training neuronaler Netze bis zu hundertmal effizienter macht.

Nach dem Training folgt die sogenannte Inferenz. Das ist der Moment, in dem das Modell auf konkrete Anfragen von Nutzern reagiert, also zum Beispiel einen Text schreibt oder eine Frage beantwortet. Auch hier wird Rechenleistung benötigt, wenn auch deutlich weniger als beim Training. Dennoch kommt einiges zusammen, wenn täglich Millionen von Anfragen bearbeitet werden. Der Energieverbrauch pro Anfrage hängt stark von der Nutzung ab: Eine kurze Textzusammenfassung verbraucht weniger als ein langes Gespräch mit mehreren Anfragen.

Energiekonsum von KI im Vergleich

- Training GPT-3: ca. 1.287 MWh. Quelle: ScienceDirect

- Training GPT-4: circa 10.000 bis 30.000 MWh. Quelle: Polytechnique Insights. 51,8 bis 62,3 GWh. Quelle: Medium

- LLM-Anfrage (GPT-4o, typische kurze/mittlere Antwort): etwa 0,3 bis 3 Wh (0,0003–0,003 kWh, stark token-abhängig). Quelle: Epoch AI. OpenAI nennt circa 0,34 Wh als Richtwert. Quelle: Business Insider

- Google-Suchanfrage: etwa 0,0003 kWh (0,3 Wh). Quelle: Google

- Bitcoin-Transaktion: im Mittel etwa 825 W bis 1.423 kWh pro Transaktion. Quelle: Digiconomist

- Rechenzentren weltweit: rund 1,5 Prozent des globalen Stromverbrauchs in 2024 (circa 415 TWh). Quelle: IEA

Eine einzelne ChatGPT-4o-Anfrage kann zwischen 0,3 und 3 Wh verbrauchen, je nach Modell und Rechenzentrumsinfrastruktur. Zum Vergleich: Eine Google-Suchanfrage benötigt etwa 0,3 Wh. Eine einzelne Bitcoin-Transaktion verbrucht bis zu 1,4 kWh. 100.000 VISA-Kreditkartentransaktion benötigen dagegen mit 0,1483 kWh nur einen Bruchteil dieser Energie.

Moderne Rechenzentren setzen zunehmend auf spezialisierte Hardware und energieeffiziente Chips, die den Stromverbrauch während der Inferenz reduzieren. Auch die Verwendung von kleineren, spezialisierten KI-Modellen für bestimmte Aufgaben hilft dabei, Energie zu sparen.

Warum der steigende Energieverbrauch problematisch ist

Je mehr KI-Anwendungen in Unternehmen, Schulen, Verwaltungen und im Alltag eingesetzt werden, desto größer wird der Strombedarf. Vor allem, wenn viele Menschen gleichzeitig auf große Sprachmodelle zugreifen oder diese für automatisierte Prozesse im Hintergrund laufen. Das Problem: Stammt der dafür benötigte Strom nicht aus erneuerbaren Quellen, steigt der Ausstoß von CO₂. Schon heute entfallen etwa ein bis zwei Prozent des weltweiten Stromverbrauchs auf Rechenzentren. KI trägt dazu bei, dass dieser Anteil weiter steigt.

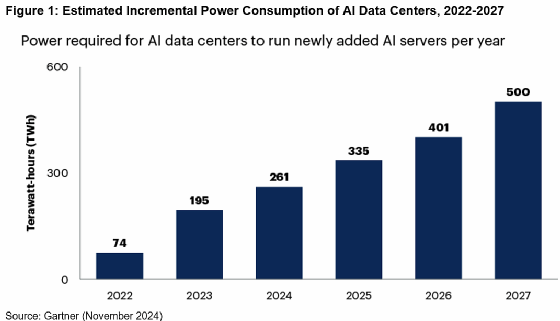

Langfristige Prognosen sind schwierig: Einige Studien sagen einen exponentiellen Anstieg voraus, andere weisen darauf hin, dass Effizienzsteigerungen den Verbrauch stabilisieren könnten. Laut einer Prognose von Gartner vom November 2024 könnten bis 2027 rund 40 Prozent der bestehenden KI-Rechenzentren vom Stromausfall betroffen sein oder in ihrer Kapazität eingeschränkt werden. Der Strombedarf dieser Infrastrukturen wird auf rund 500 Terawattstunden pro Jahr steigen, was einem Plus von 160 Prozent gegenüber 2024 entspricht.

Das wirft Fragen nach der Skalierbarkeit und Nachhaltigkeit aktueller KI-Infrastrukturen auf.

Ein weiteres Problem: Die Nachfrage nach KI wächst schneller als die Effizienz von Hard- und Software. Neue, größere Modelle benötigen trotz aller Fortschritte bei Chips und Algorithmen mehr und nicht weniger Rechenleistung. Um dieser Entwicklung entgegenzuwirken, hat sich der sogenannte AI Energy Score etabliert. Er bewertet die Energieeffizienz verschiedener KI-Modelle und hilft Entwicklern bei der Auswahl ressourcenschonender Lösungen.

Was die KI-Anbieter gegen den Energiehunger tun

Die KI-Anbieter sind sich des Problems bewusst und versuchen, Abhilfe zu schaffen. Zum einen setzen sie auf effizientere Hardware wie spezialisierte Chips, die mehr Leistung bei geringerem Stromverbrauch bieten. Zum anderen arbeiten sie daran, die Modelle selbst sparsamer zu machen. Das kann zum Beispiel durch Komprimierung, clevere Trainingsmethoden oder kleinere Spezialmodelle für bestimmte Aufgaben geschehen.

Viele große Anbieter betreiben ihre Rechenzentren inzwischen mit erneuerbaren Energien oder kaufen entsprechende Zertifikate, um ihren CO₂-Fußabdruck. Grüne Energie ist jedoch nicht unbegrenzt verfügbar. Der steigende Strombedarf der KI könnte den Druck auf andere Sektoren erhöhen, ebenfalls kohlenstofffrei zu werden. Gleichzeitig experimentieren einige Unternehmen mit neuen Ansätzen wie der Flüssigkühlung für Rechenzentren, um den Energieverbrauch weiter zu senken.

Ein weiterer Ansatz stammt von Google: Das Unternehmen will Machine-Learning-Workloads künftig flexibel anpassen, also bei hoher Netzauslastung drosseln oder verschieben. In Kooperation mit den US-Energieversorgern Indiana Michigan Power (I&M) und Tennessee Valley Authority (TVA) testet Google sogenannte Demand-Response-Modelle, um die Netze zu entlasten. Von dieser Maßnahme sind nicht-kritische KI-Lasten betroffen, während Kernfunktionen wie Search oder Maps uneingeschränkt weiterlaufen.

Chinas DeepSeek wurde ursprünglich als energieeffizientes KI-Modell beworben, doch Analysen zeigen ein differenzierteres Bild. Während das Training durch optimierte Methoden tatsächlich weniger Energie verbraucht, scheint die Inferenz, also die Beantwortung von Anfragen, deutlich energieintensiver zu sein.

Ein Grund dafür ist die Chain-of-Thought-Logik, die komplexere Antworten generiert, aber auch mehr Rechenleistung benötigt. In einigen Tests verbrauchte DeepSeek bei der Inferenz sogar bis zu 87 Prozent mehr Energie als vergleichbare Modelle. DeepSeek kann also beim Training sparsamer sein, aber im Betrieb mehr Energie verbrauchen als andere KI-Modelle.

Effizienz alleine reicht nicht

Der Energiehunger von KI wird trotzdem dieser Maßnahmen steigen. Einige Hyperscaler sichern sich deshalb über langlaufende Stromlieferverträge und Standortkäufe gezielt CO₂-arme Kraftwerksleistung, die teils aus Kernenergie stammt. So bindet sich Microsoft über 20 Jahre an Strom aus der Wiederinbetriebnahme des früheren Three-Mile-Island-Blocks (heute Crane Clean Energy Center). Das US-Energieministerium finanziert die Reaktivierung mit 1 Mrd. US-Dollar, der Neustart ist ab 2027 geplant (circa 835 MW).

Meta hat mit Energieunternehmen Constellation einen Vertrag über 20 Jahre für das Clinton Clean Energy Center in Illinois geschlossen. Der Deal stützt den Langzeitbetrieb und umfasst eine Leistungsanhebung um 30 MW ab Juni 2027.

AWS übernahm 2024 für 650 Millionen US-Dollar den Cumulus-Campus direkt am Kernkraftwerk Susquehanna (Entwicklungsziel: 960 MW) – ein Beispiel für Rechenzentren am Kraftwerksstandort.

Fazit

KI ist kein magischer Helfer, sondern eine riesige Maschine im Hintergrund, die Energie benötigt – und zwar nicht wenig. Wer KI nutzt, sollte sich bewusst sein, dass jede Anfrage Energie kostet. Damit KI nicht zum Klimaproblem wird, müssen Effizienz und Nachhaltigkeit zum Standard werden: weniger Ressourcen, mehr Output und ein Strommix, der das Klima nicht weiter belastet. Fortschritte in der Hardware- und Softwareentwicklung bieten neue Möglichkeiten, den Energieverbrauch zu senken. Anwender und Entwickler sollten sich aktiv für energieeffiziente Technologien entscheiden.

Gleichzeitig rückt die Verantwortung der Betreiber in den Fokus: Unternehmen sollten aktiv auf energieeffiziente und netzdienliche Lösungen setzen. Demand-Response-Modelle wie bei Google könnten ein praktikabler Weg sein, den steigenden Energiebedarf zu beherrschen.

Dieser Artikel wurde im Dezember 2025 aktualisiert, um neue Informationen zu berücksichtigen.