stokkete - stock.adobe.com

Wie Objektspeicher immer mehr Anforderungen erfüllen

Fortschritte im Computing und beim Storage erweitern Objektspeicher über das traditionelle HPC und die Cloud hinaus auf neue Anwendungsfälle wie Datenanalysen, ML und Deep Learning.

Objektspeicher ist die neueste der drei primären Speichertechniken und ergänzt Block- und File Storage. Im Zuge technologischer Fortschritte hat Objektspeicher einen Platz mit neuen und anderen Anwendungsfällen jenseits seiner ursprünglichen Stärken gefunden.

Entstanden ist Objektspeicher, als High-Performance-Computing-Anwender in den 1990er Jahren nach skalierbaren Alternativen für ihre massiven Datensätze suchten. So wurde objektbasierte Speicherung mit dem Aufkommen massiv skalierbarer Cloud-Dienste populär. Die Google-Forscher, die mit dem Google File System (GFS) eine der ersten Objektspeicher-Implementierungen entwickelt haben, haben Design-Anforderungen adressiert, die auch nach zwei Jahrzehnten noch existieren.

Ein Objektspeichersystem sollte demzufolge Folgendes leisten:

- Anpassung an häufige Komponentenausfälle bei Speichersystemen, die Hunderte oder Tausende von Knoten benötigen, durch kontinuierliche Überwachung, Fehlererkennung, Fehlertoleranz und automatische Wiederherstellung.

- Massive, Multi-Terabyte große Datensätze und Multi-Gigabyte große Dateien aufnehmen.

- Für Dateien optimiert sein, die überwiegend schreibgeschützt sind, sequentiell gelesen werden, „praktisch keine“ zufälligen Schreibvorgänge aufweisen und neue Daten an die Datei anhängen können, anstatt vorhandene Daten zu überschreiben.

- Ingenieure optimierten frühe Formen des Objektspeichers wie GFS für Online-Dienstanbieter. Doch mit der Zeit nahmen die Speicheranforderungen für Unternehmens-Workloads ähnliche Merkmale an.

Wie sich Objektspeicher verändert

Unternehmen führen nicht nur Cloud-Infrastrukturen und Cloud-native Anwendungsdesigns ein, sondern die folgenden Trends zeigen, dass sich der Datenbestand in Unternehmen in einer Weise entwickelt, die Objektspeicher begünstigt:

- enormes Wachstum der Menge an unstrukturierten Daten wie Text, Bilder, Audio und Video,

- eine ähnliche Zunahme der Menge an semistrukturierten Daten aus Systemprotokollen, E-Mail-Repositorys und getaggten Informationen wie HTML- und JavaScript Object Notation-Dokumenten,

- die Ansammlung riesiger Datenbestände, die Hunderte von Terabytes oder sogar Petabytes umfassen können,

- den gleichzeitigen Speicherzugriff in Echtzeit von Hunderten von Anwendern von verschiedenen Standorten aus,

- die verstärkte Nutzung von Data Lakes oder anderen Techniken, die Daten aus verschiedenen Quellen in unterschiedlichen Formaten aggregieren,

- eine damit einhergehende Entkopplung der Daten von einer bestimmten Anwendung, wobei dasselbe Repository von vielen Workloads genutzt wird.

Jeder dieser Trends beim Enterprise-Storage begünstigt Objektformate gegenüber Block- oder Dateispeichern, da Objektspeicher von Natur aus skalierbar, hochgradig verteilt und effizienter sind – sowohl in Bezug auf den Speicherplatz als auch auf die Kosten – und granulare Sicherheitsrichtlinien mit Zugriffskontrollen ermöglichen, die auf Teilmengen eines Repositorys zugeschnitten sind.

Darüber hinaus fördert die zunehmende Nutzung von Infrastructure-as-a-Service-Ressourcen von AWS, Azure, Google Cloud Platform (GCP) und anderen – wo Objektspeicherdienste die skalierbarste und kostengünstigste Option sind – die Verwendung von On-Premises-Objektspeichern als Teil einer integrierten, hybriden Cloud-Umgebung.

Gründe für die Transformation von Object Storage

Extreme Skalierbarkeit und ein inhärent verteiltes und redundantes System haben High-Performance-Computing- und Cloud-Anwender dazu bewogen, Objektspeicher zu nutzen. Der Kostenvorteil der Technologie gegenüber Datei- und Blockalternativen hat jedoch die Aufmerksamkeit von Unternehmensanwendern und Cloud-Services auf sich gezogen, wobei insbesondere AWS S3 den Anfang gemacht hat.

Als Unternehmen im letzten Jahrzehnt begannen, sich mit Cloud-Diensten zu beschäftigen, suchten sie nach Einsatzmöglichkeiten, die sowohl risikoarm als auch einfach zu implementieren waren: Backup und Archivierung wurden die Antwort und Cloud-Objektspeicher das Mittel der Wahl. Backup und Archivierung wurden zum wichtigsten Anwendungsfall und werden für viele Jahre die wichtigste Unternehmensanwendung für Objektspeicher bleiben.

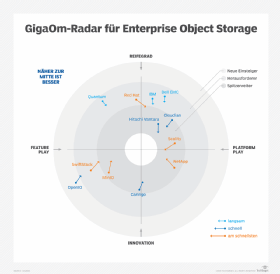

Der Markt für Objektspeicher

Es gibt keine allgemein zugänglichen öffentlichen Messungen zur Größe des Objektspeichermarktes. Einer Schätzung zufolge blieb er mit einem Umsatz von etwa 4 Milliarden US-Dollar in 2020 klein und wächst jährlich um 14 Prozent auf 6 Milliarden US-Dollar im Jahr 2023. Diese Zahlen scheinen viel zu niedrig, wenn man bedenkt, dass EMC bei der Übernahme von Isilon und Atmos vor fast einem Jahrzehnt einen Umsatz von 1 Milliarde US-Dollar bis 2012 vorausgesagt hat. Wie dem auch sei, es besteht kaum ein Zweifel daran, dass Enterprise Object Storage ein weitaus kleinerer Markt bleibt als der für Block- oder Netzwerk-Dateispeicherprodukte.

Die drei großen Cloud-Anbieter - AWS, Azure und Google Cloud - liefern sich sporadische Preiskämpfe für Standarddienste wie Compute-Instanzen und Objektspeicher. Aufgrund von Skaleneffekten ist es für Anbieter von Objektspeichern schwierig, mit den Kosten pro Gigabyte zu konkurrieren, daher haben sie sich eine Seite aus dem Marketing-Einmaleins geholt: Wenn Sie nicht über den Preis konkurrieren können, konzentrieren Sie sich auf Funktionen und Leistung.

Die meisten Unternehmen, die sich auf Objektspeichertechnologie spezialisiert haben, haben erkannt, dass der Versuch, einen Preiskampf mit Amazon oder Google zu gewinnen, für ein kleineres Unternehmen ein aussichtsloses Unterfangen ist, und haben ihren Fokus auf KI, maschinelles Lernen und Big-Data-Analyse-Workloads verlagert, die schnellere E/A und neue, eingebettete Funktionen nutzen können.

In der Tat hat das Billig-Stigma des Begriffs Objektspeicher einige dazu gebracht, die Terminologie zu verschieben, um Datenplattformen, universellen Speicher und verteiltes Datenmanagement zu betonen.

Dennoch müssen diese Anbieter die Dominanz von Cloud-Objektspeicherdiensten, insbesondere S3, bei IT und Entwicklern anerkennen. Folglich ist die Kompatibilität mit der S3-API zur Grundlage geworden, auf der Unternehmen Datenanalysefunktionen hinzufügen.

Moderne Anwendungsfälle für Objektspeicher: Entwicklung, Analytik, KI

Moderne Objektspeicherplattformen sind für mehrere aufkommende Anwendungsfälle konzipiert:

- Data Lakes für Streaming-Daten wie Systemereignisse und Protokolle, Anwendungstelemetrie, Sensormesswerte, Finanztransaktionen, Online-Interaktionen, Social-Media-Aktivitäten und andere Metadaten

- Objektspeicher-Datenbanken für Metadaten, unstrukturierte Inhalte und binäre große Objekte

- Speicher für Big-Data-Analysen mit Software wie Spark, Flink, Hive und ihren kommerziellen Alternativen

- Trainingsdaten für maschinelles und Deep Learning sowie Eingabeströme für Analysen mit zuvor trainierten Modellen

- Repositorys für Suchmaschinen

- Rich-Media-Streaming

- persistente Datenspeicher für Container-basierte und Cloud-native Anwendungen

- Repositorys für Softwareentwicklungsumgebungen, einschließlich Quellcodeverwaltung, Continuous-Integration- und Continuous-Delivery-Pipelines, Issue-Tracking und Dokumentation

Da viele Entwicklungs-Tools netzwerkgebundene File Shares verwenden, sind Objektspeicher auch über NFS- und SMB-Protokolle zugänglich.

Technologische Fortschritte für die Transformation

Objektspeicher profitieren von breiteren Trends in der Rechen- und Speichertechnologie. Hier ist eine Liste der wichtigsten Trends:

- Software-Virtualisierung des Betriebssystems (VM-Instanzen), der Anwendung (Container) und der Speicherressourcen (Software-Defined Storage), die eine Abstraktionsschicht zwischen Hardware-Implementierungen und Anwendungen einfügen. Durch die Entkopplung der Speicherdaten- und Steuerungsebene ermöglicht die Virtualisierung verteilte, skalierbare Cluster beliebiger Größe und Kapazität.

- Enorme Leistungssteigerungen bei Allzweck-CPUs, die in Kombination mit Virtualisierung Clustern aus handelsüblichen Servern die Verwaltung riesiger Speicherkapazitäten ermöglichen.

- Kontinuierlicher Rückgang des Preises pro Byte bei SATA-SSDs und NVMe-Laufwerken, wodurch diese für Objektspeichersysteme mit hoher Kapazität geeignet sind, die massive Kapazität und hohen Durchsatz kombinieren.

- Kommerzialisierung von persistenten Speichertechnologien wie Optane – von Intel und Micron Technology – und magnetoresistivem RAM – von Anbietern wie Everspin Technologies und Avalanche Technology – die eine Lücke zwischen hochdichter, aber relativ langsamen Speicher mit Festplatten oder 3D-NAND-Flash und schnellen, latenzarmen, aber flüchtigen DRAM-Caches schließen.

Die meisten Objektspeicherprodukte enthalten einige, wenn nicht sogar alle, dieser Weiterentwicklungen. Allerdings haben diese Produkte ihre Kernsoftware zur Speichersteuerung in der Regel von älteren, HDD-basierten Systemen übernommen. Ein solches Softwareerbe macht sie suboptimal für KI, maschinelles Lernen und Analyse-Workloads mit einem gemischten E/A-Muster aus zufälligen und sequenziellen Lese- und Schreibvorgängen, die auch eine geringe Latenz und einen hohen Durchsatz erfordern.

Als Antwort auf die Unzulänglichkeiten bestehender Implementierungen haben Intel und andere eine neue Softwareplattform namens Distributed Asynchronous Object Storage entwickelt. DAOS ist ein Open-Source-Projekt zur Entwicklung eines Objektspeichersystems, das die Daten- und Steuerungsebene entkoppelt und gleichzeitig I/O-Metadaten und Indizierungs-Workloads von der Datenmassenspeicherung trennt.

DAOS implementiert leichtgewichtige Protokolle, die für persistente NVMe- und Optane-Speicher entwickelt wurden, und verfügt über eine Messaging-Schnittstelle mit niedriger Latenz und hohem Durchsatz, die das Betriebssystem umgeht. Es speichert Metadaten auf schnellem, persistentem Speicher und Massendaten auf NVMe-SSDs und bietet integrierte Unterstützung für Big-Data-Schnittstellen, einschließlich Hierarchical Data Format Version 5, Apache Arrow und Spark.

Laut Intel skaliert die Lese- und Schreib-I/O-Leistung von DAOS nahezu linear mit einer steigenden Anzahl von Client-I/O-Anfragen – auf etwa 32 bis 64 Remote-Clients – und ist damit gut für die Cloud und andere gemeinsam genutzte Umgebungen geeignet. Der erste bedeutende Produktionseinsatz von DAOS war für den Exascale-Supercomputer Aurora des Argonne National Laboratory des US-Energieministeriums.

Modernste Technologien, vor allem Computational Storage, bei dem kleine, energieeffiziente Prozessoren in einzelne SSDs eingebettet werden, werden irgendwann ihren Weg in Objektspeicherdesigns finden, da die Scale-Out-Natur ideal für die Verteilung der Speicherverarbeitung auf Hunderte von Geräten geeignet ist.

Spezifische Anbieter und Produkte

Zu den wichtigsten Anbietern auf dem Markt für Objektspeicher gehören unter anderem die folgenden.

Caringo Swarm Software und Server. Swarm ist eine softwaredefinierte Objektspeicherplattform, die eine heterogene Systemumgebung unterstützt und einen einheitlichen Namespace bereitstellt, der über NFS, SMB, AWS S3 und die native HTTP-API von Swarm zugänglich ist.

Cloudian HyperStore Objektspeicher stellt eine S3-kompatible API und sowohl NFS- als auch SMB-NAS-Schnittstellen über eine integrierte Software-Hardware-Plattform zur Verfügung, die in drei Produkten von 1U und 168 TB bis zu 4HE und 1,5 Petabyte mit HDDs erhältlich ist.

DataDirect Networks Web Object Scaler ist ein S3-kompatibles Objektsystem, das auf eine Kapazität von einem Petabyte und Billionen von Objekten skaliert.

Dell EMC ECS, früher bekannt als Elastic Cloud Storage, ist eine Reihe von integrierten Hardware-Appliances, die in drei Größen erhältlich sind, von 12 1-TB- bis 8-TB-Laufwerken bis hin zu 90 12-TB-HDDs.

Hitachi Vantara Content Intelligence ist eine Ergänzung zu den Objektspeicherprodukten von Hitachi. Das Produkt bietet Datenverarbeitungs-Workflows und eine Bibliothek von Analyse-, Extraktions-, Transformations- und Berichtsfunktionen, die Anwender auf eingehende Daten anwenden können. Die transformierten und extrahierten Daten können dann an Anwendungen oder ein Storage-Tier zur langfristigen Aufbewahrung weitergeleitet werden.

IBM Red Hat Ceph Storage ist eine Speicherplattform, die S3- und OpenStack-Objekt-APIs sowie Block- (iSCSI) und NFS-Dateiprotokolle unterstützt.

MinIO ist eine quelloffene, Cloud-optimierte Objektsoftware, die die S3-API unterstützt und auf Kubernetes-Clustern läuft. MinIO kann das Hadoop Distributed File System ersetzen und ist für Analytics- und KI-Workloads konzipiert, darunter Spark, Presto, TensorFlow und H2O.ai.

NetApp StorageGrid ist das S3-kompatible Objektprodukt des Unternehmens. NetApp arbeitet jedoch auch mit Nvidia an der NetApp Ontap AI-Plattform, die seine All-Flash-Array (AFA)-Speichersysteme der AFF A-Serie mit Ontap 9 und AI Control Plane-Software mit Nvidias neuen DGX A100 AI-Servern integriert.

Pure Storage FlashBlade AFA bietet Objektspeicher-Software und ein erweiterbares 4U-Gehäuse mit 15 Hot-Plug-fähigen Speichermodulen. Pure arbeitet außerdem mit Nvidia zusammen, um die AIRI AI-Plattform anzubieten, die zwei oder mehr DGX-1- oder -2-Compute-Server mit einem oder zwei FlashBlades und einer konvergenten Ethernet-InfiniBand-Netzwerkstruktur integriert.

Das Qumulo-Dateisystem unterstützt Multi-Cloud-Implementierungen auf allen Qumulo-Storage-Appliances, qualifizierten Drittanbieterprodukten von Hewlett-Packard Enterprise und Fujitsu oder Public-Cloud-Infrastrukturen auf AWS oder Google.

Scality Ring ist eine Software-Storage-Control-Plane im Petabyte-Bereich für x86-Server, die sowohl S3-Objekt- als auch Dateischnittstellen bietet. Die Zenko-Software des Anbieters bietet eine einzige Verwaltungsschnittstelle für Ring und andere Objektplattformen, einschließlich S3, Azure Blob, Google und Ceph.

SwiftStack, von Nvidia übernommen, ist eine Objektspeicher-Software, die richtlinienbasierte Workflows unterstützt, um beispielsweise Metadaten, Labels und Tags hinzuzufügen, die bei der Vorverarbeitung von Daten verwendet werden können, um die Suche und Analyse zu erleichtern. Die 1space-Management-Software von SwiftStack unterstützt mehrere Clouds, während der 1space File Connector einen einheitlichen Namespace in heterogenen Umgebungen bietet.

Vast Data beschreibt seine Scale-Out-Speicherumgebung als universellen Speicher, der als reine Software, als Hybrid aus Hardware und Containersoftware oder als paketierte Hardware-Appliance erhältlich ist. Die hohe I/O-Performance und die NAS-Unterstützung machen Vast Data zum idealen Partner für Machine-Learning- und Deep-Learning-Workloads.

Bewertungskriterien

Bei der Evaluierung von Objektspeicherprodukten sollten Käufer mehrere kritische Faktoren berücksichtigen, da die Stärke in einem Bereich auf Kosten der Schwäche in einem anderen gehen kann.

Dazu gehören Kapazität und Speichereffizienz im Vergleich zur Leistung, Ausfallsicherheit und Redundanz im Vergleich zur Kapazität und Interoperabilität im Vergleich zu proprietären Funktionen wie eingebetteter Unterstützung für KI und Analysefunktionen. Verwaltbarkeit versus Komfort ist ebenfalls wichtig, ebenso wie Sicherheit versus Flexibilität für mehrere Mandanten.

Fortschritte bei der Objektspeicher-Software mit für AFAs optimierten Designs und hybrider HDD/SSD-Hardware haben die Leistung deutlich verbessert, während disaggregierte Steuerungs- und Datenebenen heterogene Bereitstellungen über mehrere Cloud-Umgebungen hinweg ermöglichen. Zusammen haben diese Entwicklungen verteilte, skalierbare Objektsysteme zur führenden Speicherumgebung für neue Datenanalysen, maschinelles Lernen und Deep Learning-Workloads gemacht.

Weiterentwicklungen wie DAOS, Unterstützung für persistenten Speicher und integrierte Datenverarbeitungs-Workflows versprechen noch mehr Leistung und Flexibilität für noch mehr neue Anwendungsfälle für Objektspeicher in der Zukunft.