sakkmesterke - stock.adobe.com

Die Zukunft von Quantenrechenzentren: Resilienz und Risiken

Quantencomputing ergänzt klassische IT, übertrifft sie in Spezialfällen und zwingt Unternehmen dazu, Post-Quantensicherheit konsequent in ihre Strategien und Prozesse einzubinden.

Rechenzentren haben sich von den traditionellen Computing-Räumen (Rechenzentrum, RZ) vergangener Zeiten zu den gigantischen Hyperscaler-Einrichtungen von heute entwickelt. Quantenrechenzentren sind ein weiterer Evolutionsschritt, der auf dieser Geschichte aufbaut und gleichzeitig neue Wege beschreitet.

Ein Quantenrechenzentrum ist eine Einrichtung, die für die Unterbringung von Quantencomputern und die Erfüllung ihrer Anforderungen an Stromversorgung, Kühlung und Workflow-Management gebaut wurde. Einige Zentren sind speziell für Quantensysteme gebaut. In anderen Fällen werden Quantenprozessoren (QPUs) zusammen mit klassischen Computern in High-Performance-Computing-RZs (HPC) untergebracht.

Quantentechnologieanbieter und Forschungseinrichtungen sind die typischen Betreiber von Quantenrechenzentren. Einige wenige große Unternehmen betreiben ebenfalls Quanteneinrichtungen. Die meisten CIOs und CTOs werden jedoch wahrscheinlich über eine Cloud-Schnittstelle auf Quantencomputer zugreifen, die den Zugriff auf den Backend-Quantenprozessor ermöglicht.

Unabhängig von der Zugangsmethode verspricht Quantencomputing, Probleme anzugehen, die mit herkömmlicher IT nicht gelöst werden können. Quantenprozesse, insbesondere Superposition und Verschränkung, bieten die Rechenleistung und Parallelität, die erforderlich sind, um schwierige Probleme in Bereichen wie Simulation und Optimierung zu lösen. Quantenbits – Qubits – dienen als grundlegende Informationseinheit, mit der Quantencomputer eine Vielzahl von Berechnungen durchführen können.

Der wahrgenommene geschäftliche Nutzen des Quantencomputings variiert je nach Branche. Finanzdienstleistungsunternehmen sehen Chancen in Bereichen wie dem Portfoliomanagement. Life-Science-Unternehmen suchen nach Durchbrüchen in der Molekülmodellierung und der Arzneimittelforschung. Andere Unternehmen glauben, dass Quantenrechenzentren Herausforderungen in der Logistik und Lieferkette bewältigen werden.

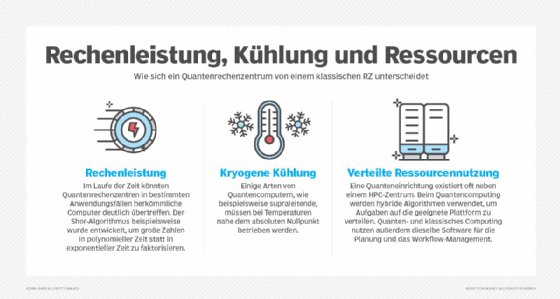

Kernfähigkeiten und Designmerkmale künftiger Quantenrechenzentren

Ein Großteil dieses wahrgenommenen Werts wird sich aus den Fähigkeiten und Merkmalen ergeben, die Quantenrechenzentren versprechen. Diese Zentren erfordern einige exotische Einrichtungen, wie zum Beispiel spezielle Kühlaggregate. In vielen Fällen nutzen Quantenmaschinen jedoch klassische Computerkomponenten. Hier sind einige Merkmale der sich noch in der Entwicklung befindlichen Quantenrechenzentren.

Hybrides Computing

Hybrid Computing ist ein Kernmerkmal vieler Quantenrechenzentren, das wahrscheinlich auch in Zukunft bestehen bleiben wird. Die Koexistenz und Integration von klassischen Computern und Quantenhardware ist eine weit verbreitete Erwartung unter Führungskräften der Branche. Das liegt daran, dass Quantencomputing auf spezielle Aufgaben ausgerichtet ist und klassischen Maschinen reichlich Raum lässt, um Workloads zu bewältigen, die für QPUs ungeeignet sind.

„Wir betrachten Quantencomputing als eine hybride Technologie, die Hand in Hand mit derzeit vorhandenen Computertechnologien wie CPUs und GPUs funktioniert“, sagt Jan Goetz, CEO und Mitbegründer von IQM Quantum Computers, einem Hersteller von supraleitenden Full-Stack-Quantencomputern.

Während IQM Quantenausrüstung in seinen eigenen Rechenzentren betreibt und Rechenzeit als Cloud-Services anbietet, legt das Unternehmen großen Wert auf seine hybriden Implementierungen. So erklärt Goetz, dass ein großer Teil ihres Geschäftsmodells darin besteht, Quantencomputer an Hochleistungsrechenzentren zu verkaufen, wo sie physisch direkt neben den Racks mit CPUs und GPUs stehen.

IBM betreibt ebenfalls eigene Quantenrechenzentren und arbeitet gleichzeitig mit Partnern an quantenklassischen Einrichtungen zusammen. Was Letzteres betrifft, so befindet sich die IBM Quantum System One-Maschine des Unternehmens auf dem Campus des Rensselaer Polytechnic Institute (RPI, New York)) zusammen mit dem Artificial Intelligence Multiprocessing Optimized System der Universität, einem klassischen Supercomputer, der allgemein als AiMOS bezeichnet wird. Die beiden Systeme sind miteinander verbunden, sodass Workloads von einer Maschine zur anderen verschoben werden können.

In ähnlicher Weise hat Riken, ein nationales wissenschaftliches Forschungsinstitut in Japan, ein IBM Quantum System Two mit seinem Fugaku-Supercomputer verbunden.

„Es gibt Problembereiche, in denen klassische Computer besser sind, und Problembereiche, in denen Quantencomputer besser sind“, sagt Oliver Dial, CTO bei IBM Quantum, und verwies auf die einfache Prämisse hinter solchen Verbindungen. „Wenn man ein Problem findet, das man tatsächlich in diese Bereiche unterteilen kann, erhält man am Ende etwas, das wirklich viel besser ist, als es beide alleine heute sein könnten.“

Grad der Integration von Quanten-HPC

Laut Andrea Tabacchini, Vizepräsident für Quantenlösungen bei Quantum Brilliance, gibt es zwei Denkansätze zur Integration von Quanten-HPC: enge und lose Integration.

Eine enge Integration funktioniere wie die GPU-CPU-Integration in derselben Rechnerarchitektur, so Tabacchini. Bei einer losen Integration fungiere ein Quantencomputer eher als eigenständige Ressource. Dieser Ansatz mag für eine bestimmte Aufgabe ausreichend sein, aber Tabacchini hält eine enge Integration für die bessere Option.

Zu diesem Schluss kommt Tabacchini basierend auf den Erfahrungen seines Unternehmens bei der Integration seiner Quantenbeschleuniger im Pawsey Supercomputing Center in Westaustralien. Die Hardware von Quantum Brilliance basiert auf der Stickstoff-Vakanz-Diamant-Technologie.

„Aus Sicht von Quantum Brilliance bedeutet die Integration von QC und HPC eine enge Integration“, betont er. „Dies erfordert eine QPU, die so nah wie möglich an der CPU/GPU platziert werden kann, idealerweise auf demselben Bus.“

Hybride Algorithmen

Mehrere Quantencomputeralgorithmen sind so konzipiert, dass sie Probleme aufteilen und Verarbeitungsaufgaben der geeigneten Plattform zuweisen, sei es Quanten- oder klassische. Durch die Kombination von Quantenmaschinen und Supercomputern, kann man gemeinsame quantenklassische Algorithmen erforschen.

Als Beispiel nent Dial von IBM Quantum den Sample-Based Quantum Diagonalization (SQD)-Algorithmus. Mit SQD identifizieren Quantencomputer die elektronischen Zustände von Molekülen und bestimmen so den Umfang für die Simulation chemischer Probleme auf klassischen Maschinen. Dieser Ansatz ermöglicht es Forschern, das Gleichgewicht zwischen Quanten- und klassischer Rechenleistung für die Lösung spezifischer Probleme zu optimieren. In diesem Zusammenhang bauen die herkömmlichen Maschinen ein Modell aus den verrauschten Ergebnissen des Quantencomputers auf. Durch eine längere Laufzeit auf dem Quantencomputer könnten genügend Daten bereitgestellt werden, um nur die Antworten zu verwenden, die mit größter Sicherheit korrekt sind, was die Belastung für die herkömmliche Maschine verringert.

„Man kann gewissermaßen die Genauigkeit des Quantencomputers gegen die Menge der anschließend durchgeführten klassischen Berechnungen eintauschen“, erklärt Dial. „Es ist spannend, mit dieser Idee zu spielen, klassische und Quantenberechnungen zusammenzuführen und zu sehen, wie man diese am besten miteinander kombinieren kann.“

IQM-CEO Goetz nannte unterdessen den Variational Quantum Eigensolver (VQE) als einen weiteren prominenten hybriden Algorithmus, der in der Chemie verwendet wird. VQE löst den Quantenteil eines bestimmten Moleküls – seine elektronische Struktur – und der klassische Computer führt einen Optimierungsalgorithmus aus, um das Ergebnis zu verfeinern.

Ein weiteres hybrides Beispiel ist der Quantum Approximate Optimization Algorithm (QAOA), der sich auf Optimierungsprobleme wie das Finanzportfoliomanagement konzentriert. Solche Algorithmen sind typisch für die aktuelle Ära des Quantencomputings, die von Führungskräften der Branche als Noisy Intermediate-Scale Quantum (NISQ) bezeichnet wird. In der NISQ-Ära gibt es laut Goetz eine ganze Reihe von Algorithmen, die einen Quantencomputer und einen normalen Computer erfordern.

Stromversorgung, Kühlung und Platzbedarf

Stromversorgung, Kühlung und Platzbedarf stehen bei der Planung von Quantenrechenzentren ganz oben auf der Liste. Wie Unternehmen diese Anforderungen erfüllen, hängt von der Art der Quantencomputer-Hardware ab und davon, ob es sich um ein erweitertes HPC-Zentrum oder eine reine Quantenanlage handelt. Das Quantenrechenzentrum von IBM in Poughkeepsie, New York, fällt in die letztere Kategorie.

„Der Standort in Poughkeepsie ist im Grunde genommen eine reine Quantenanlage“, sagt IBM-Experte Dial. Diese Anlage umfasst mehrere kryogene Kühlaggregate und Quantenmaschinen, die mit den Quantenprozessoren Heron und Eagle von IBM ausgestattet sind. Die Quantencomputer von IBM basieren auf supraleitenden Qubits, die auf nahezu den absoluten Nullpunkt gekühlt werden müssen, um fehlerverursachende Umwelteinflüsse zu minimieren. Die supraleitende Qubit-Technologie ist eine von wenigen Arten des Quantencomputings.

Die Kühlung bringt laut Dial einige Anforderungen an die Einrichtungen mit sich, die normalerweise nicht vorhanden wären. Zudem wies er darauf hin, dass Kühlaggregate gelegentlich routinemäßig gewartet werden müssen. Die Teams, die Quantensysteme verwalten, wechseln beispielsweise einige Teile, die Helium-3 pumpen, ein Heliumisotop, das in Verdünnungskühlern verwendet wird. In gewisser Weise ähnelt dieser Teil eher einer Halbleiterfabrik als einem Rechenzentrum.

Quantenrechenzentren benötigen außerdem Kühlwasser, um Wärme abzuleiten. Laut IQM-Fachmann Goetz verwenden HPC-Zentren bereits wasserbasierte Kühlung, sodass für diese Anforderung keine neue Infrastruktur erforderlich ist. Was den Stromverbrauch angeht, benötigen IQM-Maschinen mehrere zehn Kilowatt, was laut Goetz deutlich weniger ist als der Strombedarf großer Supercomputer. Quantenanbieter sind auch bestrebt, den Platzbedarf in hybriden Rechenzentren zu minimieren. Die Quantenmaschinen von IQM, so Goetz, sind in einem 19-Zoll-Rack-Formfaktor erhältlich, der in Rechenzentren üblich ist.

Quantenrechenzentren in Deutschland: Initiativen und Standorte

Deutschland hat sich in den vergangenen Jahren zu einem wichtigen Standort für den Aufbau von Quantenrechenzentren entwickelt. Dabei verfolgen Industrie, Forschung und Politik unterschiedliche Ansätze, die von Cloud-basierten Quantenservices bis zu hybriden HPC-Integrationen reichen.

IBM betreibt seit 2024 in Ehningen bei Stuttgart das erste europäische Quantenrechenzentrum des Unternehmens. Mehrere Systeme mit über 100 Qubits sollen dort installiert werden und europäischen Kunden über die Cloud zur Verfügung stehen – unter Einhaltung regionaler Datenschutzstandards.

Das Start-up IQM Quantum Computers hat in München ein eigenes Quantenrechenzentrum eröffnet. Zunächst stehen zwei Systeme zur Verfügung, die stundenweise gebucht werden können. Langfristig ist eine Erweiterung auf bis zu zwölf Maschinen geplant. Ziel ist es, Unternehmen und Forschungseinrichtungen einfachen Zugang zu experimentellen Anwendungen zu ermöglichen und Erfahrungen im Betrieb von Quantenhardware zu sammeln.

Ein weiterer Schwerpunkt liegt in Bayern: Das Leibniz-Rechenzentrum (LRZ) in Garching integriert im Rahmen des Projekts Q-Exa einen Quantenprozessor von IQM in seinen Supercomputer SuperMUC-NG. Damit entsteht eine hybride Umgebung, in der klassische und Quantenressourcen gemeinsam genutzt werden können. Mit Euro-Q-Exa ist zudem eine europäische Erweiterung geplant, die Systeme mit bis zu 150 Qubits umfasst.

Auch in Hessen werden Quantenressourcen erprobt. Das Fraunhofer-Zentrum für angewandtes Quantencomputing (ZAQC) arbeitet mit einem IBM Q System One und stellt über eine Web-Plattform Werkzeuge zur Entwicklung und Visualisierung von Quantenalgorithmen bereit.

Darüber hinaus fördert das Bundesforschungsministerium in mehreren Projekten den Aufbau eigener Quantenrechner. Dazu gehört MAQCS, ein Vorhaben von planqc, dem Max-Planck-Institut für Quantenoptik und dem LRZ, das den Bau eines 1000-Qubit-Systems auf Basis neutraler Atome vorsieht. Parallel betreiben das Deutsche Zentrum für Luft- und Raumfahrt (DLR) und NXP in Hamburg ein Innovationszentrum, das auf Ionenfallen-Technologie setzt.

Ein Sonderfall ist das Forschungszentrum Jülich, das neben eigenen Aktivitäten auch ein Quanten-Annealing-System von D-Wave einsetzt. Damit lassen sich Optimierungsaufgaben und Materialsimulationen testen, die sich für Gate-basierte Quantenrechner noch nicht eignen.

Diese Beispiele verdeutlichen: Deutschland verfolgt eine klare Doppelstrategie. Einerseits soll durch Kooperationen mit internationalen Anbietern schneller Zugang zu leistungsfähiger Quantenhardware geschaffen werden. Andererseits investieren Forschungseinrichtungen und Unternehmen in eigene Technologien, um langfristig unabhängige und skalierbare Quantenrechenzentren im Land aufzubauen.

Herausforderungen für Quantenrechenzentren

Fehlerraten, Integrations- und Datenspeicherprobleme gehören zu den Herausforderungen für Quantenrechenzentren. Die Fähigkeit der Branche, diese Probleme zu lösen, wird eine entscheidende Rolle dabei spielen, Quantencomputing für Unternehmenskunden nutzbar zu machen. Im Folgenden beleuchten wir einige der anstehenden Herausforderungen.

Umgang mit Quantenfehlerraten

Der verrauschte (noisy) Aspekt von NISQ bezieht sich auf die Tendenz von Quantenberechnungen, Fehler zu erzeugen, wenn fragile Quantenzustände zusammenbrechen. Quantenmaschinen machen jedoch Fortschritte bei der Fehlerunterdrückung und -minderung. Das längerfristige Ziel der Branche ist die Fehlerkorrektur und Fehlertoleranz. Dieses fortgeschrittenere Stadium erfordert jedoch auch eine Zusammenarbeit zwischen Quanten- und klassischem Computing.

Das Erkennen und Korrigieren von Fehlern in Quantenberechnungen, insbesondere bei einer großen Anzahl von Qubits, erfordert laut Goetz eine Menge Rechenleistung, unabhängig davon, welchen Algorithmus man verwendet. Klassische Computer werden diese Anforderungen erfüllen. Wann immer Fehlerkorrektur im Spiel ist, benötigt man im Backend herkömmliche Rechenleistung.

IBM entwickelt einen fehlerkorrigierenden Decoder, der auf klassischer Datenverarbeitung basiert. Die Decodierungstechnik mit dem Namen Relay-BP kann auf einem Field-Programmable Gate Array (FPGA) oder einem anwendungsspezifischen integrierten Schaltkreis (Application-Specific Integrated Circuit, ASIC) implementiert werden, die IBM als heutzutage allgegenwärtige klassische Komponenten bezeichnet. Das Ergebnis: Laut dem Unternehmen sind für fehlertolerante Quantenberechnungen keine enormen HPC-Leistungen erforderlich.

Integration von Computing-Plattformen

Um die Quanten- und klassischen Bausteine zusammenarbeiten zu lassen, ist eine Integration erforderlich. Derzeit konzentriert sich die Integration der jeweiligen Technologie-Stacks auf Software, was hauptsächlich über APIs geschieht.

Auch Scheduling-Software spielt eine Rolle bei der Harmonisierung hybrider Rechenzentren. Scheduler, wie beispielsweise das einfache Linux-Dienstprogramm für das Ressourcenmanagement (Slurm), verwalten Workloads, die zwischen Quanten- und konventionellen Plattformen verschoben werden. Slurm ist laut Goetz der Standard in HPC-Zentren.

Dial nennt die Verwendung der Scheduling- und Workflow-Management-Tools eines klassischen Supercomputers als eine wichtige Erkenntnis aus der Arbeit von IBM an Standorten wie RPI und Riken. „Es ist wichtig, sich in das bestehende Workflow-Management einbinden zu können, anstatt zu versuchen, eine eigene spezielle Quantenversion nebenbei einzuführen“, sagt er. „Eine unserer Maßnahmen besteht darin, die Art und Weise, wie wir unsere Workflow-Orchestrierung handhaben, umzustellen und uns an branchenübliche Tools wie Slurm anzubinden.“

Streben nach einer höheren Integration

Goetz prognostizierte für die Zukunft eine viel engere Integration von Quanten- und klassischer Technologie, zunächst auf der Softwareseite.

Als einen Schritt in diese Richtung hat IQM im Juli Qrisp, ein Open-Source-Softwareentwicklungs-Kit, als Standard-SDK für seine Resonance-Quantencomputing-Plattform eingeführt. Dieser Schritt trägt zur Integration auf Softwareebene bei, da Qrisp den Datenaustausch zwischen verschiedenen Umgebungen vereinfacht. Mit Qrisp kann IQM eine offene und modulare Plattform aufbauen, die Entwickler für die Integration nutzen können.

Auch die Hardware-Integration steht bevor. Der IQM-CEO wies auf die Möglichkeit einer direkten Verbindung mit geringer Latenz zwischen den Grafikkarten in einem GPU-Cluster und einem Quantenprozessor hin. Er betont, dass Forschungs- und Entwicklungsprojekte dieses Ziel bereits verfolgen.

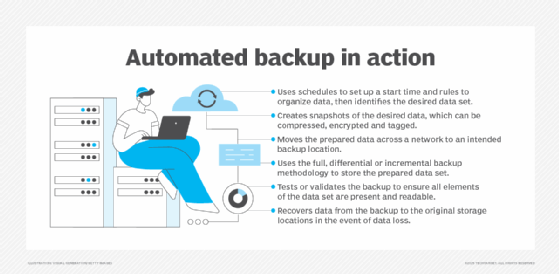

Bereitstellung von Ressourcen für Storage und Datenverwaltung

Quantencomputern fehlen eigene Speichersubsysteme. Eine Quantenmaschine fungiert als Echtzeit-Verarbeitungseinheit, durch die Daten fließen und dann an einen herkömmlichen Computer weitergeleitet werden. An diesem Punkt können jedoch die Datenverarbeitungsressourcen des HPC-Zentrums übernehmen und Primärspeicher, Backup und Datenmanagement bereitstellen. Was das Datenmanagement und die Datenspeicherung angeht muss laut Goetz lediglich alles mit dem Quantencomputer verbunden werden.“

Wie Quanten-Rechenzentren Backup und Recovery revolutionieren könnten

Die Anzahl der Quantenrechenzentren ist relativ gering und beschränkt sich weitgehend auf Technologieanbieter, Universitäten, Forschungseinrichtungen und Regierungsbehörden. In naher Zukunft werden die meisten Unternehmen Quantenrechenzentren in erster Linie über On-Demand-Dienste für spezielle Anwendungsfälle nutzen. Diese Unternehmen profitieren zwar von einer neuen Quelle für Rechenleistung, sind aber auch einer Cybersicherheitsbedrohung ausgesetzt, die ihre Backup-Daten angreifen und die Wiederherstellung (Data Recovery) behindern könnte.

Angreifer, insbesondere solche mit staatlicher Unterstützung, könnten Quantencomputer einsetzen, um klassische Verschlüsselungsalgorithmen zu knacken, die Daten seit Jahrzehnten schützen. Quantencomputer, die dazu in der Lage sind, gibt es zwar noch nicht, aber ihre Einführung scheint innerhalb der nächsten Jahre wahrscheinlich. In der Zwischenzeit sind Unternehmen sogenannten Harvest-Now-Decrypt-Later-Angriffen (zu deutsch: Ernte jetzt, entschlüssele später) ausgesetzt, bei denen Daten gestohlen und bis zum Q-Day gespeichert werden – dem Zeitpunkt, an dem Quantencomputer in der Lage sind, Verschlüsselungen zu knacken.

„Gespeicherte Backups, die mit veralteten Algorithmen verschlüsselt sind, würden sofort zum Ziel von Angreifern werden, die eine Harvest-Now-Decrypt-Later-Strategie verfolgen“, erklärt John Young, COO von Quantum eMotion America, der US-Tochtergesellschaft der in Montreal ansässigen Quantum eMotion Corporation. Das Unternehmen ist auf quantensichere Hardware und Software spezialisiert.

Young merkt an, dass auch Systeme mit Multifaktor-Authentifizierung (MFA) und Identitäts- und Zugriffsmanagementprozessen (IAM) gefährdet sein könnten, wenn sie auf Kryptografie basieren, die anfällig für Quantenbedrohungen ist. Ein Angreifer, der sich als Backup-Administrator ausgibt, könnte Wiederherstellungsvorgänge stören, auf sensible Daten zugreifen oder Datensätze manipulieren.

Wie man heute eine Post-Quanten-Backup-Strategie aufbaut

Unternehmen können mehrere Maßnahmen ergreifen, um sich aus Sicht der Datensicherung und -wiederherstellung auf die Post-Quanten-Sicherheit vorzubereiten.

1. Mehr Aufmerksamkeit für Datensicherungsstrategien

Viele Unternehmen schenken laut Young herkömmlichen Backups nicht genügend Aufmerksamkeit, geschweige denn einem Post-Quanten-Backup-Plan. Daher sollte der erste Schritt darin bestehen, eine starke Backup- und Recovery-Strategie zu entwickeln. Unternehmen sollten auch sicherstellen, dass Backup-Richtlinien klar definiert sind und die für Backups verantwortlichen Mitarbeiter diese Richtlinien kennen. Die Wiederherstellung von gesicherten Daten muss zudem regelmäßig getestet werden.

2. Evaluierung der IT-Umgebung und Risikobewertung

In dieser Phase werden Daten ermittelt, inventarisiert und mit der richtigen Sicherheitsklassifizierung versehen. Vertrauliche Daten wie geistiges Eigentum, Kundendaten und Mitarbeiterinformationen sollten eine Sicherheitsklassifizierung erhalten, die ihre Bedeutung im Vergleich beispielsweise zu einer alten Verkaufstrainingsdemo, die bereits im Internet verfügbar ist, berücksichtigt.

Bei der Inventarisierung wird auch dokumentiert, wie Daten derzeit verschlüsselt sind, und bewertet, ob diese Methoden post-quantentauglich sind oder anfällig für Angriffe. Die Bestandsaufnahme der kryptografischen Systeme wird als kryptografische Stückliste (Cryptographic Bill of Materials) bezeichnet. Insgesamt kann der Bewertungs-Workflow Zeit, technisches Wissen und Transparenz erfordern.

3. Priorisieren Sie die wichtigsten Schwachstellen für die Behebung

Niemand kann mit Sicherheit sagen, wann der Q-Day kommen wird. Die aktuellen Schätzungen liegen im Zeitraum 2029-2030, obwohl ein baldiger technischer Durchbruch den Beginn beschleunigen könnte. Cybersicherheitsexperten gehen davon aus, dass die Umstellung auf Post-Quanten-Kryptografie mehrere Jahre dauern wird, und verweisen dabei auf den Übergang vom SHA-1- zum SHA-2-Algorithmus, der sieben oder mehr Jahre in Anspruch genommen hat.

Unternehmen, die noch keine Post-Quanten-Backup-Strategie eingeführt haben, werden es schwer haben, ihre Arbeit abzuschließen, bevor die Quantenbedrohung eintritt. Daher ist es von entscheidender Bedeutung, die sensibelsten Daten und die größten Schwachstellen zu priorisieren.

Ein Mosca-Score, der auf dem von der Kryptografie-Expertin Michele Mosca entwickelten Theorem basiert, kann bei der Priorisierung helfen. Der Score berücksichtigt, wie lange ein Kunde benötigen wird, um anfällige Algorithmen zu beheben, im Verhältnis zum voraussichtlichen Zeitpunkt der Einführung ausreichend leistungsfähiger Quantencomputer. Unternehmen sollten auch eine Air-Gap-Lösung für ihre sensibelsten Daten in Betracht ziehen. Diese Daten offline zu halten, schütze vor Ransomware und Taktiken, bei denen Daten zunächst gesammelt und später entschlüsselt werden.

4. Identifizieren und bewerten Sie Backup-Anbieter

Unternehmen sollten die Anbieter in ihrem Backup- und Wiederherstellungs-Ökosystem identifizieren, einschließlich Hardware, Software und Offsite-Speicher. Zu den wichtigsten Überlegungen gehöre, ob Backups intern oder automatisiert und Remote von einem MSP (Managed Service Provider) durchgeführt werden. Es kann sich als schwierig erweisen, die Post-Quanten-Bereitschaft von Backup-Anbietern zu durchschauen.

5. Aktualisieren Sie Ihre Business-Continuity- und Disaster-Recovery-Pläne

BC/DR-Pläne sollten überarbeitet werden, um den Post-Quantum-bezogenen Geschäftsrisiken Rechnung zu tragen. „Dies ist ein weiterer Bereich, in dem viele Unternehmen improvisieren“, meint Young. Solche Unternehmen überprüfen ihre BC/DR-Pläne möglicherweise nur alle paar Jahre. „Das kann nicht nur ein Häkchen auf der Aufgabenliste eines Managers sein“, betont der Experte von Quantum eMotion. „Dies erfordert erhebliche Anstrengungen, nicht nur um die Planung korrekt durchzuführen, sondern auch um bei Bedarf Tests, Wartungsarbeiten und Aktualisierungen durchzuführen.“

6. Langfristige Perspektive einnehmen

IT-Manager sollten die Quantensicherheit als eine unmittelbare und dauerhafte Herausforderung betrachten. Ein Großteil unserer sensiblen Daten muss über Jahre hinweg aufbewahrt werden, während einige sogar jahrzehntelang vorgehalten werden. Dies ist eine enorme organisatorische Verantwortung, die Architekten dazu zwingt, langfristige Post-Quanten-Bedrohungen zu planen beziehungsweise sich darauf vorzubereiten.

Quantenrechenzentren: Das Wichtigste auf einen Blick

Definition: Spezialisierte Einrichtungen für Quantencomputer, mit Anforderungen an Strom, Kühlung und Workflow-Management.

Hybrid-Ansatz: Kombination von Quanten- und klassischen HPC-Systemen bleibt zentral, um Workloads optimal zu verteilen.

Algorithmen: Hybride Verfahren wie VQE, QAOA oder SQD verknüpfen Quanten- und klassische Rechenleistung.

Infrastruktur: Kryotechnik, Kühlwasser und platzoptimierte Formfaktoren sind entscheidend; Strombedarf geringer als bei klassischen Supercomputern. Zudem werden Speicherressourcen erforderlich.

Deutschland: Initiativen gibt es in Ehningen (IBM), München (IQM), Garching (LRZ/Q-Exa), Hessen (Fraunhofer ZAQC), Hamburg (DLR/NXP) und Jülich (D-Wave).

Nutzen: Anwendungspotenzial liegt unter anderem in Finanzwesen, Logistik, Life Sciences und Materialwissenschaften.

Herausforderungen: Fehlerraten, Integration, Datenmanagement, Storage und die Vorbereitung auf Post-Quanten-Sicherheit.

Sicherheit: CIOs und CTOs müssen Strategien für Backups, Verschlüsselung und BC/DR-Pläne an die Quantenära anpassen.