your123 - stock.adobe.com

Data Lake: Design, Einsatz und Limits datenzentrierter Speicher

Als speicherzentrierte Architektur trennen Data Lakes Storage und Compute, ermöglichen flexible Datenverarbeitung und unterstützen Machine Learning, Analytics und Archivierung.

Data Lakes bilden eine speicherzentrierte Datenarchitektur, die große Datenmengen unabhängig von Struktur, Herkunft und Format in ihrem nativen Zustand aufnimmt. Im Unterschied zu klassischen Data-Warehouse-Systemen erfolgt keine vorgelagerte Modellierung. Die in einem Data Lake abgelegten Daten unterliegen dem Prinzip Schema-on-Read, wodurch Struktur, Semantik und Typisierung erst zum Zeitpunkt der Analyse festgelegt werden. Diese Eigenschaft macht Data Lakes zu einem zentralen Baustein moderner Datenplattformen, in denen unstrukturierte, semistrukturierte und strukturierte Daten parallel genutzt werden. Technisch basieren Data Lakes heute überwiegend auf skalierbarem Objektspeicher, der lokal oder Cloud-basiert betrieben wird und Storage sowie Compute konsequent voneinander trennt.

Vorteile und Grenzen der speicherzentrierten Architektur

Die Trennung von Storage und Compute erlaubt eine unabhängige Skalierung von Speicher und Rechenleistung und senkt die Einstiegskosten bei stark wachsenden Datenvolumina. Rohdaten bleiben unverändert verfügbar und unterstützen flexible Analysepfade sowie wiederholbare ML-Trainings. Gleichzeitig erhöht Schema-on-Read die Komplexität bei Governance, Datenqualität und Zugriffskontrolle, da Struktur und Semantik erst zur Laufzeit definiert werden. Ohne Metadatenmanagement, geeignete Dateiformate und Abfrageoptimierung steigen Latenzen und Betriebskosten. Die Architektur verlangt daher konsequente Katalogisierung, Sicherheitsmechanismen und Kostenkontrolle, um langfristig nutzbar zu bleiben.

Machine Learning als primärer Treiber

Der stärkste Impuls für die Verbreitung von Data Lakes resultiert aus Anforderungen des Machine Learning (ML). Lernverfahren benötigen große Mengen heterogener Trainingsdaten, die häufig aus Text, Logfiles, Sensormessungen, Bildern, Audiodaten oder Transaktionsströmen bestehen. Data Lakes ermöglichen die verlustfreie Ablage dieser Daten ohne vorherige Selektion oder Normalisierung. Modelle greifen direkt auf Rohdaten zu, wodurch Feature Engineering, Re-Training und experimentelle Modellvarianten ohne strukturelle Einschränkungen möglich bleiben. Für verteilte Trainingsprozesse kommen Rechen-Frameworks zum Einsatz, die parallel auf den Data Lake zugreifen. Apache Spark wird hier oft für skalierbare Vorverarbeitung, Feature-Berechnung und Modell-Pipelines genutzt. Ergänzend integrieren viele Plattformen MLOps-Komponenten zur Versionsverwaltung von Trainingsdaten, Modellen und Metadaten.

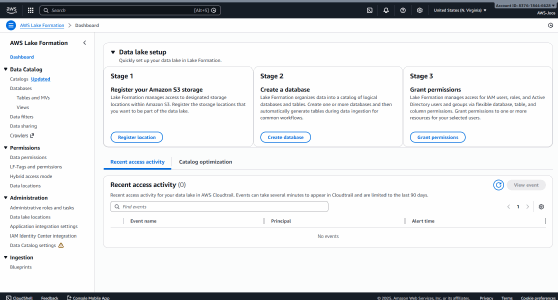

Databricks Lakehouse ergänzt Spark um Delta-Lake-Funktionen und fügt ACID-Transaktionen, Versionsverwaltung und optimierte Zugriffsstrukturen direkt auf dem Objektspeicher hinzu, was reproduzierbare ML-Pipelines und stabile Feature-Daten begünstigt. Snowflake Data Cloud bindet Data-Lake-Daten über externe Tabellen ein und ermöglicht analytische Workloads mit konsistenter Performance, wenn strukturierte und semistrukturierte Daten gemeinsam ausgewertet werden. Für hybride Szenarien adressiert die Cloudera Data Platform Data Lakes auf Basis des Hadoop-Ökosystems und integriert Sicherheits- und Governance-Funktionen für regulierte Umgebungen. Cloud-native Stacks auf Basis von Amazon S3 mit AWS Lake Formation oder Azure Data Lake Storage Gen2 ergänzen den reinen Speicher um Katalogisierung, Zugriffskontrolle und serverlose Abfrageoptionen. Diese Lösungen können Rohdatenflexibilität des Data Lakes mit Stabilität, Governance und reproduzierbaren Analyseprozessen verbinden und damit den Übergang von experimentellen ML-Workloads in den produktiven Betrieb unterstützen.

Weitere Einsatzgebiete jenseits von Machine Learning

Neben Machine Learning dienen Data Lakes als Fundament für Big-Data-Analysen, IoT-Datenhaltung, Log- und Ereignisanalyse sowie Langzeitarchivierung. In IoT-Szenarien treffen kontinuierliche Messwerte aus Sensoren in hoher Frequenz ein. Data Lakes nehmen diese Datenströme unverändert auf und erlauben eine spätere Korrelation mit historischen Datenbeständen. In der Sicherheitsanalyse und Observability fungieren Data Lakes als kosteneffiziente Ablage für umfangreiche Logdaten, die für forensische Analysen oder Mustererkennung herangezogen werden. Für Compliance-Anforderungen eignen sich Data Lakes mit entsprechender Konfiguration (WORM, Immutability) zur revisionssicheren Archivierung großer Datenhistorien, da kostengünstige Storage-Tiers eine langfristige Aufbewahrung erlauben, ohne operative Systeme zu belasten.

Architekturprinzipien moderner Data Lakes

Die Architektur moderner Data Lakes folgt einem mehrschichtigen Aufbau. Eine Ingestion-Ebene übernimmt die Aufnahme von Daten aus Datenbanken, Anwendungen, Streaming-Systemen und Geräten. Sowohl Batch- als auch Streaming-Verfahren kommen zum Einsatz. Der Storage-Layer speichert die Daten unverändert und skaliert horizontal. Darüber liegt eine Verarbeitungsebene, die analytische Workloads, Machine-Learning-Pipelines und Transformationsprozesse ausführt. Eine Metadaten- und Governance-Schicht ergänzt diese Struktur um Katalogisierung, Datenklassifikation, Zugriffssteuerung und Data Lineage. In Cloud-Umgebungen erfolgt die Transformation häufig nach dem ELT-Prinzip, wodurch Daten erst nach der Ablage verarbeitet werden. Diese Trennung senkt Einstiegshürden und erhöht die Flexibilität bei der Datennutzung.

Governance, Qualität und betriebliche Herausforderungen

Die Offenheit von Data Lakes erfordert ein stringentes Governance-Modell. Ohne Metadatenmanagement, Datenklassifikation und Zugriffskontrolle verlieren Datenbestände an Nutzbarkeit. Unzureichend gepflegte Data Lakes entwickeln sich zu schwer durchsuchbaren Datensammlungen mit eingeschränktem Mehrwert. Ergänzend stellen Datenqualität, Formatvielfalt und Performance zentrale Herausforderungen dar. Abfragen auf nicht optimierten Rohdaten verursachen hohe Latenzen, sofern keine Partitionierung, geeignete Dateiformate oder Caching-Mechanismen eingesetzt werden. Sicherheitsanforderungen erfordern rollenbasierte Zugriffskontrolle (RBAC), Verschlüsselung und Auditierbarkeit, da sensible Daten aus unterschiedlichen Fachdomänen in einem gemeinsamen Speicher liegen. Wirtschaftlich stehen Organisationen vor der Aufgabe, On-Premises-Investitionen gegen variable Cloud-Kosten abzuwägen und unkontrolliertes Ressourcenwachstum zu vermeiden.

Cloud-basierte und lokale Plattformen

In Cloud-Umgebungen bildet Amazon S3 als Objektspeicher die Grundlage vieler Data-Lake-Implementierungen in Verbindung mit AWS Lake Formation. Ergänzend ermöglichen Amazon Athena und Amazon EMR analytische Abfragen und verteilte Verarbeitungsprozesse direkt auf den gespeicherten Daten. Microsoft positioniert Azure Data Lake Storage Gen2 als integralen Bestandteil seines Analytics-Stacks mit enger Verzahnung zu Azure Databricks und Azure Synapse Analytics. Google Cloud Storage dient als Speicherbasis für Data Lakes innerhalb der Google Cloud und wird durch BigLake um eine einheitliche Governance- und Abfrageschicht erweitert, die auch Multi-Cloud-Szenarien unterstützt.

Databricks Lakehouse kombiniert Data-Lake-Speicher mit transaktionalen Eigenschaften durch Delta Lake und adressiert gezielt Machine-Learning- und Data-Science-Workloads. Für hybride und lokale Szenarien bietet sich die Cloudera Data Platform als Plattform auf Basis des Hadoop-Ökosystems. Apache Hadoop bleibt vor allem in bestehenden Installationen als Open-Source-Grundlage für eigenbetriebene Data Lakes relevant, erfordert jedoch erheblichen Betriebsaufwand.

IBM adressiert Data-Lake- und Lakehouse-Szenarien mit IBM Cloud Object Storage und IBM watsonx.data.

Integration und Datenmanagement

Für die Integration heterogener Datenquellen spielen Datenintegrations- und Governance-Werkzeuge eine zentrale Rolle. Talend Data Fabric unterstützt Datenintegration, Datenqualität und Governance entlang des gesamten Datenlebenszyklus und ergänzt Data-Lake-Architekturen um konsistente Datenflüsse. Stitch stellt verwaltete Pipelines für analytische Workloads bereit. In Observability- und Sicherheitskontexten fungieren Plattformen wie Splunk als vorgelagerte Analyse- und Erfassungsschicht, deren Datenbestände langfristig in Data Lakes überführt werden.

Einordnung gegenüber Data Warehouses und Lakehouses

Data Lakes unterscheiden sich grundlegend von Data Warehouses, die auf strukturierte Daten, vordefinierte Schemata und wiederkehrende Abfragen ausgelegt sind. Data Warehouses liefern hohe Abfrage-Performance und stabile Datenmodelle für Business Intelligence (BI) und Reporting, Data Lakes ermöglichen explorative Analysen und datengetriebene Experimente. Lakehouse-Architekturen versuchen beide Konzepte zu vereinen, indem sie Data-Lake-Speicher mit Warehouse-nahen Analysefunktionen kombinieren. In der Praxis ergeben sich hybride Architekturen, in denen Data Lakes als Rohdatenbasis dienen und kuratierte Daten in analytische Systeme überführt werden.

Data Lakes entwickeln sich zu zentralen Knotenpunkten in vielen Datenlandschaften. Ihr Wert liegt weniger im Speicher selbst als in der Fähigkeit, Daten langfristig nutzbar zu halten und neue Analyseformen zu unterstützen. Machine Learning, generative KI (GenAI), Echtzeitanalysen und domänenübergreifende Datenintegration bauen auf dieser Flexibilität auf. Voraussetzung bleibt eine technisch saubere Architektur mit klaren Governance-Regeln, performanter Verarbeitung und kontrollierten Kostenstrukturen. In diesem Rahmen bilden Data Lakes eine tragfähige Grundlage für datengetriebene Entscheidungen und fortschrittliche Analytik in Unternehmen.