Laurent - stock.adobe.com

Managementplattform für KI-gestützte NAS-Anwendungen

Mit der AI Console bringt Synology erstmals ein zentrales Steuerwerkzeug für KI in DSM. Unternehmen können externe Dienste kontrolliert, nachvollziehbar und sicher integrieren.

Wer DSM 7.2 produktiv nutzt, erhält mit der AI Console ein Verwaltungs-Tool, das sich in die Synology-Systemarchitektur einfügt und externe KI-Funktionalität im Netzwerk kontrollierbar macht. Statt proprietärer Modelle setzt Synology auf API-Konnektoren zu OpenAI, Azure OpenAI, Google Vertex AI, Amazon Bedrock oder Baidu AI Cloud. Die zentrale Logik ist klar: die Modelle bleiben außerhalb, die Kontrolle bleibt lokal.

Installation und Beta-Hinweise

Das AI Console Paket befindet sich derzeit in der öffentlichen Beta-Phase (Stand Juli 2025) und steht im Paket-Zentrum unter Beta-Pakete zum Test bereit. Das Paket lässt sich ausschließlich auf Geräten mit DSM 7.2 oder höher installieren. Die Nutzung erfolgt ausdrücklich zu Evaluierungszwecken, produktive Umgebungen werden noch nicht unterstützt, ließen sich aber theoretisch betreiben.

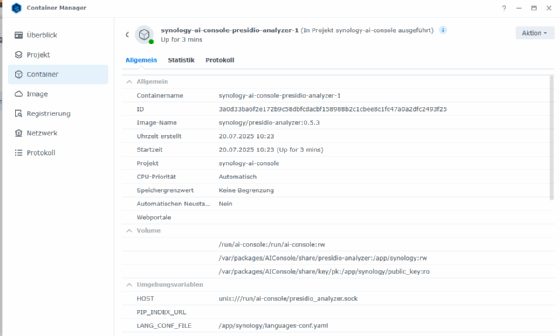

Die AI Console kann nur auf Systemen mit x86-64-Architektur und mindestens acht Gigabyte Arbeitsspeicher betrieben werden. Unterstützt werden zahlreiche Modelle der Plus-, XS- und FS-Serien ab Baujahr 2016. Die Installation erfordert zusätzlich das Paket Container Manager, das für die Verarbeitung von Sprachmodellen und die De-Identifikation zuständig ist. Systeme mit ARM-Architektur oder reduzierter Speicherausstattung sind ausgeschlossen.

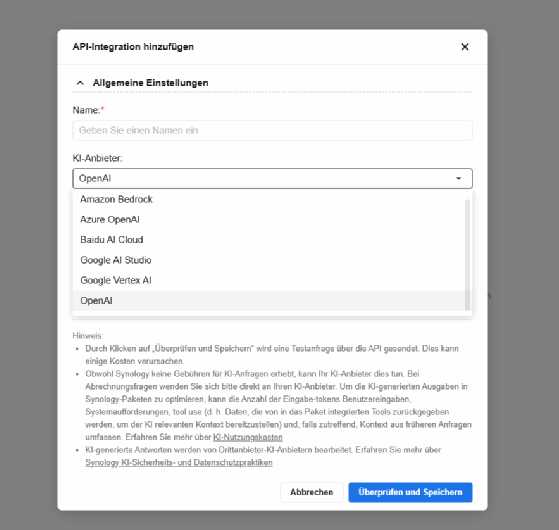

API-Integration externer KI-Anbieter

Im Zentrum steht die Möglichkeit, Schnittstellen zu externen generativen Modellen herzustellen. Unterstützt werden unter anderem OpenAI, Azure OpenAI, Google Vertex AI, Amazon Bedrock und Baidu AI Cloud. Die Einrichtung erfolgt über ein geführtes Formular in der AI Console.

Administratoren vergeben einen Namen, wählen den Anbieter, hinterlegen den API-Schlüssel und definieren das gewünschte Modell. Über die Seite Überblick lassen sich bestehende Integrationen samt Status, Anbieterzuordnung und Paketverknüpfung jederzeit einsehen. Erweiterte Optionen wie benutzerdefinierte Basis-URLs und Token-Limits pro Benutzer oder Zeiteinheit stehen ebenfalls zur Verfügung. Die Konsole prüft neue Integrationen automatisch durch eine Testanfrage, die beim Anbieter zu Gebühren führen kann. Synology selbst erhebt keine Kosten für Anfragen.

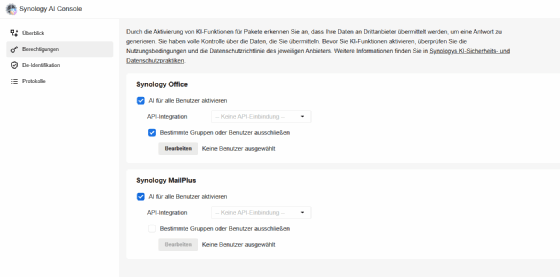

Berechtigungsverwaltung auf Anwendungsebene

Nach erfolgreicher Anbindung eines Dienstes können Administratoren festlegen, welche Pakete die KI-Funktionalität nutzen dürfen. Innerhalb der AI Console lassen sich Rechte auf Benutzer- und Gruppenebene steuern. Es besteht die Möglichkeit, KI global für ein Paket freizugeben oder selektiv einzelne Gruppen auszuschließen. Wenn ein Synology-NAS an Active Directory angebunden ist, lassen sich hier auch Gruppen aus dem Active Directory nutzen. Die Zuweisung erfolgt über ein Drop-down-Menü, das alle eingerichteten API-Integrationen aufführt.

Derzeit stehen Funktionen für MailPlus und Synology Office zur Verfügung. In MailPlus lassen sich lange Nachrichten automatisch zusammenfassen, übersetzen oder neu formulieren. Die Textgenerierung unterstützt verschiedene Tonlagen für professionelle E-Mail-Kommunikation. In Office sind perspektivisch Funktionen zum automatischen Schreiben, Gliedern und Umformulieren vorgesehen. Der Funktionsumfang soll auf Dokumente, Präsentationen und Tabellen ausgeweitet werden.

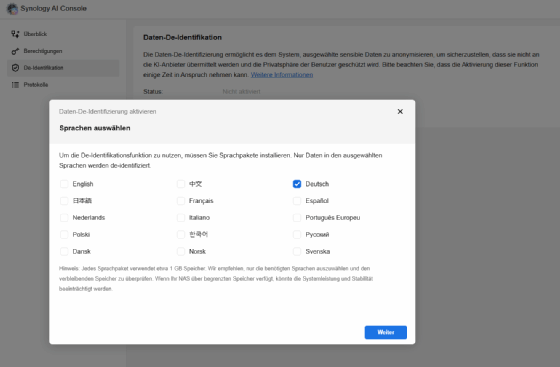

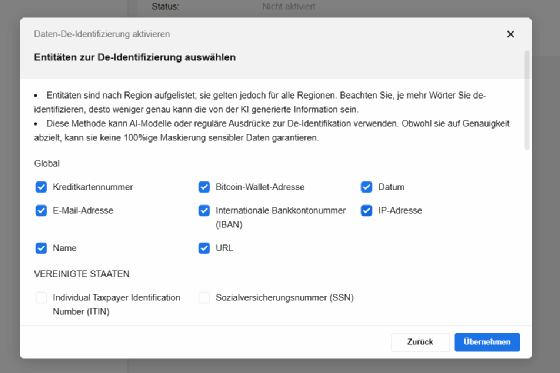

Datenschutz durch lokale De-Identifikation

Ein wesentliches Merkmal der AI Console ist die Fähigkeit zur Anonymisierung sensibler Daten. Bevor Prompts an einen externen Dienst gesendet werden, prüft das System lokal den Textinhalt und ersetzt identifizierbare Entitäten wie Namen, Adressen oder Nummern durch Platzhalter. Diese Funktion steht nur auf Systemen mit mindestens acht Gigabyte RAM zur Verfügung. Administratoren müssen den Container Manager installiert haben und eine Sprachauswahl treffen.

Jedes Sprachpaket belegt rund ein Gigabyte Speicher. Die Maskierung basiert auf regulären Ausdrücken oder vortrainierten Erkennungsmodellen. Die De-Identifikation lässt sich auf der Konfigurationsseite des Dienstes aktivieren. Dort können Sprachen ausgewählt und zu maskierende Entitäten definiert werden. Für Testzwecke bietet die Konsole einen Bereich zur Eingabe von Beispielsätzen.

Nach Erhalt der KI-Antwort werden die Originalinformationen lokal wiederhergestellt. Synology weist darauf hin, dass keine vollständige Maskierungsgenauigkeit garantiert werden kann und der Schutz sensibler Inhalte durch bewusste Auswahl der Filterlogik abgesichert werden sollte.

Für Administratoren, die die De-Identifikationsfunktionen in produktionsnahen Umgebungen testen möchten, bietet die AI Console eine dedizierte Eingabemaske zur Echtzeitprüfung. Dort lassen sich Beispieltexte eingeben, anhand derer das System sofort anzeigt, welche Entitäten erkannt und maskiert würden. Diese Vorschau erleichtert die Kalibrierung von Regeln und ermöglicht eine abschnittsweise Optimierung der Filterlogik, bevor Daten an den KI-Anbieter übermittelt werden.

Besonders in regulierten Branchen oder bei personenbezogenen Informationen (PII) erlaubt dieser Mechanismus eine absicherbare Testschleife. Administratoren können mit minimalem Risiko evaluieren, wie sich Maskierungsstärke, Sprachpaketwahl oder Entitätendefinition konkret auf die Antwortqualität der KI auswirken. Der lokale Testbereich ersetzt keine Auditfunktion, bildet jedoch ein praxisnahes Werkzeug zur Feinjustierung in sensiblen Unternehmenskontexten.

Token-Kontrolle und Budgetverwaltung

Alle KI-Anfragen werden detailliert gezählt. Die Eingabe-Token umfassen Benutzereingaben, System-Prompts, Kontextinformationen aus vorangegangenen Dialogen sowie Rückgaben aus intern verknüpften Tools. Für jeden Zugriff lässt sich nachvollziehen, wie viele Tokens verbraucht wurden. Administratoren können Token-Limits pro Minute oder Tag setzen. Diese Beschränkungen helfen dabei, das Budget planbar zu halten und einzelne Benutzer nicht unbeabsichtigt zu überlasten. Die Begrenzungen werden täglich zurückgesetzt. Änderungen an den Limits beeinflussen den aktuellen Zählerstand nicht. Die Messung der AI Console kann geringfügig von der Abrechnung des jeweiligen KI-Anbieters abweichen, die für die tatsächlichen Kosten maßgeblich ist.

Alle Aktivitäten in der AI Console werden lückenlos dokumentiert. Im Transaktionsprotokoll erscheinen Datum, Uhrzeit, IP-Adresse, verwendetes Paket, API-Dienst, Status der Anfrage sowie auf Wunsch auch Eingabe- und Ausgabetexte. Die vollständige Erfassung lässt sich über die erweiterten Einstellungen aktivieren. Das Admin-Log zeichnet sämtliche Änderungen an API-Integrationen, Rechtezuweisungen und Systemeinstellungen mit Zeitstempel und Benutzerkennung auf. Beide Protokolle lassen sich exportieren. Unterstützt werden CSV, Excel und JSON. Die Protokolldateien verbleiben ausschließlich auf dem lokalen NAS. Synology oder Dritte haben ohne Zustimmung keinen Zugriff auf diese Daten.

Nutzung interner Datenquellen

Eine optionale Erweiterung besteht in der Nutzung von Synology Drive als kontextuelle Datenquelle. Damit lassen sich KI-Antworten mit internen Dateiinhalten anreichern. Dieses Feature ist angekündigt, aber noch nicht allgemein verfügbar. Der KI-Dienst erhält Zugriff auf zuvor definierte Informationen und generiert Antworten mit höherem Bezug zur realen Arbeitsumgebung.

Integration in die Synology Office Suite und Positionierung im Produktportfolio

Die AI Console ist nicht als Einzelfunktion zu verstehen, sondern als strategischer Bestandteil der erweiterten Synology Office Suite. Sie richtet sich explizit an IT-Teams, die KI-gesteuerte Produktivität in einer privaten Cloud-Umgebung umsetzen wollen. Der Fokus liegt auf einer flexiblen und dennoch vollständig kontrollierten Bereitstellung generativer Intelligenz in internen Arbeitsprozessen. Synology gibt bekannt, dass keine Zusatzkosten für die Nutzung der KI-Schnittstellen anfallen, solange der API-Anbieter selbst keine Gebühren erhebt. Gleichzeitig bewirbt der Hersteller eine hundertprozentige Wahrung der Datenhoheit. Der KI-Dienst verarbeitet ausschließlich temporär übermittelte, anonymisierte Inhalte. Eine Verwendung der Informationen zu Trainingszwecken ist ausgeschlossen. Der Zugang zu sensiblen Firmendaten bleibt damit vollständig in der Hand des Betreibers.

Synology verspricht eine klare Trennung zwischen Nutzdaten und Anbieterzugriff. Es findet keine Trainingsnutzung der Inhalte statt. Jede Verarbeitung erfolgt temporär und ausschließlich im Rahmen der Anfrage. Synology dokumentiert in den eigenen Datenschutzrichtlinien, dass alle Prozesse regulatorischen Anforderungen entsprechen. Sensible Inhalte verlassen laut Synology niemals das lokale System, ohne vorher de-identifiziert worden zu sein. Protokolle bleiben vollständig in der Kontrolle des Administrators.

Perspektiven und betrieblicher Nutzen

Die AI Console verfolgt einen pragmatischen Ansatz für Unternehmen, die externe KI-Dienste nutzen wollen, ohne Kontrolle und Datenschutz aufzugeben. Durch lokale Anonymisierung, revisionssichere Protokollierung und granulare Rechtevergabe entsteht ein geschützter Rahmen für den produktiven Einsatz generativer Intelligenz. Gleichzeitig wird vermieden, dass Nutzerdaten unkontrolliert in Trainingsdatensätze externer Anbieter gelangen. Die AI Console ist kein weiteres KI-Frontend, sondern ein Governance-Tool mit Echtzeitkontrolle.

In Kürze: Synology AI Console (Stand Juli 2025)

Mit der AI Console bietet Synology ein neues Verwaltungswerkzeug für DSM 7.2, das eine kontrollierte Einbindung externer KI-Dienste (zum Beispiel OpenAI, Azure, Google Vertex AI) ermöglicht. Die KI-Modelle verbleiben extern, während Steuerung und Datenschutz lokal umgesetzt werden. Das Paket befindet sich aktuell in der öffentlichen Beta-Phase und läuft nur auf x86-64-NAS-Systemen mit mindestens 8 GB RAM.

Zentrale Funktionen

- API-Integration: Unterstützung mehrerer KI-Anbieter über ein einheitliches Interface mit API-Schlüsseln und Modellwahl.

- Zugriffsverwaltung: KI-Nutzung lässt sich paket-, benutzer- oder gruppenbezogen freigeben; Active Directory wird unterstützt.

- Datenschutz: Sensible Daten werden lokal anonymisiert (De-Identifikation) vor Versand an KI-Dienste.

- Token- und Budgetkontrolle: Nutzungsstatistiken, Token-Limits und Protokollierung schützen vor Kostenexplosion und Kontrollverlust.

- Anwendungsintegration: Erste KI-Funktionen in MailPlus und Synology Office (z. B. automatische Textzusammenfassungen).

- Zukünftige Funktionen: Geplante Nutzung interner Dateien (Synology Drive) als Kontextquelle zur Verbesserung der KI-Antworten.

Zielgruppe und Nutzen

IT-Administratoren in Unternehmen, die generative KI datenschutzkonform und unter eigener Kontrolle einsetzen möchten. Die AI Console bietet dafür Governance, Transparenz und Sicherheitsmechanismen – bei voller Datenhoheit.