chones - stock.adobe.com

Generative KI und Ethik: Die 8 größten Bedenken und Risiken

Generative KI stellt Geschäftsmodelle auf den Kopf und rückt ethische Fragen wie den Schutz der Privatsphäre, Markenintegrität und Verdrängung von Arbeitskräften ins Rampenlicht.

Wie andere Formen der KI kann auch generative KI eine Reihe von ethischen Fragen in Bezug auf Datenschutz, Sicherheit, Richtlinien und Arbeitskräfte aufwerfen. Generative KI-Technologie kann auch eine Reihe neuer Geschäftsrisiken wie Fehlinformationen, Plagiate, Urheberrechtsverletzungen und schädliche Inhalte hervorbringen. Mangelnde Transparenz und die potenzielle Verdrängung von Arbeitskräften sind ebenfalls Herausforderungen, mit denen sich Unternehmen auseinandersetzen müssen.

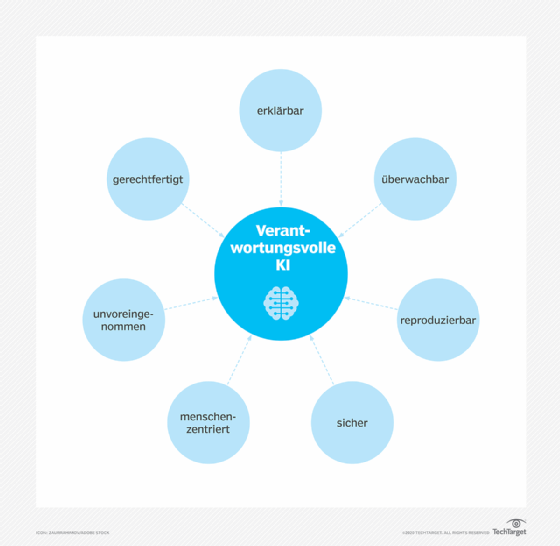

„Manche Risiken, die von generativer KI ausgehen, sind größer und besorgniserregender als andere“, sagt Tad Roselund, Managing Director und Senior Partner bei der Unternehmensberatung BCG. Diese Risiken erfordern einen umfassenden Ansatz, der eine klar definierte Strategie, eine gute Unternehmensführung und ein Bekenntnis zu verantwortungsvoller KI beinhaltet. Eine Unternehmenskultur, die eine generative KI-Ethik einbezieht, muss acht wichtige Aspekte berücksichtigen.

1. Verbreitung von schädlichen Inhalten

KI-Systeme können Inhalte automatisch auf der Grundlage von Texteingaben durch Menschen erstellen. „Diese Systeme bewirken enorme Produktivitätssteigerungen, aber sie können auch absichtlich oder unabsichtlich Schaden verursachen“, erklärt Bret Greenstein, Partner, Cloud and Digital Analytics Insights, bei der Beratungsfirma PwC. Eine von KI generierte E-Mail, die im Namen des Unternehmens verschickt wird, kann zum Beispiel versehentlich beleidigende Formulierungen enthalten oder Mitarbeitern falsche Anweisungen geben. Generative KI sollte als Ergänzung und nicht als Ersatz für Menschen oder Prozesse eingesetzt werden, um sicherzustellen, dass die Inhalte den ethischen Erwartungen des Unternehmens entsprechen und seine Werte unterstützen.

2. Urheberrecht und andere rechtliche Risiken

Gängige generative KI-Tools werden auf riesigen Bild- und Textdatenbanken aus verschiedenen Quellen, darunter auch dem Internet, trainiert. Wenn diese Tools Bilder erstellen oder Codezeilen generieren, kann die Quelle der Daten unbekannt sein, was für eine Bank, die Finanztransaktionen abwickelt, oder ein Pharmaunternehmen, das sich auf eine Formel für ein komplexes Molekül in einem Medikament verlässt, problematisch ist. Auch die Reputations- und Finanzrisiken können massiv sein, wenn das Produkt eines Unternehmens auf dem geistigen Eigentum eines anderen Unternehmens basiert. „Die Unternehmen müssen darauf achten, die Ergebnisse der Modelle zu validieren“, rät Roselund, „bis rechtliche Präzedenzfälle Klarheit über die Herausforderungen im Bereich des geistigen Eigentums und des Urheberrechts schaffen.“

3. Datenschutzverstöße

Generative KI-Sprachmodelle (Large Language Models, LLMs) werden mit Datensätzen trainiert, die manchmal personenbezogene Informationen über Einzelpersonen enthalten. „Diese Daten können manchmal mit einer einfachen Textabfrage eruiert werden“, sagt Abhishek Gupta, Gründer und Principal Researcher am Montreal AI Ethics Institute. Und im Vergleich zu herkömmlichen Suchmaschinen kann es für einen Verbraucher schwieriger sein, die Informationen zu finden und ihre Löschung zu verlangen. Unternehmen, die LLMs entwickeln oder verfeinern, müssen sicherstellen, dass personenbezogene Daten nicht in die Sprachmodelle eingebettet sind und dass es einfach ist, personenbezogene Daten aus diesen Modellen unter Einhaltung der Datenschutzgesetze zu entfernen.

4. Veröffentlichung sensibler Informationen

Generative KI demokratisiert die KI-Fähigkeiten und macht sie leichter zugänglich. Diese Kombination aus Demokratisierung und Zugänglichkeit kann laut Roselund dazu führen, dass ein medizinischer Forscher versehentlich sensible Patientendaten preisgibt oder eine Verbrauchermarke ihre Produktstrategie unwissentlich an Dritte weitergibt. Die Folgen solcher unbeabsichtigten Vorfälle können das Vertrauen der Patienten oder Kunden erschüttern und rechtliche Konsequenzen nach sich ziehen. Roselund empfiehlt den Unternehmen, klare Richtlinien, Governance und effektive Kommunikation von oben nach unten einzuführen und die gemeinsame Verantwortung für den Schutz sensibler Informationen, geschützter Daten und geistigen Eigentums zu betonen.

5. Verstärkung bestehender Vorurteile

Generative KI kann potenziell bestehende Verzerrungen verstärken, zum Beispiel können Verzerrungen in Daten gefunden werden, die für das Training von LLMs verwendet werden und sich der Kontrolle von Unternehmen entziehen, die diese Sprachmodelle für bestimmte Anwendungen nutzen. Es ist wichtig, dass Unternehmen, die an KI arbeiten, über verschiedene Führungskräfte und Fachexperten verfügen, die dabei unterstützen, unbewusste Vorurteile in Daten und Modellen zu erkennen.

6. Rolle der Mitarbeiter

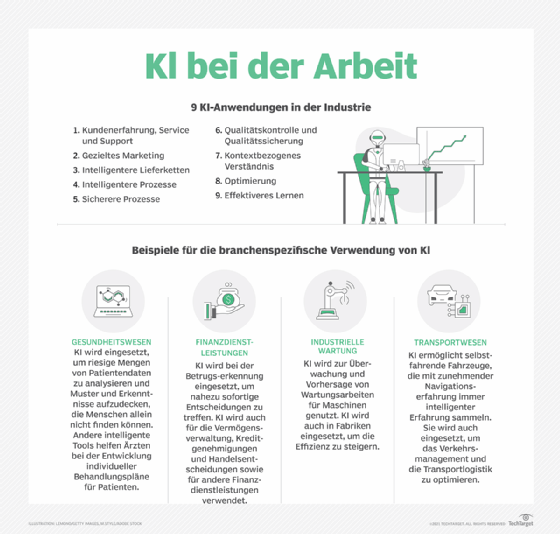

KI kann laut Greenstein einen Großteil der täglichen Aufgaben von Wissensarbeitern übernehmen, darunter Schreiben, Codieren, Erstellen von Inhalten, Zusammenfassen und Analysieren. Obwohl die Verdrängung und der Ersatz von Arbeitskräften seit dem Einsatz der ersten KI- und Automatisierungs-Tools anhält, hat sich das Tempo durch die Innovationen im Bereich der generativen KI-Technologien beschleunigt. „Die Zukunft der Arbeit selbst verändert sich und die ethischsten Unternehmen investieren in diesen [Wandel]“, fügt Greenstein hinzu.

Zu den ethischen Antworten gehören Investitionen in die Vorbereitung bestimmter Teile der Belegschaft auf die neuen Aufgaben, die durch generative KI-Anwendungen entstehen. Unternehmen müssen beispielsweise ihre Mitarbeiter unterstützen, generative KI-Fähigkeiten zu entwickeln. „Die wirklich existenzielle ethische Herausforderung für die Einführung generativer KI sind die Auswirkungen auf die Organisationsgestaltung, die Arbeit und letztlich auf den einzelnen Arbeitnehmer“, sagt Nick Kramer, Vice President für angewandte Lösungen bei der Unternehmensberatung SSA & Company. „Dies wird nicht nur die negativen Auswirkungen minimieren, sondern auch die Unternehmen auf das Wachstum vorbereiten.“

7. Herkunft der Daten

Generative KI-Systeme verbrauchen enorme Datenmengen, die unzureichend verwaltet werden, von fragwürdiger Herkunft sein können, ohne Zustimmung verwendet werden oder Vorurteile enthalten. Zusätzliche Ungenauigkeiten können durch Influencer oder die KI-Systeme selbst verstärkt werden.

„Die Genauigkeit eines generativen KI-Systems hängt von dem verwendeten Datenkorpus und dessen Herkunft ab“, erklärt Scott Zoldi, Chief Analytics Officer beim Kreditbewertungsunternehmen FICO. „ChatGPT-4 durchsucht das Internet nach Daten, und viele davon sind wirklich Müll, was ein grundlegendes Genauigkeitsproblem bei Antworten auf Fragen darstellt, auf die wir die Antwort nicht kennen.“

Laut Zoldi setzt FICO seit mehr als einem Jahrzehnt generative KI ein, um beim Training von Algorithmen zur Betrugserkennung Grenzfälle zu simulieren. Die generierten Daten werden stets als synthetische Daten gekennzeichnet, damit Zoldis Team weiß, wo die Daten verwendet werden dürfen. „Wir behandeln sie als abgeschottete Daten, die nur zu Test- und Simulationszwecken verwendet werden“, sagt er. „Synthetische Daten, die von generativer KI erzeugt werden, fließen nicht in das künftige Modell ein. Wir halten dieses generative Gut unter Verschluss und lassen es nicht ‚in freier Wildbahn‘ zu.“

8. Mangelnde Erklärbarkeit und Interpretierbarkeit

„Viele generative KI-Systeme fassen Fakten probabilistisch zusammen, was auf die Art und Weise zurückgeht, wie KI gelernt hat, Datenelemente miteinander zu verknüpfen“, erklärt Zoldi. Aber diese Details werden bei Anwendungen wie ChatGPT nicht immer offengelegt. Folglich wird die Vertrauenswürdigkeit der Daten in Frage gestellt.

Bei der Befragung von generativer KI erwarten Analysten eine kausale Erklärung für die Ergebnisse. Aber Machine-Learning-Modelle und generative KI suchen nach Korrelationen, nicht nach Kausalität. „An dieser Stelle müssen wir Menschen auf die Interpretierbarkeit des Modells bestehen – den Grund erkennen, warum das Modell die Antwort gegeben hat, die es gegeben hat“, sagt Zoldi. „Und wir müssen wirklich verstehen, ob eine Antwort eine plausible Erklärung ist, anstatt das Ergebnis für bare Münze zu nehmen.“

Solange dieses Maß an Vertrauenswürdigkeit nicht erreicht ist, sollte man sich nicht auf generative KI-Systeme verlassen, wenn es darum geht, Antworten zu geben, die das Leben und den Lebensunterhalt von Menschen erheblich beeinflussen können.