Suriyo - stock.adobe.com

Ein Model Drift eines KI-Modells erkennen und korrigieren

Durch das Erkennen und Korrigieren eines Model Drifts stellen Entwickler von KI-Modellen sicher, dass diese Systeme genauer, relevant und praktikabel bleiben.

KI-Modelle können nicht statisch und unverändert bleiben, sondern weichen im Laufe der Zeit zwangsläufig ab. Daher sind eine kontinuierliche Überwachung und die Minderung von Model Drifts (Modellabweichungen) für jede laufende KI-Strategie von entscheidender Bedeutung.

KI-Systeme werden unter Verwendung komplexer Algorithmuskombinationen entwickelt, die Ergebnisse liefern, indem sie neue Betriebsdaten mit einem umfassenden Satz von Trainingsdaten vergleichen. Dieser Vergleich zwischen Trainings- und Produktionsdaten ist von entscheidender Bedeutung, da er es KI-Modellen ermöglicht, Muster zu lernen und fundierte Maßnahmen inmitten einer ständig wachsenden Flut von Geschäftsinformationen zu ergreifen.

Leider können sich die realen Datenbedingungen unerwartet oder allmählich über Monate oder sogar Jahre hinweg verändern – und Trainingsdaten passen sich nicht automatisch an, um mit diesen Veränderungen Schritt zu halten. Im Laufe der Zeit können wachsende Abweichungen zwischen Produktions- und Trainingsdaten die Genauigkeit oder Vorhersagefähigkeit eines Modells beeinträchtigen – ein Phänomen, das als Model Drift bekannt ist – was zu einer Verschlechterung der Modellleistung führen kann.

Was ist Model Drift?

Ein KI-Model-Drift tritt auf, wenn die realen Daten, mit denen ein Modell konfrontiert wird, von den Daten abweichen, für deren Erkennung oder Verarbeitung es trainiert wurde. Infolge dieser Diskrepanz verliert das Modell allmählich seine Fähigkeit, Trends genau zu erkennen, Probleme zu identifizieren oder Entscheidungen zu treffen, da es weiterhin veraltete Muster anwendet, die es während seines ursprünglichen Trainings gelernt hat.

Betrachten wir beispielsweise ein E-Mail-Filtermodell, das darauf trainiert wurde, Spam zu identifizieren, indem es bestimmte Wörter oder Ausdrücke markiert, die häufig in solchen E-Mails vorkommen. Im Laufe der Zeit ändert sich die Sprache, und Spammer wenden neue Taktiken an, um die Aufmerksamkeit der Leser zu erregen. Dazu können neue Schlagworte, Ausdrücke, Verweise und Taktiken wie Spear Phishing gehören, für deren Verarbeitung das Modell ursprünglich nicht trainiert wurde.

So können im Laufe der Zeit die Elemente, auf deren Erkennung das Modell trainiert wurde, an Bedeutung verlieren und durch neue Elemente ersetzt werden. Aufgrund dieser Änderungen der Produktionsdaten verschlechtert sich die Funktionsfähigkeit des Modells, da es nie gelernt hat, mit diesen neuen Datenelementen umzugehen. Dies führt zu einem Model Drift, das den Wert des Modells für das Unternehmen mindert oder sogar zunichte macht. Um dem entgegenzuwirken, können KI- und Machine-Learning-Teams die Trainingsdaten aktualisieren und möglicherweise adaptive Lernmechanismen integrieren, die sich an neue Spam-Verhaltensweisen anpassen können.

Die Abweichung hat keine dauerhaften Auswirkungen auf die Modelle selbst – wenn die Produktionsdaten und Variablen zu den erwarteten Parametern zurückkehren, wird das Verhalten und die Ausgabe eines Modells wiederhergestellt. Die Abweichung beeinträchtigt jedoch die Fähigkeit eines Modells, genaue und vorhersagbare Ergebnisse zu liefern, wodurch sein Wert gemindert wird. Die Schwere dieser Auswirkungen hängt vom Ausmaß der Abweichung zwischen Produktions- und Trainingsdaten ab.

Ursachen für Model Drifts von KI-Modellen

Es gibt zwei Hauptursachen für Model Drifts:

- Data Drift (Datenabweichung) tritt auf, wenn sich die Verteilung, der Umfang oder die Art der eingehenden Produktionsdaten im Laufe der Zeit ändern. Beispielsweise kann ein Modell, das zur Erstellung von Trendprognosen für ein Einzelhandelsunternehmen verwendet wurde, aufgrund unerwartet hoher Versandmengen und -kosten während eines außergewöhnlichen Ereignisses beeinträchtigt werden.

- Functional Drift (funktionale Abweichung) tritt auf, wenn sich die grundlegenden Verhaltensweisen oder Beziehungen zwischen Variablen ändern, wodurch die ursprünglichen Parameter für die Betriebsumgebung weniger geeignet sind. Beispielsweise kann ein von einem Finanzdienstleister verwendetes Modell eine funktionale Abweichung erfahren, wenn Veränderungen in der Wirtschaft die Beziehung zwischen Kreditausfällen und Bonitätsbewertungen verändern.

Auch andere Faktoren können zu einer Modellabweichung führen und die Zuverlässigkeit und Genauigkeit beeinträchtigen:

- Schlechte Datenqualität. Falsche Messungen, fehlende Werte, mangelnde Normalisierung und andere Datenfehler können zu Problemen mit der Datenqualität führen, die die Wirksamkeit des Modells beeinträchtigen. Beispielsweise liefert ein Umsatzprognosemodell, das mit falschen Transaktionsbeträgen gefüttert wurde, keine zuverlässigen Ergebnisse.

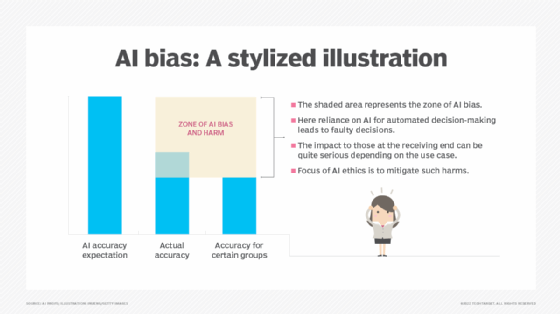

- Verzerrung der Trainingsdaten. Eine Verzerrung der Daten tritt auf, wenn die Verteilung der Daten in einem Datensatz unangemessen verzerrt ist oder nicht repräsentativ für die tatsächliche Verteilung ist. Wenn ein Modell mit verzerrten Daten trainiert wird, wird es im produktiven Einsatz schlechte Ergebnisse liefern, wenn es auf Daten in realen Umgebungen trifft, die sich von seinem Trainingssatz unterscheiden.

- Externe Ereignisse. Modelle, die für Aufgaben wie die Analyse der Benutzererfahrung oder Stimmung eingesetzt werden, können mit einer Flut unerwarteter Daten aus externen Quellen wie politischen Ereignissen, wirtschaftlichen Veränderungen und Naturkatastrophen konfrontiert werden. Beispielsweise kann ein regionaler Krieg die Analyse der Stimmung der Benutzer gegenüber einem Produkt oder einer Dienstleistung beeinflussen und dazu führen, dass zuvor positive Indikatoren plötzlich und umfassend zurückgehen. Diese Form der Datenabweichung lässt sich manchmal schnell beheben, kann aber auch über einen längeren Zeitraum bestehen bleiben und damit eine anhaltende Auswirkung auf das Modell haben.

Wie man ein Model Drift eines KI-Modells überwacht und erkennt

Das Erkennen von Model Drifts kann schwierig sein; Unternehmen zögern möglicherweise, die Zeit zu investieren, die für die Erstellung und das Training eines Modells sowie die Überprüfung seiner Ergebnisse erforderlich ist. Allerdings ändern sich Geschäftsumgebungen und Daten im Laufe der Zeit, wodurch jedes System dem Risiko eines Model Drifts ausgesetzt ist. Dies kann wiederum die genaue Entscheidungsfindung innerhalb des Unternehmens beeinträchtigen und zu einem schlechteren ROI von KI-Initiativen führen.

Die Erkennung von Modellabweichungen erfordert eine umfassende Reihe von Methoden:

- Direkter Vergleich. Die einfachste Methode zur Erkennung von Modellabweichungen ist der Vergleich der vorhergesagten Werte mit den tatsächlichen Werten. Wenn ein Modell beispielsweise dazu dient, die Einnahmen für das kommende Quartal zu prognostizieren, kann durch den regelmäßigen Vergleich der vorhergesagten Einnahmen mit den tatsächlichen Einnahmen für dieses Quartal sichergestellt werden, dass Abweichungen offensichtlich werden, wenn die beiden Ergebnisse im Laufe der Zeit voneinander abweichen.

- Überwachung der Modellleistung. Es gibt zahlreiche Metriken, die zur Messung der Modellleistung beitragen können, darunter Verwechslungsmatrizen, F1-Score sowie Gewinn- und Verlustdiagramme. Andere statistische Methoden, wie der Kolmogorov-Smirnov-Test, können ebenfalls dabei unterstützen, die Abweichung der Ergebnisse vom erwarteten Mittelwert zu berechnen. Modellentwickler sollten die Metriken auswählen, die für das Modell, seinen Verwendungszweck und die zu untersuchende Eigenschaft am besten geeignet sind.

- Daten- und Merkmalsbewertungen. Die in Modellen verwendeten Daten und Merkmale ändern sich im Laufe der Zeit. Modellentwickler sollten die an das Modell gelieferten Daten regelmäßig bewerten, die zur Vorbereitung des Modells verwendeten Trainingsdaten berücksichtigen und die zur Erstellung des Modells verwendeten Algorithmen und Annahmen neu bewerten. Dies kann Teams dabei helfen, festzustellen, ob sich die Datenqualität verändert hat und ob die vorhandenen Merkmale noch Vorhersagekraft haben.

- Vergleichsmodelle. Wenn zwei oder mehr ähnliche Modelle verfügbar sind, kann es sinnvoll sein, die Ergebnisse mehrerer Modelle zu vergleichen, um ihre Variabilität und Empfindlichkeit gegenüber verschiedenen Datensätzen zu verstehen. Beispielsweise können Teams parallele Modelle entwickeln, die leicht unterschiedliche Trainingsdaten oder Produktionsdaten verwenden, und dann die Ergebnisse vergleichen, um Abweichungen in einem oder mehreren Modellen zu ermitteln.

Unabhängig von der verwendeten Methode sollte die Erkennung von Abweichungen als regelmäßiger Prozess behandelt werden, um im Laufe der Zeit genaue Ergebnisse zu gewährleisten.

So korrigieren Sie ein Model Drift

Um Model Drifts zu korrigieren, können Unternehmen Machine-Learning-Workflows einsetzen, die einen wiederkehrenden Prozess der Datenqualitätssicherung, Drift-Überwachung und -Minderung umfassen. Dazu gehören die Einrichtung solider Data-Governance-Praktiken, die proaktive Gestaltung von Modellen, um sicherzustellen, dass sie im Laufe der Zeit angepasst werden können, sowie die regelmäßige Überprüfung der Modelle auf Genauigkeit und Zuverlässigkeit.

Zu den spezifischen Strategien zur Drift-Minderung gehören die folgenden:

- Modell-Retraining. Regelmäßiges Retraining ist eine der einfachsten und unkompliziertesten Methoden zur Minderung eines Model Drifts und kann nach Bedarf durchgeführt werden – entweder in regelmäßigen Abständen oder bei Erkennung einer Abweichung. Durch Retraining können neue, genaue, vollständige und valide Daten bereitgestellt werden, die es dem Modell ermöglichen, sich als Reaktion auf neue Daten und Merkmale weiterzuentwickeln.

- Adaptive Techniken. Herkömmliche Modelle für maschinelles Lernen verwenden eine anfängliche Schulung und bei Bedarf eine Nachschulung, aber ein fortschrittliches Modelldesign kann Rückkopplungsschleifen innerhalb des Modells implementieren, die es ihm ermöglichen, aktiv aus eingehenden Daten zu lernen und sich an diese anzupassen. Eine solche Technik kann die Bewertung durch Benutzer oder anderes menschliches Feedback umfassen, das es dem Modell ermöglicht, seine Entscheidungsfindung dynamisch anzupassen, um wünschenswertere Ergebnisse zu erzielen. Andere inkrementelle oder kontinuierliche Lerntechniken können ebenfalls in das Modell integriert werden, um regelmäßige Trainingsaktualisierungen durchzuführen.

- Mehrere Modelle. Eine weitere Möglichkeit, sich gegen Model Drift zu schützen, besteht darin, mehrere verwandte Modelle gleichzeitig einzusetzen und verschiedene Modelle zu verwenden, um unterschiedliche Aspekte des Problems oder der Daten zu erfassen. Die Bewertung desselben Problems aus verschiedenen Perspektiven ermöglicht einen ganzheitlichen Ansatz für Analysen und Entscheidungsfindungen. Die Verwendung mehrerer Modelle kann auch als Schutz vor dem Ausfall des gesamten Systems dienen, wenn ein Modell zu driften beginnt.