Vasyl - stock.adobe.com

Datenbasierte Steuerung von Speicherressourcen und Wachstum

Wachsende Datenbestände verlangen nach kontinuierlicher Überwachung von Speicherressourcen und einer vorausschauenden Planung, die technische Messwerte systematisch auswertet.

Storage Monitoring und Kapazitätsplanung wirken im Unternehmensumfeld nicht als isolierte Disziplinen, sondern als zusammenhängender Steuerungsmechanismus für den Betrieb digitaler Infrastrukturen. Anwendungen aus Virtualisierung, Datenbanken, Cloud-Plattformen, Analyseumgebungen und industriellen Systemen erzeugen kontinuierlich wachsende Datenmengen. Das gilt natürlich auch für das Machine Learning. Jede geschäftskritische Funktion hängt von der Verfügbarkeit, Performance und Skalierbarkeit der darunterliegenden Speicherplattform ab. Fehlende Transparenz über Belegung, Wachstumsverläufe und Leistungsgrenzen führt zu Fehlentscheidungen bei Investitionen, zu operativen Risiken und zu unnötiger Bindung von Budget.

Kapazitätsplanung setzt dort an, wo Monitoring endet. Monitoring liefert Messwerte in hoher zeitlicher Auflösung. Kapazitätsplanung interpretiert diese Messwerte über längere Zeiträume, erkennt Trends, bewertet strukturelle Effekte und übersetzt technische Zustände in belastbare Planungsgrundlagen. Mit einer konsequenten Kapazitätsplanung entwickelt sich Storage-Betrieb zu einem kalkulierbaren Prozess.

Monitoring als Grundlage jeder belastbaren Kapazitätsanalyse

Storage Monitoring erfasst kontinuierlich technische Kennzahlen auf Block-, File- und Object-Ebene. Dazu zählen belegter Speicherplatz, Netto- und Rohkapazität, Replikationsanteile, Snapshot-Wachstum, I/O-Profile, Latenzen, Warteschlangen und Controller-Auslastung. Diese Werte besitzen für sich genommen keinen Planungswert. Erst ihre zeitliche Entwicklung liefert Aussagen über zukünftige Anforderungen.

Prometheus wird in vielen Unternehmen als zentrales Metriksystem oder als Kern einer Monitoring-Architektur für diese Aufgabe genutzt. Exporter sammeln Storage-relevante Kennzahlen aus Betriebssystemen, Hypervisoren, Containerplattformen und Storage-Diensten. Das Zeitreihenmodell erlaubt eine eindeutige Zuordnung der Messwerte zu Volumes, Pools, Mandanten oder Applikationen. Abfragen über Wochen, Monate oder Jahre zeigen Wachstumsraten und Lastverteilungen, die für Kapazitätsmodelle unverzichtbar sind. Prometheus übernimmt dabei nicht die Planung, sondern stellt die Datenbasis bereit, auf der Planung erst möglich wird.

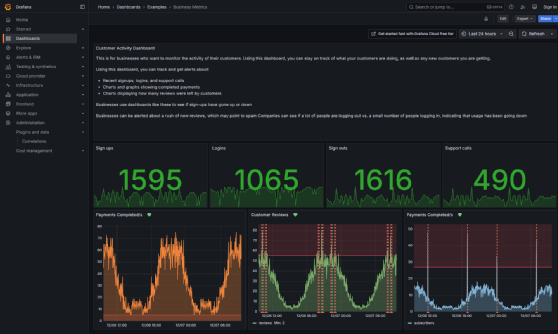

Grafana ergänzt diese Ebene durch visuelle und analytische Auswertung. Zeitliche Überlagerungen von Belegung, I/O-Last und Latenz verdeutlichen Zusammenhänge, die in Rohdaten verborgen bleiben. Verantwortliche erkennen auf diese Weise, ob Speicherengpässe durch Kapazitätsgrenzen oder durch Leistungsparameter verursacht werden. Diese Differenzierung beeinflusst Planungsentscheidungen grundlegend, da sie zwischen Erweiterung von Kapazität und Optimierung von Architektur unterscheidet.

Klassische Enterprise-Plattformen für Storage Monitoring

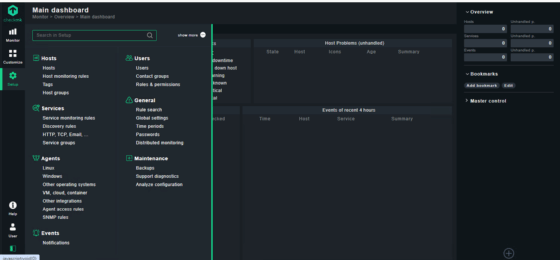

In Rechenzentren mit klassischen Server- und Storage-Architekturen übernehmen Zabbix und Checkmk ebenfalls eine zentrale Rolle bei der Überwachung. Auch für das Storage-Monitoring und der damit verbundenen Kapazitätsplanung lassen sich diese Tools nutzen. Beide Plattformen erfassen Storage-Kapazitäten über Agenten, SNMP und APIs zu Storage-Controllern. Sie speichern Messwerte langfristig, verdichten historische Daten und stellen Trends automatisiert bereit. Diese Eigenschaften machen sie für Kapazitätsplanung im Unternehmen geeignet.

Unternehmen analysieren mit diesen Plattformen das Wachstum einzelner File-Systeme, die Belastung spezifischer Storage-Tiers und die Auswirkungen neuer Anwendungen auf bestehende Speicherressourcen. Die Daten zeigen nicht nur absolute Belegung, sondern auch Änderungsraten. Daraus lassen sich Zeiträume ableiten, in denen Erweiterungen erforderlich werden. Kapazitätsplanung verlagert sich damit von spontanen Reaktionen hin zu geplanten Maßnahmen mit definiertem Vorlauf.

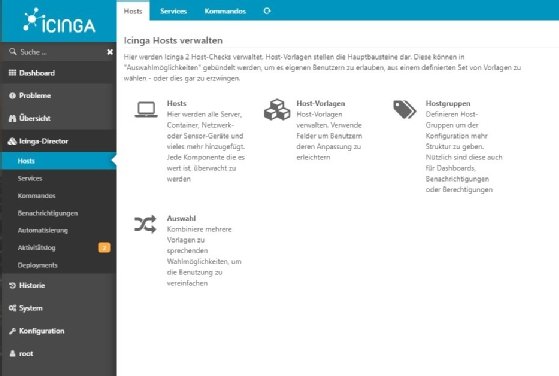

Icinga und Nagios verfolgen einen stärker regelgetriebenen Ansatz. Beide Systeme prüfen Speicherzustände anhand definierter Grenzwerte und melden Abweichungen. In Verbindung mit externen Zeitreihendatenbanken entsteht dennoch eine belastbare Historie. Unternehmen nutzen diese Plattformen teilweise dort, wo bestehende Betriebsmodelle eine enge Verzahnung von Monitoring, Alarmierung und IT-Service-Management verlangen. Kapazitätsplanung basiert in diesen Umgebungen auf der Auswertung historischer Grenzwertüberschreitungen und der zeitlichen Häufung kritischer Zustände.

Echtzeitdaten und ihre Rolle in der Planung

Netdata liefert hochauflösende Echtzeitdaten zu I/O-Last, Queue-Tiefen und File-Systemzugriffen. Diese Informationen eignen sich für die kurzfristige Analyse von Lastspitzen und Performance-Anomalien. Für Kapazitätsplanung besitzt Netdata eine ergänzende Funktion. Unternehmen integrieren die Daten in zentrale Zeitreihensysteme, um kurzfristige Effekte in langfristige Modelle einfließen zu lassen. Auf diese Weise fließen auch außergewöhnliche Lastmuster in Planungsentscheidungen ein.

Kapazitätsplanung in containerisierten Umgebungen

Containerplattformen verändern die Sicht auf Storage-Kapazität grundlegend. Kubernetes abstrahiert Speicher über Persistent Volumes und StorageClasses. Physische Grenzen bleiben im Hintergrund. Kapazitätsplanung muss daher Ressourcenzuteilung und tatsächliche Nutzung gleichzeitig betrachten.

Kube-capacity adressiert diese Anforderung durch Aggregation angeforderter und genutzter Ressourcen auf Node-, Namespace- und Workload-Ebene. Unternehmen erkennen Überreservierungen, bei denen logische Anforderungen rechnerisch Kapazität blockieren, ohne real genutzt zu werden. Diese Transparenz bildet eine zentrale Grundlage für die Planung, da sie zeigt, welche Kapazität technisch vorhanden ist und welche Kapazität durch Konfiguration gebunden bleibt.

Cluster-capacity erweitert diesen Ansatz um simulationsbasierte Analyse. Das Werkzeug berechnet, wie viele zusätzliche Workloads unter aktuellen Ressourcendefinitionen noch platzierbar sind. Firmen nutzen diese Information, um vor Rollouts zu prüfen, ob bestehende Cluster ausreichend dimensioniert sind oder ob Erweiterungen erforderlich werden. Kapazitätsplanung gewinnt dadurch eine prognostische Komponente, die über reine Ist-Zustände hinausgeht.

Kapazitätsplanung in verteilten Storage-Systemen

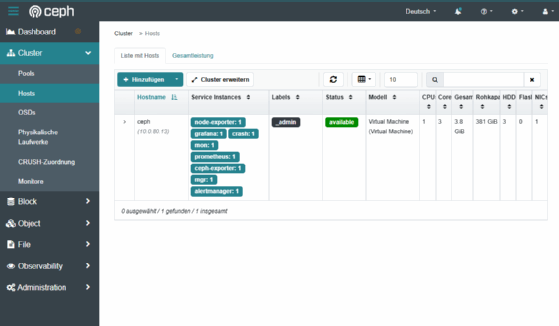

Verteilte Storage-Systeme stellen besondere Anforderungen an Planung. Ceph verteilt Daten über viele OSDs und nutzt Replikation oder Erasure Coding. Nutzbare Kapazität ergibt sich aus Konfiguration, Verteilung und Auslastung. Der Ceph Manager analysiert diese Faktoren kontinuierlich. Er bewertet Belegung pro OSD, Pool-Auslastung und Re-Balancing-Zustände.

Kapazitätsbalancierung besitzt hier eine funktionale Bedeutung. Ein einzelnes überfülltes Gerät begrenzt den gesamten Cluster. Ceph steuert daher aktiv die Verteilung von Daten, um gleichmäßige Füllstände zu erreichen. Kapazitätsplanung berücksichtigt zusätzlich den Aufwand für Re-Balancing, da Erweiterungen temporäre Mehrlast erzeugen. Unternehmen planen Storage-Erweiterungen deshalb nicht nur nach Kapazitätsbedarf, sondern auch nach betrieblicher Belastbarkeit.

Das Ceph Dashboard konsolidiert diese Informationen und stellt sie für operative Auswertung und strategische Planung bereit. Langfristige Trends zeigen, wie schnell Pools wachsen und welche Replikationsstrategien den größten Einfluss auf nutzbare Kapazität besitzen.

Langfristige Datenspeicherung und Prognosemodelle

Kapazitätsplanung erfordert langfristige Datenhaltung. Prometheus allein deckt diesen Bedarf nur eingeschränkt ab. VictoriaMetrics und Thanos übernehmen die Rolle skalierbarer Langzeit-Backends. Sie speichern Metriken effizient über Jahre hinweg und erlauben Aggregationen auf Tages- oder Wochenbasis.

Unternehmen nutzen diese Daten, um Wachstumsmodelle zu entwickeln. Lineare Entwicklungen, saisonale Effekte und Lastspitzen fließen in Prognosen ein. Diese Prognosen dienen als Grundlage für Budgetplanung, Hardware-Beschaffung und Vertragslaufzeiten bei Colocation oder Cloud-Anbietern. Kapazitätsplanung ersetzt damit Annahmen durch nachvollziehbare Berechnungen.

Hardwarezustände als Planungsfaktor

Kapazitätsplanung berücksichtigt nicht nur logische Belegung, sondern auch physische Zustände. Smartmontools liefern Informationen zu Betriebsstunden, Fehlerraten und Temperaturverläufen von Datenträgern. Unternehmen beziehen diese Werte in Planung ein, um Austauschzyklen mit Kapazitätsbedarf abzustimmen. Der gleichzeitige Austausch alter Hardware und die Erweiterung von Speicherkapazität reduziert operative Eingriffe und vereinfacht Wartungsfenster.

Strategische Bedeutung für Unternehmen

Storage Monitoring und Kapazitätsplanung bilden zusammen ein Instrument zur Steuerung von IT-Ressourcen. Monitoring liefert objektive Messwerte. Kapazitätsplanung interpretiert diese Werte im zeitlichen Kontext und übersetzt sie in technische und wirtschaftliche Entscheidungen. Open-Source-Werkzeuge decken diesen Prozess oft ab und erlauben eine transparente, herstellerunabhängige Umsetzung.

Unternehmen gewinnen Planungssicherheit, reduzieren ungeplante Erweiterungen und stabilisieren den Betrieb wachsender Datenplattformen. Kapazitätsplanung entwickelt sich dadurch von einer reaktiven Notwendigkeit zu einem festen Bestandteil strategischer IT-Steuerung.