Getty Images

Wie Unternehmen mit KI-Halluzinationen umgehen

KI-Halluzinationen können echte Schäden verursachen, daher setzen Technologieunternehmen automatisierte Schlussfolgerungen, neue Datensätze und RAG ein, um sie zu reduzieren.

Wenn man ein Prompt in ein KI-Modell eingibt, erwartet man im Allgemeinen, dass die Antwort wahrheitsgemäß ist. Schließlich ist das der Grund, warum Menschen dieses Tool überhaupt nutzen.

Es kommt jedoch nur allzu häufig vor, dass jemand eine Frage stellt und eine Antwort erhält, die auf den ersten Blick glaubwürdig erscheint, sich aber als falsch herausstellt. Dies wird als KI-Halluzination bezeichnet. Für Unternehmen, die künstliche Intelligenz (KI) zur Unterstützung ihrer Geschäftsabläufe einsetzen möchten, wird es immer wichtiger, herauszufinden, wie sie mit KI-Halluzinationen umgehen können.

KI-Modelle reagieren auf Prompts jedes Mal auf die gleiche Weise, aber KI-Halluzinationen treten nur gelegentlich auf. Daten des KI-Start-ups Vectara schätzen, dass KI-Halluzinationen je nach verwendetem Large Language Model (LLM) in 0,7 Prozent bis 29,9 Prozent der Fälle auftreten.

Dies resultiert daraus, dass die KI Muster oder Objekte in ihrem trainierten Datensatz erkennt, die nicht existieren, und dadurch eine Antwort liefert, die sachlich nicht korrekt ist. Da falsche Antworten auf die gleiche Weise wie wahrheitsgemäße Antworten generiert und präsentiert werden, ist es nicht sofort ersichtlich, wenn eine KI-Halluzination auftritt.

KI-Halluzinationen gibt es schon so lange wie LLMs und generative KI-Programme, aber sie sind mit der zunehmenden Verbreitung der Technologie deutlicher geworden. Dank der massenhaften Verfügbarkeit von Tools wie ChatGPT und DeepSeek gibt es heute auch mehr Gelegenheitsnutzer, die mit KI interagieren und von denen viele möglicherweise nicht das gleiche Verständnis von der Funktionsweise von KI haben.

In ähnlicher Weise setzen Unternehmen KI heute in ihren Betrieben auf vielfältigere Weise ein, ohne unbedingt über umfassende Kenntnisse der Funktionsweise von KI zu verfügen, was die Sichtbarkeit von Halluzinationen – und den potenziellen Schaden – erhöht.

Wie KI-Halluzinationen entstehen

Obwohl sie nicht perfekt sind, wird von KI-Tools erwartet, dass sie auf menschliche Anfragen wahrheitsgemäße Antworten liefern. Der Name künstliche Intelligenz impliziert, dass das Tool eine Quelle echten Wissens ist; viele Nutzer nehmen das wörtlich. Gelegenheitsnutzer von KI wissen möglicherweise nicht genau, wie die Technologie funktioniert, und sind sich daher nicht bewusst, dass korrekte Antworten eher auf Mustererkennung als auf einem bewussten Verständnis beruhen. Das bedeutet, dass viele Nutzer nicht wissen, dass die Antworten auf KI-Halluzinationen überprüft werden müssen.

Dieses Problem wird dadurch verschärft, dass KI-Modelle häufig Fragen zu Themen gestellt werden, über die der Nutzer nur unzureichende Kenntnisse hat, weshalb er sich überhaupt erst an das Modell wendet. Ohne fundierte Kenntnisse zum Thema kann es schwierig sein, selbst offensichtliche Fehler in den Antworten zu erkennen. Die KI bezieht ihre Antwort außerdem aus einem großen Datensatz, der Faktenmaterial enthält, sodass die KI-Halluzinationen wahrscheinlich einige Elemente der Wahrheit oder Ähnlichkeiten mit der Wahrheit enthalten. Dies kann ausreichend überzeugend sein. Der Nutzer kann zwar unabhängige Recherchen durchführen und die Antwort überprüfen, dies kann jedoch zeitaufwendig sein und untergräbt den Komfort, den die Nutzung der KI mit sich bringt.

Erschwerend kommt hinzu, dass das Modell häufig zusätzliche ungenaue Informationen generiert, wenn der Fragesteller die KI um Belege für ihre Antwort bittet. Die Belege sehen auf den ersten Blick überzeugend aus, sodass der Nutzer nicht erkennt, dass es sich um eine KI-Halluzination handelt. Auch hier werden lediglich die Daten verwendet, um Muster zu finden, sodass keine böswillige Absicht vorliegt – die Auswirkungen sind dennoch real. Dies geschah zum Beispiel einer Anwaltskanzlei, die 2023 an einer Klage in den USA wegen eines Flugunfalls arbeitete und ChatGPT für Recherchen nutzte und unwissentlich fiktives Material in ihre Argumentation einfließen ließ. Letztendlich wurden die Juristen wegen böswilliger Absicht mit einer Geldstrafe belegt.

KI-Halluzinationen können schnell auftreten und schwer zu erkennen sein, insbesondere wenn es keinen Prozess zur Überprüfung der Fakten gibt. Während einige Halluzinationen harmlos sein mögen, können andere erhebliche Auswirkungen haben – vor allem, wenn sie in einem geschäftlichen Umfeld eingesetzt werden.

Die potenziellen Gefahren von KI-Halluzinationen in der Wirtschaft

Wenn ein einzelner Nutzer eine falsche Information erhält, kann das zwar ärgerlich sein, aber letztlich nicht schädlich. Wenn ein Mitarbeiter KI nutzt und eine Halluzination erhält, können die Auswirkungen weitreichend und schädlich sein. Dies gilt insbesondere, wenn die Ergebnisse die Geschäftsstrategie unterstützen oder externe Akteure von einer bestimmten Vorgehensweise überzeugen. Wenn beispielsweise eine KI-Halluzination falsche Zahlen liefert, der Mitarbeiter deren Unrichtigkeit jedoch nicht erkennt, können diese Zahlen in Geschäftsunterlagen verwendet werden, die Investoren, Aktionäre oder Kunden über die tatsächliche Geschäftsentwicklung irreführen. Dies kann das Vertrauen in das Unternehmen untergraben und dessen Ruf auf dem Markt schädigen.

Die Generierung ungenauer Informationen durch eine KI-Halluzination kann Ressourcen verschlingen und Abläufe verzögern. Diese Fehler werden wahrscheinlich irgendwann entdeckt, sodass Mitarbeiter die Informationen überprüfen und korrigieren müssen, bevor die Prozesse manuell wieder aufgenommen werden können – allerdings erst nach einer Verzögerung. Da der Fehler nicht sofort erkannt wird, werden Zeit und Energie verschwendet. Wenn dies in großem Umfang geschieht, kann dies die Leistung erheblich beeinträchtigen und sich negativ auf den Umsatz auswirken. Dies ist genau das Gegenteil dessen, wofür die meisten KI-Programme implementiert werden: Effizienzsteigerung und Entlastung der Mitarbeiter.

Aufgrund der potenziellen Auswirkungen von KI-Halluzinationen werden viele Entscheidungsträger zunehmend skeptisch gegenüber dem Einsatz von KI für wichtige Anwendungsfälle. Diese Zurückhaltung kann dazu führen, dass Unternehmen die Vorteile der KI nicht nutzen können, weil sie versuchen, die Fallstricke zu vermeiden. Aus diesem Grund wirkt sich die Bekämpfung des Problems der KI-Halluzinationen auch positiv auf die allgemeine KI-Strategie von Unternehmen aus.

Wie Unternehmen mit KI-Halluzinationen umgehen

KI-Halluzinationen sind ein unvermeidbares Nebenprodukt der LLM-Verarbeitung, aber das bedeutet nicht, dass Unternehmen ihr Auftreten oder ihre Auswirkungen nicht reduzieren können. Es gibt verschiedene Ansätze für dieses Problem, wobei einige sich auf die Verbesserung des ursprünglichen Datensatzes konzentrieren und andere den Aspekt der Faktenprüfung ihrer KI-Tools untersuchen.

Automatisierte Schlussfolgerung

Ein Ansatz besteht darin, automatisierte Schlussfolgerungen (Automated Reasoning) einzusetzen, um KI-Ergebnisse bei ihrer Generierung zu überprüfen. Amazon ist durch die Einführung seines Produkts Automated Reasoning Checks Anbieter einer Lösung gegen KI-Halluzinationen. Automatisiertes Schlussfolgern verwendet mathematische, logikbasierte Algorithmen und Schlussfolgerungsprozesse, um die Richtigkeit des Ergebnisses nachzuweisen und den Nutzern ein höheres Vertrauen in die Richtigkeit ihrer Ergebnisse zu geben. Da der Prozess automatisiert ist, müssen Kunden ihre Abläufe nicht verzögern oder manuell Fakten überprüfen. Jeder Kunde wählt seine eigenen Richtlinien und erstellt eine personalisierte absolute Wahrheit, anhand derer die KI-Ergebnisse überprüft werden, damit die Ergebnisse für seine spezifischen Anwendungsfälle relevant sind. PwC setzt derzeit Tools aus seinem Portfolio ein, darunter die Lösung Maestro Medical Legal Review, um zu überprüfen, ob KI-Ergebnisse den Vorschriften entsprechen.

Verbesserte Datenqualität

Eine weitere Methode besteht darin, den ursprünglichen Datensatz, mit dem das LLM trainiert wurde, zu überarbeiten, um das Risiko zu verringern, dass ungenaue Daten verwendet werden. Ungenaue Daten können unverifizierte oder fehlerhafte Datenpunkte sein oder sich auf subjektives und meinungsbasiertes Material beziehen. Google möchte zum Beispiel die Richtigkeit der KI-Ergebnisse verbessern, indem man die Menge der in ein KI-Ergebnis einfließenden nutzergenerierten Inhalte begrenzt hat. Zu den nutzergenerierten Inhalten (User Generated Content, UGC) gehören Beiträge in sozialen Medien oder Reddit-Beiträge, die eher Meinungen als Fakten widerspiegeln können. Durch die Begrenzung des Anteils von UGC in der KI-Verarbeitung hofft Google, das Risiko von KI-Halluzinationen zu verringern.

Retrieval-augmented Generation (RAG)

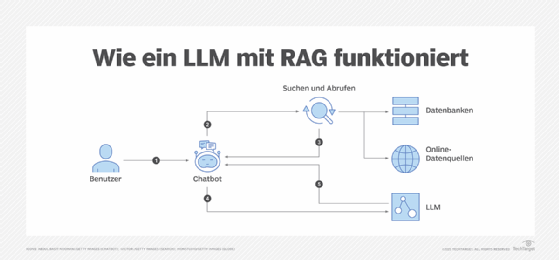

Schließlich ist die Retrieval-augmented Generation (RAG) eine zunehmend beliebte Methode zur Bekämpfung von KI-Halluzinationen. RAG ergänzt die Datensätze von LLMs, indem es sie mit spezifischen Informationsspeichern verbindet, die für ihre Anwendungsfälle relevant sind. Dies erlaubt eine größere Tiefe und Genauigkeit bei der Übermittlung von Anfragen zu spezifischeren oder technischen Themen, wie beispielsweise Medizin oder Recht. RAG kann mit beliebigen externen Ressourcen verknüpft werden, sodass diese für unterschiedliche Zwecke individuell angepasst werden können. Da die Antworten anhand dieser (oft sehr technischen) Referenzen überprüft werden, verringert sich das Risiko von KI-Halluzinationen und die Ergebnisse sind zuverlässiger.

Weitere Methoden zur Eindämmung von KI-Halluzinationen

Da es sich um ein weit verbreitetes Phänomen handelt, versuchen Unternehmen eine Reihe weiterer Methoden, um die Auswirkungen von Halluzinationen zu minimieren. Dazu gehören unter anderem

- Einführung von Leitlinien für den Einsatz von KI im Unternehmen. Dies kann die Einschränkung der Anwendungsfälle für KI oder die Implementierung spezifischer Beschränkungen für die Ergebnisse umfassen.

- Aufrechterhaltung der menschlichen Kontrolle über KI-Ergebnisse. Indem Menschen in jeder Phase der KI-Generierung einbezogen werden, sinkt die Wahrscheinlichkeit, dass Halluzinationen unentdeckt bleiben.

- Strenge Tests von LLM-Modellen vor der Einführung. So können Ingenieure wiederkehrende Probleme identifizieren und beheben, bevor die Technologie in größerem Umfang eingesetzt wird.

- Schaffung einer Kultur der Transparenz und Aufklärung der Mitarbeiter über die Grenzen der KI. Da KI-Halluzinationen nicht vollständig beseitigt werden können, ist es von entscheidender Bedeutung, die Nutzer über die Möglichkeit von Halluzinationen und die Bedeutung der Überprüfung aufzuklären.