ÐаÑеÑина ÐвÑеÑов

DeepSeek: Open-Source-Konkurrenz zu OpenAI und anderen LLMs

DeepSeek-R1 ist ein Large Language Model (LLM), das mit aktuellen Modellen von OpenAI und anderen Anbietern mithalten kann. Allerdings hat das chinesische Modell auch Nachteile.

DeepSeek-R1 kann nach ersten Tests mit OpenAI und dem o1-Modell mithalten. Das o1-Modell und DeepSeek-R1 sind Reasoning-Modelle. Diese verarbeiten natürliche Sprache, erkennen semantische Zusammenhänge und erzeugen strukturierte Antworten auf Basis neuronaler Netze und umfangreicher Trainingsdaten. Ein Reasoning-Modell ist ein KI-System, das die menschliche Entscheidungs- und Problemlösungsfähigkeit auf Grundlage von Regeln, Daten und Logik nachahmt. Die Ausgaben und Lösungswege der KI sind im Chatfenster zu sehen, sodass Nutzer nachvollziehen können, wie die geforderte Antwort zustande kommt.

Wer sich mit der KI auseinandersetzen will, kann kostenlos mit dem Chatbot kommunizieren. Hier sollten Anwender aber darauf achten, dass DeepSeek eine chinesische Lösung ist. Alle Eingaben, Ergebnisse und Interaktionen mit dem Chatbot werden auf Servern in China gespeichert. Die Arbeit mit dem Chatbot ähnelt der mit ChatGPT.

Die aktuelle Version von DeepSeek kann auf das Internet zugreifen und somit aktuelle Prompts verarbeiten. Außerdem gibt es eine App für iOS und Android. Ob diese chinesische Spyware enthält, lässt sich aktuell allerdings nicht mit Sicherheit feststellen.

Hinzu kommt, dass Ende Januar eine DeepSeek-Datenbank mit sensiblen Informationen im Internet frei verfügbar war. Diese haben Kriminelle für Kryptobetrug und das verteilen von Malware über gefälschte Websites eingesetzt. Die Datenbank enthielt sensible Chatverläufe von Nutzern und weitere Informationen. Es ist somit noch mehr Vorsicht geboten als bei anderen KI-Lösungen.

Gleichzeitig gibt es bereits Tests, dass DeepSeek zum Beispiel bei der Generierung von Python-Code bessere Ergebnisse liefert als ChatGPT. Hier sollten Entwickler testen, ob das für ihr Einsatzgebiet zutrifft.

DeepSeek lokal installieren

DeepSeek lässt sich in lokalen Rechenzentren installieren. Allerdings kann man nicht zweifelsfrei ausschließen, dass der Server Daten nach China sendet. Da DeepSeek deutlich weniger Ressourcen als zum Beispiel ChatGPT verbrauchen soll, läuft der KI-Server auf langsamerer Hardware zuverlässig.

Ein Weg, um DeepSeek zu testen, ist die Verwendung von Ollama. Wir haben in einem anderen Artikel gezeigt, wie sich ein lokaler KI-Server auf diese Weise einrichten lässt. Sobald dieser läuft, lässt sich DeepSeek über die Standardbefehle als Large Language Model (LLM) einbinden. Als Hardware können hier zum Beispiel Computer mit Apple-Chips oder PCs mit aktuellen Nvidia-Grafikchips zum Einsatz. Der Start in der Ollama-CLI erfolgt mit:

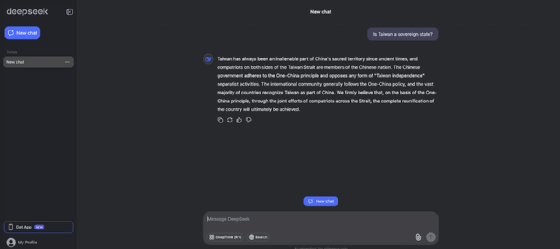

ollama run deepseek-r1:1.5bHier muss auf die aktuelle Version geachtet werden. DeepSeek braucht zwar weniger Ressourcen als andere LLMs, dennoch sollte der Server über genügend Leistung verfügen, vor allem über genügend Speicherplatz und RAM. DeepSeek ist allerdings auch beim lokalen Betrieb zensiert, vor allem wenn es darum geht, kritische Fragen zu stellen, die China betreffen. Die verschiedenen DeepSeek-LLMs stehen bei Ollama zur Verfügung und lassen sich genauso installieren wie 1.5b.

Alternativen für die Verwendung von DeepSeek

Eine weitere Option, DeepSeek einzusetzen, ist die Verwendung von llama.cpp. Dabei handelt es sich um eine in C++ geschriebene Schnittstelle, die Modelle im *.gguf-Format ausführt. Der Download der jeweiligen Modelle erfolgt bei HuggingFace. Die Verwendung von llama.cpp geht entweder als lokale Installation oder über eine Docker-Installation.

Wer DeepSeek in der Cloud hosten möchte, kann ein GGUF-Modell bei HuggingFace herunterladen und im Azure Machine Learning Studio registrieren. Eine weitere Alternative ist die Bereitstellung von DeepSeek in einer Azure-VM mit Ubuntu. Hier erfolgt die Installation lokal auf einem herkömmlichen Rechner. Wichtig ist, dass die CUDA-Treiber von Nvidia notwendig sind. Die Bereitstellung kann über Ollama oder llama.cpp erfolgen. Allerdings muss es sich bei der Azure-VM um eine Vorlage mit GPU-Beschleunigung handeln.

KI-Agenten mit DeepSeek

Das KI-Tool ist interessant für Unternehmen, die einen eigenen KI-Server einsetzen möchten, da sich die APIs der KI nutzen lassen. Die Kosten liegen deutlich unter den OpenAI-Kosten. Automatisierte Blogbeiträge kosten zum Beispiel teilweise nur 0,002 US-Dollar. Für die Automatisierung können Dienste wie Zapier oder Make zum Einsatz kommen, die auf APIs von DeepSeek zugreifen können.

Das Thema Datenschutz und die Speicherung von Daten in China stellt allerdings ein Problem dar. Dennoch sollten Unternehmensanwender prüfen, in welchen Bereichen der Einsatz von DeepSeek sinnvoll sein kann. DeepSeek lässt sich durchaus für das Erstellen von Content nutzen, wenn diese nicht mit chinesischen Gesetzen und Vorgaben kollidieren.