Suriyo - stock.adobe.com

Aufgaben mit Azure KI Foundry Agent Service automatisieren

Mit Azure KI Foundry Agent Service lassen sich komplexe Arbeitsprozesse automatisieren. Die Agenten agieren dabei selbstständig, greifen auf Daten zu und lösen automatisch Aktionen aus.

Azure KI Foundry Agent Service und Azure KI Foundry sind keine technologische Spielerei, sondern ein tiefer Eingriff in die Art, wie sich Routineprozesse automatisieren lassen. Wer bisher unter Chatbots einfache Frage-Antwort-Systeme verstand, steht hier vor einem Architekturwechsel.

Vom Chatbot zur Handlungseinheit

Ein Agent in Azure KI reagiert nicht nur, er handelt aktiv. Der Agent analysiert, plant, ruft APIs auf, erstellt Berichte, versendet E-Mails, löst Probleme, füllt Formulare aus und koordiniert bei Bedarf andere Agenten. Statt Gespräche entstehen Interaktionen. Microsoft positioniert diese Agenten als skalierbare, autonome Microservices.

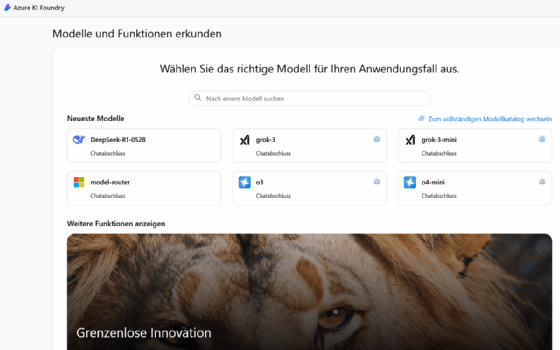

Entwickelt werden sie in Azure KI Foundry, wo der Einstieg über ein zentrales Portal erfolgt, das sämtliche KI-Dienste konsolidiert, von Azure OpenAI über Content Safety bis zu benutzerdefiniertem Modell-Hosting. Das gesamte Ökosystem ist so aufgebaut, dass Entwickler direkt produktionsreife Lösungen entwerfen können, ohne sich mit dem Infrastrukturmanagement beschäftigen zu müssen.

Dreistufiger Entwicklungsprozess

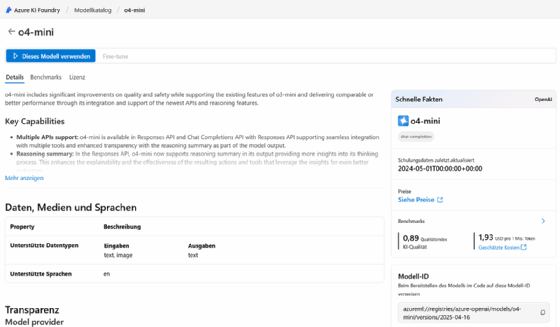

Die Entwicklung erfolgt in drei Schritten. Zunächst die Modellwahl: es lassen sich zum Beispiel GPT-4o, Llama 3, Mistral oder ein eigenes, feinjustiertes Modell projektbezogen auswählen. Jeder Agent kann mit einem anderen Modell arbeiten, auch innerhalb desselben Workflows. Die Modularität ist tief verankert, eine Reaktion auf reale Unternehmensprozesse, die sich nicht in einem generischen Agenten abbilden lassen.

Der zweite Schritt ist die die Datenanbindung. Per Retrieval-augmented Generation (RAG) greift der Agent auf strukturierte und unstrukturierte Inhalte zu. Microsoft Bing, SharePoint, Microsoft Fabric, lokale Dateien oder externe Provider lassen sich als Wissensquellen verknüpfen.

Retrieval-augmented Generation kombiniert ein KI-Sprachmodell mit einer externen Wissensquelle. Vor der Textgenerierung sucht das System gezielt in verknüpften Datenbeständen, zum Beispiel SharePoint, Azure KI Search oder lokalen Dokumenten, nach relevanten Inhalten. Diese Informationen werden dem Modell zur Verfügung gestellt und fließen direkt in die Antwort ein. Dadurch bleiben Aussagen präzise, aktuell und nachvollziehbar, ohne dass das Modell Halluzinationen erzeugt oder auf veraltetes Training angewiesen ist. Auch Azure KI Search ist eingebunden, mit der Möglichkeit, Daten vorab zu indizieren, zu klassifizieren und über semantische Abfragen zu referenzieren. Öffentliche und private Informationsquellen lassen sich kombinieren, je nach Sensibilität und Anwendungszweck.

Im dritten Schritt wird das Handlungsspektrum definiert. Azure Logic Apps stellen über 1400 Konnektoren bereit. Über eine OpenAPI-Spezifikation lassen sich zusätzliche APIs einbinden, sei es ein interner Service oder ein Drittanbieterangebot.

Noch tiefer reicht die Integration mit Azure Functions. Der Agent übergibt Eingaben direkt an benutzerdefinierten Code, empfängt Rückgaben, verwertet Ergebnisse. Auch komplexe Aufgaben mit Berechnungen, Datenbankabfragen oder Entscheidungslogik lassen sich so umsetzen, eingebettet in einen skalierbaren, verwalteten Rahmen ohne Infrastrukturpflege.

Koordination verteilter Intelligenz

Ein Agent bleibt dabei nicht isoliert. Er agiert in einem kontextbezogenen Thread. Darin laufen Aktionen, Nachrichten und Entscheidungswege zusammen. Für aufwendige Prozesse lässt sich ein Orchestrator-Agent einsetzen, etwa über Semantic Kernel. Dieser orchestriert mehrere Teilagenten, jeder zuständig für einen konkreten Aspekt. So entsteht aus modularen Bausteinen ein komplexes Multi-Agenten-System, das zum Beispiel Versicherungsfälle analysiert, Informationen verifiziert, Berichte erstellt und Rückfragen koordiniert. Entwickler profitieren dabei von einem erweiterbaren Framework, das auch Open-Source-Orchestratoren wie LangChain oder Autogen unterstützt.

Kontrollmechanismen für sensible Prozesse

Microsoft betont die Trennung zwischen Agentenleistung und menschlicher Verantwortung. Bestimmte Aufgaben lassen sich mit einer manuellen Freigabe koppeln. Bei Kostenerstattungen, Personalentscheidungen oder rechtlich relevanten Prozessen wird der Mensch eingebunden. Der Agent erkennt, wann er handeln darf und wann nicht. Diese Steuerung erfolgt über definierbare Kontrollpunkte innerhalb des Workflows. So bleibt die Kontrolle nachvollziehbar, auch bei hohem Automatisierungsgrad.

Sicherheit und Kontrolle sind von Beginn an eingebaut. Jeder Agent arbeitet auf Basis der Benutzeridentität, die durch Entra ID durchgereicht wird. Die Verbindung zu internen Datenquellen lässt sich über private Endpoints absichern, öffentliche Zugriffe sind nicht erforderlich. Auch der Betrieb in einem vollständig geschlossenen Netzwerk ist möglich. Unternehmen behalten die Kontrolle über Datenflüsse, Berechtigungen und Audit-Trails. Die Agenten verhalten sich wie interne Dienste, nicht wie externe Tools. Zugriffsbeschränkungen, Netzwerkisolation und Protokollierung lassen sich detailliert konfigurieren.

Vom Prototyp zum Enterprise-Agent

Die Umsetzung erfolgt entweder im Low-Code-Portal für einfache Experimente oder über das Foundry SDK für produktionsreife Workflows. Python-Entwickler können auf REST APIs oder das Azure KI Foundry SDK zurückgreifen. Die grundlegende Architektur bleibt gleich: Agent erstellen, Thread starten, Nachricht senden und Aktion ausführen. Die Wiederverwendbarkeit ist hoch, einzelne Komponenten lassen sich projektspezifisch adaptieren. Auch Monitoring, Logging und Kostenkontrolle sind integriert. Entwickler können zwischen Azure OpenAI-Modellen und Open-Source-Modellen wählen.

Die Evolution der Plattform begann zunächst mit einfachen Chat Completions. Anschließend folgten Azure OpenAI Assistants, erweitert um Code Interpreter, File Search und Datenanbindung. Der KI Agent Service bildet die nächste Stufe der Entwicklung. Er vereint semantisches Verständnis, Handlungsfähigkeit, Wissensintegration und Sicherheitsarchitektur zu einem Framework für digitale Mitarbeiter.

Ein praktisches Beispiel verdeutlicht die Architektur: Ein Unternehmen entwickelt eine Multi-Agenten-Lösung zur Bearbeitung von Versicherungsanträgen. Ein erster Agent durchsucht relevante Richtlinien. Ein zweiter validiert Kundendaten. Ein dritter erstellt einen zusammenfassenden Bericht. Gesteuert wird alles durch einen zentralen Orchestrator. Alle Agenten greifen auf dieselbe Wissensdatenbank zu, nutzen verschiedene Modelle und kommunizieren intern. Die Ergebnisse werden in natürlicher Sprache aufbereitet und an den zuständigen Sachbearbeiter weitergeleitet. Die gesamte Umgebung ist in Azure Foundry orchestriert, inklusive Speicher, Indexierung und Zugangskontrolle.

Agentenentwicklung im SDK: strukturierte Abläufe in Python

Die Programmierung erfolgt in einem standardisierten Muster: Zunächst wird ein Agent erzeugt, anschließend ein Thread, der den Kontext darstellt, und zuletzt eine Message, welche die Nutzereingabe und Instruktionen enthält. Dieser dreiteilige Aufbau bildet das Grundgerüst aller Anwendungen. Die Kommunikation mit dem Azure KI Foundry Agent Service erfolgt per REST oder über das Foundry SDK, bevorzugt in Python.

Entwickler integrieren ihre Umgebungsvariablen, definieren Modellinstanzen, setzen Berechtigungen und orchestrieren den Ablauf über wenige Codezeilen. Besonders leistungsfähig wird das System in Kombination mit orchestrierenden Frameworks wie Semantic Kernel. Auch die Anbindung von Azure Functions oder das Laden lokaler Dokumente zur Verwendung per Retrieval-augmented Generation lassen sich vollständig aus dem Code heraus steuern.

Codebeispiele und GitHub-Referenzen für Entwickler

Microsoft stellt hierfür vollständige Beispiele über GitHub bereit. Sie zeigen nicht nur einfache Agenten, sondern auch koordinierte Systeme mit mehreren Agenten, eingebunden in reale Produktionsabläufe. Entwickler können sofort starten, mit eigenen Daten experimentieren und produktionsreife Anwendungen entwickeln.

Über das Foundry-Portal lassen sich Agenten mit wenigen Klicks erstellen, an Datenquellen anbinden und testen. Alternativ steht der Weg per SDK offen, mit vordefinierten Funktionen zur Agenteninitialisierung, Thread-Erstellung und Ablaufsteuerung. Die typische Abfolge dabei ist: Agent anlegen, Thread erzeugen, Nachricht übergeben, Ausführung anstoßen und alles per SDK oder direkt im Azure AI Studio einbinden.

Der Wandel von Mensch-Maschine-Interaktion zur Agenten-Koordination

Der eigentliche Fortschritt liegt nicht im Einsatz großer KI-Modelle, sondern in deren Einbindung in konkrete Arbeitsabläufe. Der Azure KI Agent Service transformiert Unternehmensprozesse. Er ersetzt manuelle Routine durch nachvollziehbare Automatisierung, verteilt Entscheidungen dort, wo sie hingehören, und erlaubt Kontrolle auf jeder Ebene. Was früher Wochen dauerte, geschieht jetzt innerhalb einer orchestrierten Agentensitzung. Die Agenten werden zu Akteuren in der IT, gesteuert, überwacht, aber eigenständig handelnd.