turbomotion046 - stock.adobe.com

NVMe und SCM: Ihre Auswirkung auf die Zukunft des Storage

Erkunden Sie die verschiedenen Möglichkeiten, wie Anbieter von NVMe-Technologie den Weg für Unternehmen bereiten, um auf Storage Class Memory in ihren Infrastrukturen umzusteigen.

NVMe hat sich in Unternehmen durchgesetzt, angetrieben durch Anwendungen mit hohen Leistungsanforderungen wie Künstliche Intelligenz (KI), maschinelles Lernen und Analysen und deren Bedarf an Hochgeschwindigkeitszugriff mit niedriger Latenz auf Speichermedien. Jetzt setzt sich Storage Class Memory (SCM) durch, das Speichermedien mit niedriger Latenz bereitstellt.

Dieser Artikel befasst sich damit, wie NVMe Unternehmen den Weg für den Übergang zu Storage Class Memory (SCM) ebnet. Wenn sich NVMe- und SCM-Laufwerke durchsetzen, verlagert sich der Fokus von den Speichermedien als Engpass auf Bereiche wie CPU, Interconnect, Speichersoftware-Stack, Treiber und Protokolle. Lassen Sie uns erkunden, wie NVMe und SCM neue Wege zu schnellerem Speicher bei geringeren Kosten eröffnen.

Ein kurzer Rückblick

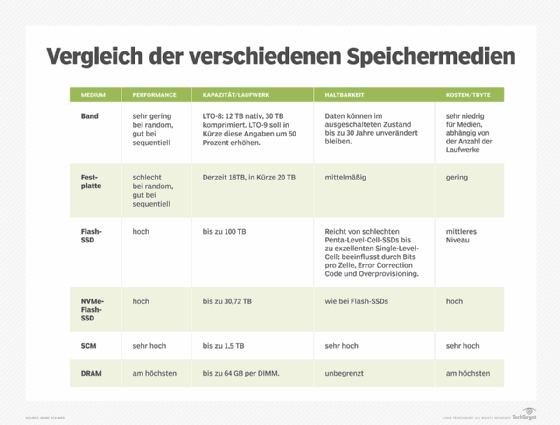

Bei Speichersystemen ging es schon immer um Kompromisse zwischen Leistung, Kapazität und Kosten. Die höchste Leistung, wie sie um Beispiel von dynamischem RAM (DRAM) bereitgestellt wird, hat relativ geringe Kapazitäten und sehr hohe Kosten pro Terabyte.

Das andere Extrem ist die Bandtechnologie. Band liefert eine sehr geringe Zufallsleistung (random performance), eine gute sequentielle Leistung und hohe Kapazitäten zu sehr geringen Kosten. Zwischen diesen Leistungs-, Kapazitäts- und Kostenextremen liegen Flash-SSDs und Festplatten (HDDs).

SSDs haben eine exzellente Lese- und Schreibleistung, die wesentlich niedriger ist als DRAM, und gute bis hohe Kapazitäten - bis zu 100 TB in einem 3,5-Zoll-Laufwerk - aber zu einem relativ hohen Preis im Vergleich zu HDDs oder Bändern. Preis, Leistung, Kapazität und Haltbarkeit für Flash variieren in Abhängigkeit von den NAND-Flash-Bits pro Zelle.

Festplatten liefern relativ schlechte zufällige Lese- und Schreibvorgänge im Vergleich zu DRAM oder SSDs, mit hohen Kapazitäten, guter sequenzieller Leistung, mittelmäßiger Ausdauer und vergleichsweise niedrigen Kosten pro Terabyte.

Aber was ist, wenn es einen Bedarf an höherer Leistung als bei gewöhnlichen Flash-SSDs zu niedrigeren Kosten als bei DRAM gibt? Es gibt immer Arbeitslasten - E-Commerce, Online-Transaktionsverarbeitung, Data Warehouses, KI-Analytik, maschinelles Lernen und Deep Learning -, die die höhere Leistung von niedrigeren Latenzzeiten und mehr IOPS oder Durchsatz verlangen. Es ist jedoch schwierig, die Kosten und die begrenzte Kapazität von DRAM zu rechtfertigen. Um diese Produktlücke zu schließen, haben die Anbieter NVMe-Flash-SSDs und NVMe-SCM entwickelt, die von Intel als Optane-SSDs vermarktet werden.

NVMe-Flash-SSDs

NVMe-Flash-SSDs wurden entwickelt, um die Latenzzeiten von Flash-SSDs zu reduzieren. Die Latenz ist der wichtigste Faktor bei Transaktionen und Nachrichtenübermittlung, da sie die Zeit ist, die für den Zugriff oder das Schreiben des ersten Bytes benötigt wird. Es ist auch die Zeit, die benötigt wird, um auf das letzte Byte zuzugreifen oder für die Tail-Latenz zu synchronisieren. Die Tail-Latenz ist extrem wichtig für Anwendungen, die das im High Performance Computing (HPC) vorherrschende Message-Passing-Interface-Protokoll verwenden.

NVMe ist die Open-Source-Standardspezifikation, die nichtflüchtige Medien wie NAND-Flash und 3D XPoint - die Technologie hinter Optane - über den PCIe-Bus anspricht. NVMe beseitigt einen bedeutenden Latenz-Engpass im SAS- oder SATA-Controller. Alle Controller erhöhen die Latenz, da sie zwischen dem PCIe-Controller und den Laufwerken sitzen. Die Eliminierung dieses Controllers reduziert die End-to-End-Latenz erheblich. NVMe-Flash-Laufwerke reduzieren die SSD-Latenz typischerweise um zwei Drittel oder mehr auf etwa 30 Mikrosekunden oder 0,03 Millisekunden. Das ist eine signifikante Reduzierung der Latenz.

NVMe verbessert auch den Durchsatz und die IOPS. PCIe Gen 4 - mit der doppelten Bandbreite von PCIe Gen 3 - ist erforderlich, um den vollen Leistungsvorteil zu erzielen. Die meisten aktuellen Speichersysteme verfügen über PCIe Gen 3.

NVMe-Laufwerke laufen direkt auf dem PCIe-Bus. Allerdings steht pro Sockel nur eine begrenzte Anzahl von PCIe-Steckplätzen zur Verfügung, abhängig von der CPU. Dies führt zu weniger NVMe-Laufwerken pro Speicher-Controller. Das ist der Hauptgrund, warum so viele NVMe-Flash-Speichersysteme 24 oder weniger NVMe-Laufwerke haben.

Der Start-up-Anbieter Pavilion Data Systems umgeht diese Einschränkung, indem er Architekturen mit mehr Controllern implementiert - bis zu 20 Controllern und 72 NVMe-Flash-Laufwerken. Fungible, ein weiteres Start-up, überwindet die PCIe-Steckplatzbeschränkung mit internen Infrastruktur-Switches über seinen anwendungsspezifischen integrierten Schaltkreis der Data Processing Unit (DPU). Die meisten Mainstream-Storage-Anbieter wie Dell EMC, Hewlett Packard Enterprise, Hitachi Vantara und NetApp verwenden Scale-out-Clustering-Technologie, um mehr Controller und Laufwerke in einem Speichersystem zu erhalten. Dieser Ansatz verbraucht auch mehr Platz im Rack.

Solange der Kompromiss zwischen den Controllern und dem Platzbedarf im Rack akzeptabel ist und die Verbindung zwischen den Speicher-Controller-Knoten nicht viel Latenz hinzufügt, reduziert NVMe die Latenz spürbar und erhöht die Leistung. SCM geht noch weiter.

Storage Class Memory

Der Optane SCM von Intel basiert auf 3D XPoint. Er ist schneller als Flash und hat geringere Latenzzeiten, einen höheren Durchsatz, mehr IOPS und eine größere Haltbarkeit. SCM-Laufwerke sind NVMe-basiert. SCM sollte jedoch nicht mit Intels Optane Persistent Memory (PMEM) DIMMs verwechselt werden, die in den DDR4-Speichersteckplätzen eines Servers oder Controllers stecken.

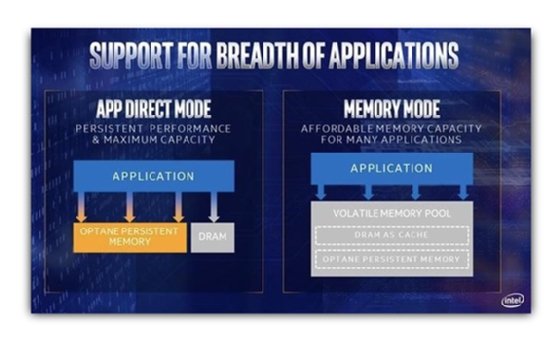

Auf PMEM kann auf zwei Arten zugegriffen werden. Die erste ist die Verwendung des nicht persistenten Speichermodus, der PMEM wie langsameres, weniger kostspieliges DRAM aussehen lässt. Die zweite Möglichkeit ist die Verwendung des persistenten Speichermodus App Direct Mode, der eine Modifikation der Anwendung und des Dateisystems erfordert, damit PMEM wie ein Speicher aussieht. Das ist nichts, was die meisten IT-Organisationen nutzen können, aber es gibt Ausnahmen. Anbieter wie Formulus Black und MemVerge können diese Anforderung vor den Anwendungen und Dateisystemen verbergen. Oracle nutzt den App Direct Mode in seinem Exadata-System für Oracle Database. Auch SAP S/4HANA nutzt den App Direct Mode für seine Datenbank. Es gibt vier Varianten des App Direct Mode: Raw Device Access, Memory Access, File System und NVM-aware File System.

Für die meisten Speicherimplementierungen und Speichersysteme ist SCM die Optane-Implementierung der Wahl. Sie ist einfach und erfordert keine Änderungen am Speicher-Stack. Es handelt sich einfach um ein schnelleres Laufwerk mit geringerer Latenz. SCM ist in der Regel drei- bis fünfmal schneller als NVMe-Flash-SSDs; allerdings ist es auch drei- bis fünfmal teurer. PMEM-DIMMs sind sogar noch schneller und teurer pro Terabyte.

Auswirkungen von NVMe und SCM auf die Speicherentwicklung

Die Anbieter von Speicherlösungen stellen sich bereits auf NVMe und SCM ein. Es gibt nur wenige Anbieter von Primärspeichersystemen, die derzeit keine NVMe-Flash-SSD-Speicheroptionen anbieten.

Was passiert, ist die Rückkehr von Tiered oder Cached Storage. Dies sind nicht die Speichersysteme von vor ein paar Jahren, die Flash-SSDs mit HDDs kombinierten. Diese Systeme verwendeten Flash-SSDs als primären Lese-/Schreib-Tier oder als Lese-/Schreib-Cache und verlagerten die Daten dann mit der Zeit auf kostengünstigere, weniger leistungsfähige Festplatten.

Vast Data und StorONE haben Pionierarbeit bei einer neuen Variante von hybriden Solid-State-Systemen geleistet. Sie verwenden NVMe-Flash-SSDs oder neuerdings SCM als primäre Lese-/Schreibschicht mit kostengünstigeren SAS/SATA-Quad-Level-Cell- (QLC) oder 4-Bit-pro-Zelle-Flash-SSDs mit hoher Kapazität als sekundäre Schicht für kühle und kalte Daten. QLC-Flash-Laufwerke bieten viel größere Kapazitäten zu deutlich niedrigeren Kosten als andere Flash-Laufwerke. Die Technologie bietet eine geringere Leistung und Ausdauer, um mehr Kapazität zu geringeren Kosten zu erhalten. Nimbus Data hat ein 64-TB-QLC-Flash-Laufwerk im 3,5-Zoll-Formfaktor angekündigt, das sich ideal für diese Hybridsysteme eignet.

Während SCM unabhängig von den Bits pro Zelle eine viel schnellere Leistung und höhere Ausdauer als Flash-SSDs hat, hat QLC eine geringere Leistung und Ausdauer als Single-Level-Cell-, Multi-Level-Cell- und Triple-Level-Cell-Flash-SSDs. Die Verwendung von NVMe-Flash- oder SCM-Laufwerken als primäre Schreibschicht oder Cache ermöglicht eine viel bessere Systemleistung und erhöht gleichzeitig die Ausdauer der viel preiswerteren QLC-Flash-SSDs.

Diese kombinierten NVMe- oder SCM- und QLC-Hybridsysteme sind zu 100 Prozent Solid-State mit einer viel besseren Allround-Leistung im Vergleich zu früheren Hybrid- oder sogar vielen aktuellen All-Flash-Systemen. Noch wichtiger ist, dass sie weniger kosten als aktuelle All-Flash-Systeme. Die Wirtschaftlichkeit und die Kosten-/Leistungsmetriken zeichnen den Weg dieser Systeme als die nächsten Mainstream-Allzwecksysteme vor.

Aber auch die All-NVMe-Flash- oder SCM-Systeme, die auf extreme Leistung ausgelegt sind, haben ihren Platz auf dem Markt. Sie verwenden nicht nur NVMe-Flash- und SCM-Laufwerke, sondern nutzen auch das NVMe-oF-Verbindungsprotokoll, das die Latenzzeiten zum und vom Speichersystem minimiert.