Business-Intelligence-Trends für 2021 und darüber hinaus

Diese acht Business-Intelligence-Trends beeinflussen, wie Unternehmen im Jahr 2021 mit Daten arbeiten. Neben Augmented und Embedded Analytics wird der Markt von RPA geprägt.

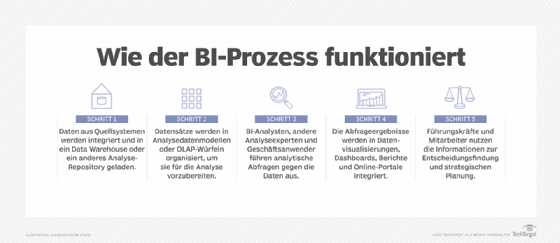

Seit Howard Dresner 1989 den Begriff Business Intelligence (BI) für Datenanalysewerkzeuge und -techniken zur Unterstützung unternehmerischer Entscheidungsprozesse geprägt hat, hat sich viel verändert.

Die Werkzeuge und Techniken sind zahlreicher und leistungsfähiger geworden. Der übergreifende Trend bei Business Intelligence ist jedoch, dass es zunehmend egalitär und allgegenwärtig ist: Mehr Menschen können von mehr Orten und für mehr Zwecke auf Geschäftsdaten zugreifen und sie anpassen.

Hier sind acht BI-Trends, die diesen Wandel 2021 vorantreiben.

1. Augmented Analytics

Augmented Analytics – der Einsatz von Machine Learning (ML) und Natural Language Processing (NLP) zur Verbesserung der Datenanalyse, des Datenaustauschs und der Business Intelligence – wurde von mehreren Forschern als einer der größten Trends des Jahres 2020 genannt. Zu diesen Forschern gehören auch die Analysten von Gartner, die das Konzept im Jahr 2017 eingeführt haben. Die allgemeine Idee hinter Augmented Analytics ist, dass sie den BI- und Analyseprozess für Geschäftsanwender und sogenannten Citizen Data Scientists (Geschäftsanwender ohne Data-Science-Hintergrund) vereinfachen.

Augmented Analytics Tools übernehmen einen Großteil der mühsamen Arbeit, die mit der Vorbereitung der zu analysierenden Daten verbunden ist, wie zum Beispiel das Parsing und Scrubbing. Unternehmen können Informationen aus Rohdatenquellen in diese Plattformen eingeben, die dann die Geschäftsdaten analysieren, parsen und zur Analyse zurückgeben. Durch den Einsatz von Machine Learning und NLP sind Augmented Analytics Tools in der Lage, Daten organisch zu verstehen und mit ihnen zu interagieren sowie wertvolle oder ungewöhnliche Trends zu erkennen. Im Gegenzug können Geschäftsanwender ohne datenwissenschaftlichen Hintergrund Abfragen stellen und sich nicht nur auf statische Balkendiagramme verlassen.

Augmented Intelligence stellt eine dritte Welle der Business Intelligence dar. Die erste Welle kam in den 1980er- und 1990er-Jahren und stützte sich ausschließlich auf Informationstechnologie-Experten. Die zweite Welle, Self-Service-Analytics, war in den vergangenen Jahren der bestimmende Trend. Im Jahr 2019 schätzte Gartner, dass die Augmented Analytics bis 2023 ein Volumen von 13 Milliarden US-Dollar erreichen wird.

2. Embedded Analytics

Wie Augmented Analytics gibt auch Embedded Analytics den Endanwendern mehr Macht. Wenn sie ein Daten-Dashboard sehen, möchten sie in der Lage sein, mit den Daten zu arbeiten, zum Beispiel sie vergrößern, aggregieren und aus verschiedenen Blickwinkeln betrachten, und das alles mit nur einem Knopfdruck. Und Unternehmen wollen ihren Kunden und Mitarbeitern diese Möglichkeit geben, um bessere Entscheidungen zu treffen. Aber die Erstellung interaktiver Dashboards und erweiterter Analysefunktionen ist nicht so einfach wie das Erstellen einer statischen Tabelle oder eines Diagramms und das Einbetten in eine Ansicht oder Webseite.

Embedded BI entlastet die Analyseteams und gibt den Endanwendern eine schnellere Möglichkeit, die benötigten Erkenntnisse zu erhalten, während sich die Analyseteams auf neue Produkte konzentrieren können, die das Wachstum und die Differenzierung des Unternehmens unterstützen.

"Analysten und Ingenieure müssen keine benutzerdefinierte Software verwenden oder sich mit Skalierbarkeits- und Sicherheitsproblemen befassen, wenn sie Endanwendern Einblicke liefern", sagt Ramesh Hariharan, Mitbegründer und CTO bei der Beratungsfirma LatentView Analytics. "Vielmehr können Dashboards und andere Visualisierungen ohne Codes oder Bibliotheken in Anwendungen integriert werden."

Allied Market Research prognostiziert, dass der Markt für Embedded Analytics bis 2023 60,28 Milliarden US-Dollar erreichen wird, mit einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 13,6 Prozent zwischen 2017 und 2023.

3. Datenvisualisierung

Wie überzeugend ist Ihre Datengeschichte? Datenqualität und Modellgenauigkeit sind wichtig, aber Sie müssen trotzdem erklären, was die Daten bedeuten. Genauer gesagt, müssen Sie nicht nur das Was, sondern auch das Warum erklären. „Im Gegensatz zu einer reinen Datenvisualisierung hat eine Datenstory einen Anfang, eine Mitte und ein Ende“, erläutert Charles Miglietti, CEO und Mitbegründer von Toucan Toco, einem Unternehmen für Data Storytelling Software. Der Anfang sollte erklären, worum es in Ihrem Bericht oder Ihrer Präsentation geht und warum es wichtig ist. In der Mitte werden diese Ideen näher erläutert, und das Ende fasst die Geschichte zusammen und enthält normalerweise eine Empfehlung.

Hier sind die vier wichtigsten Merkmale, die erfolgreiche Datenvisualisierung und Storytelling beinhalten sollten:

- Kontext. Jedes Daten-Storytelling benötigt einen Kontext, um den Punkt zu verdeutlichen, den Sie zu machen versuchen, und das Publikum, das Sie ansprechen.

- Ästhetik und Arten von Visualisierungen. Datenvisualisierungs-Tools bieten eine Menge Freiheiten. Kreative Freiheiten können jedoch der Klarheit entgegenwirken, wenn Klarheit Ihr Ziel sein sollte.

- Erzählungen. Der Text der Datenvisualisierung erklärt, was das Diagramm oder die Grafik bedeutet.

- Aktion. Erklären Sie, was Menschen mit diesen Informationen tun sollten.

4. Management der Datenqualität

Das Management der Datenqualität ist aufgrund von Veränderungen in der Art und Weise, wie Daten produziert, verarbeitet und genutzt werden, komplizierter geworden. CompTIA stellte in seiner Studie Trends in Data Management vom Februar 2020 fest, dass heute weniger Unternehmen mit dem Datenmanagement zufrieden sind als noch 2015. Konkret haben 25 Prozent der Unternehmen das Gefühl, dass sie mit ihrem Datenmanagement genau dort sind, wo sie sein wollen, im Vergleich zu 31 Prozent im Jahr 2015. Der Bericht stellt auch fest, dass 38 Prozent der Unternehmen ihre Datenanalyse beschleunigen wollen, während 37 Prozent angaben, dass sie Daten im gesamten Unternehmen integrieren müssen.

Datenqualitätsmanagement ist der Schlüssel zum Datenmanagementprozess. Bemühungen zur Verbesserung der Datenqualität sind oft eng mit Data-Governance-Programmen verbunden. Schlecht verwaltete Daten können zu betrieblichen Pannen, ungenauen Analysen, verpassten Verkaufschancen und Geldstrafen für unsachgemäße Finanz- oder Compliance-Berichte führen.

5. Predictive und Prescriptive Analytics Tools

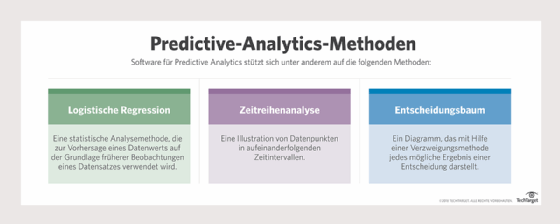

Predictive Analytics – eine Form von Advanced Analytics, die sowohl neue als auch historische Daten nutzt, um Aktivitäten, Verhalten und Trends vorherzusagen – hat mit dem Aufkommen von Big-Data-Systemen an Bedeutung gewonnen. Da Unternehmen immer größere und umfangreichere Datenpools in Hadoop-Clustern und anderen Big-Data-Plattformen anhäufen, haben sie vermehrt Data-Mining-Möglichkeiten geschaffen, um prädiktive Erkenntnisse zu gewinnen.

Bei Predictive Analytics werden statistische Analysetechniken, analytische Abfragen und automatisierte Algorithmen für maschinelles Lernen auf Datensätze angewendet, um Vorhersagemodelle zu erstellen, die einen numerischen Wert – oder eine Punktzahl – für die Wahrscheinlichkeit des Eintretens eines bestimmten Ereignisses angeben. Predictive Analytics versucht, die beste Lösung oder das beste Ergebnis unter verschiedenen Möglichkeiten zu bestimmen, wenn die Parameter bekannt sind.

2019 zeichnete sich der Einsatz von Predictive Analytics und künstlicher Intelligenz (KI) als Merkmal der besten Datenspeicherprodukte des Jahres aus, die von Storage Magazine und SearchStorage genannt wurden.

Im Jahr 2018 schätzte Zion Market Research den globalen Predictive-Analytics-Markt auf rund 3,49 Milliarden US-Dollar und erwartet, dass er 2022 10,95 Milliarden US-Dollar erreichen wird, mit einer jährlichen Wachstumsrate von 21 Prozent.

6. Hyperautomatisierung und Robotic Process Automation

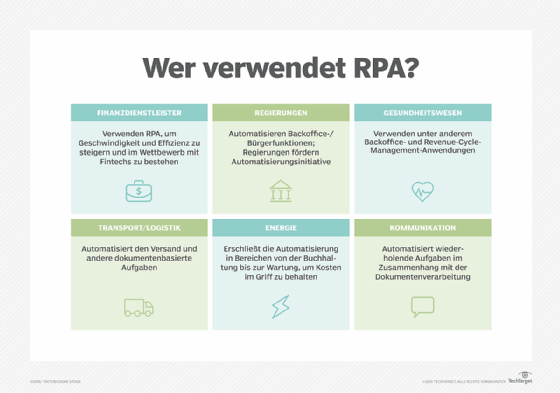

Hyperautomatisierung ist die weit verbreitete Anwendung von Technologien in einem Unternehmen, um Entscheidungen zu automatisieren. Typischerweise gehört dazu Robotic Process Automation (RPA), das von Gartner als eine der am schnellsten wachsenden Softwarekategorien identifiziert wurde.

RPA-Software zeichnet sich dadurch aus, dass sie es Geschäftsexperten und Frontline-Mitarbeitern mit minimalen oder gar keinen Programmierkenntnissen ermöglicht, leichte digitale Arbeitsaufgaben zu automatisieren. Forrester prognostiziert, dass bis 2027 29 Prozent der bestehenden Arbeitsplätze durch Automatisierung verloren gehen werden, während die Automatisierungswirtschaft, auch durch RPA, 13 Prozent neue Arbeitsplätze schaffen wird, wie zum Beispiel Data Scientists und Automatisierungsmanager.

Gartner prognostiziert, dass bis Ende 2020 mehr als 40 Prozent der Data-Science-Aufgaben automatisiert sein werden, was zu einer erhöhten Produktivität und einer breiteren Nutzung von Daten und Analysen durch Citizen Data Scientists führt.

7. Künstliche Intelligenz und Business Intelligence

Geschäftsanalysten, Datenwissenschaftler und Ingenieure haben den Einsatz von Machine-Learning-Algorithmen erforscht, um ihre Datenanalysen zu erweitern. Einige verwenden BI- und Datenaufbereitungssoftwarepakete, während andere fortschrittlichere Tools einsetzen, wie zum Beispiel Skripte zur Erstellung benutzerdefinierter Vorhersagemodelle mit Sprachen wie Python und R.

KI und BI wurden oft als Technologien mit wenig Überschneidungen betrachtet, da BI hauptsächlich retrospektiv ist, während es bei KI um die Zukunft geht. Bei der statistischen Analyse, die hinter BI steht, geht es in erster Linie um einfache Zählungen, im Gegensatz zu den ultra-anspruchsvollen Machine-Learning- und Deep-Learning-Algorithmen, die KI zugrunde liegen.

8. Mobile BI

Mobile BI-Tools wurden anfangs hochgejubelt, aber ihre Unpraktikabilität hat sie zurückgehalten. Das Problem ist, dass verwertbare Daten größtenteils visuell verarbeitet werden und mobile Displays im Vergleich zu Computerbildschirmen winzig sind. Die Nachbildung von Desktop-Dashboards funktioniert auf einem Mobilgerät nicht besonders gut. Die analytischen Fähigkeiten von Desktop-Geräten nachzubilden, funktioniert daher auch nicht.

Stattdessen haben die Anbieter, die erfolgreiche BI für mobile Apps entwickelt haben, Telefone und Tablets als andere Entitäten betrachtet als Desktop-Computer und eine andere Erfahrung auf ihren mobilen Apps geschaffen.

Microsoft verfolgt eine andere Taktik. Im Mai 2020 stellte es ein neues Power-BI-Update vor. Eine neue Funktion, die KI-Fähigkeiten hinzufügt, ist Smart Narratives, ein Tool zur Generierung natürlicher Sprache, das es Berichtsautoren ermöglicht, interaktive Erzählungen hinzuzufügen, die Power BI automatisch generiert und Endbenutzern Erklärungen zu ihren ständig aktualisierten Daten gibt. Eine weitere neue Funktion ist eine neue Funktion für die mobile Berichterstellung. Autoren können mobile Versionen ihrer bestehenden Power BI Desktop-Berichte erstellen, die die Benutzer dann mit Unterstützung der mobilen App von Power BI ansehen können.

Mordor Intelligence schätzt den globalen Markt für mobile Business Intelligence auf 7,6 Milliarden US-Dollar im Jahr 2019. Es erwartet, dass der Markt ein jährliches Wachstum von 22,43 Prozent während des Prognosezeitraums 2020 bis 2025 verzeichnen wird, wobei der Markt bis 2025 25,5 Milliarden Dollar erwirtschaftet.