sdecoret - stock.adobe.com

Deep-Learning-Algorithmen erfordern unbegrenzte Datenmengen

Je mehr Daten vorliegen, desto wirkungsvoller sind Deep-Learning-Projekte. Allerdings benötigen Unternehmen auch die richtigen Daten für Deep Learning.

Bei Deep-Learning-Projekten ist es praktisch unmöglich, sich eine Obergrenze für die Datenmengen vorzustellen, die für Trainingsmodelle und Analysen benötigt werden.

„Wir benötigen mehr Daten“, sagt Patrick Lucey, Director of Data Science bei der Sportberatungsfirma STATS LLC. „Wir kratzen wirklich nur an der Oberfläche. Wir wollen Geschichten rekonstruieren, [und] bessere Geschichten erzählen. Wir sind allerdings dabei begrenzt, da wir nicht alle Daten bekommen, die wir wollen.“

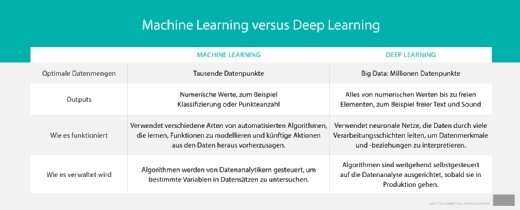

Deep Learning, wie es durch die Verwendung mehrerer Machine-Learning-Algorithmen definiert wird, ist nicht unbedingt ein neues Konzept. Es hat jedoch in den letzten Jahren an Bedeutung gewonnen, da Forscher und Unternehmensanwender erkannt haben, dass analytische Modelle auf die riesigen Datenschätze der Firmen, die sie angesammelt haben, angewendet werden können. Deep-Learning-Algorithmen erfordern Erfahrung, um ihre Empfehlungen zu schärfen – und Big Data liefert den Treibstoff, den sie brauchen.

Dies wirft jedoch die Frage auf, wann genug Daten vorhanden sind. Einige der bekanntesten Beispiele für Deep Learning verwendeten während des Modelltrainings Hunderttausende, ja sogar Millionen von Datensätzen. Aber manchmal reicht selbst das nicht aus.

Bei STATS hat Lucey Zugang zu einer Fülle von Daten, doch er sagt auch, dass die Modelle mit mehr Daten besser funktionieren. Das Unternehmen unterhält Datenbanken mit Spieldaten, die bis 1981 zurückreichen. Seine tiefsten Datensätze reichen bei der NBA bis ins Jahr 2010 zurück und stammen von seinem SportVU-System, einem Netzwerk von Kameras, das in den Sportarenen installiert ist und die Bewegungsdaten der Spieler erfasst.

Diese Fülle von Daten hat es Lucey und seinem Team ermöglicht, einige interessante Dinge mit Deep Learing zu machen. So entwickelten er und sein Team beispielsweise ein Modell, das Videodaten von NBA-Spielen betrachtet und die Körperpositionen der Spieler analysiert, um besser definieren zu können, wie eine optimale Position und Wurfbahn aussehen.

In einem anderen STATS-Projekt wurden Deep-Learning-Algorithmen für die Premier League in England angewandt. STATS analysierte Daten, die über die traditionellen Statistiken hinausgehen, wie Schüsse und Tore, um die Faktoren zu verstehen, die dazu führten, dass der Leicester City Football Club in der Saison 2015/16 den Meistertitel gewinnen konnte.

Das Data-Science-Team von STATS erstellt Modelle in erster Linie in Open-Source-Tools, wie dem von Google entwickelten TensorFlow und Scikit-Learn, einer Bibliothek mit in Python erstellten Machine-Learning-Modellen.

„Diese Projekte sind zwar erfolgreich gewesen“, sagt Lucey. Er fügt jedoch hinzu, dass er sich bereits darum bemühe, die Analysen zu schärfen. Hierbei sollen mehr Daten helfen.

Neben größeren Datenmengen seien aber auch detailliertere Informationen notwendig. Deep-Learning-Algorithmen gedeihen auf detaillierten Daten ebenso gut wie auf großen Datenmengen, und das wird eine wichtige Rolle spielen, da diese Modelle die Welt immer besser und genauer beschreiben.

„Das ist der Schlüssel – genau diesen Kontext zu finden“, sagt Lucey. „Man kann eine gute Vorhersage erhalten, doch wenn man sie mit zu viel Kontext verwässert, kann sie auch an Wert verlieren. Man muss daher die richtigen Daten haben.“