peterschreiber.media - stock.ado

So lassen sich Data Lakes für Speichernutzung einsetzen

Data Lake-Technologien lassen sich für die Speicherung von Daten nutzen. Dabei sollten Anwender auf verschiedene Kriterien achten und wissen, was am Markt verfügbar ist.

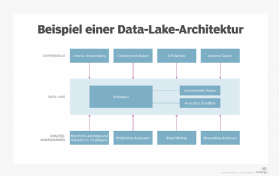

Die Data-Lake-Technologie hat die Aufmerksamkeit von Unternehmen auf sich gezogen, die einen Ort benötigen, an dem sie große Mengen an Rohdaten bis zu ihrer Verwendung in Analyseanwendungen speichern können.

Der Speichermarkt für Data Lakes wird schnell wachsen. Data Lake-Anbieter bieten Vorteile wie Speicherskalierbarkeit und Kosteneinsparungen. Auch wenn es sich hierbei noch um eine neue Lösung handelt, ist Data Lake Storage ein zunehmend beliebter Ansatz für die Datenarchitektur.

Im Gegensatz zu einem Data Warehouse, bei dem die Daten in Dateien oder Ordnern abgelegt werden, speichert ein Data Lake die Daten in ihrem ursprünglichen Format. Dadurch entfällt die Notwendigkeit, Daten umzustrukturieren, bevor sie für verschiedene Arten von Analysen verwendet werden.

Unternehmen müssen ihre Bedürfnisse und Möglichkeiten kennen, um den richtigen Anbieter zu wählen. Erfahren Sie, wo sich Data Lakes als besonders vorteilhaft erweisen und was die wichtigsten Kaufkriterien für diese Technologie sind. Sehen Sie sich dann die Hauptmerkmale der wichtigsten Data-Lake-Anbieter an.

Vorteile von Data Lake Storage

In erster Linie profitieren Linie Vertriebs-, Marketing- und Kundensupportorganisationen von dieser Technologie. Ein Data Lake führt verschiedene Daten auf einer einzigen, einheitlichen Datenplattform zusammen und ermöglicht eine flexible Entscheidungsfindung.

Data Lakes sind skalierbar, was es den Anwendern ermöglicht, Daten auf relativ kostengünstige Weise zu speichern. Die Technologie hilft auch dabei, alte Analyseanwendungen außer Betrieb zu nehmen, was Kapital und Ressourcen freisetzt.

Außerdem können Unternehmen, die eventuell alte Anwendungen und Datenbanken hatten, die Daten in einen kostengünstigeren Speichermechanismus verschieben. Unternehmen treffen ihre Entscheidungen zunehmend auf der Grundlage von Erkenntnissen, die sie aus Daten gewinnen. Für viele Unternehmen sind Data Lakes wirtschaftlicher als Data Warehousing, insbesondere wenn die Geschwindigkeit des Datenabrufs entscheidend ist.

Auswahl eines Data-Lake-Anbieters

Die Auswahl eines Anbieters hängt von der Art der Speicherplattform – On-Promises oder in der Cloud – sowie von der Datenverwaltung und den Datentypen des Unternehmens ab.

Data Lake Hosting. Data Lakes am eigenen Standort sind am effektivsten, wenn der Anwender in eine langfristige Infrastruktur investiert - einschließlich Speicherplatz, Strom, Hardware und Software - sowie in die für den Betrieb der Systeme erforderlichen Mitarbeiter. Data Lakes in der Cloud eignen sich am besten für Unternehmen, die auslagern wollen und eine flexible Infrastruktur benötigen.

Sicherheit. Die Übereinstimmung mit dem Sicherheits- und Zugriffsprofil des Unternehmens ist die wichtigste Eigenschaft, nach der man bei einem Anbieter von Cloud-Speicher für Data Lakes suchen sollte. Es gibt einen unvermeidlichen Kompromiss zwischen Sicherheit und einfachem Zugriff und Verarbeitung. Wenn Firmen mit einem Anbieter zusammenarbeiten, der im Gegensatz zu den Prioritäten die Sicherheit gegenüber der Benutzerfreundlichkeit in den Vordergrund stellt oder umgekehrt, werden Anwender vom ersten Tag an Schwierigkeiten haben.

Stellen Sie sicher, dass der Anbieter die Daten verschlüsselt, sowohl bei der Übertragung als auch im Ruhezustand.

Umgang mit Daten. Der Data Lake sollte alle Datentypen problemlos verarbeiten können, ob strukturiert, halbstrukturiert oder unstrukturiert. Unternehmen werden exponentiell alle Datenformen generieren, die bedient werden müssen.

Beispiele für Data Lake-Anbieter

Viele große Anbieter von Speichertechnologien, darunter IBM und HPE, können Unternehmen beim Aufbau eines Data Lake vor Ort unterstützen. Microsoft Azure und AWS sind die größten Cloud-basierten Data Lake-Anbieter.

- Data Lake on AWS kombiniert die wichtigsten AWS-Cloud-Services, die laut Anbieter zum Kennzeichnen, Durchsuchen, Freigeben, Analysieren und Verwalten von Teilmengen von Daten erforderlich sind. Zu den Funktionen gehören eine verwaltete Speicherebene, Verschlüsselung im Ruhezustand durch AWS Key Management Service und Flexibilität beim Datenzugriff.

- HPE bewirbt seinen Apollo 4200 Gen10 Plus Speicherserver als Baustein für einen modernen Data Lake. Er eignet sich für datenzentrierte Arbeitslasten und verfügt laut Hersteller über NVMe-Flash, persistenten Speicher sowie hohen Durchsatz und geringe Latenz, die für In-Place-Analysen erforderlich sind.

- IBM bietet die Bereitstellung von Data Lakes über seine Produkte Power und Spectrum Scale an. Unternehmen können zwischen On-Premises-, Cloud- und Hybrid-Optionen wählen. Durch eine Partnerschaft mit Cloudera bietet IBM Daten-Governance, Sicherheit und Analysen.

- Microsoft Azure Data Lake ist ein Cloud-Service, der Dateien in Petabyte-Größe und Billionen von Objekten speichert und analysiert. Microsoft verwaltet das Data-Lake-Produkt. Es umfasst die Verschlüsselung von Daten im Ruhezustand und bei der Übertragung, Multifaktor-Authentifizierung und Auditing.

Viele kleinere Anbieter – darunter Dremio und Databricks mit Delta Lake – drängen ebenfalls auf den Markt, was zu einem größeren Angebot an Optionen zu niedrigeren Preisen führen könnte. Wenn sich die aktuellen Trends fortsetzen, könnte sich eine umfassende Migration zu Data Lake Storage abzeichnen.

Herausforderungen

Data-Lake-Anwender sehen sich mit Problemen konfrontiert, insbesondere mit Kostenfragen, die sich aus der Speicherung, Aktualisierung und dem Abruf großer Datenmengen ergeben. Tatsächlich sind viele dieser Daten nutzlos.

Unternehmen horten immer mehr Daten und werden so zu „Hoardern“. Niemand möchte derjenige sein, der sagt: Löscht die Daten. In der Zwischenzeit können Data Lakes ohne eine konstante, aufmerksame Verwaltung allmählich an Effektivität verlieren. Das größte Risiko ist der so genannte „Datenfriedhof“, in dem potenziell relevante Daten zwischen unnötigen Dateien verloren gehen und so Metriken und Analysen verfälschen.