Malambo C/peopleimages.com - sto

GitHub Copilot versus ChatGPT: was unterscheidet die Tools?

GitHub Copilot und ChatGPT sind generative KI-Tools, die bei der Entwicklung und Optimierung von Softwarecode unterstützen. Erfahren Sie mehr über ihre Stärken und Schwächen.

GitHub Copilot und ChatGPT sind zwei Arten von generativen KI-Tools, die Programmierer bei der Anwendungsentwicklung unterstützen können. In diesem Artikel wird untersucht, wie sie funktionieren, welche Stärken und Schwächen sie haben, welche Ähnlichkeiten und Unterschiede sie aufweisen und welche Alternativen es zu diesen beiden Tools gibt.

Beginnen wir mit einer kurzen Zusammenfassung ihrer wichtigsten Gemeinsamkeiten und Unterschiede und gehen dann zu einer detaillierten Analyse der Funktionsweise der einzelnen Tools und ihrer jeweiligen Stärken und Schwächen über.

Die wichtigsten Gemeinsamkeiten und Unterschiede zwischen GitHub Copilot und ChatGPT

Beide Tools verwenden die Large Language Models (LLM) von OpenAI, um Ergebnisse zu generieren, aber auf unterschiedliche Weise. Hier ist eine Momentaufnahme ihrer wichtigsten Gemeinsamkeiten und Unterschiede.

Gemeinsamkeiten

- GPT-Modelle von OpenAI. Beide Tools verwenden OpenAI-Modelle, einschließlich OpenAI und GPT-4o, um bei der Programmierung zu unterstützen.

- Natural Language Processing (NLP). Entwickler können Fragen stellen oder die beabsichtigte Codegenerierung in natürlicher Sprache beschreiben.

- Als Assistenten fungieren. Beide können bei der Fehlerbehebung bei bestehendem Code bei der Codeentwicklung unterstützen.

- Steigerung der Entwicklerproduktivität. Beide Tools automatisieren viele Aspekte der Codeanalyse und -generierung.

Unterschiede

- Schwerpunkt. GitHub Copilot konzentriert sich auf Software- und Testingenieure. ChatGPT kann auch Anfänger unterstützen.

- Modellflexibilität. GitHub Copilot kann auch die LLMs von Anthropic Claude Sonnet und Google Gemini verwenden.

- Integration in die integrierte Entwicklungsumgebung. GitHub Copilot kann kontextbezogene Vorschläge direkt in der IDE bereitstellen, um den Arbeitsablauf zu optimieren und die automatische Vervollständigung zu verbessern. ChatGPT wird in einem separaten Fenster ausgeführt.

- Testen. GitHub Copilot kann während des Programmiervorgangs automatisch Tests generieren oder Code schreiben, der so konzipiert ist, dass er einen Test mit größerer Kontextsensibilität besteht. ChatGPT kann auch Tests schreiben, erfordert jedoch mehr Hin- und Her zwischen der IDE und dem Chat-Fenster.

„Beide stehen für die Zukunft des generativen KI-Erfahrungsdesigns, bei dem KI-gestützte Assistenten uns dabei helfen können, Aufgaben effizienter und effektiver zu erledigen“, sagt Jorge Torres, Mitbegründer und CEO von MindsDB. Mit der fortschreitenden Verbesserung der KI-Technologie werden wir immer ausgefeiltere KI-gestützte Assistenten sehen, die die menschliche Sprache und den Kontext genauer verstehen und komplexere und ausgefeiltere Ergebnisse generieren können.

Die Tools versprechen auch, Entwickler produktiver zu machen, indem sie das Schreiben von alltäglichem, standardisiertem Code automatisieren – und können Entwickler möglicherweise effektiver machen, indem sie ihnen mehr Zeit für anspruchsvollere Aufgaben lassen. So bietet beispielsweise die Copilot-Chat-Oberfläche von GitHub eine ChatGPT-ähnliche Erfahrung, um Code zu erklären, bewährte Verfahren vorzuschlagen, Tests zu generieren und Fehler zu beheben. GitHub hat außerdem neue Filter hinzugefügt, um das Risiko zu verringern, dass vorhandene Code-Snippets generiert werden, die möglicherweise Lizenzbeschränkungen auferlegen, und ein KI-basiertes System zur Vermeidung von Schwachstellen, um die Anzahl unsicherer Codes zu reduzieren.

„In Zukunft kann ein KI-Assistent, der ChatGPT ähnelt, wahrscheinlich direkt in IDEs integriert werden, sodass Entwickler mit ihm kommunizieren und ihn mit Routineaufgaben beauftragen können, wie zum Beispiel das Auschecken von Code aus Repositories, das Ausführen von Tests oder das Erstellen von Code“, erläutert Nikita Povarov, Team Lead für Datenanalyse und maschinelles Lernen bei JetBrains.

Wenn etwas schiefgeht, wie zum Beispiel ein Testfehler oder ein Absturz beim Erstellen, kann der Entwickler den Assistenten bitten, den Fehler zu identifizieren und einen Vorschlag zur Fehlerbehebung zu machen. Der KI-Assistent kann dies tun und so den Zeit- und Arbeitsaufwand für die Wartung der Codebasis reduzieren.

„Der Hauptunterschied [zwischen den beiden] ist die enge Integration von Copilot in Visual Studio Code und die Tatsache, dass Copilot mit riesigen Mengen an Code von GitHub und anderen Quellen trainiert wurde“, erklärt Guido Hoffmann, technischer Mitarbeiter bei Tech Soft 3D.

„Insgesamt ist Copilot ein großartiges Tool für schnelle, taktische Aufgaben, und ChatGPT ist besser für umfassendere Aufgaben geeignet. Wie jede neue Technologie haben beide Verbesserungspotenzial und werden mit der Zeit besser und fortschrittlicher werden“, sagt Agur Jõgi, CTO beim CRM-Plattformanbieter Pipedrive.

Was ist GitHub Copilot und wie funktioniert es?

GitHub Copilot, einer der beliebtesten Programmierassistenten, konzentriert sich speziell auf die Codevervollständigung und bietet Vorschläge für Codezeilen oder ganze Funktionen direkt in IDEs. Er wurde von GitHub und OpenAI entwickelt und basiert auf den Sprachmodellen von OpenAI.

Copilot-Benutzer können IDEs von JetBrains und direkt in Tools wie Visual Studio, VSCode und Neovim Hilfe verwenden. Mit diesen Funktionen kann Copilot einen großen Kontext von Code analysieren, ohne kurze Snippets auszuschneiden und in ChatGPT einzufügen.

GitHub Copilot verwendet LLMs, um Antworten und Vorschläge zu generieren. Benutzer können zwischen den GPT-Modellen von OpenAI, Anthropic Claude Sonnet und Google Gemini wechseln.

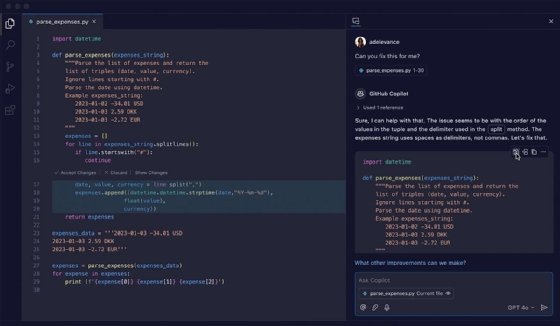

GitHub bietet auch Copilot Chat an, das Chat- und Terminal-Schnittstellen direkt in die IDE integriert. Es kann weitere Aspekte der Entwicklungserfahrung automatisieren. So kann es beispielsweise Codeänderungen erkennen und automatisch Beschreibungen, sogenannte Pull-Requests, für Software-Updates vorschlagen.

Das Tool bietet kontextbezogene Konversationen, um Code zu erklären, Fehler zu finden und Korrekturen vorzuschlagen. Es personalisiert auch Antworten, die mit der offiziellen Dokumentation verknüpft sind. Darüber hinaus kann es Softwaretests schreiben und fehlende Tests identifizieren, die möglicherweise erforderlich sind.

Was ist ChatGPT und wie funktioniert es?

ChatGPT, das von OpenAI entwickelt und im November 2022 eingeführt wurde, wird als separates Tool aufgerufen und eignet sich besser, um komplexen Code zusammenzufassen oder eine Startvorlage für eine bestimmte Programmieraufgabe zu erstellen. Seitdem sind zahlreiche andere KI-Chat-Tools zur Codegenerierung entstanden. Viele davon können unabhängig aufgerufen, in verschiedene Codeentwicklungs-Tools integriert oder als Funktion in einigen IDEs angeboten werden.

Das LLM von ChatGPT wird mit Daten aus der menschlichen Sprache trainiert. Als universell einsetzbare KI-Plattform für Konversationen, die NLP zur Beantwortung von Benutzereingaben verwendet, kann ChatGPT Antworten auf ein breiteres Spektrum von Fragen außerhalb der typischen Programmier-Workflows liefern.

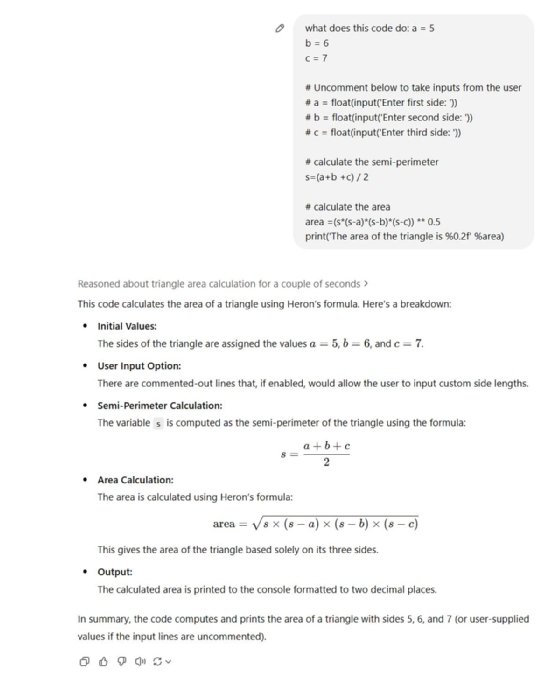

Der häufigste Anwendungsfall für ChatGPT in der Anwendungsentwicklung ist das Verstehen und Schreiben von Code auf der Grundlage der Aufgabenbeschreibung.

Stärken und Schwächen von GitHub Copilot und ChatGPT

Hier finden Sie eine Übersicht über die Stärken und Schwächen der einzelnen Tools.

GitHub Copilot

Stärken. GitHub Copilot zeichnet sich laut Torres durch die Generierung von Code-Snippets und Vorschlägen aus, die auf dem Kontext des zu schreibenden Codes basieren.

Copilot kann Codezeilen, Variablen und Funktionsnamen vorschlagen, die für den Kontext des Codes relevant sind, und es kann bei detaillierten Snippets helfen. GitHub Copilot fungiert auch als Codevervollständigungsagent, der Aufgaben erledigen kann, die die üblichen, in die IDE integrierten Codevervollständigungs-Tools nicht erledigen können.

Auf diese Weise können Entwickler Zeit sparen und effizienter programmieren. Darüber hinaus kann GitHub Copilot aus dem Code lernen, den Entwickler schreiben, wodurch seine Vorschläge und Genauigkeit im Laufe der Zeit verbessert werden.

Eine weitere Stärke von GitHub Copilot beim Schreiben von Code ist die Integration in die IDE, die es für die Echtzeit-Codierung effizienter macht als ChatGPT und laut Jõgi eine insgesamt bessere Benutzererfahrung für Programmierer bietet. „Da es in das GitHub-Ökosystem eingebettet ist, können Entwickler es nutzen, ohne den Kontext zu wechseln oder zusätzliche Tools zu öffnen“, sagt er.

Schwächen. Zu den Schwächen von GitHub Copilot gehört laut Torres, dass es falsche oder ineffiziente Code-Vorschläge generiert. Es ist möglicherweise auch nicht für komplexe Programmieraufgaben geeignet, die umfangreiches Wissen und Fachkenntnisse erfordern.

ChatGPT

Stärken. Die Stärken von ChatGPT liegen laut Torres in der Automatisierung von Kundenservice-Interaktionen und der Bereitstellung virtueller Unterstützung für verschiedene Aufgaben. Es kann auch textbasierte Inhalte wie Artikel, Geschichten und Zusammenfassungen generieren, was es für die Erstellung von Inhalten nützlich macht.

Povarov findet ChatGPT hilfreich, um eine Vielzahl von Codeantworten zu generieren und Codekonzepte zu erklären. Es ist auch für nicht-technische Interessengruppen besser geeignet und flexibler: Die Benutzer kommunizieren über eine Chat-Oberfläche mit einem Agenten, der praktisch jede Frage beantworten kann. Diese Flexibilität ermöglicht es den Benutzern, Fragen zu präzisieren und neu zu formulieren, was zu differenzierteren Antworten und Unterscheidungen führt.

Jõgi verwendet ChatGPT auch, um Funktions- und Unit-Tests zur Validierung von Ergebnissen zu generieren. Dies kann die testgetriebene Entwicklung optimieren.

Schwächen. Was die Mängel betrifft, so stellt Torres fest, dass ChatGPT mit komplexer oder technischer Sprache möglicherweise Schwierigkeiten hat und nicht immer genaue oder relevante Antworten generiert. Es ist möglicherweise auch nicht für Anwendungen geeignet, die Echtzeit-Interaktionen erfordern, wie zum Beispiel Spiele oder Handel.

Forscher haben in einer Studie festgestellt, dass ChatGPT Schwierigkeiten hatte, das gleiche Maß an Korrektheit, Konsistenz, Vollständigkeit und Prägnanz zu erreichen wie Antworten, die von Menschen auf Stack Overflow geschrieben wurden. Darüber hinaus stellten sie fest, dass 52 Prozent der Antworten von ChatGPT Ungenauigkeiten enthielten, 62 Prozent weniger prägnant waren als menschliche Antworten und 78 Prozent in unterschiedlichem Maße mit menschlichen Antworten inkonsistent waren.

Dennoch bevorzugten die Benutzer in etwa 39 Prozent der Fälle die ChatGPT-Antworten, da diese umfassender und sprachlich besser formuliert waren. Die Gefahr, so die Forscher, bestehe darin, dass Benutzer gelegentlich Fehler machen, indem sie falsche ChatGPT-Antworten bevorzugen, weil diese besser formuliert sind und scheinbar korrekte Logik mit positiven Aussagen präsentieren.

Alternativen zu GitHub Copilot und ChatGPT

GitHub Copilot und ChatGPT sind nicht mehr die einzigen Angebote. Einige Programmierassistenten, wie zum Beispiel Tabnine, waren sogar schon vor dem jüngsten Hype um die Verwendung von LLMs zur Codegenerierung auf dem Markt. Darüber hinaus wurden weitere programmierspezifische LLMs entwickelt, die eine verbesserte Fähigkeit zur sicheren Feinabstimmung der Modelle auf bestehenden oder proprietären Codebasen und Unternehmenscodierungspraktiken versprechen. In keiner bestimmten Reihenfolge finden Sie hier eine Liste vielversprechender Alternativen.

IBM watsonx Code Assistant verwendet vorab trainierte Modelle, die auf bestimmten Programmiersprachen basieren, um die Zuverlässigkeit und Effizienz zu verbessern. Er kann dazu beitragen, die Transparenz zu erhöhen, indem er Einblick in den potenziellen Ursprung des generierten Codes gibt, Code von einer Sprache in eine andere übersetzt oder veralteten Code modernisiert. watsonx Code Assistant für IBM Z unterstützt Unternehmen bei der Umgestaltung von COBOL in Java.

JetBrains hat KI-Codierungsassistenten und Chat-Funktionen in sein Portfolio an IDE-Tools integriert. Der JetBrains KI-Service unterstützt die Funktionen, die Benutzer mit verschiedenen LLMs verbinden. Der Assistent muss separat im JetBrains-Store installiert werden. Er umfasst eine Prompt-Bibliothek, KI-Chat, Dokumentationserstellung, Codeerklärung und die Erstellung von Commit-Nachrichten. Ask AI ist eine neue Funktion in der kollaborativen Datenwissenschaftsplattform Datalore von JetBrains, die die Programmierung in Python, R und SQL vereinfachen soll, indem sie die Codegenerierung und -änderung durch Befehle in natürlicher Sprache unterstützt.

Google bietet mehrere Tools zur Unterstützung bei der Programmierung an. Google Gemini Code Assist unterstützt die Codeanalyse und -entwicklung. Android Studio Bot bietet eine Konversationserfahrung wie ChatGPT für Android-Entwickler. Google Colab, eine Entwicklungsplattform für Datenwissenschaft, verwendet die für Code optimierten Codey-LLMs von Google, um größere Codeblöcke zu generieren und ganze Funktionen aus Prompts zu schreiben.

CodeGPT ist eine Open-Source-Erweiterung für Programmierassistenten, die innerhalb der Microsoft Visual Studio IDE ausgeführt wird. Es kann mit einer Vielzahl von LLMs verbunden werden, die für Code im Backend von OpenAI, Cohere, AI21 Labs, Meta und Anthropic optimiert sind. Es kann neuen Code direkt in der IDE erklären, verbessern und erstellen. Ein professioneller Service unterstützt Kontextmanagement, die Erstellung von KI-Agenten, die Synchronisierung von GitHub-Repositorys und andere Funktionen.

Cursor von Anysphere ist ein neuerer KI-gestützter Codeeditor, der auf generativen KI-Fähigkeiten basiert und KI-Copilot- und Chat-Interface-Elemente kombiniert, um Entwicklungsabläufe zu beschleunigen. Er enthält ein Tool zur Generierung von Code mit einer bestimmten Abhängigkeit und kann Fragen zu einer Codebasis beantworten, Bibliotheken von Drittanbietern analysieren und Code automatisch debuggen. Es gibt eine kostenlose Stufe für den Basiszugang. Zudem gibt es kostenpflichte Pläne, je nach Zugang, Funktionen und Kontrolle.

Einführung von Programmierassistenten

„Entwickler müssen bei der Einführung von Programmierassistenten und Chatbots vorsichtig vorgehen“, sagt Kevin Smith, CTO bei der Systemintegrationsberatung Dootrix.

Die erste große Herausforderung betrifft die Datensicherheit. „Wenn Sie sensible Daten in ChatGPT eingeben, verstoßen Sie möglicherweise gegen das Gesetz oder gegen die Geheimhaltungspflicht“, erläutert er. Es ist auch wichtig, sich über die Bedingungen im Klaren zu sein, unter denen Sie die Tools nutzen, und gegebenenfalls in alternative Pläne oder Vereinbarungen zu investieren.

Die neuen Tools erhöhen auch die Notwendigkeit der Rechenschaftspflicht. Diese Tools können Entwicklern unterstützen, produktiver zu sein, sollten aber keine Experten ersetzen. „Sie sollten ChatGPT wie einen Junior-Entwickler behandeln; Sie müssen seine Arbeit immer noch überprüfen, die Ergebnisse müssen möglicherweise noch erheblich überarbeitet werden, und in einigen Fällen kann es auch einfach falsch sein“, sagt Smith.

Wann Sie GitHub Copilot anstelle von ChatGPT verwenden sollten

GitHub Copilot ist direkt in die IDE integriert, sodass es Kontext für Code-Snippets bieten kann, um Vorschläge direkt im Workflow zu machen. Es kann das Ende einer Zeile, ganze Zeilen und manchmal sogar ganze Code-Blöcke vorschlagen, während der Entwickler tippt. Es bietet außerdem Folgendes:

- Erleichtert das Erlernen neuer Sprachen durch Bereitstellung von Beispielen und Vorlagen.

- Es markiert Fehler und empfiehlt Entwicklern Korrekturen, während sie tippen, ähnlich wie eine Rechtschreibprüfung. Dadurch kann Zeit gespart werden, die sonst für die spätere Behebung von Problemen aufgewendet werden müsste.

- Es ermöglicht die Generierung von Code aus Kommentaren, die beschreiben, was ein Codeabschnitt tun soll.

- Es automatisiert die Dokumentation.

Wann sollte man ChatGPT anstelle von GitHub Copilot verwenden?

ChatGPT eignet sich besser, wenn Sie eine kurze Frage zu einer vorhandenen Codebasis stellen oder einfache Code-Snippets in natürlicher Sprache generieren möchten. Es eignet sich besser für allgemeine Analysen und Untersuchungen.

Eine wesentliche Stärke liegt im Verständnis komplexer Codierungskonzepte oder Algorithmen beim Erlernen neuer Programmiersprachen, Algorithmen, APIs oder Programmierkonzepte. Es bietet außerdem Folgendes:

- Es bietet Einblicke bei der Fehlerbehebung und beim Debugging von vorhandenem Code.

- Entwickler können verschiedene Ansätze zur Lösung eines Problems untersuchen und entwerfen und die allgemeinen Vorzüge oder Einschränkungen jedes Ansatzes werden erläutert.

- Es werden Softwaredokumentationen und eine Übersicht über die Codestruktur für ein bestimmtes Problem erstellt.

- Es findet und wählt eine geeignete Codierungsbibliothek für eine bestimmte Aufgabe aus und bietet Anleitungen zu deren Verwendung.

GitHub ist die bessere Wahl, wenn es darum geht, KI-Codierungsvorschläge direkt in den Arbeitsablauf zu integrieren und Governance und Kontrollen für Codierungspraktiken durchzusetzen.

ChatGPT ist die bessere Wahl, wenn es darum geht, neue Konzepte kennenzulernen oder Erkenntnisse aus komplexen Codebasen zu gewinnen.

Die Zukunft der Programmierassistenten

Smith geht davon aus, dass die Fähigkeiten von Programmierassistenten immer umfassender werden, ähnlich wie jedes Textverarbeitungsprogramm über eine Rechtschreib- und Grammatikprüfung verfügt. Jedes Entwicklungswerkzeug wird irgendwann KI einsetzen, um den Durchsatz der Entwickler zu verbessern.

Die Tools werden wahrscheinlich auch durch Innovationen in der Entwicklererfahrung und der Programmierung von LLMs weiterentwickelt werden. Smith erwartet auch in Zukunft Verbesserungen durch spezifischere Modelle, die auf bestimmte Datensätze und Problemdomänen trainiert werden.

Langfristig können auch Programmierassistenten und Chat-Schnittstellen zusammenwachsen. „So wie wir uns alle für die Suchmaschine interessiert haben und kleine Suchfelder in all unseren Apps zu sehen begannen, wird vielleicht die Chat-Schnittstelle am Ende dominieren und die primäre Art und Weise sein, wie wir mit KI interagieren“, sagt Smith.

Anmerkung der Redaktion: Die oben genannte Liste wurde auf der Grundlage umfangreicher langfristiger Recherchen im Bereich der Codevervollständigungs-Tools und der Analyse einiger der führenden Akteure sowie neuerer Marktteilnehmer in diesem Bereich erstellt. Es sollte beachtet werden, dass auch eine neue Generation von LLMs in Betracht gezogen wurde, die entwickelt werden, um Codeassistent- und Chat-Funktionen auf Backend-Seite zu unterstützen, jedoch nicht direkt die Frontend-Entwicklererfahrung. Aus Gründen der Kürze und Klarheit haben wir uns in diesem Artikel nur auf die Tools konzentriert, die derzeit Codevervollständigungs- und Code-Chat-Funktionen auf der Frontend-Seite implementieren und in Verbindung mit einem oder mehreren Codevervollständigungs-LLMs auf der Backend-Seite funktionieren.