Gorodenkoff - stock.adobe.com

Ein Leitfaden zu Big Data in der Cloud

Wenn Unternehmen Big-Data-Projekte in die Cloud verlagern, müssen IT-Administratoren einiges beachten. Ein Leitfaden zum Big-Data-Management in der Cloud.

Unternehmen aller Größenordnungen wissen um den Wert von Daten und nutzen sie, um ihre Leistung zu messen, Probleme zu erkennen und neue Wachstumsmöglichkeiten zu finden. Big Data ist auch für maschinelles Lernen von zentraler Bedeutung, um komplexe Modelle zu trainieren und künstliche Intelligenz (KI) zu ermöglichen.

Big Data bietet zwar viele Vorteile, doch die schiere Menge an Rechenressourcen und Softwarediensten, die zur Unterstützung von Big Data benötigt werden, kann das finanzielle und intellektuelle Kapital selbst der größten Unternehmen überfordern. Die Cloud hat große Fortschritte gemacht, um den Bedarf an Big Data zu decken. Sie kann nahezu unbegrenzte Rechenressourcen und Dienste bereitstellen, die Big-Data-Initiativen für jedes Unternehmen möglich machen.

Im Folgenden wägen wir Kompromisse ab, bewerten Cloud-Modelle und betrachten, welche Dienste derzeit für Big Data in der Cloud verfügbar sind.

Was ist Big Data in der Cloud?

Big Data und Cloud Computing sind zwei völlig unterschiedliche Konzepte, die jedoch so eng miteinander verwoben sind, dass sie fast untrennbar sind. Es ist wichtig, beide Begriffe zu definieren und zu sehen, wie sie zusammenhängen.

Big Data

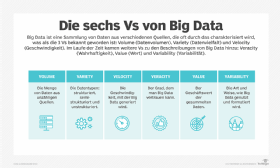

Big Data bezieht sich auf riesige Datenmengen, die strukturiert, semistrukturiert oder unstrukturiert sein können. Bei Big Data geht es um Analysen, die in der Regel verschiedene Quellen anzapfen, zum Beispiel aus Benutzereingaben, IoT-Sensoren und Verkaufsdaten.

Big Data bezieht sich auch auf die Verarbeitung enormer Datenmengen, um eine Anfrage zu beantworten oder einen Trend oder ein Muster zu erkennen. Die Daten werden durch eine Reihe mathematischer Algorithmen analysiert, die je nach Bedeutung der Daten, der Anzahl der beteiligten Quellen und der Absicht des Unternehmens variieren. Verteilte Softwareplattformen wie Apache Hadoop, Databricks und Cloudera werden verwendet, um solche komplexen Analysen aufzuteilen und zu organisieren.

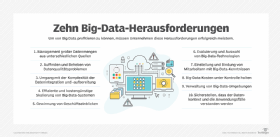

Das Problem bei Big Data ist die Größe der Computer- und Netzwerkinfrastruktur, die für den Aufbau einer Big-Data-Umgebung erforderlich ist. Die finanziellen Investitionen in Server, Speicher und dedizierte Netzwerke können beträchtlich sein, ebenso wie die Softwarekenntnisse, die für die Einrichtung einer effektiven verteilten Datenverarbeitungsumgebung erforderlich sind. Und wenn ein Unternehmen erst einmal in Big Data investiert hat, sind die Daten nur dann wertvoll, wenn sie in Betrieb sind – wenn sie nicht genutzt werden, sind sie wertlos. Die Anforderungen von Big Data haben dazu geführt, dass diese Technologie lange Zeit nur den größten und finanzstärksten Unternehmen vorbehalten war. Hier hat Cloud Computing einige Fortschritte gebracht.

Cloud Computing

Beim Cloud Computing werden Rechenressourcen und -dienste auf Abruf bereitgestellt. Ein Nutzer kann die gewünschte Infrastruktur aus Cloud-Recheninstanzen und -Speicherressourcen einfach zusammenstellen, Cloud-Dienste verbinden, Datensätze hochladen und Analysen in der Cloud durchführen. Die Nutzer können nahezu unbegrenzte Ressourcen in der Public Cloud nutzen, diese Ressourcen so lange wie nötig verwenden und dann die Umgebung wieder verlassen – sie zahlen nur für die Ressourcen und Dienste, die tatsächlich genutzt wurden.

Die Public Cloud hat sich zu einer idealen Plattform für Big Data entwickelt. Eine Cloud verfügt über die Ressourcen und Dienste, die ein Unternehmen bei Bedarf nutzen kann, ohne dass es die Infrastruktur selbst aufbauen, besitzen oder warten muss. Somit macht die Cloud Big-Data-Technologien für nahezu jede Unternehmensgröße zugänglich und erschwinglich.

Die Vorteile von Big Data in der Cloud

Die Cloud bietet Unternehmen aller Größenordnungen eine Reihe Vorteile. Die wichtigsten Argumente für Big Data in der Cloud sind:

Skalierbarkeit. Ein typisches Rechenzentrum eines Unternehmens stößt an seine räumlichen, energetischen und kältetechnischen Grenzen und hat nur ein begrenztes Budget für den Kauf und die Bereitstellung der riesigen Menge an Hardware, die für den Aufbau einer Big-Data-Infrastruktur erforderlich ist. Im Vergleich dazu verwaltet eine Public Cloud Hunderttausende von Servern, die über eine Flotte von globalen Rechenzentren verteilt sind. Die Infrastruktur und die Softwareservices sind bereits vorhanden, und die Benutzer können die Infrastruktur für ein Big-Data-Projekt von fast beliebiger Größe zusammenstellen.

Agilität. Nicht alle Big-Data-Projekte sind gleich. Für ein Projekt werden vielleicht 100 Server benötigt, für ein anderes aber 2.000 Server. Mit der Cloud können die Benutzer so viele Ressourcen einsetzen, wie sie für eine Aufgabe benötigen, und diese Ressourcen dann wieder freigeben, wenn die Aufgabe abgeschlossen ist.

Kosten. Ein Unternehmensrechenzentrum ist ein enormer Kapitalaufwand. Neben der Hardware müssen Unternehmen auch für Einrichtungen, Strom, laufende Wartung und Personal bezahlen. Bei der Cloud werden all diese Kosten in ein flexibles Mietmodell integriert, bei dem Ressourcen und Dienste nach Bedarf und nach einem Pay-per-Use-Modell verfügbar sind.

Erreichbarkeit. Viele Clouds bieten einen globalen Fußabdruck, der die Bereitstellung von Ressourcen und Diensten in den meisten wichtigen Regionen der Welt ermöglicht. Dadurch können Daten und Verarbeitungsaktivitäten in der Nähe der Region stattfinden, in der sich die Big-Data-Aufgabe befindet. Wenn beispielsweise ein Großteil der Daten in einer bestimmten Region eines Cloud-Anbieters gespeichert ist, ist es relativ einfach, die Ressourcen und Services für ein Big-Data-Projekt in dieser spezifischen Cloud-Region zu implementieren, anstatt die Kosten für die Verlagerung dieser Daten in eine andere Region zu tragen.

Ausfallsicherheit. Daten sind der eigentliche Wert von Big-Data-Projekten, und der Vorteil der Ausfallsicherheit der Cloud liegt in der Zuverlässigkeit der Datenspeicherung. Clouds replizieren Daten standardmäßig, um eine hohe Verfügbarkeit der Speicherressourcen aufrechtzuerhalten, und in der Cloud sind sogar noch langlebigere Speicheroptionen verfügbar.

Die Nachteile von Big Data in der Cloud

Public-Cloud-Umgebungen und viele Big-Data-Dienste von Drittanbietern haben ihren Wert für Big-Data-Anwendungen unter Beweis gestellt. Trotz der Vorteile müssen Unternehmen auch einige potenzielle Fallstricke berücksichtigen. Zu den wichtigsten Nachteilen von Big Data in der Cloud gehören:

Netzwerkabhängigkeit. Die Nutzung der Cloud hängt von einer vollständigen Netzwerkkonnektivität vom LAN über das Internet bis zum Netzwerk des Cloud-Anbieters ab. Ausfälle auf diesem Netzwerkpfad können im besten Fall zu erhöhten Latenzzeiten oder im schlimmsten Fall zu einer vollständigen Unzugänglichkeit der Cloud führen. Auch wenn sich ein Ausfall auf ein Big-Data-Projekt nicht in gleicher Weise auswirkt wie auf eine unternehmenskritische Arbeitslast, sollten die Auswirkungen von Ausfällen dennoch bei jeder Big-Data-Nutzung der Cloud berücksichtigt werden.

Speicherkosten. Die Datenspeicherung in der Cloud kann bei Big-Data-Projekten langfristig erhebliche Kosten verursachen. Die drei Hauptprobleme sind Datenspeicherung, Datenmigration und Datenaufbewahrung. Es kostet Zeit, große Datenmengen in die Cloud zu laden. Anschließend fallen für diese Speicherinstanzen monatliche Gebühren an. Wenn die Daten erneut verschoben werden, können weitere Gebühren anfallen. Außerdem sind große Datensätze oft zeitabhängig, was bedeutet, dass einige Daten auch noch Stunden in der Zukunft keinen Wert für eine Big-Data-Analyse haben können. Die Aufbewahrung unnötiger Daten kostet Geld, so dass Unternehmen umfassende Richtlinien zur Datenaufbewahrung und -löschung anwenden müssen, um die Kosten für die Cloud-Speicherung von Big Data zu verwalten.

Sicherheit. Die an Big-Data-Projekten beteiligten Daten können geschützte oder persönlich identifizierbare Informationen enthalten, die dem Datenschutz und anderen branchen- oder behördlichen Vorschriften unterworfen sind. Cloud-Benutzer müssen die notwendigen Schritte unternehmen, um die Sicherheit bei der Cloud-Speicherung und -Verarbeitung zu gewährleisten, indem sie sich angemessen authentifizieren und autorisieren, Daten im Ruhezustand und während der Übertragung verschlüsseln und ausführlich protokollieren, wie sie auf Daten zugreifen und sie verwenden.

Fehlende Standardisierung. Es gibt keine einheitliche Methode für den Aufbau, die Implementierung oder den Betrieb einer Big-Data-Bereitstellung in der Cloud. Dies kann zu einer schlechten Leistung führen und das Unternehmen möglichen Sicherheitsrisiken aussetzen. Geschäftsanwender sollten die Big-Data-Architektur zusammen mit allen Richtlinien und Verfahren im Zusammenhang mit ihrer Nutzung dokumentieren. Diese Dokumentation kann als Grundlage für Optimierungen und Verbesserungen in der Zukunft dienen.

Cloud-Bereitstellungsmodell

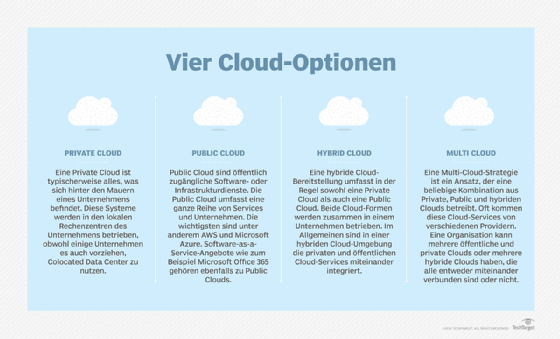

Welches Cloud-Modell ist ideal für eine Big-Data-Bereitstellung? Unternehmen haben in der Regel vier verschiedene Cloud-Modelle zur Auswahl: Public, Private, Hybrid und Multi-Cloud. Es ist wichtig, die Art und die Vorteile jedes Modells zu verstehen.

Private Cloud. Private Clouds geben Unternehmen die Kontrolle über ihre Cloud-Umgebung, oft um bestimmten gesetzlichen Vorschriften, Sicherheits- oder Verfügbarkeitsanforderungen gerecht zu werden. Sie sind jedoch kostspieliger, da ein Unternehmen die gesamte Infrastruktur besitzen und betreiben muss. Daher eignet sich eine Private Cloud nur für sensible Big-Data-Projekte in kleinem Umfang.

Public Cloud. Durch die Kombination von On-Demand-Ressourcen und Skalierbarkeit ist die Public Cloud ideal für Big-Data-Projekte fast jeder Größe. Allerdings müssen die Nutzer der Public Cloud die von ihr genutzten Cloud-Ressourcen und -Dienste verwalten. In einem Modell der geteilten Verantwortung kümmert sich der Public-Cloud-Anbieter um die Sicherheit der Cloud, während die Nutzer die Sicherheit in der Cloud konfigurieren und verwalten müssen.

Hybrid Cloud. Eine Hybrid Cloud ist nützlich, wenn bestimmte Ressourcen gemeinsam genutzt werden. Eine hybride Cloud ermöglicht beispielsweise die Speicherung großer Datenmengen in der lokalen privaten Cloud – so bleiben die Datensätze lokal und sicher – und die Public Cloud wird für Rechenressourcen und Big-Data-Analysedienste verwendet. Der Aufbau und die Verwaltung von Hybrid-Cloud-Umgebungen sind jedoch komplexer, und die Benutzer müssen sich mit allen Problemen und Herausforderungen auseinandersetzen.

Multi-Cloud. Mit mehreren Clouds können Anwender die Verfügbarkeit aufrechterhalten und Kostenvorteile auskosten. Allerdings sind die Ressourcen und Services in den verschiedenen Clouds selten identisch, so dass die Verwaltung mehrerer Clouds komplexer ist. Dieses Cloud-Modell birgt auch mehr Risiken in Bezug auf Sicherheitslücken und Compliance-Verstöße als die Nutzung einer einzelnen Public Cloud. In Anbetracht des Umfangs von Big-Data-Projekten kann die zusätzliche Komplexität von Multi-Cloud-Implementierungen die Bemühungen erschweren.

Big-Data-Dienste in der Cloud

Während die zugrunde liegende Hardware die meiste Aufmerksamkeit und das meiste Budget für Big-Data-Initiativen erhält, sind es die Services, also die Analyse-Tools, die Big-Data-Analysen erst möglich machen. Die gute Nachricht ist, dass Unternehmen, die Big-Data-Initiativen umsetzen möchten, nicht bei null anfangen müssen.

Die Anbieter bieten nicht nur Dienstleistungen und Dokumentation an, sondern stellen auch Support und Beratung bereit, um Unternehmen bei der Optimierung ihrer Projekte zu unterstützen. Eine Auswahl der verfügbaren Big-Data-Services der drei führenden Anbieter sind:

AWS

- Amazon Elastic MapReduce

- AWS Deep Learning AMIs

- Amazon SageMaker

Microsoft Azure

Google Cloud

- Google BigQuery

- Google Cloud Dataproc

- Google Cloud AutoML

Beachten Sie auch, dass es zahlreiche Dienste von Drittanbietern gibt. In der Regel bieten diese Anbieter eher Nischendienste an, während die großen Anbieter eine Einheitsstrategie für ihre Services verfolgen. Einige Optionen von Drittanbietern sind:

- Cloudera

- Hortonworks Data Platform

- Oracle Big Data Services

- Snowflake Data Cloud