Netzwerk-Switch

Was ist ein Netzwerk-Switch?

Ein Netzwerk-Switch verbindet Geräte in einem Netzwerk miteinander und ermöglicht es ihnen, durch den Austausch von Datenpaketen miteinander zu kommunizieren. Switches können Hardware-Geräte sein, die physische Netzwerke verwalten, oder softwarebasierte virtuelle Geräte.

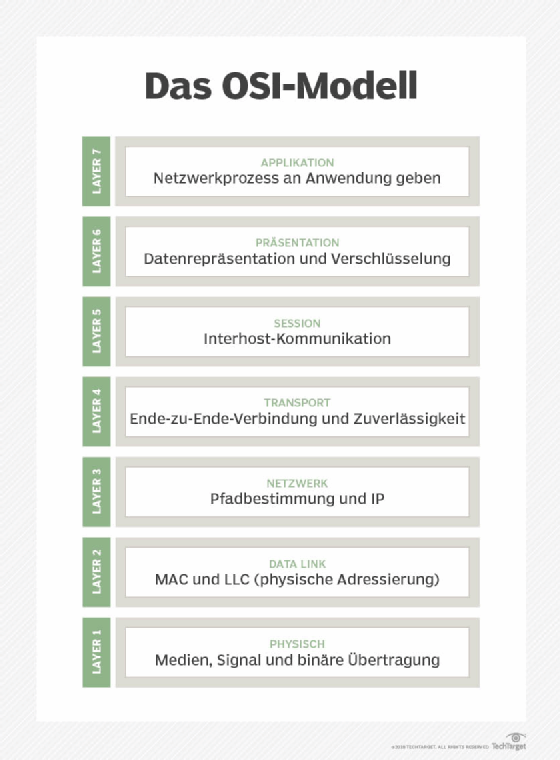

Ein Netzwerk-Switch arbeitet auf der Datenverbindungsschicht (Data Link Layer) oder Schicht 2 des OSI-Modells (Open Systems Interconnection). In einem lokalen Netzwerk (LAN), das Ethernet verwendet, bestimmt ein Netzwerk-Switch anhand der MAC-Adresse (Media Access Control), wohin er jeden eingehenden Nachrichtenrahmen (Message Frame) senden soll. Switches unterhalten Tabellen, die jede MAC-Adresse dem Port zuordnen, der die MAC-Adresse empfängt.

Warum sind Netzwerk-Switches so wichtig?

Switches sind für die Weiterleitung von Informationen zwischen verschiedenen Endpunkten zuständig und bieten eine Fülle von Vorteilen:

- Switches bilden die Mehrheit der Netzwerkgeräte in modernen Datennetzen und transportieren riesige Mengen an Datenverkehr in den Netzen der Telekommunikationsanbieter.

- Sie bieten Vollduplex-Kommunikation, verbinden Netzwerksegmente, steigern die Netzwerkleistung und nutzen die verfügbare Bandbreite effektiv.

- Switches stellen die kabelgebundenen Verbindungen zu Desktop-Computern, drahtlosen Zugangspunkten (Access Points, AP), Druckern, Industriemaschinen und einigen Geräten des Internets der Dinge (IoT), wie Karteneingabesystemen, her.

- Sie verbinden die Computer, die virtuelle Maschinen (VMs) in Rechenzentren hosten, sowie physische Server und einen Großteil der Speicherinfrastruktur.

- Die meisten modernen Switches arbeiten mit der Power-over-Ethernet-Technologie, die bis zu 100 Watt Leistung liefern kann, um die Konnektivität von Netzwerkgeräten zu unterstützen. Dies ermöglicht es Unternehmen, Geräte wie Außenbeleuchtung, Sicherheitskameras, Voice-over-IP-Telefone und verschiedene Arten von Sensoren zur Überwachung abgelegener Bereiche an Orten einzurichten, an denen eine separate Stromquelle nicht erforderlich ist.

- Daten von IoT-Geräten können von einem Netzwerk-Switch gesammelt und von Algorithmen der künstlichen Intelligenz (KI) und des maschinellen Lernens (ML) verwendet werden, um eine intelligentere Umgebung zu optimieren.

Wie funktioniert ein Netzwerk-Switch?

Alle Switches übertragen Daten von einem Standort zu einem anderen, aber ihre Hardware- und Softwarekonfigurationen können sehr unterschiedlich sein. Ein Netzwerk-Switch kann auf die folgenden Arten eingesetzt werden:

- Edge oder Access Switches. Diese Switches verwalten den Datenverkehr, der in das Netzwerk eintritt oder es verlässt. Geräte wie Computer und APs werden an Edge Switches angeschlossen.

- Aggregations- oder Verteilungs-Switches. Diese Switches befinden sich in einer optionalen mittleren Schicht in einer Netzwerktopologie. Edge Switches stellen eine Verbindung zu ihnen her und leiten den Datenverkehr von Switch zu Switch oder bis zu den Core Switches weiter.

- Core-Switches. Diese Netzwerk-Switches bilden das Backbone des Netzwerks. Core Switches verbinden Aggregations- oder Edge Switches, Benutzer oder Geräte-Edge-Netzwerke mit Rechenzentrumsnetzwerken und Unternehmens-LANs mit Routern.

Ein Datenrahmen (Data Frame) wird an alle Ports in der Switching-Domäne gesendet, wenn er an eine MAC-Adresse weitergeleitet wird, die der Switch-Infrastruktur nicht bekannt ist. Datenrahmen für Multicast und Broadcast werden ebenfalls an alle Ports gesendet. Dies wird als Broadcast, unknown unicast und multicast flooding bezeichnet. Diese Fähigkeit macht einen Switch zu einem Layer-2-Gerät im OSI-Kommunikationsmodell.

Viele Rechenzentren verwenden eine Spine-Leaf-Architektur, bei der die Aggregationsschicht entfällt. In diesem Design sind Server und Speicher an Leaf Switches (Edge Switches) angeschlossen. Jeder Leaf Switch ist mit zwei oder mehr Spine Switches (Core Switches) verbunden. Dadurch verringert sich die Anzahl der Sprünge, die die Daten von der Quelle zum Ziel benötigen, und damit auch die Latenzzeit.

Einige Rechenzentren richten ein Fabric- oder Mesh-Netzwerkdesign ein, bei dem jedes Gerät wie ein einziger großer Switch aussieht. Dieser Ansatz reduziert die Latenzzeit auf ein Minimum. Anspruchsvolle Anwendungen, die High Performance Computing (HPC) nutzen, verwenden häufig diesen Ansatz.

Für kleine Unternehmen und Heimnetzwerke bieten Netzwerk-Switches den Vorteil zusätzlicher Ethernet-Ports für den Anschluss an Gigabit-Ethernet.

Nicht alle Netzwerke verwenden jedoch Switches. Ein Netzwerk kann in einem Token Ring organisiert oder über einen Bus, Hub oder Repeater verbunden sein. In diesen Netzwerken sieht jedes angeschlossene Gerät den gesamten Datenverkehr und liest den an es gerichteten Datenverkehr. Ein Netzwerk kann auch aufgebaut werden, indem Computer direkt miteinander verbunden werden, ohne eine separate Schicht von Netzwerkgeräten. Dieser Ansatz ist vor allem für HPC geeignet, die Latenzzeiten von weniger als 5 Mikrosekunden benötigen und deren Entwurf, Verkabelung und Verwaltung recht komplex ist.

Welche Arten von Switches gibt es?

Es gibt verschiedene Arten von Switches in Netzwerken:

- Virtuelle Switches sind reine Software-Switches, die in VM-Hosting-Umgebungen eingesetzt werden.

- Routing Switches verbinden LANs. Zusätzlich zum MAC-basierten Layer-2-Switching führen sie Routing-Funktionen auf OSI-Layer 3 (Netzwerkschicht) aus und leiten den Datenverkehr auf der Grundlage der IP-Adresse in jedem Paket weiter.

- Bei Managed Switches kann der Benutzer jeden Port des Switches einstellen. Dies ermöglicht die Überwachung und Änderung der Konfiguration.

- Nicht verwaltete Switches ermöglichen Ethernet-Geräten die automatische Datenübertragung mittels Auto-Negotiation, bei der Parameter wie die Datenrate festgelegt werden. Die Konfiguration ist fest eingestellt und kann nicht bearbeitet werden.

- Intelligente Switches können so konfiguriert werden, dass sie mehr Kontrolle über die Datenübertragungen ermöglichen, haben aber im Vergleich zu verwalteten Switches mehr Einschränkungen. Diese so genannten Smart Switches werden auch als teilweise verwaltete Switches bezeichnet.

- Stackable Switches sind feste Switches, die über eine Backplane-Kabelschnittstelle miteinander verbunden werden können, um aus zwei oder mehr physischen Switches einen einzigen logischen Switch zu bilden.

- Modulare Switches sind Switch-Karten für modulare oder chassisbasierte Switches und können in ein großes Gehäuse mit festem Formfaktor eingesetzt werden, das zwei oder mehr Karten aufnehmen kann. Da die Switch-Schnittstellen je nach Bedarf ausgetauscht werden können, bietet diese Art von Switches die größte Flexibilität und Aufrüstbarkeit.

So richten Sie einen Netzwerk-Switch ein

Je nach Art des Netzwerks können verschiedene Arten von Switches verwendet werden. Für ein kleines Büro-LAN oder ein Heimnetzwerk wird ein Netzwerk-Switch normalerweise an einen der Ports eines Routers angeschlossen. Ein Switch erweitert die Anzahl der kabelgebundenen, mit dem Internet verbundenen Geräte in einem kleinen Netzwerk, darunter Desktops, Laptops und Drucker.

Die typischen Schritte bei der Einrichtung eines Netzwerk-Switches sind die folgenden:

- Der Switch wird entsprechend den Bedürfnissen und Anforderungen des Netzwerks gekauft.

- Der Port des Switches wird über ein Straight-Through-Kabel mit dem Router verbunden. Die meisten Switches verfügen über Uplink-Ports, die für die Verbindung mit Geräten wie Routern verwendet werden. Ist jedoch kein Uplink-Port an einem Switch vorhanden, kann jeder beliebige Port für die Verbindung mit dem Router verwendet werden.

- Sobald der Switch physisch mit dem Router verbunden ist, werden die IP-Adressen der Geräte konfiguriert.

Was sind die verschiedenen Verwendungszwecke für Netzwerk-Switches?

Ein Switch spielt eine entscheidende Rolle bei der Bereitstellung von Internet-Konnektivität und Netzwerkkommunikation in einem Netzwerk.

Im Folgenden werden die verschiedenen Anwendungsfälle für Netzwerk-Switches beschrieben:

- Durch die Automatisierung von Verbindungen, die manuelle und zeitaufwändige Einstellungen überflüssig macht, sorgen Netzwerk-Switches für effektive Konnektivität, Geschwindigkeit und Benutzerfreundlichkeit zwischen Netzwerkgeräten.

- Switches helfen beim Aufbau eines zuverlässigeren und sichereren Netzwerks, da sie ein gewisses Maß an Kontrolle über die Datenübertragung bieten.

- Netzwerk-Switches werden benötigt, wenn verschiedene Netzwerkgeräte über eine physische Verbindung angeschlossen werden müssen, da sie über mehrere Ports auf der Vorderseite verfügen. In der Regel handelt es sich bei diesen Anschlüssen um RJ-45-Anschlüsse für Ethernet-Kabel; die Anzahl der Anschlüsse kann jedoch variieren.

- Switches können auch im Vollduplex-Modus betrieben werden, der das gleichzeitige Senden und Empfangen von Daten über das Netzwerk ermöglicht. Im Vergleich zu Hubs, die nur den Halbduplex-Modus ermöglichen, vervierfachen Switches die Geschwindigkeit des Netzwerks praktisch.

- Netzwerk-Switches sind hilfreich für Heimnetzwerke und Szenarien, in denen regelmäßig leistungsstarke Streaming-Dienste genutzt werden. Sie sind besonders vorteilhaft, wenn man eine zuverlässige Möglichkeit zum Streamen oder Abspielen von 4K-Videos benötigt.

- Da Netzwerk-Switches eine Liste mit den eindeutigen MAC-Adressen aller angeschlossenen Geräte führen, wird der Großteil der Netzwerkkommunikation nur an das vorgesehene Ziel geleitet und nicht an alle angeschlossenen Geräte gesendet. Dadurch werden Kollisionen reduziert und Broadcast-Domänen in einem Netzwerk vermieden.

Netzwerk-Switch vs. Router

Netzwerk-Switches können leicht mit Routern verwechselt werden. Sie haben jedoch unterschiedliche Funktionen und arbeiten auf verschiedenen Ebenen.

Hier sind die wichtigsten Unterschiede zwischen einem Switch und einem Router:

- Ein Netzwerk-Switch ist ein Layer-2-Gerät im OSI-Modell. Ein Router ist in erster Linie ein Gerät der Schicht 3.

- Ein Router überträgt Daten zwischen zwei oder mehr Computernetzwerken, während ein Switch die gemeinsame Nutzung von Ressourcen erleichtert, indem er mehrere Geräte in einem einzigen LAN verbindet.

- Um die Route und das Ziel eines Pakets zu bestimmen, untersucht ein Router die IP-Adressen der Pakete. Ein Switch prüft die MAC-Adresse jedes Geräts, um die Daten an das richtige Ziel zu übertragen.

- Router verwenden Datenpakete, während Switches, die zur Datenübertragungsschicht gehören, normalerweise mit Datenrahmen arbeiten.

- Ein Switch ist weniger anspruchsvoll als ein Router, da er im Gegensatz zu einem Router keine Routing-Algorithmen verwendet, um Daten in großen Netzwerken zu leiten.

- Router können sowohl in verkabelten als auch in Wi-Fi-Netzwerken arbeiten, während ein Switch auf verkabelte Netzwerkverbindungen beschränkt ist.

- Ein Router bietet (Network Address Translation), NetFlow und Quality of Service (QoS), während ein Switch keinen dieser Dienste anbietet.

Netzwerk-Switch vs. Hub

Hier sind die Hauptunterschiede zwischen einem Switch und einem Hub:

- Während ein Netzwerk-Switch ein Layer-2-Gerät im OSI-Modell ist, ist ein Hub ein physisches Layer-1-Gerät.

- Ein Hub ist im Vergleich zu einem Netzwerk-Switch relativ einfach, da er im Gegensatz zu einem Switch die Adressen der Computer, an die er den Datenverkehr weiterleitet, nicht speichert.

- Das Ziel eines Hubs ist es, alle Knoten in einem Netzwerk zu verbinden, während ein Ethernet-Switch alle Netzwerkgeräte miteinander verbindet und Datenpakete zwischen diesen Geräten überträgt.

- Da ein Hub die ein- und ausgehenden Daten nicht wie ein Netzwerk-Switch verwalten kann, kommt es häufig zu Kommunikationskollisionen.

- Switches verhindern Kollisionen, indem sie Ethernet-Frames puffern, aber Hubs können Kollisionen nicht verhindern, da die Geräte über einen einzigen Übertragungsstrom verbunden sind.