Elnur - stock.adobe.com

Eigene KI-Dienste mit Azure OpenAI Service entwickeln

Mit Azure OpenAI Service können Entwickler auf das LLM von OpenAI in der Microsoft-Cloud zugreifen, um eigene KI-Anwendungen zu entwickeln und bereitzustellen.

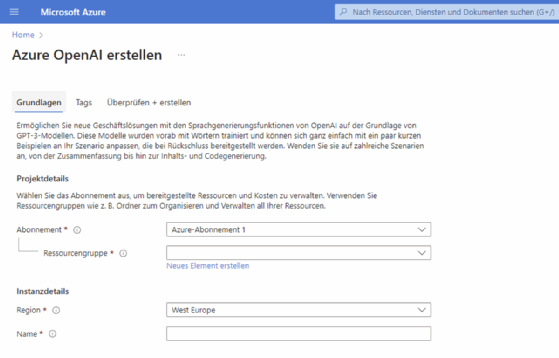

Microsoft stellt mit Azure OpenAI Service einen neuen Dienst zur Verfügung, mit dem Entwickler auf Basis der Large Language Models (LLM) von OpenAI eigene KI-Anwendungen entwickeln und in der Microsoft-Cloud bereitstellen können. Azure OpenAI Service vereint die OpenAI-API mit der Sicherheit, Compliance und regionale Verfügbarkeit von Azure auf Unternehmensebene.

Dabei können Entwickler auf die Authentifizierungsfunktionen von Entra ID sowie auf die zahlreichen Sicherheitsfunktionen, die in Azure zur Verfügung stehen, zugreifen, darunter rollenbasierte Berechtigungen und private Netzwerke. Für die Verwendung des Dienstes ist eine Bewerbung notwendig, die Entwickler online durchgehen können.

Durch den Einsatz von Sprachmodellen wie GPT-3 und GPT-4 kann der Azure OpenAI Service Texte generieren, die für eine Vielzahl von Anwendungen wie Inhaltserstellung, Chatbots und automatisierte Kunden-Support-Systeme geeignet sind. Ebenfalls Bestandteil ist Dall-E 2. Damit lassen sich über Azure OpenAI Service auch Bilder erstellen und in eigenen Anwendungen einbauen.

Die Sprachmodelle können für spezifische Anwendungsfälle angepasst werden, um eine höhere Relevanz und Genauigkeit in den Ergebnissen zu erzielen. Anwender können eigene Datensätze zur Schulung der Modelle verwenden, um die Erkennung branchenspezifischer Termini und Kontexte zu verbessern. Die Trainingsdaten bleiben dabei unter der eigenen Kontrolle.

Azure OpenAI Service ist auf Skalierbarkeit ausgelegt, was die Verarbeitung großer Datenmengen ermöglicht. Die Integration in die Azure-Infrastruktur bietet zudem erweiterte Sicherheitsfunktionen, um den Datenschutz und die Einhaltung von Compliance-Richtlinien sicherzustellen. Entwickler erhalten Zugriff auf umfassende Dokumentationen und APIs, um die Services in bestehende Systeme einzubinden. Die Kompatibilität mit anderen Azure-Diensten wie Azure Machine Learning ermöglicht eine tiefe technische Integration und die Erstellung komplexer KI-Lösungen.

Anwendungsfälle und Synergien mit Azure-Diensten

Azure OpenAI Service kann für eine Reihe von spezialisierten Anwendungsfällen eingesetzt werden, wobei die Integration mit anderen Azure-Diensten zu einer leistungsfähigen Gesamtlösung führt. Ein konkretes Beispiel ist die Optimierung von Kundeninteraktionen durch personalisierte Chatbots, die über den Azure KI Bot Service bereitgestellt und mit fortschrittlichen Sprachmodellen erweitert werden. Diese Kombination ermöglicht es, hochgradig interaktive und natürliche Gesprächserfahrungen zu schaffen.

In der Produktentwicklung und Marktforschung kann Azure OpenAI Service mit Azure Cognitive Services kombiniert werden, um Feedback und Kundenbewertungen in Echtzeit zu analysieren, Trends zu identifizieren und Produktempfehlungen zu generieren. Azure Machine Learning kann hierbei zusätzlich genutzt werden, um Prognosemodelle zu erstellen, die auf den Erkenntnissen der Sprachanalyse basieren.

Für die Automatisierung von Dokumentationsprozessen kann Azure OpenAI Service mit der Azure KI Dokument Intelligenz verbunden werden, um unstrukturierte Daten aus verschiedenen Dokumenttypen zu extrahieren, zu verarbeiten und in strukturierte Daten umzuwandeln. Anschließend können diese Daten von Sprachmodellen genutzt werden, um Zusammenfassungen zu erstellen oder automatisierte Antworten auf häufige Anfragen zu generieren.

In sicherheitskritischen Bereichen kann die Einbindung des Azure Security Center dazu beitragen, die durch OpenAI generierten Inhalte zu überwachen und zu sichern, während IAM-Services (Identity and Access Management) sicherstellen, dass nur autorisierte Benutzer auf die KI-Dienste zugreifen können. Durch diese Synergien zwischen Azure OpenAI Services und anderen Azure-Diensten können Unternehmen komplexe Probleme lösen, die Effizienz steigern und innovative Lösungen in ihren digitalen Produkten und Dienstleistungen implementieren.

Entwickler können Azure OpenAI Services mit verschiedenen Programmiersprachen verwenden, wobei die Umgebung am leistungsfähigsten mit Python arbeitet. Zu den weiteren unterstützten Sprachen gehören C#, JavaScript, Go, Perl, PHP, Ruby, Swift und TypeScript. Bezüglich der Entwicklungsumgebungen gibt es keine spezifischen Einschränkungen, da die Integration in der Regel über REST APIs erfolgt, die in nahezu jeder modernen integrierten Entwicklungsumgebung (IDE) verwendet werden können.

Azure OpenAI Studio und OpenAI Python SDK

Die Entwicklung von Anwendungen und die Verknüpfung mit anderen Diensten in Azure erfolgt über Azure OpenAI Studio. Die Entwicklung der eigenen Anwendungen kann in der gewünschten IDE erfolgen, zum Beispiel in Visual Studio.

Für die Entwicklung mit Azure OpenAI Service kann die Chat Completion-API genutzt werden. Mit dieser API übergeben Entwickler das KI-Prompt als Array von Nachrichten anstelle eines einzelnen Strings. Jede Nachricht in dem Array ist ein Wörterbuch, das eine Rolle und einen Inhalt enthält. Die Rolle gibt an, von wem die Nachricht kommt, während der Inhalt der Text der Nachricht selbst ist.

Die Entwicklung kann zum Beispiel mit dem OpenAI Python SDK erfolgen. Die OpenAI-Python-Bibliothek bietet Zugriff auf die OpenAI-REST-API aus Python-Anwendungen. Die Bibliothek enthält Typdefinitionen für Request-Parameter und Response-Felder und bietet synchrone als auch asynchrone Clients auf Basis von httpx. Die Zusammenarbeit funktioniert ab Python 3.7.

Generell ist eine solide Kenntnis der unterstützten Programmiersprachen, insbesondere Python, von Vorteil, da die Codex-Modelle in dieser Sprache am leistungsfähigsten sind. Daneben sollten sich Entwickler mit REST APIs vertraut machen, da diese für die Integration der Services wichtig sind.

Einschränkungen des Azure OpenAI Service

Der Azure OpenAI Service ist zwar vielseitig einsetzbar, jedoch nicht für jede Art von Aufgabe die optimale Lösung. Beispielsweise sind die Services nicht darauf ausgelegt, Echtzeitentscheidungen in kritischen Systemen oder in der direkten Steuerung von Industrieanlagen zu treffen, wo spezialisierte, auf Sicherheit ausgelegte Algorithmen benötigt werden. Ebenso sind sie nicht für den Einsatz in Umgebungen konzipiert, die eine vollständige Offline-Funktionalität erfordern, da sie eine ständige Verbindung zur Azure Cloud voraussetzen.

In Fällen, in denen eine granulare Kontrolle über das Modellverhalten und die Datenverarbeitung erforderlich ist oder spezielle Richtlinien bezüglich Datenhoheit und Verarbeitungsstandorten beachtet werden müssen, kann der direkte Zugriff auf die OpenAI API von größeren Vorteil sein. Die OpenAI API erlaubt eine tiefere Konfiguration und Personalisierung der Modelle, einschließlich der Möglichkeit, eigene Modelle zu trainieren, was eine größere Flexibilität in Bezug auf die Datenverarbeitung und Modellanpassung bietet. Dies ist besonders relevant in Szenarien, in denen proprietäre Daten nicht in die Cloud hochgeladen werden dürfen oder eine Verarbeitung auf spezifischen, selbst verwalteten Servern erfolgen muss.

Die aktuellen Preise für die Verwendung von GPT-4 im Azure OpenAI Service listet Microsoft in einem eigenen Blogbeitrag auf. Die Modelle bieten Funktionen zur Textzusammenfassung, Übersetzung und Sentimentanalyse. Die Abrechnung erfolgt auf Basis der üblichen Vorgehensweise in Azure, also der verwendeten Ressourcen.