Getty Images

Tipps für den richtigen Einsatz von Edge-Infrastrukturen

Bei Edge-Storage und -Infrastruktur sind mehrere Fragen zu stellen und Ansätze zu berücksichtigen. Ein Anwendungsbeispiel kann bei der Entscheidung über die Implementierung helfen.

Der Markt für Edge Computing wächst rasant, angetrieben durch neue Edge-Technologien, den Bedarf an Echtzeitanalysen und steigende Kosten in der Public Cloud.

Aber was ist Edge? Es gibt viele Definitionen von Edge, von entfernt liegenden Büros und Produktionsstätten – manchmal als Near Edge bezeichnet – bis hin zu Kommunikationstürmen, IoT-Geräten und autonomen Fahrzeugen, letzteres wird manchmal als Far Edge bezeichnet. Die Verwendungszwecke und Arbeitslasten variieren, einschließlich typischer Büroproduktivität, Anwendungen für Collaboration und VDI (Virtual Desktop Infrastructure).

Zum Edge oder nicht zum Edge?

Die wichtigsten Edge-Fragen für die IT sind die folgenden: Welche Anwendungen sollten sie am Edge ausführen, welche können sie effizient in einer Public Cloud ausführen und welche sollten sie in einem zentralen Rechenzentrum betreiben? Wie wirkt sich dies auf die Art der erforderlichen Infrastruktur aus? Die Antworten liegen in den Daten:

- Die Bewegung von Daten ist teuer und zeitaufwändig. Je größer das Volumen ist, desto kosteneffizienter ist es, die Daten dort zu speichern und zu analysieren, wo sie von den Benutzern erstellt oder eingegeben werden.

- Die Datensicherheit ist entscheidend. Dies hat sich bei häufigen Angriffen auf Daten gezeigt. Edge-Standorte sind vielleicht abgelegener und anfälliger für Angriffe, doch die Datenschutzbestimmungen können vorschreiben, dass die Daten lokal oder zumindest im Land gespeichert werden müssen, was eine strenge digitale und physische Überwachung erfordert.

- Der wahre Wert von Daten liegt in der Analyse, um verwertbare und zeitnahe Erkenntnisse zu gewinnen.Unternehmen können sofort auf standortspezifische Analysen reagieren, während umfassendere Erkenntnisse durch Nachbearbeitung in der Cloud gewonnen werden können.

Videoüberwachung unter den Top-Edge-Anwendungen

Darüber hinaus ist künstliche Intelligenz (KI) eine der wichtigsten neuen Edge-Anwendungen. Es ist sinnvoll, die von Edge-Geräten eingehenden Daten zu verarbeiten und zu speichern und Inferenzanalysen lokal durchzuführen, bevor die Ergebnisse zurück in ein zentrales Rechenzentrum oder eine Cloud übertragen werden. Beispiele hierfür sind Bilderkennung zur Fehlererkennung in der Fertigung, virtuelle Kundenerlebnisse im Einzelhandel oder Videoüberwachung zur Gewährleistung der Arbeitssicherheit in einem Lager. All diese Anwendungen erfordern eine Edge-Verarbeitung und -Analyse in Echtzeit.

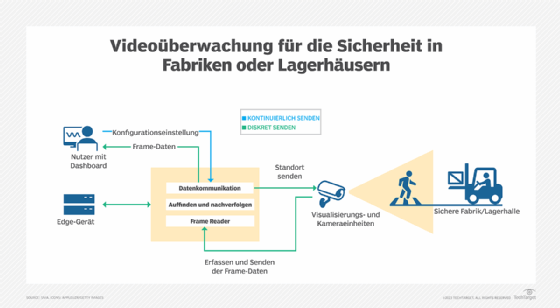

Zur Veranschaulichung: Von der Echtzeitvideoanalyse in Edge-Surveillance-Anwendungen wird erwartet, dass sie unverfälschte und genaue Ergebnisse liefert, wie das Beispiel der Sicherheitsüberwachung in einem Lagerhaus in Abbildung 1 zeigt. Die Anforderungen an die Datenerfassung, -speicherung und -verarbeitung sollten in der Anwendungsumgebung selbst spezifiziert werden, anstatt allgemeine Richtlinien anzuwenden, die für Cloud-Dienstanbieter oder andere lokale Infrastrukturen geeignet sind.

Bei einer Echtzeit-KI-Lagerhaus-Sicherheitsüberwachung umfassen die Leistungskennzahlen die Genauigkeit des KI-Schlussfolgerungsmodells, die Echtzeitverarbeitung des Modells mit den ermittelten Ergebnissen und die Systemlatenz, die die Zeit bis zum Ergebnis beeinflussen können. Um diese Metriken zu optimieren, sollten sich die Rechen-, Memory- und Storage-Ressourcen an dem Ort befinden, an dem die Daten erfasst werden, zum Beispiel in einem Videoüberwachungssystem. Abbildung 1 zeigt eine Beispielimplementierung, bei der ein Unternehmen ein Netzwerk von Videokameras in einer Lagerhaus-Sicherheitsanwendung einsetzt, um Verletzungen durch Gabelstapler zu vermeiden.

Bei einer Edge-Implementierung für die Videoanalyse müssen die Rechen-, Memory- und Storage-Ressourcen dynamisch und skalierbar sein und die Leistungsziele der Anwendung erfüllen. Im Edge-Datensammelnetzwerk – in diesem Fall Videokameras – müssen ausreichend eingebettete Rechen- und Memory-Ressourcen für jede Kamera und für das Edge-Verarbeitungsgerät zur Verfügung stehen.

Infrastrukturansätze umfassen HCI

Edge-Aggregationspunkte können physischen Standortbeschränkungen unterliegen, wie zum Beispiel der Unterbringung eines Server-Racks, eines Schrank-Servers oder sogar nur eines Geräts. Solche Beschränkungen können von der engen Kopplung oder Konsolidierung von Rechen- und Speicherressourcen in einem Server oder einer Appliance profitieren.

Es besteht zwar die Tendenz, eine kostengünstige Infrastruktur am Edge anzustreben, vor allem, wenn viele Edge-Standorte beteiligt sind, aber niedrige Kosten können auch geringe Fähigkeiten bedeuten. Für die IT-Abteilung ist es wichtig, die Infrastruktur an die Anforderungen der Arbeitslast in Bezug auf Rechen- und Speicherleistung anzupassen. Die gute Nachricht ist, dass neuere Infrastrukturen einen schnelleren ROI in Bezug auf die Effizienz der Leistung sowie den Platz- und Energiebedarf bieten können.

Die Verwaltung der Infrastruktur am Netzwerk-Edge sollte die Remote-Bereitstellung und -Verwaltung unterstützen. Dies ermöglicht die Nutzung von Workloads und Infrastrukturen an Standorten, an denen kein lokales IT-Personal vorhanden ist, und gewährleistet die Konsistenz über mehrere entfernte Standorte hinweg, was zu mehr Sicherheit und geringeren Betriebskosten führt.

Ein architektonischer Ansatz, der sich im Edge-Bereich durchgesetzt hat, ist die hyperkonvergente Infrastruktur (HCI). Dabei werden Rechen-, Netzwerk- und Speicherfunktionen auf jedem Server konsolidiert, so dass weniger Platz, Energie und Kühlung benötigt werden als bei herkömmlichen IT-Infrastrukturen.

Insgesamt ist es sinnvoll, diese Überlegungen bei der Auswahl der Infrastruktur für den Edge-Bereich zu berücksichtigen:

- Wählen Sie eine kosteneffiziente Architektur, die eine breite Palette von Workloads ausführen kann.Evaluieren Sie die Workloads, die Sie an jedem Edge-Standort ausführen möchten, auf der Grundlage des Datenvolumens, des Erfassungspunkts und des Bedarfs an standortspezifischen Erkenntnissen.

- Beurteilen Sie die Verarbeitungs- und Speicheranforderungen dieser Workloads. Stellen Sie sicher, dass die Rechen- und Speicherkapazität des Clusters den aktuellen Anforderungen entspricht. Viele HCI-Produkte bieten zum Beispiel Edge-optimierte Bereitstellungsoptionen mit weniger Knoten in einem Cluster. Sie verwenden Remote Witness Server für mehr Zuverlässigkeit oder ermöglichen die Erweiterung von Clustern über mehrere Standorte hinweg, um Ressourcen gemeinsam zu nutzen.

- Ermitteln Sie die Standortbedingungen der Infrastruktur. Handelt es sich um einen speziellen Schrank oder einen gemischt genutzten Schrank? Wie gut wird die Temperatur kontrolliert? Einige Server-OEMs bieten bei Bedarf robuste Hardware an.

- Planen Sie die Möglichkeit der Fernverwaltung ein. Viele Edge-Plattformen haben in den letzten Generationen ihre Remote-Bereitstellungs- und -Verwaltungsfunktionen verbessert, so dass ein konsistenter Bereitstellungsprozess über mehrere Edge-Standorte hinweg repliziert werden kann.

Die beste Infrastruktur für Ihre Edge-Standorte kann variieren. Da Edge-Anwendungen und -Workloads wachsen und sich weiterentwickeln – einschließlich künstlicher Intelligenz, vertikal-spezifischer Workloads und Standard-Büro- und Remote-Arbeitsanwendungen – ist es wichtig, Infrastrukturoptionen zu evaluieren, um sicherzustellen, dass sie die Anforderungen an sichere und leistungsfähige Rechen-, Netzwerk- und Speicherlösungen erfüllen, um den wachsenden Betrieb zu unterstützen.

Über die Autoren: Christine McMonigal ist Vorsitzende des Networking Storage Forum (NSF) der Storage Networking Industry Association (SNIA). David McIntyre ist Marketing-Vorsitzender des SNIA NSF.

SNIA ist eine gemeinnützige globale Organisation, die sich aus Mitgliedsunternehmen aus dem gesamten Speichermarkt zusammensetzt. SNIA hat es sich zur Aufgabe gemacht, die Speicherindustrie bei der Entwicklung und Förderung von herstellerneutralen Architekturen, Standards und Bildungsdienstleistungen anzuführen, die die effiziente Verwaltung, Bewegung und Sicherheit von Informationen erleichtern.

SNIA's NSF vermittelt Einblicke und Führungsqualitäten für die Anwendung vernetzter Speicher und zugehöriger Technologien in einem breiten Spektrum von End-to-End-Diensten. Diese Expertengemeinschaft deckt so unterschiedliche Themen wie Block-, Datei- und Objektspeicher, virtualisierte und hyperkonvergente Plattformen sowie Einblicke in Cloud-to-Edge-Infrastrukturen, Beschleuniger und unterstützte Programmier-Frameworks ab.