sarayut_sy - stock.adobe.com

Warum künstliche Intelligenz überprüfbar sein muss

Künstliche Intelligenz (KI) muss überprüfbar sein. Das gilt umso mehr, da die Geschäftswelt KI bereits in der Praxis für bessere Entscheidungen nutzt und skaliert.

IT-Branchengrößen planen mittlerweile die Etablierung von Ethikteams, die für die Evaluation des Verhaltens von Algorithmen verantwortlich sein sollen, berichtete das Wall Street Journal im Herbst 2021.

Das ist in jedem Fall ein Schritt in die richtige Richtung, aber leider nicht genug. Denn KI-gestützte Geschäftsentscheidungen müssen mehr als nur erklärbar, ethisch und verantwortlich sein. KI muss überprüfbar sein (auditierbare KI) – insbesondere, da der Mainstream der Geschäftswelt den Einsatz von KI nicht mehr theoretisch verfolgt, sondern in der Praxis für bessere Entscheidungen nutzt und skaliert. Überprüfbare KI stellt die Dokumente und Berichte über sich selbst zur Verfügung, die es für eine regulatorische Überprüfung braucht. Dabei werden in der Regel folgende Fragen gestellt:

- Welche Daten wurden genutzt, um das Machine-Learning-Modell aufzusetzen? Waren die Daten für den Einsatz in der Praxis repräsentativ? Wie wurde das Thema Voreingenommenheit der Daten in der Entwicklungsphase adressiert?

- Was sind die abgeleiteten Variablen im Modell? Sind sie voreingenommen? Wurden die Variablen von einem Governance-Team für den Einsatz im Modell freigegeben?

- Welche spezifischen Machine-Learning-Algorithmen wurden verwendet? Sind sie für die Daten und das zu lösende Problem geeignet?

- Ist das Modell umfänglich erklärbar und mit genauen Begründungs-Codes hinterlegt, die die automatisierten Entscheidungen detailliert darlegen, die das Modell macht? Sind die Codes für den Modellanwender und andere Betroffene erklärbar?

- Ist das Modell so aufgesetzt, dass es interpretierbar ist? Was sind latente Merkmale, die das Ergebnis beeinflussen? Sind diese auf Voreingenommenheit getestet?

- Welche Stabilitätstests hat das Modell durchlaufen, um Veränderungen in Produktionsdaten zu verstehen und zu korrigieren?

- Gibt es spezifische Monitoring-Anforderungen, die sicherstellen, dass Datenveränderung, Leistungsabfall oder zu wenig ethische Überprüfung kontrolliert werden?

- Welche Mechanismen werden eingesetzt, um auf ein sichereres Modell auszuweichen, wenn sich die Daten im Einsatz gegenüber den Daten, auf denen das Modell trainiert wurde, verändern?

- Wie erkennt das Modell feindliche KI-Angriffe und wie geht es damit um?

Auch wenn das Wort Audit eine nachträgliche Kontrolle impliziert, betont auditierbare KI die Prüfung des Modells, während es aufgesetzt wird und bevor es zum Einsatz kommt, um Compliance zu gewährleisten und deren Einhaltung auch während der Produktion zu überwachen.

Kontrollierbare künstliche Intelligenz macht Responsible AI real, indem ein Auditpfad vom dokumentierten Standard eines Unternehmens für die Kontrolle bei der Modellentwicklung geschaffen wird. Das bringt zusätzliche Vorteile: Indem früh genug verstanden wird, wenn ein Modell versagt, können sich Unternehmen viel Ärger ersparen sowie negative Auswirkungen auf die Reputation und Rechtsstreitigkeiten vermeiden.

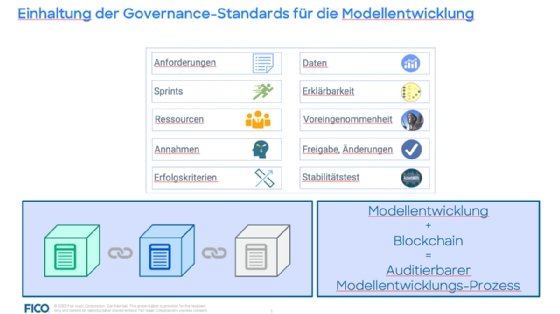

Auditierbare KI stellt sicher, dass die KI-Standards eines Unternehmens eingehalten werden, indem wichtige Entscheidungen und Ergebnisse im Modellentwicklungsprozess dokumentiert werden. Auch wenn es nicht einfach ist, zu definieren, welche Informationen dafür gemessen, überprüft und freigegeben werden müssen – es zu tun, bringt Unternehmen zwei unschätzbare Vorteile: Informationen zur Modellentwicklung bleiben für immer erhalten und können auch von neuen Data Scientists später für Reviews und Audits herangezogen werden. Außerdem ist ein größeres Vertrauen in die Modellentwicklung möglich, weil sie dem dokumentierten Standard des Unternehmens entspricht und Abweichungen davon vermeidet.

Was ist für auditierbare KI notwendig?

Ohne Standards und Guidelines für die Modellentwicklung können Unternehmen keine Audits erstellen, die Compliance durchgängig gewährleisten und sicherstellen, dass die Daten für die Modellentwicklung fair, unvoreingenommen und sicher sind. Viele Unternehmen leiden auch unter den verschiedenen Data-Science-Philosophien, die ihre Data Scientists unter Umständen verfolgen.

Manchmal werden kritische Bestandteile der Modell-Governance einfach außer Acht gelassen. Deswegen ist es so wichtig, dass Data Scientists und Unternehmen von der Entwicklung bis zum Einsatz von KI-Modellen einen gemeinsamen Standard verfolgen.

„Indem früh genug verstanden wird, wenn ein Modell versagt, können sich Unternehmen viel Ärger ersparen sowie negative Auswirkungen auf die Reputation und Rechtsstreitigkeiten vermeiden.“

Scott Zoldi, FICO

Für die Entwicklung von kontrollierbarer KI sollten Unternehmen und KI-Verantwortliche daher folgende acht Schritte mit entsprechenden Fragestellungen durchgehen:

- Wie ist das Analytikteam strukturiert? Gibt es eine Führungsperson oder eine Matrix aus mehreren Verantwortlichen? Wenn es mehrere Verantwortliche gibt: Wie gut arbeiten sie zusammen und stimmen sie sich ab?

- Wie ist das Kontrollteam strukturiert? Wie werden Entscheidungen darüber, was in KI-Algorithmen akzeptabel ist und der Unternehmensphilosophie zu KI entspricht, getroffen? Wie werden Standards dokumentiert?

- Wie wird Responsible KI adressiert? Gibt es ein aktives Monitoring-Programm? Falls ja, wie arbeitet es? Sind unveränderbare Blockchain-Technologien im Einsatz, damit dokumentiert werden kann, ob und wie der Standard für jedes Modell eingehalten wurde? So ein System bleibt erhalten, auch wenn sich Personal oder Unternehmen verändern.

- Wie sehen das Datenethik-Programm und Regelungen zur Datennutzung aus? Wie werden synthetische Daten getestet und genutzt? Welche Stabilitätstest werden durchgeführt, damit die Modelle auch in sich verändernden Einsatzumgebungen effektiv funktionieren?

- Was sind die Standards für die KI-Entwicklung? Welche Tools und Assets stehen zur Verfügung? Welche Algorithmen sind erlaubt, welche nicht? Auditierbare KI verlangt zunehmend Standard-Tools und Standard-Variablenbibliotheken. Wie werden diese ausgewählt und instandgehalten? Gibt es allgemeine Code-Grundlagen und tägliche Regressionstests? Wie werden angelernte latente Merkmale extrahiert und hinsichtlich Eignung, Stabilität und Voreingenommenheit getestet?

- Wie erreicht das Unternehmen ethische KI? Welche KI-Technologien dürfen eingesetzt werden? Wie werden sie getestet, damit sichergestellt ist, dass sie für den Einsatz in der Praxis taugen? Wird jedes Modell geprüft und wenn ja, was wird geprüft? Wird berücksichtigt, dass sich Daten, Performance und ethische Betrachtung verändern? Welche Grenzen sind gesetzt, damit angezeigt wird, wenn ein Modell nicht länger genutzt werden sollte?

- Was ist die Unternehmensphilosophie rund um KI-Forschung? Möchte das Unternehmen erfinderisch agieren und damit eher höhere Risiken bei seinen KI-Investitionen tolerieren? Oder ist das Unternehmen eher konservativ und möchte sichergehen, dass nur geprüfte Technologie eingesetzt wird, die reguliert und einfach zu kontrollieren ist? Oder steht es für einen hybriden Ansatz mit zwei Teams im Einsatz – wobei das eine zeigt, was alles mit KI möglich ist, und das andere, wie man KI in der Praxis einsetzen kann?

- Ist die Firma einheitlich in Bezug auf KI? Stellt sie nur einige Modelle unter Responsible-KI- Regularien, andere aber nicht? Wie sind diese beiden Ansätze ggf. aufgesetzt? Ist es in Ordnung, Responsible KI außer Acht zu lassen? Wenn ja, in welchem Fall?

Zugegeben, das sind sehr viele Fragen und das Ziel, auditierbare KI zu erreichen, mag auf den ersten Blick schwer erreichbar erscheinen. Aber die gute Nachricht ist, dass es Best Practices und Ansätze dafür gibt, die einfach übernommen werden können. Auf jeden Fall ist auditierbare KI eine Notwendigkeit. Die Zukunft von KI und der Business-Welt, wie wir sie kennen, hängt davon ab, dass diese mächtige Technologie bestens gemanagt und kontrolliert wird.

Über den Autor:

Dr. Scott Zoldi ist Chief Analytics Officer bei FICO und verantwortlich für die analytische Entwicklung der Produkt- und Technologielösungen von FICO. Während seiner Tätigkeit im Unternehmen war Scott Zoldi bisher für die Entwicklung von mehr als 100 Analytics-Patenten verantwortlich, von denen 65 erteilt und 45 eingereicht wurden. Scott Zoldi ist Mitglied in den beiden Vorständen von Software San Diego und Cyber Center of Excellence. Er hat seinen Doktortitel in theoretischer und rechnergestützter Physik an der Duke University erworben. Er bloggt unter www.fico.com/blogs/author/scott-zoldi.

Die Autoren sind für den Inhalt und die Richtigkeit ihrer Beiträge selbst verantwortlich. Die dargelegten Meinungen geben die Ansichten der Autoren wieder.