Software-defined Networking (SDN)

Das Ziel von SDN ist die Verbesserung der Netzwerkkontrolle, indem Unternehmen und Dienstanbieter in die Lage versetzt werden, schnell auf sich ändernde Geschäftsanforderungen zu reagieren.

In einem softwaredefinierten Netzwerk kann ein Netzwerkingenieur oder -administrator den Datenverkehr von einer zentralen Steuerkonsole aus kontrollieren, ohne einzelne Switches im Netzwerk berühren zu müssen. Der zentrale SDN-Controller weist die Switches an, Netzwerkdienste unabhängig von den spezifischen Verbindungen zwischen einem Server und den Geräten überall dort bereitzustellen, wo sie benötigt werden.

Dieser Prozess ist eine Abkehr von der traditionellen Netzwerkarchitektur, bei der einzelne Netzwerkgeräte Traffic-Entscheidungen auf der Grundlage ihrer konfigurierten Routing-Tabellen treffen.

SDN-Architektur

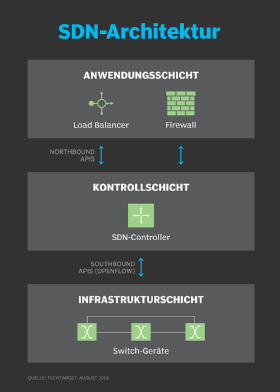

Eine typische Darstellung der SDN-Architektur besteht aus drei Schichten: der Anwendungsschicht (Application Layer), der Kontrollschicht (Control Layer) und der Infrastrukturschicht (Infrastructure Layer).

Die Anwendungsschicht enthält wenig überraschend die typischen Netzwerkanwendungen oder Funktionen, die Unternehmen verwenden, wie Intrusion Detection Systeme (IDS), Load Balancer oder Firewalls. Wo ein traditionelles Netzwerk eine spezialisierte Appliance wie eine Firewall oder einen Load Balancer verwenden würde, ersetzt ein softwaredefiniertes Netzwerk die Appliance durch eine Anwendung, die den Controller zur Verwaltung des Verhaltens der Datenebene verwendet.

Die SDN-Architektur trennt das Netzwerk in drei verschiedene Schichten, die über APIs für den Nord- und Südverkehr (Northbound und Southbound) miteinander verbunden sind.

Die Steuerungsschicht stellt die zentrale SDN-Controller-Software dar, die als Gehirn des softwaredefinierten Netzwerks fungiert. Dieser SDN-Controller befindet sich auf einem Server und verwaltet die Richtlinien und den Verkehrsfluss im gesamten Netzwerk.

Die Infrastrukturschicht besteht aus den physischen Switches im Netzwerk.

Diese drei Schichten kommunizieren unter Verwendung der jeweiligen Programmierschnittstellen (API) für die Nord- und Südrichtung. Beispielsweise sprechen Anwendungen mit dem Controller über sein Northbound Interface, während der Controller und die Switches über die Southbound-Schnittstellen kommunizieren, wie das etwa bei OpenFlow und anderen SDN-Protokollen der Fall ist.

Es gibt derzeit keinen formalen Standard für die Northbound-API des SDN-Controllers, der mit OpenFlow als allgemeine Southbound-Schnittstelle übereinstimmt. Es ist möglich, dass sich die Northbound-API des OpenDaylight-Controllers im Laufe der Zeit zu einem De-facto-Standard entwickeln könnte, da sie von einem breiten Anbieterkreis unterstützt wird.

Wie SDN funktioniert

SDN umfasst mehrere Arten von Technologien, darunter funktionale Trennung, Netzwerkvirtualisierung und Automatisierung durch Programmierbarkeit.

Ursprünglich konzentrierte sich die SDN-Technologie ausschließlich auf die Trennung der Netzwerksteuerungsebene (Network Control Plane) von der Datenebene (Data Plane). Während die Steuerungsebene Entscheidungen darüber trifft, wie Pakete durch das Netzwerk fließen sollen, bewegt die Datenebene die Pakete tatsächlich von Ort zu Ort.

In einem klassischen SDN-Szenario kommt ein Paket bei einem Netzwerk-Switch an, und in die proprietäre Firmware des Switches integrierte Regeln teilen dem Switch mit, wohin das Paket weitergeleitet werden soll. Diese Paketverarbeitungsregeln werden von der zentralen Steuerung an den Switch gesendet.

Der Switch – ein Data Plane Device – fragt den Controller bei Bedarf nach einer Anweisung ab und liefert dem Controller Informationen über den von ihm abgewickelten Verkehr. Der Switch sendet jedes Paket, das zum gleichen Ziel geht, auf dem gleichen Pfad und behandelt alle Pakete auf genau die gleiche Weise.

Software-defined Networking verwendet einen Betriebsmodus, der manchmal als adaptiv oder dynamisch bezeichnet wird. Hierbei gibt ein Switch eine Routenanforderung an einen Controller für ein Paket aus, das keine bestimmte Route hat. Dieser Prozess ist von der adaptiven Weiterleitung getrennt, bei der die Anforderungen für die Weiterleitung durch Router und Algorithmen auf der Grundlage der Netzwerktopologie und nicht durch einen Controller ausgegeben werden.

Der Virtualisierungsaspekt von SDN kommt durch ein virtuelles Overlay ins Spiel, das ein logisch getrenntes Netzwerk über dem physischen Netzwerk darstellt. Benutzer können End-to-End-Overlays implementieren, um das zugrunde liegende Netzwerk zu abstrahieren und den Netzwerkverkehr zu segmentieren. Diese Mikrosegmentierung ist besonders nützlich für Dienstanbieter und Betreiber mit Mehrmandanten-Cloud-Umgebungen und -Cloud-Diensten, da sie so ein separates virtuelles Netzwerk mit spezifischen Richtlinien für jeden Mandanten bereitstellen können.

Vorteile von SDN

Mit Software-defined Networking kann ein Administrator bei Bedarf die Regeln jedes Netzwerk-Switches ändern, indem er bestimmte Arten von Paketen priorisiert, herabstuft oder sogar blockiert, und zwar mit einem granularen Grad an Kontrolle und Sicherheit. Dies ist besonders hilfreich in einer Mehrmandantenarchitektur bei Cloud-Computing, da der Administrator dadurch die Verkehrslasten flexibel und effizienter verwalten kann. Im Wesentlichen ermöglicht dies ihm, kostengünstigere Commodity-Switches zu verwenden und mehr Kontrolle über den Netzwerkverkehrsfluss als je zuvor zu haben.

Weitere Vorteile des SDN sind das Netzwerkmanagement und die End-to-End-Sichtbarkeit. Ein Netzwerkadministrator muss sich nur mit einem zentralen Controller befassen, um Richtlinien an die angeschlossenen Switches zu verteilen, anstatt mehrere einzelne Geräte zu konfigurieren. Diese Fähigkeit ist auch ein Sicherheitsvorteil, da der Controller den Datenverkehr überwachen und Sicherheitsrichtlinien bereitstellen kann. Wenn der Controller den Datenverkehr für verdächtig hält, kann er beispielsweise die Pakete umleiten oder verwerfen.

SDN virtualisiert auch Hardware und Dienste, die zuvor von dedizierter Hardware ausgeführt wurden, was zu den angekündigten Vorteilen eines geringeren Hardwarebedarfes und geringerer Betriebskosten führt.

Darüber hinaus trug Software-defined Networking zur Entstehung der softwaredefinierten Weitverkehrsnetzwerktechnologie (SD-WAN) bei. SD-WAN nutzt den virtuellen Overlay-Aspekt der SDN-Technologie, indem es die Konnektivitätsverbindungen einer Organisation im gesamten Wide Area Network WAN abstrahiert und ein virtuelles Netzwerk schafft, das die Verbindung nutzen kann, die der Controller für den Datenverkehr für geeignet hält.

Herausforderungen bei SDN

Sicherheit ist bei der SDN-Technologie sowohl ein Vorteil als auch ein Bedenken. Der zentralisierte SDN-Controller stellt eine einzige Fehlerstelle dar und kann sich, wenn er von einem Angreifer ins Visier genommen wird, als schädlich für das Netzwerk erweisen.

Ironischerweise besteht eine weitere Herausforderung bei SDN darin, dass es in der Netzwerkbranche keine wirklich etablierte Definition des softwaredefinierten Netzwerks gibt. Verschiedene Anbieter bieten verschiedene Ansätze für SDN an, die von hardwarenahen Modellen und Virtualisierungsplattformen bis hin zu hyperkonvergente Netzwerkdesigns und Controller-losen Methoden reichen.

Einige Netzwerkinitiativen werden oft mit SDN verwechselt, darunter White Box Networking, Netzwerk-Disaggregation, Netzwerkautomatisierung und programmierbare Netzwerke. Obwohl SDN von diesen Technologien und Prozessen profitieren und mit ihnen arbeiten kann, bleibt es eine separate Technologie.

Die SDN-Technologie entstand mit einem großen Hype um 2011, als sie zusammen mit dem OpenFlow-Protokoll eingeführt wurde. Seitdem hat sich die Akzeptanz relativ langsam entwickelt, insbesondere in Unternehmen mit kleineren Netzwerken und weniger Ressourcen. Außerdem geben viele Unternehmen an, dass die Kosten für die SDN-Einführung ein abschreckender Faktor sind.

Zu den wichtigsten SDN-Anwendern gehören Dienstanbieter, Netzwerkbetreiber, Telekommunikations- und Carrier-Unternehmen sowie große Unternehmen wie Facebook und Google, die alle über die Ressourcen verfügen, um eine aufkommende Technologie in Angriff zu nehmen und zu unterstützen.

SDN-Anwendungsfälle

Anwendungsszenarien für Software-defined Networking sind unter anderem:

- DevOps: Ein auf SDN basierender Ansatz kann DevOps durch die Automatisierung von App-Updates und -Implementierungen vereinfachen, einschließlich der Automatisierung von IT-Infrastrukturkomponenten bei der Implementierung von DevOps-Apps und -Plattformen.

- Campus-Netzwerke: Diese Netzwerke können schwierig zu verwalten sein, insbesondere angesichts der anhaltenden Notwendigkeit, Wi-Fi- und Ethernet-Netzwerke zu vereinheitlichen. SDN-Controller können Campus-Netzwerke durch zentralisierte Verwaltung und Automatisierung, verbesserte Sicherheit und Servicequalität auf Anwendungsebene im gesamten Netzwerk begünstigen.

- Netzwerke von Dienstanbietern: SDN hilft Serviceanbietern bei Vereinfachung und Automatisierung der Bereitstellung ihrer Netzwerke für die End-to-End-Verwaltung und -Steuerung von Netzwerken und Diensten.

- Sicherheit im Rechenzentrum: SDN unterstützt einen gezielteren Schutz und vereinfacht die Firewall-Verwaltung. Im Allgemeinen ist ein Unternehmen zur Sicherung seines gesamten Rechenzentrums auf eine herkömmliche Perimeter-Firewall angewiesen. Firmen können jedoch ein verteiltes Firewall-System erstellen, indem sie virtuelle Firewalls zum Schutz der virtuellen Maschinen hinzufügen. Diese zusätzliche Sicherheitsebene der Firewall verhindert, dass ein Sicherheitsbruch in einer virtuellen Maschine auf eine andere überspringt. Die zentralisierte Steuerung und Automatisierung des SDN ermöglicht es dem Administrator außerdem, die Netzwerkaktivitäten anzuzeigen, zu modifizieren und zu kontrollieren, um das Risiko einer Verletzung von vorneherein zu reduzieren.

Die Auswirkungen von SDN

Software-defined Networking hat einen großen Einfluss auf die Verwaltung der IT-Infrastruktur und das Netzwerkdesign gehabt. Mit zunehmender Reife der SDN-Technologie verändert sich nicht nur das Design der Netzwerkinfrastruktur, sondern auch die Art und Weise, wie die IT ihre Rolle sieht, da das IT-Management stärker in den Entscheidungsprozess eingebunden ist und die gesamte IT-Infrastruktur neu definiert.

SDN-Architekturen können die Netzwerksteuerung programmierbar machen, wobei oft offene Protokolle wie OpenFlow verwendet werden. Aus diesem Grund können Unternehmen an den Rändern ihrer Netzwerke eine ganzheitliche Softwaresteuerung anwenden, um auf Netzwerk-Switches und Router zuzugreifen, anstatt die geschlossene und proprietäre Firmware zu verwenden, die im Allgemeinen zur Konfiguration, Verwaltung, Sicherung und Optimierung von Netzwerkressourcen verwendet wird.

Während SDN-Installationen in jeder Branche zu finden sind, ist der Einfluss der Technologie in technologiebezogenen Bereichen und bei Finanzdienstleistungen am stärksten.

SDN hat Auswirkungen auf die Art und Weise, wie Telekommunikationsunternehmen arbeiten. Sie verwenden SDN beispielsweise, um alle vorhandenen Service-Edge-Router für Ethernet- und IP-basierte Dienste in einer Plattform zu kombinieren. Ziel ist es, die Edge-Architektur zu vereinfachen, um die betriebliche Effizienz und Flexibilität zur Unterstützung neuer Funktionen und Dienste zu verbessern. Software-defined Networking soll dabei helfen, das Netzwerkmanagement zu verbessern und den Kunden letztlich bessere Dienstleistungen anzubieten.

Der Erfolg im Finanzdienstleistungssektor hängt von der Anbindung einer großen Anzahl von Handelsteilnehmern, niedrigen Latenzzeiten und einer hochsicheren Netzwerkinfrastruktur ab, um die Finanzmärkte weltweit zu versorgen.

Nahezu alle Teilnehmer am Finanzmarkt sind von alten Netzwerken abhängig, die zum Teil nicht prognostizierbar, schwer zu verwalten und langsam zu bedienen sind und enorme Sicherheitslücken aufweisen. Mit der SDN-Technologie können Organisationen im Finanzdienstleistungssektor jedoch prädiktive Netzwerke aufbauen, um effizientere und effektivere Plattformen für Finanzhandelsanwendungen zu ermöglichen.

SDN und SD-WAN

SD-WAN ist eine Technologie, die den Netzwerkverkehr über WAN verteilt und dabei SDN-Konzepte verwendet, um automatisch die effektivste Methode zu bestimmen, wie der Verkehr zu und von den Zweigstellen und Rechenzentrumsstandorten geleitet werden kann.

SDN und SD-WAN haben Gemeinsamkeiten. Beispielsweise trennen sie beide die Steuerungsebene und die Datenebene und unterstützen beide die Implementierung zusätzlicher virtueller Netzwerkfunktionen.

Während sich SDN jedoch in erster Linie auf die internen Abläufe innerhalb eines lokalen Netzwerks konzentriert, leitet das SD-WAN Anwendungen an das WAN weiter, um die geografisch verteilten Standorte eines Unternehmens zu verbinden.

Weitere Unterschiede sind:

- SDN kann vom Kunden programmiert werden, während SD-WAN vom Lieferanten programmiert wird.

- SDN wird durch die Virtualisierung von Netzwerkfunktionen (NFV) innerhalb eines geschlossenen Systems ermöglicht. SD-WAN hingegen bietet ein Anwendungs-Routing, das auf einer SD-WAN-Appliance läuft oder virtualisiert werden kann.

- SD-WAN verwendet ein applikationsbasiertes Routing-System im Breitbandinternet der Consumer-Klasse. Dies ermöglicht eine bessere Qualitäts-Performance und geringere Kosten pro Megabyte als das für SDN entscheidende Multiprotocol Label Switching (MPLS).

SDN und SD-WAN sind zwei verschiedene Technologien, die auf die Erreichung unterschiedlicher Geschäftsziele ausgerichtet sind. Typischerweise verwenden kleine und mittlere Unternehmen (KMU) SDN an ihren zentralen Standorten. Größere Unternehmen, die eine Verbindung zwischen ihrem Hauptsitz und externen Standorten herstellen möchten, setzen SD-WAN ein.