Getty Images/iStockphoto

Tutorial für Einsteiger: KI-Agenten mit LangChain bauen

LangChain ist eine beliebte Wahl unter Entwicklern für die Erstellung von KI-Anwendungen, einschließlich Agenten. Verwenden Sie dieses Tutorial, um mit dem Framework zu beginnen.

LangChain kann beim Erstellen von Agenten und anderen Arten von KI-Anwendungen helfen. Entwickler müssen jedoch die Installations- und Erstellungsprozesse verstehen, um es erfolgreich einsetzen zu können.

LangChain ist ein Open-Source-Framework zum Verbinden großer Sprachmodelle (Large Language Model, LLM) mit Daten, Dienstprogrammen und anderen LLMs. Dies geschieht mithilfe verschiedener vorgefertigter Tools und Integrationen, die es Entwicklern erleichtern, die für die Erstellung von KI-Anwendungen erforderlichen Funktionen zu implementieren.

LangChain ist besonders vorteilhaft für die Entwicklung agentischer KI. Mit LangChain können Benutzer einen KI-Agenten erstellen, der eine menschliche Anfrage an ein LLM weiterleiten kann. Das LLM verarbeitet die Anfrage und ermittelt, welche Tools oder Befehle zur Erfüllung der Anfrage erforderlich sind. Der Agent führt dann die Aufgaben automatisch aus.

Dieses LangChain-Tutorial für Anfänger behandelt die Grundlagen der LangChain-Installation und die Erstellung eines Agenten, der Dateien auf einem lokalen Computer mit dem Dateisystem-Tool von LangChain verwalten kann.

LangChain installieren

Bevor Entwickler Agenten oder andere KI-Anwendungen erstellen können, müssen sie sich mit dem einfachen Installationsprozess von LangChain vertraut machen.

Alle Befehle in diesem Artikel wurden auf einem Ubuntu 25.04-System getestet, aber die meisten funktionieren auf jedem Betriebssystem, das Python 3 unterstützt. Die einzige Ausnahme sind die sudo apt-Befehle, die zur Installation von Python 3 und Pip, einem Paketmanager für Python, verwendet werden. apt-get ist das Software-Installationsprogramm von Ubuntu. Benutzer, die ein anderes Betriebssystem als Ubuntu verwenden, müssen diese beiden Pakete mit einer vom System unterstützten Installationsmethode installieren.

Installieren Sie zunächst Python 3 und Pip:

sudo apt update

sudo apt install python3 python3-pip

Verwenden Sie anschließend Pip, um das LangChain-Paket zu installieren:

pip install langchain

LangChain testen

Um zu testen, ob LangChain ordnungsgemäß eingerichtet ist, führen Sie einen einfachen Code aus, der eine Abfrage von einem Terminal an ein LLM sendet. Entwickler können die folgenden Befehle direkt in einer Python-Konsole ausführen, obwohl die Ausführung in einem Jupyter-Notebook möglicherweise bequemer ist und einen interaktiveren Ansatz ermöglicht.

Installieren Sie zunächst das LangChain-Paket für das verwendete LLM. In diesem Tutorial wird das Gemini-Modell von Google verwendet, aber LangChain unterstützt eine Reihe von Modellen.

Installieren Sie das Gemini-Paket:

pip install -qU "langchain[google-genai]"

Führen Sie anschließend die folgenden Befehle aus, um die für die Interaktion mit Gemini erforderlichen Module zu importieren. Diese Befehle fordern den Benutzer außerdem auf, einen Gemini-API-Schlüssel einzugeben. Entwickler können hier einen erstellen.

import getpass

import os

if not os.environ.get("GOOGLE_API_KEY"):

os.environ["GOOGLE_API_KEY"] = getpass.getpass("Enter API key for Google Gemini: ")

from langchain.chat_models import init_chat_model

model = init_chat_model("gemini-2.0-flash", model_provider="google_genai")

from langchain_core.messages import HumanMessage, SystemMessage

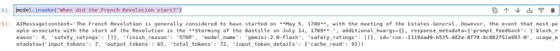

Als Nächstes übergeben Sie eine Abfrage mit der Methode .invoke an Gemini. Der folgende Befehl fragt Gemini beispielsweise, wann die Französische Revolution begann:

model.invoke("When did the French Revolution start?")

Abbildung 1 zeigt die Ausgabe von Gemini basierend auf dem Code, der in einem Jupyter-Notebook ausgeführt wird.

Einen KI-Agenten mit LangChain erstellen

Das obige Tutorial hat gezeigt, wie man mit LangChain eine Nachricht an ein LLM sendet und die Antwort anzeigt. Es wurde jedoch kein Agent erstellt, da das LLM nicht mit Tools verbunden war, die es ihm ermöglichen würden, Befehle auszuführen.

Das folgende Tutorial verwendet LangChain, um eine Verbindung zu einem LLM herzustellen und es in ein Tool zu integrieren. Konkret wird das Tool File System verwendet, das die erforderlichen Befehle zum Verwalten von Dateien auf einem Computer bereitstellt. Der Agent kann Dateien auf der Grundlage von Eingaben des Benutzers in natürlicher Sprache lesen, schreiben und löschen.

1. LLM integrieren

Installieren Sie die Integration mit dem LLM, das den Agenten steuert. In diesem Tutorial wird Gemini verwendet:

pip install -qU "langchain[google-genai]"

Richten Sie als Nächstes einen API-Schlüssel für das LLM ein:

import getpass

import os

if not os.environ.get("GOOGLE_API_KEY"):

os.environ["GOOGLE_API_KEY"] = getpass.getpass("Enter API key for Google Gemini: ")

from langchain.chat_models import init_chat_model

model = init_chat_model("gemini-2.0-flash", model_provider="google_genai")

2. Das Tool einrichten

Installieren und konfigurieren Sie das gewünschte LangChain-Tool. Wie oben erwähnt, ist das Tool dieses Tutorials File System, das die Interaktion mit Dateien auf einem Computer ermöglicht.

Das Tool File System ist Teil des Pakets langchain-community. Installieren Sie es mit dem folgenden Befehl:

pip install -qU langchain-community

Importieren Sie anschließend die für die Verwendung von File System erforderlichen Module:

from langchain_community.agent_toolkits import FileManagementToolkit

Legen Sie als Nächstes ein Arbeitsverzeichnis fest, das File System einem Verzeichnis im lokalen Dateisystem des Host-Computers zuordnet. In diesem Tutorial wird ein temporäres Verzeichnis verwendet, da es nicht ratsam ist, dem Tool Zugriff auf ein Verzeichnis mit wichtigen Dateien zu gewähren, ohne Sicherheitsvorkehrungen zu treffen.

Richten Sie das Verzeichnis ein:

from tempfile import TemporaryDirectory

working_directory = TemporaryDirectory()

Aktivieren Sie abschließend das Tool:

tools = FileManagementToolkit(

root_dir=str(working_directory.name),

selected_tools=["read_file", "write_file", "list_directory"],

).get_tools()

3. Einen KI-Agenten erstellen

Nachdem sowohl die LangChain-LLM-Integration als auch das Tool eingerichtet sind, können Entwickler nun einen Agenten erstellen.

Als Voraussetzung installieren Sie LangGraph – ein von LangChain entwickeltes KI-Agenten-Framework, das nicht im Standard-LangChain-Paket enthalten ist – mit dem folgenden Befehl:

pip install -U langgraph

Binden Sie als Nächstes das im ersten Abschnitt dieses Tutorials definierte LLM an das im zweiten Abschnitt definierte Tool:

model_with_tools = model.bind_tools(tools)

from langgraph.prebuilt import create_react_agent

agent_executor = create_react_agent(model, tools)

Dies generiert einen KI-Agenten.

4. Den KI-Agenten ausführen

Jetzt kann der Agent Aufgaben ausführen.

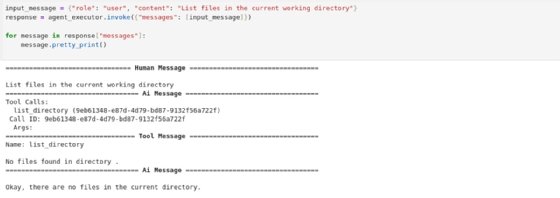

Senden Sie eine Anfrage an den Agenten, indem Sie den Inhaltswert der Variablen input_message ändern. Der folgende Code fordert den Agenten beispielsweise auf, die Dateien im aktuellen Arbeitsverzeichnis aufzulisten und die Antwort auszugeben:

input_message = {"role": "user", "content": "List files in the current working directory"}

response = agent_executor.invoke({"messages": [input_message]})

for message in response["messages"]:

message.pretty_print()

Abbildung 2 zeigt, wie die Ausgabe aussieht.

Abbildung 2 zeigt, dass das Tool keine Dateien im Verzeichnis gefunden hat, was sinnvoll ist, da noch keine vorhanden sind. Das Tool hat dieses Ergebnis an das LLM gemeldet, das daraufhin eine entsprechende Antwort generiert hat.

Als Nächstes senden Sie eine Anfrage an den Agenten, eine Datei mit dem Namen sample-file.txt zu erstellen:

input_message = {"role": "user", "content": "Create a file named sample-file.txt"}

response = agent_executor.invoke({"messages": [input_message]})

for message in response["messages"]:

message.pretty_print()

Abbildung 3 zeigt, wie der Agent die Datei wie gewünscht erstellt.

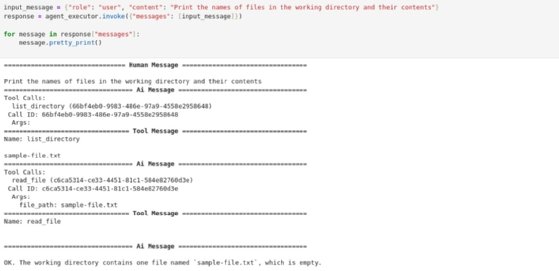

Bitten Sie den Agenten anschließend, anzugeben, welche Dateien sich im Verzeichnis befinden:

input_message = {"role": "user", "content": "Print the names of files in the working directory and their contents"}

response = agent_executor.invoke({"messages": [input_message]})

for message in response["messages"]:

message.pretty_print()

Wie die Antwort des Agenten in Abbildung 4 zeigt, enthält das Verzeichnis nun eine Datei namens sample-file.txt.

5. Entdecken Sie komplexere Anwendungsfälle

Das obige Tutorial hat die Grundlagen der Einrichtung von LangChain und der Erstellung von KI-Agenten demonstriert. Es handelt sich jedoch um ein einfaches Beispiel, bei dem der Agent nur grundlegende Aufgaben ausführt, nämlich die Verwaltung von Dateien auf einem lokalen Dateisystem.

Dies ist nur ein kleiner Ausschnitt dessen, was LangChain leisten kann. Um weitere Anwendungsfälle zu verstehen, die LangChain-KI-Agenten unterstützen können, sehen Sie sich die vollständige Liste der LangChain-Tools an. LangChain lässt sich in verschiedene Websites, Suchmaschinen, Softwareentwicklungs-Tools und mehr integrieren, sodass eine Vielzahl von Aufgaben mithilfe von KI-Agenten automatisiert werden kann.