DIgilife - stock.adobe.com

Leitfaden zur Verringerung von KI-Verzerrungen

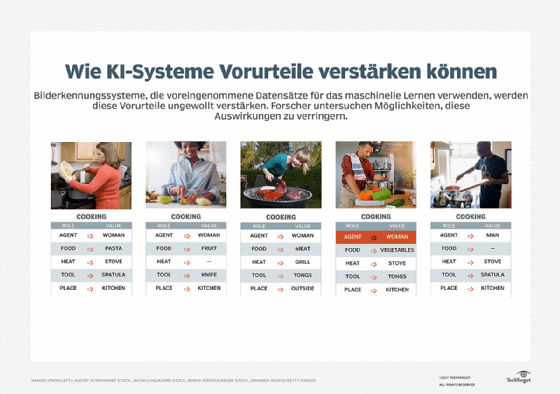

Auch KI kann voreingenommen sein und Unternehmensentscheidungen beeinflussen. Eine wirksame Risikominderung erfordert vielfältige Teams, Audits und verantwortungsbewusste Praktiken.

Unternehmen führen KI in ihren Betrieben ein, um ihre Effizienz zu steigern. Doch manchmal bieten diese neuen KI-Tools nicht nur Antworten, sondern schaffen auch neue Herausforderungen. Nutzer stellen zunehmend fest, dass ihre KI-Programme Verzerrungen (Bias) in ihren Systemen aufweisen, die Unternehmen angehen müssen, bevor sie zu einem weit verbreiteten Problem werden.

Voreingenommenheit oder Bias ist ein Phänomen, das fast alle Erwachsenen aufgrund ihrer persönlichen Erfahrungen kennen. Es äußert sich in einer Vorurteil gegenüber oder gegen etwas, das nicht durch Fakten gestützt wird, beispielsweise die Annahme, dass eine bestimmte Gruppe von Menschen aufgrund ihrer Nationalität eher hart arbeitet, oder die Annahme, dass alle Menschen mit einem bestimmten Akzent weniger intelligent sind. Dies führt oft zu unfairen Ergebnissen und subjektiven Entscheidungen, sowohl auf individueller als auch auf systemischer Ebene. Wenn KI voreingenommen ist, dann deshalb, weil sie aufgrund der Daten, mit denen sie trainiert wurde, ähnlich voreingenommene Meinungen zu einem Thema, einer Gruppe oder einer Person gebildet hat. Die Folgen können ähnlich schädlich sein.

Menschliche Voreingenommenheit wird oft als unvermeidliches Ergebnis unseres individuellen Lebens verstanden, aber sie wird dennoch als schädlich und daher als etwas angesehen, das es zu mildern gilt. Anstatt Menschen für ihre persönlichen Vorurteile zu beschämen, muss der Fokus darauf liegen, Bereiche zu identifizieren, in denen Vorurteile Auswirkungen haben, und diese Auswirkungen zu reduzieren. Dies gilt gleichermaßen für Vorurteile, die innerhalb von KI-Programmen und damit auch innerhalb von Geschäftsabläufen auftreten.

„Die Minderung von KI-Bias ist eine fortlaufende Aufgabe“, sagt Ora Tanner, CEO von Black Unicorn Education. „Kein System ist zu 100 Prozent vor Voreingenommenheit geschützt, da es auf Daten von uns Menschen basiert – und ich habe noch nie einen Menschen getroffen, der keine Voreingenommenheit hatte.“

Wie KI-Bias am Arbeitsplatz Schaden anrichtet

KI liegt, einfach gesagt, im Trend. Führungskräfte aller Branchen sind bestrebt, sich einen Wettbewerbsvorteil auf ihrem Markt zu verschaffen, aber anscheinend hat jeder die gleiche Lösung gefunden: den Einsatz von KI. Der Grund dafür liegt auf der Hand, denn KI-Unternehmen bieten einfache Integrationen an, die alle modernen Probleme am Arbeitsplatz zu lösen scheinen. Das macht KI-Verzerrungen umso gefährlicher, da viele Unternehmen nicht wissen, dass sie darauf achten müssen – oder worauf sie achten müssen.

„Die meisten Unternehmen setzen KI-Tools ein, weil sie sich davon Effizienzsteigerungen, Produktivitätssteigerungen, Kostensenkungen, Innovationspotenzial und eine Verbesserung des Kundenerlebnisses versprechen“, sagt Tanner. „Jeder dieser Aspekte ist ein potenzieller Einstiegspunkt für KI-Bias.“

Tanner nennt als Beispiel eine KI-Plattform zum Scannen von Lebensläufen, die entscheidet, welche Lebensläufe von Personalverantwortlichen angesehen werden, oder HR-Plattformen, die KI einsetzen, um zu entscheiden, wer Gehaltserhöhungen oder Beförderungen erhält. Menschen glauben oft, dass Technologie in der Lage ist, objektivere Entscheidungen zu treffen als sie selbst, da sie nicht von Emotionen oder persönlichen Erfahrungen beeinflusst wird. In Wirklichkeit wird die KI jedoch von dem großen Sprachmodell (Large Language Model, LLM) geprägt, mit dem sie trainiert wurde, und ist somit doch subjektiv. Und ihr Einfluss kann stark voreingenommen sein.

Ein Test, der von der Forscherin Ruhi Khan von der London School of Economics and Political Science durchgeführt wurde, ergab, dass ChatGPT männliche Kandidaten durchweg als fähiger, leistungsfähiger und besser für Führungspositionen geeignet beschrieb als weibliche Kandidaten – selbst wenn der einzige Unterschied innerhalb des Prompts ein geschlechtsspezifischer Name war.

Diese geschlechtsspezifische Voreingenommenheit kann einen überproportionalen Einfluss auf die Entscheidungsfindung im Personalwesen haben, insbesondere vor dem Hintergrund einer Studie von Resume Builder aus dem Juni 2025, die ergab, dass 60 Prozent der Personalverantwortlichen sich bei Entscheidungen über ihre direkten Untergebenen auf KI verlassen. Zu diesen Entscheidungen gehören die Festlegung von Gehaltserhöhungen (78 Prozent), Beförderungen (77 Prozent), Entlassungen (66 Prozent) und Kündigungen (64 Prozent).

„Da mehr als die Hälfte der Manager voreingenommene KI-Systeme verwendet, kann es für Frauen und andere traditionell benachteiligte Gruppen zunehmend schwieriger werden, bedeutende Fortschritte in der Arbeitswelt zu erzielen“, sagt Tanner unter Verweis auf die Studie von Resume Builder.

Strategien zur Minderung von KI-Bias in Unternehmen

Der potenzielle Schaden durch KI-Bias ist offensichtlich, doch die Minderung ihrer Auswirkungen ist etwas komplexer. Glücklicherweise gibt es einige Schritte, mit denen KI-Voreingenommenheit am Arbeitsplatz überprüft, behoben und überwacht werden kann.

Beziehen Sie alle Mitarbeiter mit ein

Um sinnvolle Veränderungen zu bewirken, muss sich das gesamte Unternehmen darüber einig sein, dass es sich um ein aktuelles und schädliches Problem handelt.

„Die Minderung von KI-Bias sollte nicht nur dem IT-Team überlassen bleiben“, sagt Tanner. „Alle Mitarbeiter am Arbeitsplatz, unabhängig von ihrer Position oder ihrem Rang, sollten über KI-Bias und deren potenzielle Schäden für Einzelpersonen, Organisationen und die Gesellschaft insgesamt aufgeklärt werden.“

Indem das gesamte Personal in diese Frage einbezogen wird, hat das Unternehmen bessere Chancen, die verschiedenen Fälle von KI-Bias, die intern auftreten, zu erkennen. Denn dann sind Mitarbeiter aus allen Bereichen des Unternehmens auf der Hut, ebenso wie Mitarbeiter mit unterschiedlichen Hintergründen und Perspektiven. Um Vorurteile zu bekämpfen, ist es entscheidend, auf die Vielfalt der Meinungen zu hören und eine Kultur der ethischen Verantwortung im Umgang mit KI zu pflegen.

Es kann hilfreich sein, eine Task Force einzurichten, die Maßnahmen zur Verringerung von Vorurteilen organisiert und leitet, insbesondere in größeren Unternehmen. In diesem Fall sollten die Teams aus multidisziplinären, vielfältigen Mitgliedern bestehen und nicht nur aus Mitgliedern des IT-Teams, da es hier ebenso sehr um Vorurteile wie um KI geht.

Erstellen Sie ein Inventar aller KI-Tools, -Plattformen und -Anwendungen

Wie bei allen Maßnahmen zur Risikominderung in Unternehmen muss zunächst eine umfassende Prüfung durchgeführt werden. Um alle Fälle von KI-Bias zu erfassen, muss jeder KI-Einsatz identifiziert und in einem einzigen, zentralisierten Inventar organisiert werden. Dies schafft mehr Transparenz hinsichtlich der KI-Nutzung innerhalb des Unternehmens und erleichtert die konsistente und großflächige Anwendung zukünftiger Rahmenwerke. Dieses Inventar kann auch parallel zur KI-Nutzung des Unternehmens wachsen und sich weiterentwickeln, sodass alle neuen Tools in ähnlicher Weise überwacht werden.

Führen Sie Bias-Bewertungen durch

Dies ist der Kern der Strategie: Bewerten Sie jeden Punkt im Inventar auf potenzielle Schwachstellen hinsichtlich KI-Bias. Dies kann beispielsweise darin bestehen, Tests mit neuen Szenarien durchzuführen, um festzustellen, ob das KI-Tool bei bestimmten identifizierenden Informationen unterschiedliche Empfehlungen zu ansonsten identischen Eingaben liefert. Alternativ kann dies auch darin bestehen, eine Analyse aller bisherigen Ergebnisse durchzuführen, um festzustellen, ob es bedenkliche Muster oder Trends gibt, die auf Verzerrungen hindeuten.

In Fällen, in denen ein KI-Bias festgestellt wird, verbinden Sie diese Tools mit den Datensätzen, mit denen sie trainiert wurden. Handelt es sich um ein extern entwickeltes Tool, kann dies zu einem Gespräch mit dem Anbieter führen. Bei Anwendungen, die mit internen Daten trainiert wurden, sollten diese Datensätze überprüft werden, um festzustellen, woher die Voreingenommenheit stammt.

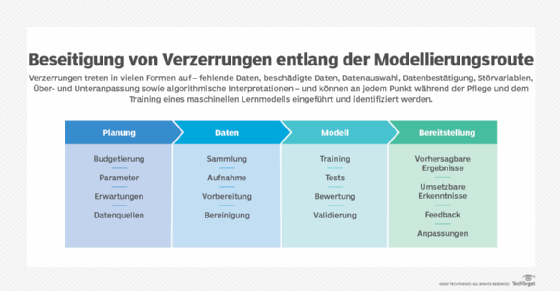

Entwickeln Sie verantwortungsvolle Datensätzen für das KI-Training

Für eine langfristige Risikominderung ist es wichtig, nicht nur aktuelle Fälle von Voreingenommenheit zu erkennen, sondern auch aktuelle KI-Modelle zukunftssicher zu machen. Das bedeutet, eine verantwortungsvolle Methode für die Datenerfassung und -verwaltung zu etablieren, deren Kern Objektivität und Unparteilichkeit sind. Teams sollten außerdem regelmäßig überprüfen, wie diese Vorgänge funktionieren, um sicherzustellen, dass sie im Laufe der Zeit nicht von den ursprünglichen Zielvorgaben abweichen.

Konsultieren Sie bestehende Frameworks zur Minderung von KI-Bias

Unternehmen müssen diese Strategien nicht ohne Unterstützung umsetzen. Es gibt mehrere frei verfügbare Ressourcen, die Teams bei ihren eigenen KI-Bias-Prüfungen unterstützen und ihnen helfen, künftig objektivere Systeme aufzubauen. Tanner empfiehlt die folgenden Rahmenwerke als nützliche Leitfäden zur Minderung von KI-Bias auf Unternehmensebene:

- Berkeley Haas AI Mitigation Playbook (PDF)

- FabriXAI Business Framework zur Reduzierung von KI-Bias

- National Institute of Standards and Technology (NIST) AI Risk Management Framework (PDF)

Kommunizieren Sie Aktivitäten zur Minderung von KI-Bias

Menschen sind fehlerhafte Wesen, daher ist es nicht verwunderlich, dass auch menschliche Erfindungen einige dieser Fehler aufweisen können. Im Falle von Verzerrungen können Unternehmen viel Gutes bewirken, indem sie einfach alle Fälle von KI-Bias anerkennen, mit ihren Teams teilen und ihre Bemühungen zur Korrektur kommunizieren. Diese KI-Transparenz fördert nicht nur das Vertrauen zwischen den Mitarbeitern und dem Unternehmen, sondern stellt auch sicher, dass alle Mitarbeiter in die größeren Bemühungen zur Minderung von KI-Verzerrungen einbezogen werden.

Häufige Fehler, die das Management im Zusammenhang mit KI-Bias macht

Die Auswirkungen von KI-Bias zu mindern, ist keine einfache Aufgabe, aber Führungskräfte können es sich selbst erschweren, wenn sie das Problem aus dem falschen Blickwinkel angehen.

„Einer der größten Fehler, den Führungskräfte machen, ist, KI-Bias aus einer rein technischen Perspektive anzugehen“, sagt Tanner. „Es ist zwar notwendig, Datensätze so zu modifizieren, dass sie repräsentativer sind, und sicherzustellen, dass Algorithmen für maschinelles Lernen fair sind, aber das reicht nicht aus.“

Selbst das NIST beschreibt KI-Bias als etwas, das über Daten hinausgeht. Laut Tanner erfordert die Verringerung ihrer Auswirkungen auf den Betrieb „vielfältige Interessengruppen, die sich mit den sozialen, politischen, ökologischen, wirtschaftlichen und ethischen Dimensionen von KI-Bias befassen können“. Durch das Verständnis der menschlichen Voreingenommenheit, die der KI-Voreingenommenheit zugrunde liegt, können Teams dieses Problem langfristig viel effektiver lösen.