Automation Bias

Was ist Automation Bias?

Automation Bias ist eine übermäßige Abhängigkeit menschlicher Bediener von automatisierten Systemen wie Computerhardware, Software und Algorithmen bei der Entscheidungsfindung, selbst wenn die maschinell generierten Ergebnisse falsch sind oder dem menschlichen Urteilsvermögen widersprechen.

Diese übermäßige Abhängigkeit kann dadurch entstehen, dass man weiß, wie ein System funktioniert, oder dass man es bereits zuvor verwendet hat. Sie kann auch durch Cognitive Bias wie Autoritäts-Bias, hohe Arbeitsbelastung und enge Fristen beeinflusst werden. Diese Überschätzung der Fähigkeiten einer Maschine in Verbindung mit menschlicher Selbstgefälligkeit kann zu verzerrten Ergebnissen und kritischen Fehlern führen.

Automatisierte Systeme – angetrieben durch das Versprechen der KI, die Produktivität in allen Branchen zu steigern – erfordern nach wie vor menschliche Aufsicht. Risikoreiche Systeme im Gesundheitswesen, im Finanzdienstleistungssektor, in der Strafjustiz und in anderen Bereichen verdeutlichen die Gefahren von Automatisierungsfehlern, die in einigen Fällen katastrophale Folgen haben können.

Ein Beispiel hierfür ist der Horizon-Skandal der British Post, über den erstmals in der Zeitschrift Computer Weekly berichtet wurde, die heute zu Informa TechTarget gehört. Im Jahr 1999 begann die britische Regierung mit der Einführung des Buchhaltungssystems Horizon in rund 14.000 Postfilialen. Im Gegensatz zu den bisherigen papierbasierten Buchhaltungsmethoden bot das neue System keine Möglichkeit, finanzielle Fehlbeträge zu erklären. Aufgrund von Fehlberechnungen in Horizon und trotz widersprüchlicher Beweise und interner Warnungen vor den Mängeln der Software verfolgte die Post zwischen 1999 und 2015 fälschlicherweise mehr als 700 Postangestellte wegen Diebstahls und Bilanzfälschung.

Wie funktioniert Automation Bias?

Automation Bias manifestiert sich im Allgemeinen auf zwei Arten:

- Fehler durch Handlungen: Diese Fehler treten auf, wenn Personen den Empfehlungen eines automatisierten Systems folgen, selbst wenn die Ergebnisse fragwürdig oder widersprüchlich erscheinen.

- Fehler durch Unterlassung: Diese Fehler treten auf, wenn menschliche Bediener einen Automatisierungsfehler nicht erkennen oder nicht darauf reagieren.

Untersuchungen zur Automation Bias zeigen, dass menschliche Entscheidungsträger oft zu viel Vertrauen in KI setzen. Wenn jedoch Entscheidungen mit höheren Risiken verbunden sind, werden Menschen möglicherweise skeptischer gegenüber Algorithmen. Diese Tendenz zeigt sich besonders bei Personen mit Algorithmusaversion, einem psychologischen Phänomen, bei dem Menschen Algorithmen weniger vertrauen, insbesondere nachdem sie Fehler beobachtet haben.

Frühe Automatisierungssysteme konzentrierten sich auf die Mechanisierung von Aufgaben, die zuvor von Hand ausgeführt wurden. Mit dem Aufkommen der Elektronik und der Computerverarbeitung wurden manuelle Aufgaben durch regelbasierte Systeme automatisiert, die von menschlichen Ingenieuren unter Verwendung einer strengen Wenn-Dann-Logik programmiert wurden. Diese frühen Systeme basierten auf deterministischen Algorithmen – Sätzen von Eingaben, die einer definierten Abfolge von Anweisungen folgen, um gut strukturierte Probleme zu lösen – und grafischen Benutzeroberflächen zur Rationalisierung der Arbeitsabläufe in der Prozessautomatisierung.

Im Gegensatz dazu verwenden KI-Modelle Algorithmen und Large Language Models (LLMs), die selbstadaptive Systeme auf der Grundlage neuer Informationen unterstützen sollen. Diese Systeme lernen Muster und wenden sie auf bisher unbekannte Daten an. Wie sie zu ihren Ergebnissen gelangen, ist jedoch oft weit weniger transparent.

Da einige KI-Anbieter die verfügbaren Internetdaten erschöpfen, stützen sich ihre Modelle zunehmend auf überwachtes und unüberwachtes Reinforcement Learning, um Ergebnisse zu generieren. Automatisiertes maschinelles Lernen stellt eine Verschmelzung von Automatisierung und maschinellem Lernen dar und ermöglicht es Systemen, die Modellentwicklung mit minimalem menschlichem Eingriff zu optimieren.

Warum Automation Bias gefährlich ist

Es ist zwar wichtig, dass menschliche Bediener darauf vertrauen oder davon überzeugt sind, dass ein automatisiertes System ihnen bei der Erfüllung einer Aufgabe hilft, aber diejenigen, die überlastet sind oder unter Zeitdruck stehen, könnten es der Maschine überlassen, für sie zu denken: eine menschliche Tendenz, die als kognitive Entlastung bekannt ist. Eine übermäßige Abhängigkeit von automatisierten Entscheidungen könnte bei unerfahrenen Personen oder solchen mit geringem Selbstvertrauen häufiger vorkommen. Einige Personen könnten sich so sehr auf automatisierte Systeme verlassen, dass sie die kritischen Fähigkeiten und das menschliche Urteilsvermögen nicht entwickeln, die für die Beurteilung risikoreicher Szenarien erforderlich sind, wie beispielsweise Piloten, die bei extremen Wetterbedingungen vom Autopiloten auf manuelle Steuerung umschalten müssen.

KI bringt ihre eigenen Herausforderungen mit sich. Die LLMs in generativen KI-gestützten Automatisierungssystemen können manchmal falsche oder erfundene Ergebnisse liefern, die als KI-Halluzinationen bezeichnet werden. Diese Halluzinationen entstehen, wenn ein Sprachmodell scheinbar plausible, aber faktisch falsche Informationen erzeugt, was ein bekanntes Problem bei großen Sprachmodellen wie ChatGPT ist. Unternehmen machen ihre Mitarbeiter zunehmend auf die Gefahren aufmerksam, die mit der Abhängigkeit von automatisierten Entscheidungen – insbesondere von KI-generierten Ergebnissen – für Informationen verbunden sind, die für Kunden oder die Geschäftsleistung von entscheidender Bedeutung sind.

Wie lässt sich Automation Bias überwinden?

Strategien zur Minderung von Automation Bias sollten Folgendes umfassen.

Obligatorische menschliche Überwachung und Beteiligung

Bei allen vollautomatisierten Entscheidungsprozessen, die die Rechte, die Sicherheit oder die Geschäftsergebnisse von Personen beeinträchtigen könnten, sollte eine menschliche Beteiligung erforderlich sein. Die Betonung der Rolle menschlicher Entscheidungen bei der Interaktion mit Maschinen trägt dazu bei, Fairness, Verantwortlichkeit und Qualitätskontrolle zu gewährleisten.

Systeme sollten so gestaltet werden, dass Menschen jederzeit eingreifen können (Human-on-the-Loop) oder aktiv Entscheidungen absegnen müssen (Human-in-the-Loop).

Fokus auf Aus- und Weiterbildung

Menschliche Bediener müssen ein gesundes Maß an Skepsis bewahren und wissen, wann sie eine zweite Meinung einholen oder algorithmische Ergebnisse überprüfen müssen. Über die Sensibilisierung der Mitarbeiter und Drittanbieter für die Gefahren von Automatisierungsfehlern hinaus sollte das Management auch Fehler und Übersteuerungen verfolgen und diese Daten zur Nachschulung sowohl der Systeme als auch des Personals nutzen.

Dokumentation der Einhaltung von Data-Governance-Rahmenwerken und Vorschriften

Der im Mai 2024 verabschiedete EU AI Act trat teilweise im August 2024 in Kraft. Die vollständige Umsetzung erfolgt stufenweise bis 2026, abhängig vom Risikoniveau der KI-Anwendung:

- unannehmbares Risiko

- Hochrisiko

- begrenzt, mit Transparenzverpflichtungen

- minimales oder kein Risiko

Der EU AI Act schreibt Mechanismen vor, die eine menschliche Aufsicht und die Dokumentation der Compliance mit Rückverfolgbarkeit für alle KI-Systeme mit hohem Risiko ermöglichen, die in kritischen Infrastrukturen und anderen öffentlichen Diensten wie dem Gesundheitswesen und dem Bildungswesen eingesetzt werden. Obwohl Chatbots im EU AI Act als begrenztes Risiko eingestuft sind, müssen Unternehmen, die sie einsetzen, die Nutzer darüber informieren, dass sie mit einem Chatbot interagieren.

Neben dem EU AI Act (KI-Verordnung) entwickeln auch andere Regionen wie die USA, Kanada und Japan Leitlinien zur Regulierung von KI: etwa über das G7-Hiroshima-Prozess-Framework.

Bewerten Sie die Datenintegrität und das Design auf Systemebene

Um das Potenzial für Verzerrungen aufgrund mangelhafter IT-Prozesse wie Datenkorruption, unzureichende Sicherheitsmaßnahmen, fehlerhafte Logik, schlechte Datenqualität oder Automatisierungsfehler zu minimieren, sind Transparenz und Rückverfolgbarkeit unerlässlich. Dazu gehören Praktiken wie erklärbare KI, um Entscheidungsprozesse zu verdeutlichen. Es ist wichtig, folgende Frage zu stellen: Wie wird das LLM trainiert oder feinabgestimmt? Wenn Softwareentwickler Algorithmen programmieren, ist es entscheidend, dass Tester überprüfen, ob die Algorithmen wie vorgesehen funktionieren. Es sollten umfassende Bewertungsprozesse eingerichtet werden, um das Design, die Bereitstellung und die Verwendung von Algorithmen zu überwachen.

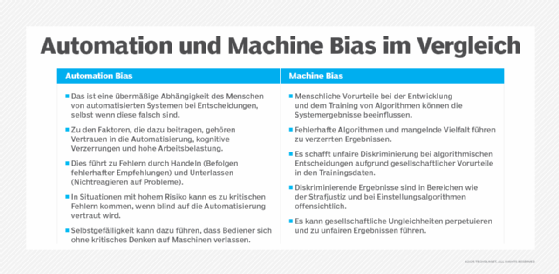

Automation und Machine Bias im Vergleich

Wenn Menschen den Entscheidungen einer Maschine vertrauen, obwohl gültige Daten zu anderen Schlussfolgerungen führen, spricht man von Automation Bias. Manchmal ist dieser Bias aufgrund des Designs, der Logik oder des algorithmischen Bias des Systems und der von ihm gesammelten Daten in die Maschine selbst eingebaut. Bei KI-Systemen stammt der Machine Learning Bias häufig aus den Trainingsdaten, aus denen das System lernt. Aus diesem Grund sind Bias-Audits und andere Maßnahmen zur Durchsetzung von Transparenz erforderlich.

Eine Untersuchung von ProPublica aus dem Jahr 2016 deckte beispielsweise Machine Bias im COMPAS-System (Correctional Offender Management Profiling for Alternative Sanctions) von Northpointe auf. Schwarze Angeklagte wurden vom System häufiger als hochriskant eingestuft, während ein höherer Prozentsatz weißer Angeklagter fälschlicherweise als weniger riskant eingestuft wurde. Die Untersuchung ergab, dass sowohl Richter als auch Bewährungshelfer sich bei Entscheidungen über Strafmaße und Kautionen auf die automatisierten Risikobewertungen des Systems stützten, selbst wenn die Vorstrafen der Angeklagten etwas anderes nahelegten.

Die KI-Verordnung verlangt, dass risikoreiche KI-Systeme Datenqualitätsstandards erfüllen, wobei die Compliance-Anforderungen nachvollziehbar sein müssen und nachweisen müssen, dass Datensätze – einschließlich derjenigen von Lieferanten – frei von Bias sind, die zu diskriminierenden Ergebnissen führen können.

Kann Bias jemals gerechtfertigt sein?

In einigen Fällen ist es gerechtfertigt, sich bei der Erfüllung einer Aufgabe übermäßig auf die Ergebnisse automatisierter Systeme zu verlassen. Beispielsweise können automatisierte Überwachungssysteme historische Daten und vorausschauende Analysen verwenden, um Sicherheitsanalysten dabei zu unterstützen, ungewöhnliches Verhalten zu erkennen, wie eine Kreditkarte, die für einen großen Einkauf an einem Ort verwendet wird, den der Karteninhaber noch nie besucht hat. Dies kann dazu beitragen, potenzielle Betrugsfälle in Zahlungssystemen und anderen Finanzdienstleistungen aufzudecken.

In ähnlicher Weise kann in KI-Systemen das Trainieren von Modellen und Algorithmen für maschinelles Lernen zur Identifizierung und Entfernung von Hassreden oder Rassismus als positive oder gute Bias angesehen werden. Diese Art von Bias wird absichtlich eingebaut, um ethische Standards zu unterstützen oder gesetzliche Anforderungen zu erfüllen.

Automation Bias auf einen Blick

Automation Bias beschreibt die übermäßige Abhängigkeit von automatisierten Systemen, selbst bei erkennbaren Fehlern. Besonders in risikoreichen Bereichen wie Justiz, Medizin oder Finanzen kann dies gravierende Folgen haben. Ursachen sind etwa Zeitdruck, Autoritätsglaube und kognitive Entlastung. KI-Systeme wie LLMs sind anfällig für Halluzinationen und Verzerrungen. Menschliche Aufsicht, Aus- und Weiterbildung sowie gesetzliche Vorgaben wie der EU AI Act sind zentrale Maßnahmen zur Vermeidung solcher Fehler.