Gigabit Ethernet: Sind 25 GbE und 50 GbE sinnvoll?

Seit Sommer 2014 arbeitet ein Konsortium an der Spezifikation für 25 GbE (Gigabit Ethernet). Binnen zwei Jahren soll erste Hardware erhältlich sein.

Es gab einmal eine Zeit, da fragten sich Netzwerk-Administratoren im Data Center, wie man jemals eine Netzwerk-Verbindung mit 10 Gigabit auslasten könnte. Sie zuckten mit den Schultern, lachten und bestellten mehr Equipment mit 10/100-Ports.

Das funktionierte, bis Virtualisierung und Cloud Computing in hyperskalierten Data Centern Einzug hielt und neue Herausforderungen mit sich brachte. Plötzlich musste man Hunderte oder sogar Tausende an Servern eine Heimat geben. Eine der Herausforderungen war der nicht enden wollende Hunger nach mehr Bandbreite.

Dabei konnte Ethernet zum Großteil mithalten. Die Standards 40 Gigabit Ethernet (GbE) und 100 GbE wurden vor einigen Jahren von der IEEE ratifiziert. Weiterhin untersucht eine Arbeitsgruppe derzeit einen Standard für 400 GbE.

Die Anforderungen von Cloud-Providern und anderen großen Data-Center-Betreibern sind allerdings differenzierter und sie benötigen nicht nur die Brutto-Kapazität. In den Top-of-Rack-Switches laufen im Data Center normalerweise die meisten Verbindungen auf. Diese werden für 10 GbE bald zu schwach. Aus Design-Gründen ist die Migration zu 40 GbE für Cloud-Provider und Anwender mit ähnlichen Anforderungen nicht Kosten- oder -Strom-effizient genug.

Aus diesem Grund haben fünf IT-Firmen im Juli 2014 ein 25-Gigabit-Ethernet-Konsortium gegründet. Arista, Broadcom, Google, Mellanox Technologies und Microsoft arbeiten an Spezifikationen für 25 GbE und 50 GbE. Die Gruppe will erreichen, dass sich die Kosten von 25 GbE mit denen von 10 GbE vergleichen lassen. Das Konsortium will so schnell wie möglich vorgehen, auch wenn man damit Standardisierungs-Institutionen umgehen muss.

Die Gründer der Branchengruppe denken, dass man Produkte mit 25 und 50 GbE innerhalb von 18 bis 24 Monaten ausliefern kann. Sieht man sich den formalen Prozess für die Ratifizierung eines neuen Ethernet-Standards an, der mehrere Jahre dauern kann, ist das ein aggressiver Zeitplan. Hinzu kommen dann noch die Jahre, die es dauert, bis kommerzielle Produkte auf den Markt kommen. Cloud-Provider und Betreiber großer Data Center haben diese Zeit nach Ansicht des Konsortiums aber ganz einfach nicht.

Die Notwendigkeit für 25 GbE ist da, die Lösung ist zum Greifen nahe und das Potenzial ist groß. „So viel Bandbreite brauchen Sie schnell. Das gilt vor allen Dingen, wenn Sie Virtualisierung im großen Stil einsetzen.“, sagte Nick Buraglio. Er ist Netzwerk-Techniker aus Illinois und arbeitet an einem nationalen Forschungs-Netzwerk.

Er ist zwar nicht bei einem Cloud-Provider beschäftigt, verfolgt die neuesten Entwicklungen allerdings auch mit großem Interesse. „Sie können mehr Services von einem einzelnen Host verkaufen, solange dieser bis zum Anschlag mit CPUs und Arbeitsspeicher hochgerüstet ist“, fügte Buraglio an. „Somit müssen Sie weniger Router- und Switch-Ports erwerben. Das ist eine teure Angelegenheit, vor allen Dingen die Router-Ports.“

Die Anstrengungen des Konsortiums haben schnell an Fahrt gewonnen und dabei ist man auf wenig (wenn überhaupt) Gegenwind oder technische Barrieren gestoßen. Seit dem Start im Juli 2014 haben sich dem Konsortium noch weitere große Namen angeschlossen. Dazu gehören Cisco, Dell, Juniper Networks und Brocade.

Das technische Komitee trifft sich wöchentlich, um an den neuen Spezifizierungen zu arbeiten. Weiterhin ist die IEEE in der Zwischenzeit mit von der Partie. Hier hat man eine Arbeitsgruppe geschaffen, die sich erstmals Mitte September 2014 getroffen hat, um an einem 25-GbE-Standard zu arbeiten.

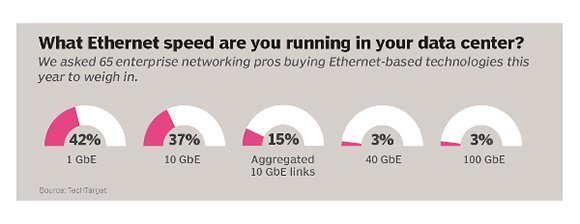

Welche Ethernet-Geschwindigkeiten laufen in Ihrem Data Center?

„Die Idee ist großartig“, sagte Gerg Ferro. Er ist ein freiberuflicher Netzwerk-Techniker und Mitherausgeber des Podcasts Packet Pushers. „Es gibt nicht wirklich einen Nachteil“, fügte er an.

Einspuriges Design lässt 25 Gigabit glänzen

Zwei Worte verkörpern, warum 25 GbE bahnbrechend ist: „Einspuriges Design“. Das bezieht sich auf die elektrische Signale des Chips, der einen Ethernet-Port antreibt. Weil das Design von 40 GbE auf dem von 10 GbE basiert, wird ein 40-Gigabit-Chip mit vier Pins hergestellt. Das bringt vier Kanäle, die man auch als Spuren oder Lanes bezeichnet. Jede Spur ist für 10 Gbps gut. Ursprünglich wollte man bei 100 GbE ähnlich an die Sache herangehen.

Im Jahr 2010 planten die Entwickler zehn Spuren a 10 Gbps. Die Standardisierungs-Stellen machten sich im Laufe der weiteren Jahre Gedanken über die Effizienz von 100 GbE. Die zweite Generation brachte dann ein komplett neues Signal-Schema mit sich. Hier sind es nun vier Spuren a 25 Gbps. Reduziert man die Anzahl der Pins auf einem Chip, ist die Herstellung günstiger und der Stromverbrauch sinkt.

Dieser Umstand ebnete den Weg für einspuriges 25 GbE, das man genau genommen aus dem 100-GbE-Standard herausgezogen hat. Die Spezifikation des Konsortiums für 50 GbE verwendet zwei Spuren a 25 Gbps.

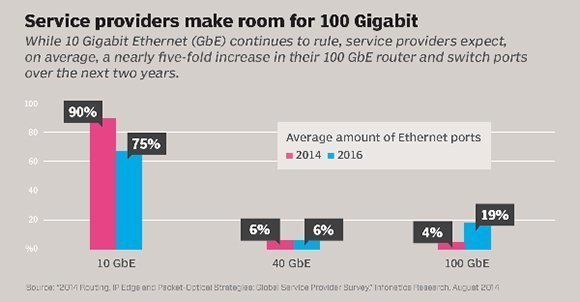

Nur wenige Experten erwarten jedoch, dass 25 GbE ein kompletter Ersatz für 40 GbE sein kann. Die Installations-Basis dafür ist bereits solide und Infonetics Research erwartet, dass sich die Anzahl der verkauften 40-Gigabit-Ports im Jahr 2014 verdreifacht und damit auf 1,5 Millionen steigt. Unter bestimmten Umständen gibt es Vorteile, wenn man einen 40-Gbps-Port in vier Spuren a 10 Gbps aufteilt.

Der Grundstein für 25 GbE ist gesetzt und somit ist zu erwarten, dass die Technologie tatsächlich in ungewöhnlich kurzer Zeit als Standard ratifiziert wird, woran die IEEE arbeitet. Dieser Meinung ist Mark Nowell, Vorsitzender der IEEE-Arbeitsgruppe 802.3 25 Gb/s Ethernet. Die größte noch zu nehmende Hürde für die IEEE ist das Definieren eines MACs (Media Access Layer) für 25 GbE. Dieser Prozess ist laut eigenen Angaben aber „sehr einfach“.

„Um dieses Projekt zu realisieren, gibt es keine technischen Herausforderungen. Die Branche hat das bereits erledigt“, sagte Nowell. Er ist außerdem leitender Direktor Engineering und CTO bei Cisco. „Unsere Arbeit ist im Endeffekt nur, die Puzzle-Teile so zusammenzuführen, dass Kompatibilität gewährleistet ist.“, fügte er an.

Service Provider machen Platz für 100 Gigabit Ethernet.

Die IEEE muss sich allerdings an die eigenen Vorgaben halten und immer noch die Standard-Entwicklungs-Prozesse offen gestalten, sowie einen ausreichenden Konsens der Mitglieder schaffen. Es ist eine Mehrheit oder absolute Mehrheit der Stimmen nötig, um neue Standards zu ratifizieren.

Wegen zu wenig Beteiligung auf einem IEEE-Event 2014 in Peking musste der Vorsitzende des Treffens eine Anfrage zurückziehen, um an einem Standard für 25 Gbps arbeiten zu können, sagte Nowell. Das ist aber der erste Schritt. „Er war der Meinung, dass nicht genug Leute anwesend seien, um im Interesse der komplette Gruppe zu entscheiden.“, erklärte er.

Cloud-Giganten wie Facebook und Microsoft, beide Kunden von Arista, wollen schnell eine ökonomische Lösung finden, um die Anforderungen für Server und Storage I/O (Input/Output) zu adressieren. Diese Dringlichkeit hat die Bereitschaft beeinflusst, auf Produkte zu setzen, die noch nicht standardisiert sind. Das sagte Anshul Sadana, Vice President Customer Engineering bei Arista. Das Unternehmen hatte das Konsortium auf Grund der Zurückhaltung der IEEE im März organisiert.

„Noch vor zwei Jahren wäre das nicht möglich gewesen. Wenn wir noch zwei Jahre warten, wird das zu spät sein.“, meinte Sadana. Er geht davon aus, dass 25 GbE die 10-GbE-Variante in den Top-of-Rack-Switchen ersetzt. 50 GbE wird seiner Meinung als Ersatz für 40 GbE in Storage-Netzwerken dienen.

Warum sind die Top-of-Rack-Modelle plötzlich so übersättigt? Die Datenmenge steigt rasch und die Workloads werden durch schnellere und leistungsfähigere Server ausgeliefert, sagt Ferro. Die nächste Generation der Mikroprozessoren wird es noch dringlicher machen, der Aggregationsschicht mehr Kapazitäten zu spendieren.

„Wenn Sie Cloud-Provider sind, dann werfen Sie einen Blick in die Zukunft. Die Grantley-Klasse der Intel-CPUs wird nächstes Jahr erscheinen“, sagte Ferro. „Diese Server-CPUs sind alle in der Lage, mehr als 10 Gigabit an Daten pro Sekunde zu übertragen. Deswegen brauchen Sie schnellere NICs. Das ist genau genommen der treibende Faktor. x86-Server sind schneller als 10 Gbps.“, fügte er an.

Die Kosten der Top-of-Rack-Modelle senken

Das Design mit nur einer Spur für 25 GbE wird verglichen mit 10 GbE, die Kosten pro Bit sinken. Cloud-Provider und Betreiber großer Data Center können weniger Switches einsetzen. Dennoch sind Sie in der Lage, die Netzwerk-Infrastruktur so zu skalieren, dass Sie Ihre Anforderungen erfüllen. „Das ist Magie, wie Musik in der Ohren der Cloud-Provider, da Sie kostengünstigeres I/O erhalten.“, sagt Sadana.

In einer vom IEEE gehaltenen Präsentation der neu formierten 25-GbE-Arbeitsgruppe haben Netzwerk-Profis ausgerechnet, wie viele Top-of-Rack-Switches man in einem Data Center mit 100.000 Servern und 100 Prozent Port-Auslastung benötigen würde. Setzt man hochkarätige Switches mit vier Spuren und 40 Gbps ein, wären das 3.572, um diese Umgebung zu unterstützen. Implementiert man dagegen einspurige 25-GbE-Modelle, bräuchte man weniger als ein Drittel. Genau genommen wären es 1.042.

„Sie können sowohl die Anzahl der Switche im Data Center reduzieren als auch die Kosten für die eigentlichen Verbindungen“, sagte Nowell. „Das Kabel hat nur einen Kupferstrang und keine vier. Dort liegt das ganze Volumen und dort liegen jede Menge Kosten im Data Center“, erklärte er.

25 GbE wird allerdings keinen solchen Einfluss haben, dass Cloud- Kunde einen Unterschied spüren.

Vergleicht man die Spezifikationen von 40 GbE mit denen von 25 GbE, darf man auch mit weniger Stromhunger und geringeren Kosten für die Klimatisierung rechnen. Da es nur einen Pin auf dem Chip gibt, benötigt man weniger Strom. Außerdem muss man weniger Switches betreiben.

„Das Problem in Data Centern ist Strom“, sagte Buraglio, er betreibt den Netzwerk-Blog The Forwarding Plane. „Der Rest ist einfach. Einen Anbieter für Dark-Fiber (unbeschaltete Glasfaser-Infrastruktur) zu finden, wird nicht schwierig sein. Der Rest lässt sich mit Geld lösen. Das Stromproblem kann man in der Regel auch mit Geld lösen, aber eben mit mehr. Je weniger Dinge Sie am Laufen haben, desto effizienter ist der Betrieb und desto höher sind die Profitspannen“, fügte er an.

Er wäre allerdings zu einfach zu sagen, dass sich die Kosteneinsparungen bei 25 GbE und 50 GbE direkt auf die Preise in der Cloud auswirken. Netzwerk-Profis und Branchen-Experten hoffen aber, dass sich die Effizienz in Bezug auf die neuen Spezifikationen irgendwann bei den Kunden niederschlägt.

„Mein persönliches Interesse liegt darin, dass Cloud-Technologien günstiger und widerstandsfähiger werden. Ich glaube fest daran, dass die durch 25 Gigabit eingeführte höhere Bandbreite genau das liefern kann.“, sagte Nathan Roberts. Er ist MIS-Direktor bei CareerSource, ein Workforce Development Network mit Sitz in Florida. „Wir migrieren viel in die Cloud und haben gerade Salesforce landesweit ausgerollt. Die Verbesserungen in den Data Centern bei großen Cloud-Firmen wie Salesforce könnten unserem Betrieb durch höhere Geschwindigkeit und Zuverlässigkeit entgegenkommen. Deswegen hoffe ich, dass es einen indirekten Vorteil gibt“, meinte er.

Andrew Lerner ist Research-Direktor bei Gartner. Er glaubt, dass die Kosteneinsparungen durch die neuen Spezifikationen nur ein Teil des Arsenals sind, das Cloud-Provider im Preis-Krieg in die Waagschale werfen können.

„Wenn Sie ein, drei oder sogar fünf Prozent an Kosten in einer groß angelegten Umgebung sparen, hat das direkten Einfluss auf die Einnahmen. Reden wir über die Cloud, wird das derzeit direkt an die Kunden weitergegeben“, sagte Lerner. „25 GbE wird allerdings keinen solchen Einfluss haben, dass der Kunde einen Unterschied spürt“, glaubt er.

Das letzte Puzzlestück

Es gibt allerdings einen Umstand, der über den Erfolg von 25 GbE als Mechanismus für Top-of-Rack-Verbindungen entscheiden könnte.

„Ob man es im großen Stil als Zugriffs-Technologie für Server einsetzt, hängt von der Unterstützung der Server-Anbieter für die NICs ab“, sagte Lerner. „Die Margen bei Servern sind gering. Deswegen gibt es keinen Vorteil, wenn man diese Technologie früh einführt und ausliefert, bevor es die breite Masse braucht. Somit tendieren die Anbieter zum Warten“, denkt er.

Die Notwendigkeit für 25 GbE ist da, die Lösung ist zum Greifen nahe und das Potenzial ist groß.

Warten diese Anbieter zu lange, wird 25 GbE in erster Linie eine Switch-zu-Switch- und keine Server-zu-Switch-Technologie, fügte er an. Das gilt im Speziellen, wenn sich die Server-Anbieter entscheiden, NICs mit Unterstützung für 40 GbE einzusetzen. Genau das hat Intel mit seinen kommenden XL710-NICs (Codename Fortville) getan. Im September 2014 kündigte Intel an, dass man damit 40 Gbps unterstützen könnte. Trotz aller Vorteile von 25 GbE hinsichtlich Effizienz und Kosteneinsparungen in anderen Teilen des Netzwerks, würde es das Top-of-Rack im Regen stehen lassen.

Dell hat sich dem Konsortium für 25-Gigabit-Ethernet angeschlossen. Intel und Sun/Oracle glänzen allerdings durch Abwesenheit. Das Konsortium hat durchblicken lassen, dass man bald neue Mitglieder vorstellt. Mehr Details gibt es hierzu allerdings nicht.

„Ich halte inne, da einige der Branchengößen kein Engagement zeigen“, sagte Roberts von CareerSource. „Warum zögern Sie? Warum zeigen sie keine Begeisterung? Warum sehen sie die Vorteile nicht und springen nicht auf den Zug auf?“, hinterfragt er.

Um die potenzielle Einführungskurve für 25 GbE zu sehen, müssen sich die Anbieter nur beim Vorgänger 10 GbE umschauen, erklärte Buraglio.

„Wenn es im Equipment enthalten ist, verwenden es die Kunden auch. Genau so fand 10 GbE Zuspruch. Es war schon sehr lange auf dem Markt, aber plötzlich gab es Server mit einer 10-Gig-NIC“, sagte er. „Im Endeffekt müssen die Puzzlestücke zusammenfinden. Das sind die Chip- und Hardware-Hersteller auf der Netzwerk- und die auf der Server-Seite. Sie müssen alle am selben Strang ziehen. Sollte das passieren, werden es die Anwender einfach nutzen“, glaubt er.

Folgen Sie SearchNetworking.de auch auf Twitter, Google+ und Facebook!