cherezoff - stock.adobe.com

Disaggregation als Schlüssel zu präziser Analyse

Aggregierte Zahlen täuschen Objektivität vor. Erst disaggregierte Daten machen sichtbar, wie ungleich Systeme wirken und was Unternehmen daraus lernen können. Der Text zeigt wie.

Daten versprechen Objektivität. Doch sobald sie zu Mittelwerten verdichtet werden, verlieren sie ihre Aussagekraft über die Realität. Aggregation, das rechnerische Zusammenführen von Einzelwerten, schafft Übersicht, aber auch Trugschlüsse. Sie glättet Differenzen, nivelliert Unterschiede, verdeckt Ausreißer. Was bleibt, ist eine scheinbare Wahrheit. In sozialen, ökonomischen und technischen Systemen wird dieser Informationsverlust zunehmend zum Problem.

In Unternehmen zeigt sich das Dilemma aggregierter Daten besonders deutlich im Controlling, Vertrieb und Personalwesen. Wenn etwa der durchschnittliche Umsatz pro Region stabil erscheint, kann das intern als Zeichen gesunder Geschäftsentwicklung gewertet werden. Doch eine disaggregierte Betrachtung zeigt möglicherweise, dass nur wenige Großkunden das Ergebnis tragen, während viele kleinere Kunden Umsatzverluste aufweisen.

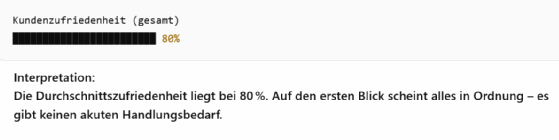

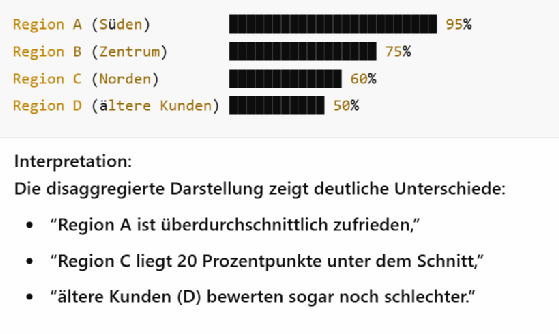

Ähnlich trügerisch wirkt der aggregierte Krankenstand im Personalbereich: Ein Wert von 3,2 Prozent suggeriert Normalität, verdeckt aber, dass bestimmte Abteilungen überdurchschnittlich betroffen sind, etwa durch hohe psychische Belastung oder schlechte Führung. Auch in der Kundenanalyse führt Aggregation zu Fehleinschätzungen: Eine mittlere Kundenzufriedenheit von 80 Prozent klingt beruhigend, bis klar wird, dass wichtige Zielgruppen wie Neukunden oder bestimmte Märkte deutlich unter dem Schnitt liegen. Aggregation produziert Übersicht, aber oft auf Kosten der Erkenntnis.

Disaggregierte Ansichten liefern in diesem Zusammenhang eine bessere Information

Disaggregation als Antwort: Strukturen sichtbar machen

Disaggregation durchbricht diese Illusion. Sie beschreibt die gezielte Zerlegung aggregierter Daten entlang relevanter Merkmale, etwa Region, Alter, Geschlecht, Zeit oder Produktkategorie. Entscheidend dafür ist eine Architektur, in der Rohdaten und beschreibende Metadaten getrennt vorliegen. Erst diese Trennung erlaubt es, Kennzahlen nicht nur übergreifend zu betrachten, sondern kontextspezifisch auszuwerten. Die Frage ist nicht mehr: Wie hoch ist die Gesamtnachfrage, sondern: Wer fragt wann, wo, unter welchen Bedingungen nach?

Warum disaggregierte Daten präzisere Entscheidungen ermöglichen

In vielen Unternehmen beruhen strategische Entscheidungen auf Kennzahlen, die auf aggregierten Daten basieren. Das ist effizient, aber nicht immer zielführend. Ein durchschnittlich hoher Net Promoter Score im Kundenservice kann darüber hinwegtäuschen, dass einzelne Produktlinien oder Regionen deutlich schlechter bewertet werden. Ähnlich im Außendienst: Wenn aggregierte Verkaufszahlen solide erscheinen, bleibt oft unentdeckt, dass bestimmte Segmente unterdurchschnittlich performen, etwa neue Zielmärkte oder bestimmte Kundentypen. Auch in der Personalentwicklung wird das Prinzip sichtbar. Ein aggregierter Wert zur Mitarbeiterzufriedenheit liefert kaum Hinweise auf abteilungsspezifische Probleme oder Unterschiede zwischen Standorten. Erst durch die disaggregierte Betrachtung lassen sich solche Muster erkennen und gezielt darauf reagieren, etwa durch angepasste Trainings, eine differenzierte Ressourcenverteilung oder marktgerechte Anpassungen im Portfolio.

Das Prinzip der Intersektionalität: Mehr als die Summe der Merkmale

Besonders relevant wird Disaggregation, wenn man berücksichtigt, dass Menschen nicht nur einer Kategorie zuzuordnen sind. Intersectionality (Intersektionalität) beschreibt, wie sich verschiedene Merkmale, etwa Ethnie, Geschlecht, Einkommen, Alter, überschneiden und so spezifische Benachteiligungen erzeugen. So zeigen Studien, dass selbst reiche schwarze Mütter in den USA deutlich höhere Risiken bei der Geburt haben als gleichwohlhabende weiße Frauen. Ohne disaggregierte Daten wären solche Mehrfachdiskriminierungen unsichtbar.

Fehlende Differenz: Wenn Aggregation zur Täuschung wird

Ein weiteres Beispiel liefert eine Studie zu Kindersterblichkeit: Betrachtet man die Daten nur für hispanische Kinder, dominiert als Todesursache angeborene Fehlbildungen. Disaggregiert man jedoch nach Subgruppen, zeigt sich, dass bei puertoricanischen Kindern niedriges Geburtsgewicht die häufigste Ursache ist. Das hat direkte Konsequenzen für medizinische Maßnahmen und Präventionsstrategien, sofern die Daten disaggregiert vorliegen.

Disaggregierte Planungssysteme: SAP als technisches Fundament

Im Unternehmenskontext sind disaggregierte Datenarchitekturen längst Realität, zum Beispiel im SAP-Umfeld. Dort basieren Planungen auf einer Matrix aus Berechnungsarten und zeitlichen Disaggregationsarten, die präzise steuern, wie aggregierte Werte verteilt oder berechnet werden. Dazu gehören:

- S (Pro Rata): Gleichmäßige Verteilung auf Detailebene.

- P (nach anderer Kennzahl): Verteilung gewichtet anhand eines Referenzwerts.

- A, D, E, F: Durchschnittsvarianten mit oder ohne Berücksichtigung von Nullwerten.

- I (intelligente Mischung): Kombination aus P und S, je nach Datenlage.

- N (keine Disaggregation): Werte werden nur auf oberer Ebene gehalten.

Entsprechendes gilt für die zeitliche Verteilung, etwa:

- P (proportional),

- E (gleichverteilt),

- K (nach anderer Zeitkennzahl) oder

- L (Wert aus letzter Periode), etwa im Supply Network Planning.

Initialwerte und Nullwerte spielen dabei eine zentrale Rolle. Abhängig von der Kennzeichnungslogik kann eine Null bewusst gesetzt, also gültig, oder einfach ein nicht vorhandener Wert sein. Das wirkt sich direkt auf die Berechnungslogik aus.

Mehr Kontrolle, bessere Prognosen, gezieltere Maßnahmen

Der Nutzen disaggregierter Planungssysteme liegt in der präzisen Steuerbarkeit komplexer Wertströme und Datenstrukturen. Unternehmen können damit nicht nur aggregierte Ziele setzen, sondern diese systemgestützt nach definierten Regeln auf operative Ebenen herunterbrechen, und bei Bedarf automatisiert wieder hochrechnen. Das schafft Konsistenz über Planungsebenen hinweg und erhöht die Genauigkeit in der Steuerung.

In der Produktion erlaubt das zum Beispiel, monatliche Absatzpläne auf Wochen oder Tage zu verteilen, gewichtet nach historischen Verbrauchsmustern oder Kapazitätsgrenzen einzelner Fertigungslinien. Werden Störungen oder Nachfragespitzen sichtbar, können einzelne Perioden gezielt angepasst werden, ohne die Gesamtplanung zu verzerren.

In der Industrie profitieren Unternehmen etwa in der Instandhaltungsplanung. Aggregierte Budgetvorgaben lassen sich anhand tatsächlicher Anlagenzustände oder Ausfallrisiken auf einzelne Werke und Zeitscheiben verteilen. Das erleichtert nicht nur die Priorisierung technischer Maßnahmen, sondern erhöht auch die Investitionseffizienz.

Im Handel wiederum ermöglicht die Disaggregation, Jahresumsatzziele nicht nur auf Filialen oder Warengruppen herunterzubrechen, sondern auch auf Werbezeiträume, regionale Sortimente oder Vertriebskanäle. So lassen sich saisonale Effekte, regionale Absatzunterschiede oder Produktspezifika gezielt abbilden und steuern.

Disaggregation als operative Brücke zwischen Strategie und Umsetzung

Disaggregierte Planungslogiken verbinden das Strategische mit dem Operativen. Sie erlauben es, übergeordnete Zielgrößen systematisch und konsistent auf die relevanten Ebenen, Perioden und Einheiten aufzuteilen. Durch die Kombination von flexibler Datenstruktur, regelbasierter Verteilung und systemgestützter Aggregationskontrolle entsteht ein belastbares Fundament für präzise Prognosen, transparente Anpassungen und faktenbasierte Entscheidungen. Unternehmen gewinnen damit nicht nur analytische Tiefe, sondern auch operative Klarheit, und vermeiden den Steuerungsverlust, der entsteht, wenn Datenstrukturen zu grob oder zu starr sind.

Leistung in der Tiefe: Was Disaggregation in der KI leistet

Auch im Bereich maschinellen Lernens zeigen sich die Grenzen aggregierter Metriken. Eine Gebauigkeit (Accuracy) von 90 Prozent klingt vielversprechend, sagt aber nichts darüber aus, ob bestimmte Gruppen systematisch benachteiligt werden. Die Performance Discrepancy (Leistungsdiskrepanz) beschreibt genau diesen Unterschied: Wie stark weicht die Leistung in bestimmten Kohorten vom Gesamtwert ab?

Beispiel: Eine Gesichtserkennungs-KI erkennt weiße Männer mit hoher Genauigkeit, versagt aber bei Frauen mit dunkler Hautfarbe, kurzen Haaren und neutralem Gesichtsausdruck mit einer Fehlerrate von bis zu 35 Prozent. Diese Diskrepanz bleibt in der aggregierten Gesamtleistung verborgen, wird aber durch disaggregierte Kohortenanalyse sichtbar (die dazugehörige Studie finden Sie hier).

Automatisierte Kohortenbildung: Fehler systematisch entdecken

Zur Identifikation solcher Kohorten, wie im vorhergehenden Abschnitt besprochen, kommen automatisierte Verfahren zum Einsatz, etwa Entscheidungsbäume, die Daten entlang von Merkmalen wie Geschlecht, Alter oder Einkommen segmentieren. Tools wie Microsofts Responsible AI Dashboard visualisieren diese Gruppen und zeigen, wo Fehler konzentriert auftreten. Dabei geht es nicht nur um Fairness: In sicherheitskritischen Anwendungen, etwa bei selbstfahrenden Autos, die bei Nacht keine Ampeln erkennen, kann ein lokaler Fehler zur Katastrophe führen.

Backward Compatibility: Wenn Updates neue Fehler erzeugen

Ein weiteres Risiko sind Modell-Updates, die zwar die Gesamtgenauigkeit verbessern, aber neue Fehler erzeugen, insbesondere in sensiblen Gruppen. Der Begriff Backward Compatibility (Rückwärtskompatibilität) beschreibt die Fähigkeit eines Systems, bei Aktualisierungen konsistent zu bleiben. Studien zeigen, dass selbst bei gleichen Trainingsdaten und Modellarchitekturen die Konsistenz nach einem Update auf nur 40 Prozent sinken kann. Disaggregierte Vergleichsmetriken helfen, diese Effekte zu erkennen und kontrolliert zu kommunizieren.

Kontext zählt: Kleine Kohorten nicht ignorieren

Gerade bei sensiblen Kohorten mit geringer Fallzahl, etwa ethnische Minderheiten in Gesundheitsdaten, besteht die Gefahr, sie wegen statistischer Unsicherheit zu ignorieren. Disaggregierte Modelle zeigen, dass genau dort überdurchschnittlich viele Fehler auftreten können. Daher lautet die Empfehlung Kohorten nicht nach Menge, sondern nach Kosten der Fehler priorisieren. In der Kreditvergabe etwa kann ein Fehler bei großen Summen gravierender sein als bei kleinen, trotz gleicher Fehlerrate.

Datenhoheit und Verantwortung: Wer darf was mit Daten tun?

Ein oft übersehener Aspekt ist die Datenhoheit. Viele Organisationen liefern Daten an zentrale Systeme und verlieren den Zugriff darauf. Berichte werden erstellt, aber die erhobenen Daten fließen nicht zurück an die Erhebenden. Das erzeugt Frust, Misstrauen und Effizienzverlust. Disaggregation muss deshalb auch bedeuten: Ergebnisse aufbereiten, zurückspielen, verwertbar machen, ein Prinzip, das man als Closing the Loop bezeichnet.

Partizipation: Wenn Communities ihre Daten mitgestalten

Einige Organisationen setzen bereits auf Community-Based Participatory Research. Sie binden Betroffene frühzeitig in die Definition von Fragestellungen, Erhebung, Auswertung und Interpretation ein. Das sichert nicht nur bessere Datenqualität, sondern schützt auch vor Stigmatisierung. Denn Disaggregation kann auch schaden, wenn sensible Daten falsch dargestellt oder pauschalisiert werden.

Ein Beispiel: In ländlichen Regionen von Kansas gilt es in manchen religiös geprägten Flüchtlingsgemeinden als normal, die Schule nach der 8. Klasse zu verlassen. Wer hier mit nationalen Bildungsbenchmarks arbeitet, ohne den kulturellen Kontext zu berücksichtigen, erzeugt falsche Schlussfolgerungen und unter Umständen diskriminierende Maßnahmen (siehe relevante Studie hier).

Disaggregation als Haltung: Daten zur Verantwortung bringen

Disaggregation ist kein rein technisches Verfahren, sondern Ausdruck einer Haltung. Wer Daten differenziert analysiert, erkennt Unterschiede an, statt sie zu glätten. Wer Kohorten bildet, sieht Menschen, mit ihren Kontexten, Herausforderungen und Ressourcen. Sichtbarkeit ist dabei keine Eigenschaft von Daten. Sie ist eine Frage der Struktur.