sdecoret - stock.adobe.com

Cisco Silicon One P200: Chip-Basis für KI-Rechenzentren

Ciscos Silicon One P200 und der 8223-Router zielen auf Scale-Across-KI-Netze über mehrere Rechenzentren. Technik, Effizienz, Konkurrenz – und was Unternehmen jetzt planen sollten.

Ein neuer Silicon-One-Chip von Cisco sowie ein KI-Routing-System werden vorerst hauptsächlich von Kunden der Kategorie Hyperscaler genutzt werden. Experten glauben jedoch, dass sie eine Schlüsselrolle in der KI-Infrastruktur von Unternehmen der Zukunft spielen könnten.

Ciscos Silicon One, der erstmals 2019 auf den Markt gebracht wurde, ist eine hochskalierbare Netzwerkchip-Architektur. Sie kann in verschiedene Netzwerkgeräte für unterschiedliche Aufgaben in Rechenzentren integriert werden, darunter Low-End-Konvergenz-Zugangs- und Edge-Router sowie Core-Rechenzentrums-Switches. Cisco hat nun damit begonnen, seinen neuesten P200-KI-Netzwerkchip und eine entsprechende Reihe von Routern der Serie 8223 an Hyperscaler-Kunden, darunter Alibaba und Microsoft Azure, auszuliefern.

Was hinter Scale-Across steckt

Der Silicon One P200 und die entsprechenden Router-Systeme sind für Scale-Across-Netzwerke ausgelegt, bei denen mehrere Rechenzentrumsstandorte zu einem logisch einheitlichen KI-Cluster gekoppelt werden. Der Treiber hierfür sind die Strom- und Flächenlimits einzelner Standorte, durch die GPU-Cluster über Stadt- und Regionsgrenzen hinweg verteilt werden. Das Ziel besteht darin, eine deterministische Performance über Distanzen mit an Distanz/Topologie angepasster Staukontrolle (Congestion Control), Telemetrie und Ausfallsicherheit zu erreichen.

„Sowohl Cloud-Hyperscaler als auch Entwickler von KI-Frontier-Modellen stoßen an diese Grenzen und an die Grenzen des Stromnetzes einer einzelnen Stadt, da ihre Anforderungen an GPU-basierte Rechenleistung explosionsartig steigen“, erklärt Sameh Boujelbene, Analystin bei der Dell'Oro Group.

„Dies ist einer der größten Schwachpunkte der Branche“, so Boujelbene. „Das Strombudget eines bestimmten Rechenzentrums – manchmal sogar einer bestimmten Stadt – ist sehr begrenzt und reicht nicht aus, um Hunderttausende von GPUs anzuschließen. Daher müssen Hyperscaler diesen KI-Cluster auf mehrere Rechenzentren und Städte verteilen.“

Einordnung des Cisco 8223/P200: Architektur, Effizienz, Betrieb

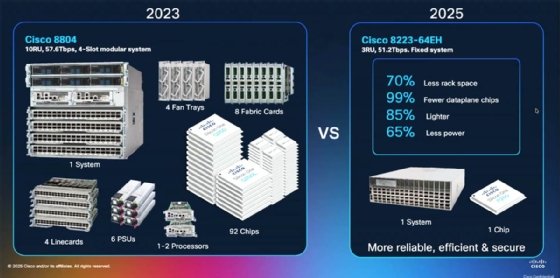

Cisco verfügt mit dem KI-Chip, den Switches und Routing-Systemen über eine Silicon-One-Produktlinie, die zur weiteren Optimierung der Energieeffizienz neu gestaltet wurde. Laut Cisco führt dies zu „Routing-Fähigkeiten mit Switching-Bandbreite und -Effizienz“ in einem einzigen 3-HE-Chassis. Das 8223-System und der P200 bieten laut Hersteller einen Durchsatz von 51,2 TBit/s bei hoher Portdichte (64 800-GbE-Ports) und unterstützen 800G-kohärente Optiken bis in den Long-Haul-Bereich. Damit adressiert die Plattform explizit DCI-/Metro-Szenarien.

Cisco zufolge ist die Paketverarbeitung innerhalb von Silicon One mit einem vollständig gemeinsam genutzten Deep Buffer in der Branche einzigartig. Deep Buffers sind zwar nichts Neues, haben in Teilen der Branche jedoch einen schlechten Ruf, da sie als zu langsam und ineffizient gelten, um KI-Workloads zu unterstützen, so Rakesh Chopra, Senior Vice President und Fellow bei Cisco.

„Es gibt die Annahme, dass tiefe Puffer die KI-Workloads verlangsamen – wenn man sich jedoch die Details genauer ansieht, stellt sich heraus, dass dies nicht zutrifft“, sagt er. „Aufgrund eines unzureichenden Überlastungsmanagements kommt es zu Überlastungen im Netzwerk, die von diesen Puffern absorbiert werden. Durch die Vorhersagbarkeit von KI-Workloads und proaktive Überlastungskontrolle lässt sich dieses Problem lösen, aber tiefe Puffer sind nach wie vor erforderlich, um mit Ausfällen im Netzwerk umzugehen – und das ist in dieser Größenordnung die Regel und keine Ausnahme.“

Die angekündigte Leistungssteigerung des P200 trägt ebenfalls zur Beschleunigung der tiefen Pufferung bei und ein einziger gemeinsamer tiefer Puffer im neuen 8000-System soll für weitere Energieeffizienzsteigerungen sorgen.

„Wir verschieben die Paketdaten eigentlich nicht in diesem vollständig gemeinsam genutzten Paketpuffer – wir schreiben die Pakete einmal, lesen sie einmal und manipulieren lediglich die Deskriptoren“, erklärte er. „Wenn man all das erreicht hat, ergibt sich ein Compounding-Effekt, weil alles viel kleiner geworden ist – wir können die Leistung unserer Lüfter reduzieren, wir können bei der Stromumwandlung sparen ... wir versuchen, jedes einzelne Watt in diesem System einzusparen ... denn das ist die grundlegende Einschränkung in dieser Branche.“

Was ist konkret neu?

Mit der jüngsten Ausbaustufe der Plattform adressiert Cisco die Skalierungsgrenzen moderner, KI-orientierter Rechenzentrumsnetze. Im Fokus stehen eine höhere Port- und Bandbreitendichte, eine verlässlichere Performance unter Last sowie ein effizienterer Betrieb über Standorte hinweg. Die wichtigsten Punkte im Überblick:

- Leistung und Dichte: 51,2 TBit/s in 3 HE, 64 × 800 GE, > 20 Milliarden Pakete/s und Skalierung bis in die Exabit-Klasse über mehrstufige Topologien.

- Pufferung: vollständig gemeinsam genutzte Deep-Buffer-Architektur zur Absorption von Burst- und Fehlerszenarien ohne GPU-Stalls.

- Optik und Distanzen: Unterstützung für kohärente 800G-Optiken (Metro/Long-Haul), die für Data Center Interconnect über Städte/Regionen relevant sind.

- Betriebssysteme: Start mit SONiC (Open Networking in the Cloud), weitere Optionen (unter anderem IOS XR, perspektivisch NX-OS in Switch-Formfaktoren) sind in Aussicht.

- Sicherheit: Line-Rate-Verschlüsselung, Hardware-Root-of-Trust und erweiterte Telemetrie sind wichtig bei standortübergreifendem Datenverkehr.

Vergleich mit Nvidia und Broadcom

Nvidias Spectrum-XGS erweitert die Ethernet-Plattform um Scale-Across-Funktionalität. Kernpunkte sind distanzbewusste Staukontrolle, Latenzmanagement und Telemetrie. Zusammen mit ConnectX-8-SuperNICs (bis 800 GBit/s) entsteht eine Ende-zu-Ende-Plattform, die verteilte Rechenzentren als einen GPU-Cluster betreibt. Der Nvidia-Partner CoreWeave nutzt Spectrum-XGS.

Broadcom adressiert zwei benachbarte Rollen: Jericho 4 ist ein Deep-Buffer-Routing-ASIC (51,2 TBit/s, unter anderem 3,2-TBit/s-HyperPorts für breite Links und RoCE-DCI über große Distanzen) und Tomahawk Ultra. Das ist ein ASIC mit 51,2 TBit/s Leistungsvermögen und einer Switch-Latenz von circa 250 ns auch bei Min-Packets (64-Byte-Frames) für latenzkritische Fabric-Stufen nahe an GPU-Zellen.

Damit formt sich ein Dreikampf um die Achsen verteilter KI-Netze: Nvidia (Switch/NIC/Software), Broadcom (Jericho/Tomahawk) und Cisco (P200/8223 als Deep-Buffer-Router mit Switching-Effizienz).

Heute Hyperscaler, morgen Unternehmens-KI?

Laut Boujelbene liegen Unternehmen noch weit hinter den Entwicklern von Grenzmodellen und Cloud-Hyperscalern zurück, wenn es darum geht, die Grenzen von KI-Netzwerken und Rechenzentren zu erweitern.

Sie sagt, dass es möglicherweise einen Trickle-Down-Effekt geben könnte, wenn Hyperscaler skalierbare KI-Netzwerke nutzen, um Rechenzentren in Regionen mit günstigeren Strompreisen zu errichten und gleichzeitig die Kohärenz der Cluster untereinander aufrechtzuerhalten.

Boujelbene fügt hinzu, dass bestimmte Early-Adopter-Segmente in der Unternehmens-KI, etwa das Gesundheitswesen oder nationale Regierungen, Scale-Across-Systeme früher als die meisten anderen benötigen.

„Jede Regierung betrachtet KI als einen sehr, sehr wichtigen Differenzierungsfaktor, und es geht um Leben und Tod”, sagt sie und fügt hinzu: „Die Regierungen liefern sich ein Wettrennen, nicht nur um den Aufbau ihrer KI-Infrastruktur, sondern auch um die Kontrolle darüber. Wer das einsetzen wird und wo, ist ein wichtiges Thema, und Cisco ist nicht nur in den USA, sondern auch im Nahen Osten und in Europa sehr aktiv in Regierungsprojekten.“

Langfristig könnte das modulare Design der Cisco-Silicon-One-Systeme als Einstiegspunkt für Unternehmen dienen, wenn sie ihre KI-Infrastrukturen erweitern, meint Matthew Kimball, Analyst bei Moor Insights & Strategy, in einer E-Mail an Informa TechTarget.

„KI wird dazu führen, dass viele Unternehmen ein Hyperscale-artiges Verhalten an den Tag legen und die schnellste und reichhaltigste Netzwerkstruktur und -verbindung aufbauen, um agentische KI in großem Maßstab voranzutreiben“, schreibt Kimball. „Silicon One P200 ist eine einzige Architektur mit fünf [Geräteprofilen], die unterschiedliche Bereitstellungsanforderungen abdecken. Die Konsistenz der Architektur bedeutet, dass diese Hyperscale-artigen Anforderung der KI für Unternehmen erfüllt werden kann.“

Ethernet, InfiniBand und UEC: Wohin geht die Reise?

InfiniBand bleibt in eng gekoppelten Trainings-Clustern stark. Gleichzeitig zeigen Hyperscaler, dass auf RoCE (RDMA over Converged Ethernet) basierende Ethernet-Fabrics auch in großem Maßstab funktionieren – mit einem anspruchsvollen Zusammenspiel aus ECN/PFC, Puffer-Tuning und Telemetrie. Parallel dazu präzisiert die UEC-Spezifikation (Ultra Ethernet Consortium) ein AI/HPC-Profil für Ethernet (UET/Transport, In-Network Collectives, Telemetrie, Congestion-Control). Für Scale-Across-Szenarien zielen alle großen Silizium-Roadmaps sichtbar auf deterministischere, verlustarme Ethernet-Fabrics.

Fazit

Cisco treibt mit Silicon One P200 und dem 8223 die Konvergenz von Routing und Switching für KI-Backbones voran: 51,2 TBit/s in 3 Höheneinheiten, hohe Energieeffizienz, gemeinsam genutzte Deep Buffer und Sicherheitsfunktionen adressieren zentrale Scale-Across-Risiken. Im Wettbewerb mit Nvidia (Spectrum-XGS) und Broadcom (Jericho 4/Tomahawk Ultra) verdichtet sich das Bild: Ethernet wird für KI verteilter und deterministischer. Für Unternehmen heißt das: Heute den DCI-/Backbone-Pfad evaluieren und ein Pilotprojekt durchführen.