Prompt Chaining

Was ist Prompt Chaining?

Prompt Chaining ist eine Technik, die bei der Arbeit mit generativen Modellen der künstlichen Intelligenz (generative KI) verwendet wird, bei denen die Ausgabe eines Prompts als Eingabe für den nächsten Prompt verwendet wird. Diese Methode ist eine Form des Prompt Engineering, bei dem die Art und Weise, wie Fragen und Probleme gestellt werden, verbessert wird, um eine bessere Ausgabe von vorab trainierten generativen KI-Modellen zu erzielen.

Prompt Chaining eignet sich am besten, um ein kompliziertes Problem stückweise zu lösen oder eine erste Ausgabe zu verfeinern und zu erweitern. Es ist hilfreich für Benutzer, die zwar eine Aufgabe und eine allgemeine Vorstellung von der gewünschten Ausgabe haben, aber nicht wissen, wie die genauen Details oder die Struktur dieser Ausgabe aussehen sollten.

Prompt Chaining wird am häufigsten bei der Interaktion mit Large Language Models (LLMs) verwendet, da diese Modelle den Kontext gut beibehalten und zuvor generierte Ausgaben verfeinern können, ohne zu viele Änderungen vorzunehmen oder wünschenswerte Funktionen zu entfernen. Entwickler arbeiten daran, die Ausgabe anderer Arten generativer KI-Modelle, wie zum Beispiel Bildgeneratoren, iterativ zu verfeinern. Das Bildgenerierungsmodell Dall-E von OpenAI, das über ChatGPT zugänglich ist, bietet diese Möglichkeit beispielsweise mit unterschiedlichem Erfolg.

Wie funktioniert Prompt Chaining?

Der Prozess beginnt wie jede andere Interaktion mit einem generativen KI-Modell: Das Modell erhält einen ersten Prompt, in der Regel eine Frage oder eine Aussage, die die gewünschte Ausgabe beschreibt. Nach der Verarbeitung dieses ersten Prompts generiert das Modell seine erste Ausgabe.

Diese erste Ausgabe wird dann entweder von einem menschlichen Benutzer oder einem automatisierten System, das darauf trainiert ist, anhand von Kriterien wie Genauigkeit und Kreativität zu überprüfen, ausgewertet. Basierend auf den Ergebnissen dieser Auswertung erstellt der Benutzer oder das System einen weiteren Prompt, der das Feedback aus der vorherigen Runde berücksichtigt, mit dem Ziel, die Ausgabe näher an die Absicht des Benutzers heranzuführen.

Die Auswertung kann beispielsweise ergeben, dass die erste Ausgabe zu allgemein ist und sich nicht ausreichend auf das Zielproblem konzentriert. Im nächsten Prompt weist der Benutzer das Modell an, sich auf ein bestimmtes Element zu konzentrieren. Der neue Prompt wird in das Modell eingespeist, und der Prozess wird fortgesetzt, bis eine zufriedenstellende Endausgabe erreicht ist.

Aus technischer Sicht ist Prompt Chaining effektiv, da es bestimmte Aspekte der LLM-Architektur nutzt. Strukturell gesehen sind LLMs neuronale Netze, die sich stark auf Transformer-Modelle stützen, die Muster und Beziehungen in langen Sequenzen von Textdaten erkennen können. LLMs eignen sich daher gut, um komplexe Muster zu erkennen und zu replizieren und den Kontext über einen längeren Zeitraum im Auge zu behalten.

Bei der Prompt-Chaining-Methode wird auf Grundlage früherer Ausgaben aufgebaut, wobei jeder neue Prompt den Kontext oder den Fokus schrittweise anpasst. Diese Methode eignet sich gut für die Fähigkeit von LLMs, den Kontext über längere Sequenzen hinweg zu verwalten, und ermöglicht eine nuanciertere Verfeinerung im Vergleich zu einem langen, detaillierten ersten Prompt.

Prompt-Chaining-Techniken

Die Prompt-Chaining-Methode umfasst mehrere Techniken, die einen bestimmten Ansatz zur Verkettung von Prompt beschreiben. LLM-Benutzer sollten die Unterschiede verstehen und wissen, wann sie welche Methode anwenden sollten. Dazu gehören:

- Interaktive Verkettung. Bei dieser Technik wird das Feedback des Benutzers in eine Kette integriert, um in Echtzeit auf die LLM-Ausgaben zu reagieren. Benutzer führen mit dem LLM frei fließende Gespräche und fügen neue Informationen und Ideen hinzu, um die Ausgaben kontinuierlich zu gestalten. LLM-Anwendungen verfeinern ihre Ausgaben als Reaktion auf das menschliche Feedback, das sie erhalten.

- Sequenzielle Verkettung. Der LLM-Benutzer unterteilt komplexe Aufgaben in aufeinanderfolgende Prompts, wobei jeder Prompt einen Schritt oder eine Phase darstellt. Diese Methode eignet sich für Aufgaben wie das Zusammenfassen langer Texte in Abschnitten oder das Sortieren von Datensätzen in verschiedene Teile.

- Prompt-Schleifen. Benutzer erstellen Schleifen aus Prompts, sodass die durch diese Prompts artikulierten Schritte wiederholt für viele verschiedene Aufgaben verwendet werden können. Eine Prompt-Schleife wird beispielsweise bei der Datenverarbeitung verwendet, bei der mehrere Datensätze dieselben Verarbeitungs- und Organisationsaufgaben erfordern.

- Bedingte Verkettung. Benutzer stellen einem LLM eine Wenn-dann-Logik zur Verfügung, um seine Ausgaben zu gestalten. Diese Technik stellt sicher, dass zukünftige Ausgaben auf dieser Logik basieren.

Vorteile des Prompt Chainings

Zu den spezifischen Vorteilen des Prompt Chainings gehören die folgenden:

- Flexibilität. Beim Prompt Chaining wird ein Problem oder eine Abfrage in mehrere Phasen unterteilt, sodass Benutzer mehrere Möglichkeiten haben, Feedback zur Modellausgabe zu geben oder ihren Abfrageansatz zu bearbeiten. Dies bietet eine bessere Flexibilität und Anpassungsfähigkeit bei der LLM-Ausgabe.

- Kreativität. Prompt Chaining ist nützlich für offene, kreative Aufgaben wie Brainstorming. Benutzer führen einen Dialog, bei dem das Modell aufgefordert wird, besonders vielversprechende Ideen zu vertiefen.

- Präzision. Der verkettete Ansatz ermöglicht es den Benutzern, ihre Abfrage schrittweise anzupassen und bei jedem Schritt Feedback zu den Antworten des Modells zu geben. Auf diese Weise liefert die Technik präzisere und qualitativ hochwertigere Antworten von LLMs.

- Effizienz. Die Bearbeitung einer nicht optimalen Antwort mit Prompt Chaining ist oft effizienter, als das gesamte Problem neu zu formulieren oder das Modell zu bitten, seine Antwort neu zu generieren. Anstatt das Modell zu bitten, die gesamte Aufgabe neu zu verarbeiten, konzentriert sich Prompt Chaining auf spezifische, gezielte Verbesserungen.

- Problemlösung. Prompt Chaining zerlegt komplizierte Fragen und Szenarien in kleinere, besser handhabbare Komponenten. Dies macht sie zu einer nützlichen Technik für die Bewältigung komplexer Aufgaben.

- Feinabstimmung. Prompt Chaining ist auch für das Modelltraining und die Feinabstimmung nützlich. Wenn Modelle die Möglichkeit erhalten, aus iterativem Feedback in einem Prompt Chaining-Kontext zu lernen, können sie besser hochwertige und genaue Ergebnisse generieren.

Nachteile des Prompt Chainings

LLM-Benutzer, die auf Prompt Chaining angewiesen sind, können ebenfalls auf Herausforderungen stoßen. Benutzer sollten diese verstehen, bevor sie versuchen, Prompt Chains zu erstellen. Dazu gehören die folgenden:

- Komplexere Verwaltung. Prompt Chaining kann schnell zu einem endlosen Strom von Prompts werden, die schwer zu verwalten sind. Längere Ketten bedeuten mehr Raum für Fehler. Wenn beispielsweise jeder Prompt ein Schritt in einer langen Liste von Schritten ist, kann ein LLM den Kontext zwischen den Schritten verlieren und inkonsistente oder unzusammenhängende Ausgaben erzeugen.

- Fehler in den ersten Prompts. Eine Kette basiert auf dem Inhalt des ersten Prompts. Wenn ein Benutzer innerhalb des ersten Prompts kein klar definiertes Problem formuliert, stimmen die LLM-Ausgaben wahrscheinlich nicht mit den Zielen des Benutzers überein.

- Zeitaufwand. Lange Ketten von Prompts kosten den Benutzer Zeit. Dies gilt insbesondere für Prompt-Entwickler, die Prompt Chaining zur Feinabstimmung von LLMs verwenden.

- Mögliche Kosten. Für Benutzer oder Unternehmen, die LLMs auf kostenpflichtigen Datenplänen verwenden, bedeuten längere Prompt-Ketten einen höheren Zeitaufwand für die Anwendung, was möglicherweise zu höheren Kosten führt.

Wie man eine Prompt Chain erstellt

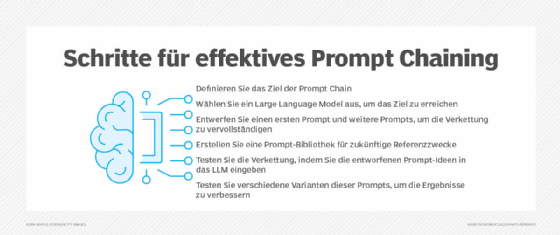

Jede Prompt Chain ist anders, aber es gibt eine Reihe von bewährten Verfahren, die für den grundlegenden Prozess der Kettenerstellung gelten. Viele der Tipps, die für Prompt-Ingenieure gelten, helfen auch typischen LLM-Benutzern. Eine effektive Strategie zum Erstellen von Ketten sollte die folgenden Schritte umfassen:

- Ziele definieren. Das LLM benötigt ein klares Ziel, bevor es eine Prompt Chain erstellt. Alle detaillierten Anweisungen, die ein LLM befolgen muss, sollten sorgfältig durchdacht werden, bevor der erste Prompt gesendet wird.

- Ein LLM auswählen. Wählen Sie ein Large Language Model aus, das zum Ziel der Prompt Chain passt.

- Sequenzen und Teilaufgaben planen. Der erste Prompt ist der wichtigste, aber der Zweck der Prompt Chain besteht darin, ein LLM nicht mit einem anfänglichen komplexen Prompt zu überfordern. Durch die Prompt Chain wird die Komplexität auf mehrere Prompts verteilt, sodass der Benutzer komplexe Details in verschiedene Prompts unterteilen sollte.

- Eine Prompt-Bibliothek aufbauen. Sobald ein neuer Prompt erstellt wurde, sollte er einer Bibliothek oder Referenzliste früherer Prompts hinzugefügt werden, um die Erstellung von Prompts in Zukunft zu vereinfachen.

- Die Kette testen. Der Benutzer sendet den ersten Prompt an das LLM für einen Testlauf und fügt der Antwort des LLMs weitere klärende Prompts hinzu. Prompts können angepasst werden, um zu testen, wie das LLM reagieren würde, und um zu sehen, ob es bessere Ergebnisse liefert.

- Iteratives Verfeinern und Experimentieren. Es lohnt sich, Ketten wiederholt auszuführen und Prompts zu verfeinern, um frühere LLM-Ergebnisse zu verbessern.

Beispiele und Anwendungsfälle für Prompt Chaining

Prompt Chaining ist eine Technik, die sich gut für kreative Anwendungen und komplexe Problemlösungen eignet. Im Folgenden finden Sie Beispiele für Prompt Chaining:

- Softwareentwicklung. Entwickler verwenden Prompt Chaining, um hochwertigen Code zu erstellen. Nachdem sie Code mit einem ersten Prompt generiert haben, verwenden sie Prompt Chaining, um ihn zu optimieren, an bestimmte organisatorische Standards anzupassen und zu debuggen.

- Produktdesign. Produktteams nutzen Prompt Chaining, um die ersten Phasen des Produktdesigns zu durchlaufen. Ein Produktdesigner kann beispielsweise ein LLM verwenden, um die ersten generativen Designdokumente für ein Produkt zu erstellen, und dann Prompt Chaining verwenden, um diese Dokumente auf der Grundlage von Überlegungen wie technischer Machbarkeit und Marktforschung zu verfeinern.

- Content Creation. Marketing- und Content-Teams nutzen Prompt Chaining, um iterativ Marketingmaterialien wie Blogbeiträge, Werbetexte und Social-Media-Beiträge zu erstellen. Prompt Chains unterstützen dabei, einen grundlegenden Entwurf so zu verfeinern, dass er Anforderungen wie Markenimage, Länge und Tonfall entspricht.

- Strategische Planung. Führungskräfte und Unternehmensleiter nutzen verkettete generative KI-Prompts, um strategische Entscheidungen zu unterstützen. Nach der Erstellung einer allgemeinen Marktanalyse vertiefen nachfolgende Prompts bestimmte Bereiche oder führen neue relevante Informationen ein, um schließlich eine detaillierte Szenarioanalyse oder -prognose zu erstellen.