Grid-Computing

Was ist Grid-Computing?

Grid-Computing ist ein System, mit dem eine große Anzahl von Computerknoten zu einer verteilten Architektur verbunden wird, die die zur Lösung komplexer Probleme erforderlichen Rechenressourcen bereitstellt.

Die Knoten können Server oder PCs umfassen, die über das Internet oder andere Netzwerke lose miteinander verbunden und in vielen Fällen über mehrere geografische Regionen verteilt sind. Beim Grid-Computing werden die jedem Knoten zur Verfügung stehenden Ressourcen genutzt, um unabhängige Aufgaben auszuführen, die zu einem größeren Vorhaben beitragen.

Grid-Computing bietet eine Architektur zur Erstellung eines virtuellen Supercomputers, der aus verteilten Computerknoten besteht. Die meisten Grid-Computing-Projekte sind nicht zeitabhängig, und große Projekte werden in der Regel über viele Länder und Kontinente hinweg durchgeführt. In vielen Fällen nutzt ein Grid-Computing-System die ungenutzten Ressourcen eines Knotens, um Grid-bezogene Aufgaben auszuführen – ein Prozess, der als Cycle Scavenging oder CPU Scavenging bezeichnet wird. Diese Aufgaben können viele Wochen lang, wenn nicht sogar länger, im Hintergrund laufen.

Jeder Knoten führt spezielle Grid-Computing-Software aus, die die Teilnahme am Grid ermöglicht. Eine Grid-Umgebung erfordert außerdem einen Kontrollknoten: in der Regel einen Server, der administrative Vorgänge abwickelt und Aufgaben plant. Darüber hinaus verwendet eine Grid-Umgebung Middleware, um das Grid zu erstellen und zu steuern, Prozesse über die Knoten hinweg zu verwalten und die Kommunikation zwischen Anwendungskomponenten zu ermöglichen.

Ein Beispiel für Middleware ist Berkeley Open Infrastructure for Network Computing (BOINC), eine Open-Source-Grid-Computing-Plattform, die in der wissenschaftlichen Forschung weit verbreitet ist. Projekte können auf Tools wie BOINC aufbauen, indem sie benutzerfreundliche GUIs sowie Funktionen zum Verteilen von Rohdaten und zum Empfangen und Speichern von Ergebnissen hinzufügen.

In einer Grid-Computing-Umgebung ist es sehr wahrscheinlich, dass mehrere Rechenknoten die Verbindung trennen oder ausfallen. Aus diesem Grund sollte eine Organisation Redundanz und eine robuste Fehlerbehebung in das Modell integrieren.

Die Organisation sollte auch Sicherheitsaspekte und die Notwendigkeit einer Qualitätskontrolle berücksichtigen. In einigen Grid-Umgebungen sind die Kontrollen beispielsweise sehr locker, und es ist einfach, ein Grid-Projekt einzurichten oder sich einem bestehenden anzuschließen. Wenn Sicherheit oder Qualität oberste Priorität haben, muss die Organisation sicherstellen, dass die richtigen Kontrollen zum Schutz ihrer Ressourcen implementiert wurden.

Wie unterscheidet sich Grid-Computing von anderen Umgebungen?

Grid-Computing wird manchmal als virtuelles Supercomputing bezeichnet, unterscheidet sich jedoch in mehreren wichtigen Punkten vom Supercomputing. Ein Supercomputer besteht aus einer großen Anzahl von Prozessoren, die parallel in einem begrenzten Bereich, zum Beispiel einem speziellen Rechenzentrum, betrieben werden. Eine Grid-Umgebung kann hingegen über den ganzen Globus verteilt sein.

Supercomputer verwenden Hochgeschwindigkeitsnetzwerke und führen stark vernetzte Anwendungen aus, anstatt unabhängig voneinander funktionierende Knoten. Grid-Systeme hingegen tauschen nur wenige oder gar keine Daten zwischen den Knoten aus und kommunizieren in der Regel über Internetverbindungen von geografisch verteilten Standorten aus.

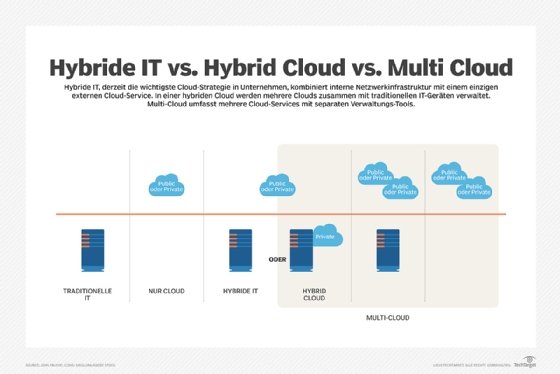

Grid-Computing unterscheidet sich auch vom Cloud Computing, einer weiteren Form des verteilten Rechnens. Cloud Computing liegt funktional zwischen Grid-Computing und Supercomputing.

Cloud-Umgebungen sind granularer, standardisierter und können zeitabhängige Workloads effektiver verarbeiten. Obwohl Cloud-Ressourcen geografisch verteilt sein können, sind sie in der Regel auf wenige, zentral verwaltete Standorte beschränkt – im Gegensatz zu den Tausenden oder Millionen weit verstreuten Knoten, die an einem Grid-Netzwerk beteiligt sein können.

Grid-Computing wird häufig als Vorläufer des Cloud Computing angesehen, das mittlerweile eine zentrale Rolle in der weltweiten Datenverarbeitung spielt. Viele Organisationen verlagern rechenintensive Aufgaben heute in die Cloud oder nutzen hybride Ansätze, die Cloud- und Grid-Kapazitäten kombinieren.

Durch diese Integration können Unternehmen die elastische Skalierung und das Pay-as-you-go-Modell der Cloud nutzen und gleichzeitig die Vorteile des Grid-Modells beibehalten, etwa die Einbindung verteilter, oft freiwillig bereitgestellter Ressourcen.

Darüber hinaus verschwimmen die Grenzen zwischen den Konzepten zunehmend: Heutige HPC-Cloud-Angebote und Container-Orchestrierungssysteme wie Kubernetes ermöglichen verteiltes Rechnen mit ähnlichen Eigenschaften wie klassische Grids – jedoch mit höherer Automatisierung, Standardisierung und Sicherheit.

Was sind die Einsatzmöglichkeiten von Grid-Computing?

Grid-Computing wird von Regierungen, Universitäten, kommerziellen Unternehmen und einer Vielzahl anderer Organisationen und Einzelpersonen genutzt, um bei Projekten zusammenzuarbeiten und komplexe Probleme zu lösen. Grid-Systeme können Rechenleistung für eine Vielzahl von Projekten bereitstellen, darunter Genforschung, die Suche nach geeigneten Medikamentenkandidaten, Sicherheitsprogramme der Regierung und historische Untersuchungen, wie beispielsweise die Suche nach dem Grab von Dschingis Khan.

Grid-Computing kann auch für viele andere Arten von Analysen eingesetzt werden, beispielsweise zur Modellierung finanzieller Risiken, zur Untersuchung seismischer Aktivitäten oder zur Analyse von Wettermustern.

Darüber hinaus spielt Grid-Computing weiterhin eine Rolle im wissenschaftlichen Hochleistungsrechnen – insbesondere in Projekten, die weltweit große Datenmengen analysieren, wie das Worldwide LHC Computing Grid (WLCG) des CERN.

Ein beliebtes und historisch bedeutendes Grid-Projekt ist SETI@home, ein wissenschaftliches Experiment der University of California in Berkeley. Das Projekt nutzte mit dem Internet verbundene Computer, um nach außerirdischer Intelligenz zu suchen, wobei Millionen von PCs ein Suchprogramm für einen segmentierten Teil der Radioteleskopdaten ausführten. Obwohl das SETI@home-Projekt seit 2020 keine Aufgaben mehr verteilt, wird im Rahmen des Projekts weiterhin an der Backend-Datenanalyse gearbeitet.

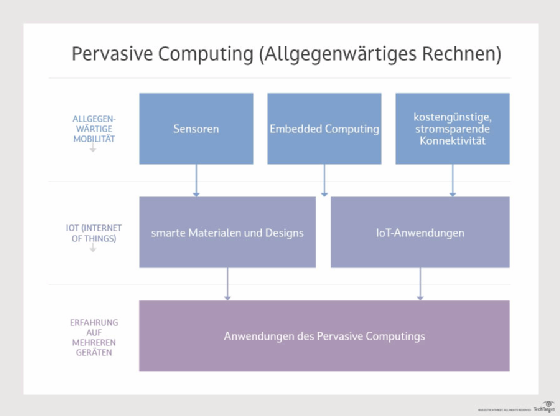

Auch moderne Konzepte wie Volunteer Computing oder Edge Computing nutzen teilweise ähnliche Prinzipien wie das Grid-Modell, um verteilte Ressourcen zu bündeln – sei es in wissenschaftlichen Netzwerken, bei IoT-Anwendungen oder in hybriden Forschungsumgebungen.

Die Grid-Computing-Architektur kann enorme Rechenleistung für die Lösung eines Problems bereitstellen, wie SETI@home, BOINC und das WLCG eindrucksvoll gezeigt haben.

Das verteilte Modell eignet sich jedoch vor allem für Aufgaben, die sich gut in unabhängige Teilaufgaben zerlegen lassen. Für stark gekoppelte Anwendungen mit hohem Kommunikationsbedarf sind HPC-Cluster oder Cloud-HPC-Lösungen meist effizienter.

Das Wichtigste auf einen Blick: Grid-Computing

Grid-Computing bündelt weltweit verteilte Rechenressourcen zu einem virtuellen Supercomputer, um komplexe wissenschaftliche oder technische Aufgaben zu lösen. Es nutzt ungenutzte Kapazitäten einzelner Rechner effizient und ermöglicht dadurch kostengünstige, kooperative Datenverarbeitung über Länder- und Institutionsgrenzen hinweg. Bekannte Beispiele sind das Worldwide LHC Computing Grid (WLCG) des CERN, das SETI@home-Projekt zur Suche nach außerirdischer Intelligenz oder medizinische Forschungsinitiativen auf Basis von BOINC. Obwohl Cloud- und HPC-Lösungen heute dominieren, bleibt Grid-Computing ein bedeutendes Konzept für verteiltes Rechnen, insbesondere in der Forschung, Simulation und Datenanalyse.