HPE

HPE vereint Aruba und Juniper für AIOps, Wi-Fi 7, OpsRamp

HPE bündelt Aruba und Juniper, bringt KI gestützte Verwaltung, Wi-Fi 7 APs sowie neue Switches und Router. OpsRamp und GreenLake verzahnen Beobachtbarkeit im Hybridbetrieb.

Hewlett Packard Enterprise (HPE) treibt die Integration von Aruba und Juniper voran und stellt auf der Discover 2025 vom 3. bis 4. Dezember in Barcelona eine erweiterte, KI-native Netzwerksparte vor. Im Fokus stehen dabei einheitliche AIOps-Funktionen über Aruba Central und Juniper Mist, neue Wi-Fi-7-fähige Access Points (AP) sowie Switch- und Router-Neuheiten für KI-Workloads. Fünf Monate nach Abschluss der Juniper-Übernahme markiert diese Ankündigung einen wichtigen Integrationsmeilenstein und soll die Rolle des Netzwerks als Basis für KI- und Cloud-Leistung betonen.

Self-driving Netzwerke und AIOps

HPE positioniert seine Netzwerktechnik als „self-driving“: Telemetriedaten aus Campus, Rechenzentrum und Cloud werden mit klassischem und generativem AIOps korreliert, um Störungen zu erkennen, zu beheben und zu verhindern. Begründet wird der Bedarf mit mehr Endgeräten, komplexeren Umgebungen und steigenden Sicherheitsrisiken – besonders dort, wo KI-Inference aus Latenz-, Datenschutz- und Kostengründen näher an den Edge rückt.

Vereinheitlichte AIOps über Aruba Central und Juniper Mist

HPE will Telemetriedaten aus Endgeräten, WLAN, LAN, Rechenzentrum und Cloud mit klassischem und generativem AIOps korrelieren. Das Ziel besteht darin, Störungen schneller zu erkennen, Ursachen einzugrenzen und Abhilfemaßnahmen zu automatisieren. Als Bausteine führt HPE an:

- Mist Large Experience Model (LEM): Ein auf Erfahrungswerten basierendes Modell, das Messpunkte unter anderem aus Videodiensten auswertet und laut HPE synthetische Daten aus digitalen Zwillingen einbezieht. LEM soll schrittweise auch in Aruba Central verfügbar werden.

- Agentenbasiertes Mesh: Die aus Aruba Central bekannten Agentenmechanismen sollen Juniper Mist erweitern, um eine bessere Anomalieerkennung, Ursachenanalyse und assistierte beziehungsweise autonome Aktionen zu ermöglichen.

- Gemeinsame Bedienoberflächenelemente: Mist soll Einblicke in die Organisation und globale Leitstandsichten aus Aruba Central übernehmen, um Betriebsabläufe zu vereinheitlichen.

Für regulierte Umgebungen kündigt HPE Aruba Networking Central On-Premises 3.0 an. Diese Version soll klassische und generative AIOps-Funktionen, umsetzbare Hinweise, proaktive Fehlerbehebung, Client-Einblicke, eine vereinfachte Dokumentensuche und eine überarbeitete Oberfläche bereitstellen.

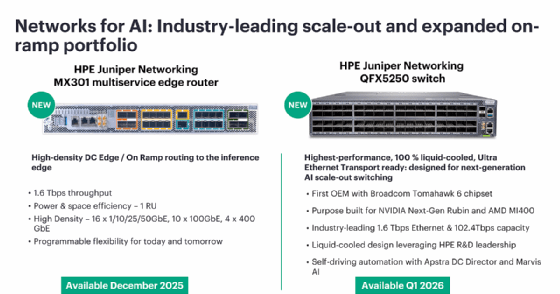

Rechenzentrums-Switch und Edge-Router für KI-Verkehr

Zur Abdeckung von bandbreitenintensivem Ost/West-Traffic in GPU-Fabrics und für leistungsfähige Anbindungen am Netzwerkrand nennt HPE zwei neue Produkte:

- QFX5250 (Rechenzentrums-Switch): Laut HPE bietet das System auf Broadcom-Tomahawk-6-Basis 102,4 TBit/s. Es soll Ultra-Ethernet-Transport unterstützen, Flüssigkühlung bereitstellen und mithilfe von AIOps-Funktionen die Inbetriebnahme und den Betrieb erleichtern. Verfügbar laut HPE im ersten Quartal 2026.

- MX301 (Multiservice-Edge-Router): Das 1-HE-Gerät soll bis zu 1,6 TBit/s und 400G-Ports liefern und Szenarien wie Inferenz am Netzwerkrand, Metro- und Mobile-Backhaul sowie Enterprise-Routing adressieren. Verfügbarkeit laut Hersteller ab Dezember 2025. Die Preise für die Software beginnen bei 3.000 US-Dollar für alle MX-Produkte (mit Optionen für unbefristete Lizenzen und Abonnements). Die MX301-Hardware soll circa 75.000 US-Dollar kosten.

Wi-Fi-7-Access-Points für die Verwaltung mit Central oder Mist

Die angekündigten Wi-Fi-7-APs sollen wahlweise in Aruba Central oder Juniper Mist betrieben werden können. HPE positioniert dies als Vorteil für gemischte Bestände und Migrationspfade. HPE nennt hierfür ein duales AP-Modell mit geplanter Verfügbarkeit im Q3 2026. Aus technischer Sicht verweist HPE auf Wi-Fi-7-typische Merkmale wie Mehrfachverbindung (Multi-Link Operation, MLO), 320-MHz-Kanäle und 4K-QAM. Für den Betrieb hebt der Hersteller besonders hervor:

- Einheitliche Inbetriebnahme und konsistente Richtlinien, abhängig von der gewählten Management-Domäne.

- Durchgängige Telemetrie für AIOps-Funktionen wie Client-Erfahrung, Service-Qualität und Ursachenanalyse.

Laut HPE sollen diese Punkte den Administrationsaufwand senken und die Fehlersuche beschleunigen.

OpsRamp, GreenLake und agentenbasierte Automatisierung

HPE will Management- und Observability-Daten über Compute, Storage, Netzwerk und Cloud verzahnen. OpsRamp soll die Telemetrie aus Compute Ops Management, Aruba Central und Juniper Apstra zusammenführen und als Basis eines hybriden Leitstands dienen. HPE verweist auf bidirektionale Integrationen mit Apstra DC Director sowie Erweiterungen in Compute Ops (unter anderem Compute Copilot) und MCP-Unterstützung sowohl in OpsRamp als auch in Alletra. Genannt werden unter anderem:

- Integration von Data Center Assurance & Director (HPE Juniper) für Full-Stack-Beobachtbarkeit, prädiktive Absicherung und proaktive Behebung.

- Compute-Ops-Erweiterungen mit OpsRamp-Anbindung, Compute Copilot und Self-Service-Ursachenanalyse.

- Agentenbasierte Ursachenfindung sowie das Model Context Protocol (MCP) stehen in begrenzter Verfügbarkeit bereit. MCP soll Drittanbieter-Agenten ohne Programmierung anbinden und bestehende Integrationen mit Kontext versorgen.

- Neue GreenLake-Intelligence-Agenten (zum Beispiel Sustainability Insight Center, Wellness Dashboard).

Partner-Updates mit NVIDIA und AMD

HPE will gemeinsam mit Partnern Lösungen für sogenannte AI Factorys (KI-Fabriken) ausbauen. Als Beispiele werden Edge-On-Ramp und Rechenzentrums-Verbund (Data Center Interconnect, DCI) genannt. HPE ordnet die Rollen explizit zu: MX für Edge-On-Ramp, PTX für langstreckige DCI mit kohärenter Optik. Es sollen über MX- und PTX-Router skalierbare, sichere und latenzarme Verbindungen vom Endgerät beziehungsweise Agenten bis zum KI-Cluster sowie zwischen Clustern und Clouds möglich sein.

Verfügbarkeit und Finanzierung

Laut HPE startet OpsRamp mit MCP-Unterstützung zunächst in Pilotumgebungen, eine breitere Verfügbarkeit ist für Anfang 2026 vorgesehen. HPE Financial Services stellt eine 0-Prozent-Finanzierung für AIOps-Software (einschließlich Juniper Mist) sowie ein Leasing-Programm mit einer Kostenersparnis von 10 Prozent für KI-Networking-Projekte in Aussicht. Optional soll ein Multi-OEM-Take-Out-Service mit Erlösbeteiligung verfügbar sein.

Einordnung im Wettbewerbsumfeld

AI-Networking und Fabrics

Positionierung: Mit seinen Fabric- und On-Ramp-Bausteinen adressiert HPE das gleiche Zielbild wie die anderen großen Netzwerkanbieter: große, latenzarme Fabrics für GPU-Cluster sowie kompakte Edge-Router für Inference-Zugriffe.

Im Vergleich: Cisco und Arista bewerben bereits breit eingeführte 800G-Topologien und betonen hohe Portdichten, Energieeffizienz und durchgängige Telemetrie. Nvidia positioniert Spectrum-X für KI-Fabrics mit enger Kopplung an das eigene Software-Ökosystem.

Einordnung: HPEs Botschaft zur Flüssigkühlung und zum Ultra-Ethernet-Transport soll zur Differenzierung dienen, während die Mitbewerber mit „heute lieferbaren“ 800G-Designs und ausgereifter Automatisierung punkten. Für Käufer zählt weniger das einzelne Datenblatt als die Ende-zu-Ende-Validierung im gewünschten Stack (Server, Fabric, Storage, KI-Frameworks) und die Betriebsautomatisierung über mehrere Domänen hinweg.

Wi-Fi-7-APs und Management

Positionierung: HPE kündigt an, dass die neuen Access Point für Wi-Fi 7 wahlweise über Aruba Central oder Juniper Mist verwaltet werden können.

Im Vergleich: Die Wettbewerber verfolgen ähnliche Vereinheitlichungen, meist über Cloud-Management und geteilte Policy-Modelle (zum Beispiel Campus/WLAN/SD-WAN in einer Oberfläche).

Einordnung: Der Mehrwert ergibt sich weniger aus den einzelnen WLAN-Merkmalen von Wi-Fi 7 (MLO, 320-MHz-Kanäle), die branchenweit vermarktet werden, sondern aus den Migrationspfaden und der Policy-Konsistenz zwischen den bestehenden HPE-Plattformwelten. Prüfkriterium ist die Funktionsparität beider Management-Welten im Alltag (Troubleshooting, Zero-Touch-Rollout, Mandantenfähigkeit).

AI Factory Stacks (schlüsselfertige Racks)

Positionierung: Wie die Bundles von Dell, Lenovo oder Pure Storage/Cisco zielen HPEs Private-Cloud-AI-Pakete auf vorkonfigurierte, validierte Racks mit Nvidia-Software und Integrationen. Verfügbarkeit im Februar 2026.

Im Vergleich: Dell und Lenovo vermarkten bereits seit längerem durchgängige Pakete von Servern über Networking bis Software, während Pure Storage und Cisco Storage-Skalierung und Fabric-Know-how kombinieren.

Einordnung: Entscheidend sind die Lieferfähigkeit, die Versionstreue entlang der Nvidia-Roadmap und das Lifecycle-Management (Upgrades, Patches, Telemetrie). Souveräne beziehungsweise abgeschottete Betriebsarten (Air-gapped) werden von mehreren Anbietern adressiert, wobei die auditierbare Umsetzung im konkreten Anwendungsfall zählt.

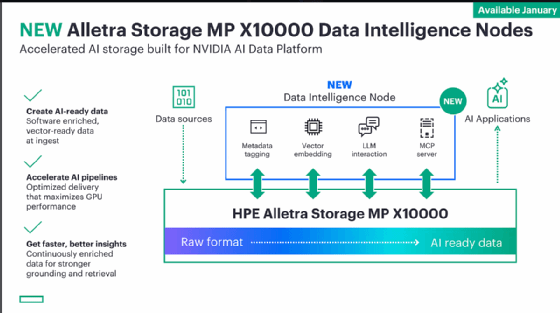

Datenpfad und Data Intelligence

Positionierung: HPE kündigt für Alletra Storage MP X10000 neue Data-Intelligence-Nodes an. Diese sollen laut HPE Metadaten-Tagging, Vektor-Einbettungen, LLM-Interaktion und einen MCP-Server bereitstellen, um Rohdaten beim Eintritt zu „KI-tauglichen“ Daten anzureichern. Die Verfügbarkeit ist laut HPE ab Januar 2026 gegeben.

Im Vergleich: NetApp und Pure Storage setzen stärker auf Datenservices, Governance und offene Anbindung. Die Einbettungen liegen oft applikations- oder datenbanknah (zum Beispiel Vektordatenbanken), nicht unmittelbar im Storage.

Einordnung: Wenn HPE die Einbettung und Anreicherung leistungsfähig „im Datenfluss“ liefern kann, wäre das eine andere Akzentuierung. Der Prüfaufwand für Anwender umfasst Latenz, Durchsatz, Skalierung der Indizes sowie Datenqualitäts- und Compliance-Prozesse (Versionierung, Löschkonzepte, Re-Indexierung).

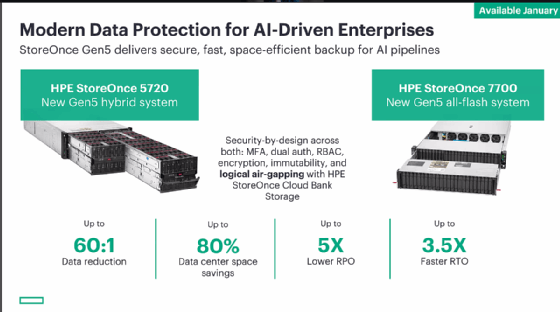

Datensicherung für KI-Pipelines

Positionierung: HPE stellt StoreOnce Gen5 als Modelle 5720 (Hybrid) und 7700 (All-Flash) vor. Genannt werden „Security-by-Design“ mit MFA, Dual-Auth, RBAC, Verschlüsselung, Unveränderbarkeit und logischem Air-Gap sowie Effizienzkennzahlen: bis 60:1 Deduplizierung, bis 80 Prozent Flächeneinsparung, bis fünfmal niedrigeres RPO und bis 3,5-fach schnelleres RTO. Verfügbarkeit ab Januar. Verfügbarkeit laut HPE ab Januar 2026.

Im Vergleich: Dell PowerProtect und andere Enterprise-Backupsysteme nennen ähnliche Schutzmechanismen und Effizienzmetriken (Immutable Snapshots, MFA, Rollenmodelle).

Einordnung: Die RPO/RTO -Ziele in KI-Pipelines hängen weniger von Slogans als von Netzpfaden, der Größe von Objekten beziehungsweise Dateien der Trainingsdaten, der Rehydrierung großer Datensätze und den Cloud-Exit-Kosten ab. Tests mit realen Datensätzen sind hier Pflicht.

Fazit

Für Betreiber hybrider Netze sind zwei Punkte zentral: Erstens reduziert eine einheitliche AIOps-Schicht den Tool-Wechsel zwischen Campus, Datacenter und Cloud – inklusive On-Premises-Option für regulierte Branchen. Zweitens adressieren QFX5250 und MX301 typische KI-Engpässe: Ost-/West-Traffic in GPU-Fabrics und performante Edge-Anbindung für Inference. Offene Fragen betreffen wie üblich Preise und Migrationspfade im Detail. HPE nennt hier vor allem Kompatibilität und Finanzierungsmodelle. Für Bestandskunden von Aruba und Juniper ist die Cross-Plattform-Nutzung (Wi-Fi-7-APs, AIOps-Features) ein wichtiger Indikator für Investitionsschutz.

Im direkten Vergleich adressieren alle großen Anbieter ähnliche Zielbilder. HPE betont die Integration über Networking- und Operations-Plattformen sowie die datennahe Anreicherung im Storage-Bereich. Die Konkurrenzangebote setzen dagegen teils früher lieferbare 800G-Fabrics, seit längerem vermarktete AI-Factory-Pakete und offene Datenservices ein.

Transparenzhinweis: Wir haben die Discover 2025 auf Einladung von HPE besucht und berichten unabhängig über wichtige Neuheiten.

Update am 4.12.2025 mit Preisen für MX-Router und -Software.