offnattawat - Fotolia

Wann Sie eine Leaf-Spine-Topologie im Data Center brauchen

In modernen Data Centern geht der Trend immer weiter zu Konvergenz und Virtualisierung. Deswegen ist eine Leaf-Spine-Netzwerktopologie interessant.

Dreischichtige Designs werden in modernen Data Centern immer unbeliebter, selbst wenn sie allgegenwärtig und vertraut sind. Sogenannte Leaf-Spine-Topologien übernehmen langsam aber sicher.

Unternehmen versuchen immer, ihre Data Center zu optimieren und die maximale Leistung herauszuholen. Deswegen befinden sich herkömmlichen Netzwerktopologien auf dem Prüfstand. Als Topologie bezeichnet man, auf welche Weise Netzwerkgeräte zusammengeschlossen sind und wie die Hosts miteinander kommunizieren.

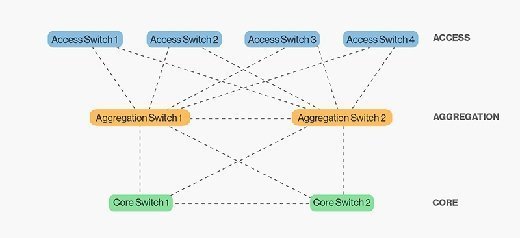

Üblicherweise bestand die Topologie des Netzwerks im Data Center aus drei Schichten:

- Über die Zugriffsschicht haben sich die Anwender mit dem Netzwerk verbunden.

- Auf der Aggregationsschicht kommunizieren Zugriffs-Switches miteinander.

- Im Kern sind Aggregations-Switches miteinander verbunden und es wird mit Netzwerken außerhalb des Data Centers kommuniziert.

Das Design dieses Modells stellt eine prognostizierbare Basis für das Netzwerk eines Data Centers zur Verfügung. Es skaliert physisch nach oben. Beim dreischichtigen Modell identifizieren Sie die Menge oder Dichte an notwendigen Ports und kaufen für jede Schicht die angemessene Anzahl an Switches. Die Anforderungen an die Verkabelung lassen sich ebenfalls voraussagen. Die Art, wie man die Schichten im gesamten Data Center verbindet, ändert sich nicht.

Wollen Sie ein Netzwerk mit drei Schichten aufstocken, dann müssen Sie einfach nur mehr Switches kaufen und mehr Kabel einziehen. Die Gesamtbetriebskosten dafür sind bekannt und lassen sich simpel berechnen.

Warum drei Schichten aus der Mode kommen

Trotz der Einfachheit gibt es viele Gründe, warum sich Netzwerk-Administratoren nach neuen Topologien für das Data Center umsehen.

Zu den wichtigsten gehört, dass sich die Traffic-Muster im Data Center ändern. Die Mehrheit des Netzwerkverkehrs läuft über die sogenannte North-South-Leitung. Hosts kommunizieren mit Hosts aus anderen Segmenten des Netzwerks. North-South Traffic fließt im Hinblick auf das Routing-Modell nach unten und dann wieder nach oben, um sein Ziel zu erreichen. Hosts im gleichen Netzwerksegment sind üblicherweise mit dem gleichen Switch verbunden. So wird der Traffic von den Verbindungsknoten fern gehalten.

In einem modernen Data Center sind Veränderungen bei den Computing- und Storage-Infrastrukturen verantwortlich, dass sich die Muster des Netzwerkverkehrs von North-South nach East-West verschieben. Bei East-West-Datenflüssen sind die Netzwerksegmente über mehrere Zugriffs-Switches verteilt und die Hosts müssen Verbindungsknoten passieren. Mindestens zwei große Trends haben zu diesem East-West-Phänomen beigetragen: Konvergenz und Virtualisierung.

Konvergenz: Storage Traffic fließt oftmals im gleichen physischen Netzwerk wie der Datenverkehr der Anwendungen. Storage Traffic spielt sich zwischen Hosts und Arrays ab, die sich im gleichen Netzwerksegment befinden. Logischerweise ist das direkt nebeneinander.

Virtualisierung: Die IT-Abteilungen migrieren immer mehr physische Hosts in virtuelle Maschinen (VM). Die Möglichkeit, Workloads einfach bewegen zu können, gehört heute zur Regel und ist eine Standardfunktion. Virtuelle Maschinen bewegen sich in einem Netzwerksegment von einem physischen Host zum nächsten.

Lässt man East-West Traffic in einer Topologie eines Data Centers laufen, die für North-South ausgelegt ist, führt das zu Überzeichnung bei den Verbindungsknoten zwischen den Schichten. Müssen Hosts, die mit einem Zugriffs-Switch verbunden sind, mit anderen Hosts sehr schnell kommunizieren, die an einem anderen Zugriffs-Switch hängen, dann kann es zwischen Zugriffs- und Aggregationsschicht zu Stau kommen. Das ist sogar sehr wahrscheinlich. Dreischichtige Netzwerkdesigns verschlimmern das Verbindungsproblem häufig. Spanning-Tree blockiert redundante Verbindungen, um Schleifen zu vermeiden. Zugriffs-Switches mit doppelten Uplinks können für das entsprechende Netzwerk immer nur eine der Verbindungen nutzen.

Stopfen Sie einfach mehr Bandbreite zwischen die Schichten, indem Sie schnellere Switches einbauen, hilft das bis bei der Bekämpfung von Staus bis zu einem gewissen Grad. Mit Traffic der Form Host-zu-Host East-West ist das Problem, dass es hier nicht nur eine gleichzeitige Konversation gibt. Die Hosts kommunizieren laufend mit anderen Hosts im gesamten Data Center. Mehr Bandbreite unterstützt die Hosts beim Smalltalk, allerdings ist das nur ein Teil der Lösung.

Eine neue Topologie macht sich breit

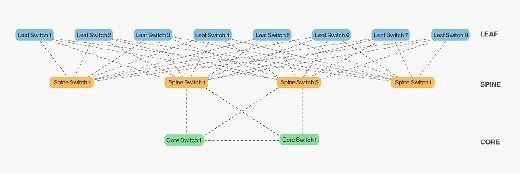

Die vollständige Lösung ist es, Switches in der Schicht unter der Zugriffsschicht zu implementieren und dann damit die Zugriffsschichten miteinander zu verbinden. Diese Topologie nennt man Leaf-Spine. Ein Leaf-Spine-Design skaliert horizontal durch das Hinzufügen von Spine Switches. Bei Spanning-Tree-Konfigurationen mit einem herkömmlichen dreischichtigen Design ist das nicht möglich.

Das ähnelt dem traditionellen Design mit drei Schichten, allerdings gibt es mehr Switches in der Spine-Schicht. In einer Leaf-Spine-Topologie werden alle Verbindungen genutzt, um Traffic weiterzuleiten. Dafür setzt man häufig auf moderne Ersatz-Protokolle für Spanning-Tree wie zum Beispiel Transparent Interconnection of Lots of Links (TRILL) oder Shortest Path Bridging (SPB). TRILL und SPB ermöglichen das Forwarding über alle verfügbaren Verbindungen und halten trotzdem eine Netzwerktopologie frei von Schleifen aufrecht. Das ist ähnlich wie bei gerouteten Netzwerken.

Die Vorteile von Leaf-Spine

Leaf-Spine-Topologien sind mittlerweile der De-Facto-Standard. Sie finden außer Leaf-Spine kaum noch andere Designs im Portfolio der Netzwerkanbieter. Dafür gibt es auch gute Gründe. Leaf-Spine bringt einige wünschenswerte Charakteristiken mit sich, die sich vorteilhaft für Netzwerkdesigner auswirken, wenn sie East-West-Traffic optimieren wollen.

Alle East-West-Hosts sind äquidistant. Leaf-Spine erweitert die Schichten Zugriff und Aggregation. Ein Host kann mit einem anderen über jeden beliebigen Leaf Switch kommunizieren und man weiß, dass der Traffic nur über den Eingangs-Leaf-Switch, den Spine Switch und den Ausgangs-Leaf-Switch läuft. Aus diesem Grund lässt sich das Verhalten von Anwendungen vorhersagen, die über eine solche Netzwerkinfrastruktur operieren. Haben Unternehmen mehrere Multi-Tiered-Webanwendungen am Laufen, ist das ein sehr wichtiger Punkt. Das gilt auch für High-Performance Computing Cluster und Hochfrequenzhandel.

Leaf-Spine nutzt alle Verbindungen. Das herkömmliche Design mit drei Schichten nutzt das Protokoll Spanning-Tree, welches Schleifen vermeidet. Wie bereits erwähnt entdeckt Spanning-Tree Schleifen und blockiert dann Verbindungen, die solche Schleifen bilden würden. Das bedeutet auch, dass Zugriffs-Switches mit zwei Verbindungen lediglich einen der Uplinks nutzen. Moderne Alternativen wie zum Beispiel SPB und TRILL erlauben die Verwendung aller Verbindungen zwischen Leaf und Spine, um den Traffic weiterzuleiten. Wächst der Netzwerkverkehr, kann das Netzwerk entsprechend skalieren.

Die Topologie unterstützt Switches mit feststehender Konfiguration. Diese Fixed Configuration Switches werden mit einer bestimmten Anzahl an Ports ausgeliefert. Switches in einem Gehäuse (Chassis Switches) sind modular und lassen sich mit entsprechenden Karten aufrüsten, um die notwendige Port-Dichte zu erreichen. Chassis Switches sind verglichen mit Fixed Configurations Switches teuer. Allerdings muss man sie in den herkömmlichen Topologien mit drei Schichten einsetzen. Hier verbindet sich eine große Anzahl an Switches von einer Schicht mit zwei Switches einer anderen. Leaf-Spine ermöglicht es, dass man die Verbindungen über eine große Anzahl an Spine Switches breit fächert. Somit brauchen Sie keine riesigen Chassis Switches in einigen Leaf-Spine-Designs. Natürlich können Sie Chassis Switches in der Spine-Schicht benutzen. Viele Unternehmen sparen sich aber ordentlich Geld, indem sie Switches mit einer festen Anzahl an Ports installieren.

Leaf-Spine ist derzeit das favorisierte Design für Data Center. Dabei ist die Größe egal. Es ist berechenbar, skalierbar und löst das Traffic-Problem East-West. Will ein Unternehmen künftig auf Konvergenz und Virtualisierung im großen Stil setzen, dann sollte es sich mit der Netzwerktopologie Leaf-Spine für das Data Center befassen.

Die Kosten von Leaf-Spine

Leaf-Spine bringt nicht nur Vorteile mit sich. Ein Nachteil ist die hohe Anzahl an notwendigen Switches, um die gewünschte Skalierbarkeit zu erreichen. Leaf-Spine-Topologien im Data Center müssen bis zu einem gewissen Grad skalieren, damit sie die physischen Hosts unterstützen können, die sich damit verbinden. Je mehr Leaf Switches Sie benötigen, um alle physischen Hosts zu verbinden, desto breiter muss das unterstützende Spine sein.

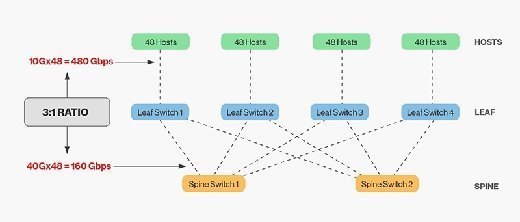

Ein Spine lässt sich nur bis zu einem gewissen Punkt erweitern. Entweder gehen den Spine Switches die Ports aus und können damit keine weiteren Leaf Switches anbinden, oder die Überzeichnung zwischen den Schichten Leaf und Spine ist nicht mehr tolerierbar. Der allgemeine Konsens ist, dass eine Überzeichnungsrate von 3:1 zwischen den Schichten Leaf und Spine akzeptabel ist. Sind zum Beispiel 48 Hosts zur Leaf-Schicht mit 10 Gbps angebunden, nutzen sie maximal 480 Gbps. Ist die Leaf-Schicht mit vier Uplinks mit je 40 Gbps verbunden, dann ist die Bandbreite logischerweise 160 Gbps. Das entspricht einer Überzeichnung von 3:1.

Bei Leaf-Spine-Netzwerken sind auch jede Menge Kabel nötig. Die Anzahl der Kabel zwischen den Schichten Leaf und Spine steigt mit jeder Aufnahme eines Spine Switches. Je breiter das Spine, desto mehr Verbindungen sind notwendig. Die Herausforderung für Administratoren liegt darin, die Verkabelung so zu planen, dass ausreichend Fibre-Optic-Stränge für die Verbindungen vorhanden sind. Wollen Sie Switches verbinden, die sehr weit auseinander liegen, dann brauchen Sie teure optische Module. Das treibt die Kosten für eine Leaf-Spine-Installation in die Höhe. Für kurze Distanzen gibt es günstige Module, die auf Kupfer basieren. In modernen Data Centern kommen Sie aber nicht um optische Module herum und diese sind richtig teuer.

Folgen Sie SearchNetworking.de auch auf Twitter, Google+ und Facebook!