Ade - stock.adobe.com

Der Security-Faktor 2026: Kontrolle über sensible Daten

Wenn Unternehmen generative KI und KI-Agenten nutzen, gilt es sich bei Prozessen und Berechtigungen detailliert mit dem Schutz der Daten zu beschäftigen, um Risiken zu vermeiden.

KI kann vieles, aber kann sie auch schweigen? Der ein oder andere mag mit den Augen rollen, wenn er den Begriff Datenschutz hört, doch für Unternehmen ist das Thema brisanter denn je. Wer KI produktiv einsetzen will – und dies wird künftig unvermeidlich sein –, muss akzeptieren, dass die neuen Tools zwangsläufig Zugriff auf unternehmensinterne Daten und vertrauliche Informationen erhalten. Die künstliche Intelligenz wird zum Insider und deshalb wird es 2026 zu einer der großen Frage der Cybersicherheit: Wie setzen Unternehmen ihre neuen Tools sicher ein, ohne sich dabei auszubremsen?

Die Gefahr liegt auf der Hand: Je mehr KI-Agenten mit Unternehmensinhalten arbeiten, aus ihnen lernen und je mehr sie generell in Prozessen vernetzt sind, umso attraktiver werden sie für Angreifer. Die Wahrscheinlichkeit ist hoch, dass wir in naher Zukunft von immer mehr Fällen hören, in denen KI vertrauliche Informationen preisgibt oder ungewollte, möglicherweise bösartige, Aktionen ausführt. Unternehmen müssen sich also konsequent schützen.

Laut Gartner werden bis Ende 2026 bereits 40 Prozent aller Unternehmensanwendungen eine Art von aufgabenspezifischen KI-Agenten integrieren. Immer mehr Abläufe sollen durch Automatisierung effizienter werden. Schon heute nutzt ein Großteil aller Unternehmen künstliche Intelligenz. In vielen Fällen sind es Routine- oder Rechercheaufgaben, die mit großen Datenmengen verbunden sind. An dieser Stelle stechen vor allem drei Sicherheitsrisiken hervor, die für Unternehmen im nächsten Jahr eine gewichtige Rolle spielen werden.

Externe Angriffe: Social Engineering trifft KI Engineering

Zu den häufigsten Taktiken von Angreifern zählen Prompt Injection und Data Poisoning. Sie liefern den KI-Agenten absichtlich irreführende Eingaben, mit dem Ziel, sie zu manipulieren. Ergebnis kann sein, dass die Agenten gegen die Intention ihrer eigentlichen Herren unbefugte Aktionen durchführen oder vertrauliche Informationen preisgeben. Je nachdem wie eng die Tools eingebunden sind, kann das Ausmaß neben dem Abfluss von Daten auch zu falschen Überweisungen oder massiven Störungen betrieblicher Abläufe reichen.

Der wirksamste Basisschutz sind konsequent gesteuerte Zugriffsrechte auf Daten. Bei der Einführung neuer KI-Tools müssen IT-Teams exakt definieren, auf welche Bereiche diese zugreifen dürfen – und auf welche nicht. Faustregel: so viel Zugriff wie nötig, so wenig wie möglich. Kein KI-Agent benötigt uneingeschränkten Zugang zu allen Kundendaten.

Da auch diese Maßnahmen mit manuellem Aufwand verbunden sind, ist das langfristige Ziel ein System, in dem sich Inhalte abhängig vom Risikofaktor selbst klassifizieren und schützen. Möglich kann so etwas durch proaktive Funktionen auf der verwendeten Datenplattform werden. So können sensible Inhalte automatisch erkannt und auf Basis definierter Richtlinien der passenden Sicherheitsstufe zugeordnet werden. Manuelle Schritte entfallen damit nicht vollständig, werden jedoch auf eine weniger kleinteilige, überwachende Ebene verlagert und genau dies ist entscheidend. Denn bei allen automatisierten Funktionen gilt der Grundsatz Human in the Loop: Ein Mensch muss jederzeit die Kontrolle behalten und finale Entscheidungen treffen können.

„KI braucht Inhalte, um damit zu arbeiten, doch es muss klar sein, welche. Die Plattform, mit der Unternehmen ihre Daten verwalten, sollte daher sicherstellen, dass KI-Agenten ausschließlich auf die Inhalte zugreifen, für die sie autorisiert sind.“

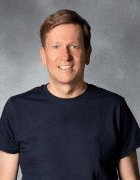

Michael Pietsch, Box

Unerwünschte Ergebnisse sind auch ohne Angriff ein Risiko

Der Human-in-the-Loop-Ansatz ist auch beim zweiten großen Risikofaktor unverzichtbar. Wenn KI sich unerwartet oder unerwünscht verhält, kann zwar ein Angriff dahinterstecken, muss es aber nicht. Wie bei jeder Software sind auch hier technische Fehlfunktionen möglich. Ein einfaches Beispiel, wenn ein Agent versehentlich Daten löscht. Umso wichtiger ist es, sich nicht blind auf Automatisierung zu verlassen. Der Mensch muss als finale Instanz im Prozess eingebunden bleiben, um Fehlverhalten zu erkennen, gegenzusteuern und die letzte Entscheidungshoheit zu behalten.

In eine ähnliche Kategorie fällt der wahrscheinlich größte Risikofaktor beim Umgang mit sensiblen Informationen: Salopp formuliert ist das der Fall, dass KI etwas ausplappert, das sie nicht preisgeben sollte. Jedem Unternehmen droht hier ein Datenschutzalptraum und solchen, die als KRITIS eingestuft sind, sogar einer von gewaltigem Ausmaß. Wenn KI-Agenten über Informationen verfügen und sie nicht wissen, dass sie diese bei einer Anfrage nicht nutzen sollten, dann tun sie das auch nicht. Hier liegt gleichzeitig der Schlüssel: Wie schon beim Schutz gegen externe Angriffe sind es klar definierte Zugriffsrechte nach dem Prinzip der geringsten Privilegien. KI braucht Inhalte, um damit zu arbeiten, doch es muss klar sein, welche. Die Plattform, mit der Unternehmen ihre Daten verwalten, sollte daher sicherstellen, dass KI-Agenten ausschließlich auf die Inhalte zugreifen, für die sie autorisiert sind. Die Datenplattform braucht also eine sichere RAG-Architektur (Retrieval-augmented Generation) mit streng gesetzten und regelmäßig überprüften Berechtigungskontrollen.

2026 trifft Content auf KI – und zwar sicher

Was die drei hier angesprochenen Punkte gemeinsam haben: Sie sollten bei allen Unternehmen, die KI nutzen wollen, im Jahr 2026 ganz oben auf der Cybersecurity-Agenda stehen. Für Organisationen aus dem KRITIS-Sektor, die sich intensiver, denn je mit der NIS2-Umsetzung beschäftigen müssen, ist die Dringlichkeit besonders hoch. Und auch wenn der Einsatz von KI an vielen Stellen wie ein Schritt ins Ungewisse wirkt, gibt es eine beruhigende Erkenntnis: Der Schutz von Unternehmensinhalten bleibt auch im KI-Zeitalter kein Hexenwerk. Entscheidend sind vor allem drei Faktoren: ein klares Bewusstsein für die Risiken, der Mensch als kontrollierende Instanz im Prozess und eine Plattform, die Sicherheit konsequent mitdenkt. 2026 wird das Jahr, in dem Content Management und KI endgültig zusammenwachsen.

Über den Autor:

Michael Pietsch ist Vice President DACH & Eastern Europe bei Box. Er beschäftigt sich intensiv mit der digitalen Transformation, der Zukunft der Arbeit und den Auswirkungen von KI auf Unternehmen. Er ist seit über 20 Jahren in Führungspositionen bei Oracle, Rubrik, Boomi, EMC und Palo Alto Networks tätig.

Die Autoren sind für den Inhalt und die Richtigkeit ihrer Beiträge selbst verantwortlich. Die dargelegten Meinungen geben die Ansichten der Autoren wieder.