Inline-Deduplizierung

Inline-Deduplizierung ist die Entfernung von Datenredundanzen, bevor oder während sie auf ein Speichersystem geschrieben werden. Die Inline-Deduplizierung reduziert im Vergleich zur Post-Process-Deduplizierung die Menge der redundanten Daten in einer Anwendung und die für die Backup-Ziele benötigte Kapazität, bevor diese belegt wird. Allerdings kann die Inline-Deduplizierung den gesamten Datensicherungsprozess verlangsamen, da sich die Geräte zur Inline-Datendeduplizierung im Datenpfad zwischen den Servern und den Backup-Systemen befinden.

Die Datendeduplizierung wurde ursprünglich für Backup-Daten entwickelt, um den Speicher-Overhead zu reduzieren. Mit dem Aufkommen von Flash-Speichern in Unternehmen wurde sie auch in den Primärspeicher integriert, um den Kostenvorteil von Solid-State-Laufwerken (SSDs) gegenüber Festplattenlaufwerken (HDDs) zu optimieren.

Die Inline-Deduplizierung ist beliebter als die Post-Process-Deduplizierung für Primärspeicher auf Flash-Arrays. Die Inline-Deduplizierung reduziert die Datenmenge, die auf die Laufwerke geschrieben wird, was wiederum den Verschleiß der Laufwerke verringert. Inline-Deduplizierung galt als ein Verkaufsargument für die ersten erfolgreichen All-Flash-Arrays, wie von XtremIO von Dell EMC und Pure Storage.

Funktionsweise der Deduplizierung

Es gibt zwei primäre Deduplizierungsmethoden. Bei der einen Methode werden die Daten in kleine Chunks unterteilt und jedem Chunk eine eindeutige Hash-Kennung zugewiesen. Beim Schreiben der Daten überprüfen die Algorithmen die Hash-Kennung, um festzustellen, ob sie bereits im Speicher vorhanden ist. Ist dies der Fall, wird die neue Kopie nicht gespeichert.

Die zweite Methode, die von Anbietern von Deduplizierungstechnologien verwendet wird, ist die Delta-Differencing-Technologie, bei der neue Daten mit bereits gespeicherten Daten auf Byte-Ebene verglichen werden.

Die Deduplizierung ist in den meisten Fällen eine Funktion, die in Datensicherungsprodukte integriert ist, wie die von Cohesity, Commvault, Dell EMC, IBM, Veritas und Rubrik. Die Technologie wird in der Regel mit anderen Tools zur Effizienzsteigerung bei der Datensicherung (zum Beispiel Datenkomprimierung) und Datenwiederherstellung (zum Beispiel Replikation) kombiniert.

Die Datenkomprimierung dient zur Verringerung der Größe des zu speichernden Datensatzes und wird häufig in Verbindung mit der Deduplizierung eingesetzt. Bei der Komprimierung wird ein Algorithmus verwendet, um festzustellen, ob die Bitfolge, die ein bestimmtes Datenelement definiert, durch eine kleinere Zeichenfolge ausgedrückt werden kann. Die Effizienz der Komprimierung wird als Verhältnis zwischen der zu speichernden Datengröße und der komprimierten Größe definiert, beispielsweise 2:1 oder 5:1. Bei einem Kompressionsverhältnis von 2:1 würde ein Datensatz von 100 Gigabyte beispielsweise nur 50 Gigabyte Speicherplatz beanspruchen.

Während Kompressionsalgorithmen zunächst für Bandspeicher entwickelt wurden, diente die Datendeduplizierung zur Verbesserung der festplattenbasierten Datensicherung.

So funktioniert die Inline-Deduplizierung

Unabhängig davon, ob die Inline-Deduplizierung die Hash-Identifizierungsmethode oder die Vergleichsmethode auf Byte-Ebene verwendet, prüft sie neue Daten, die an den Speicher gesendet werden sollen, mit Daten, die bereits im Speicher vorhanden sind, und speichert keine der entdeckten redundanten Daten. Die Inline-Deduplizierungssoftware führt Algorithmen aus, die automatisch die identifizierenden Hashes anhängen und die Hashes in den gespeicherten Daten auf eine Übereinstimmung überprüfen. Wenn es keine Übereinstimmung gibt, werden die Daten gespeichert.

Da der Prozess während der Übertragung der Daten auf den Backup-Speicher stattfindet, könnte er im Vergleich zur Post-Process-Deduplizierung ein Leistungsproblem verursachen. In den Anfängen der Deduplizierung war dies ein Problem, aber moderne Prozessoren und Speicher können die erhöhte Arbeitslast der Inline-Deduplizierung problemlos bewältigen, so dass es keine Leistungseinbußen für das Backup-System gibt.

Vor- und Nachteile der Inline-Deduplizierung

Die Inline-Deduplizierung kann entweder quell- oder zielbasiert sein. Die quellbasierte Deduplizierung findet auf dem Host statt, bevor die Datenübertragung zum Speicherziel beginnt. Die zielbasierte Deduplizierung findet auf dem Laufwerk statt, auf dem die Daten gespeichert sind.

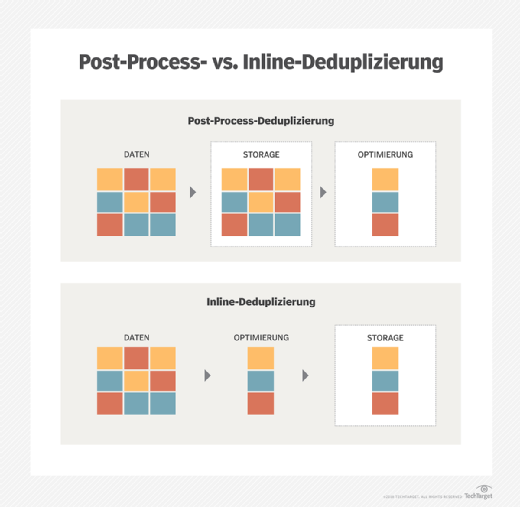

Die Inline-Deduplizierung benötigt weniger Speicherplatz als die Post-Process-Deduplizierung. Bei der Post-Process-Deduplizierung werden die Daten in den Speicher geschrieben, bevor die Deduplizierung stattfindet. Dies erfordert genügend Speicherplatz, um den gesamten Datensatz, einschließlich der Redundanzen, zu verarbeiten. Bei der Inline-Deduplizierung muss der Speicherplatz nicht für redundante Daten verwendet werden, die temporären Speicherplatz benötigen.

Da die Inline-Deduplizierung vor oder während der Datenübertragung erfolgt, kann sie zu einem Datenengpass führen und den Übertragungsprozess verlangsamen. Die Post-Process-Deduplizierung ermöglicht ein schnelleres Backup, da die Daten erst nach der Speicherung für die Deduplizierung verarbeitet werden.

Inline-Deduplizierung im Primärspeicher

Die zunehmende Verwendung von Flash-basiertem Primärspeicher hat zu einem Anstieg der Verwendung von Inline-Deduplizierung im Primärspeicher geführt. Zu den Vorteilen gehören:

- geringere Kapazitätsanforderungen an den Primärspeicher

- weniger Redundanzen, bevor die Daten zur Sicherung gesendet werden

- Kosteneinsparungen, da Solid-State-Speicher immer noch teurer sind als Festplatten

- geringere Abnutzung des Flash-Speichers in SSDs, was die Lebensdauer der Laufwerke verlängern kann

Data Domain und Inline-Deduplizierung

Data Domain war ein Pionier der Inline-Datendeduplizierung. Das Unternehmen verkaufte Hardware-Appliances, die seine Deduplizierungssoftware nutzten, um eine Alternative zu Bandsicherungen zu bieten. Der Speichergigant EMC übernahm Data Domain nach einem Bieterkrieg zwischen NetApp und EMC für 2,1 Milliarden US-Dollar. EMC integrierte die Produkte von Data Domain in sein bestehendes Angebot an Deduplizierungslösungen. Als Dell EMC im Jahr 2016 übernahm, verkaufte und aktualisierte das neu benannte Dell EMC die Data-Domain-Produktlinie weiter.

EMC kaufte auch einen anderen Deduplizierungspionier, Avamar, der Deduplizierungssoftware verkaufte. Heute ist Dell EMC Avamar Teil der Data Protection Suite des Herstellers. Avamar ist eine quellenbasierte Deduplizierungssoftware, während Data Domain zielbasiert ist.