Gigabit (Gbit, Gb)

Was ist ein Gigabit (Gb)?

In der Datenkommunikation ist ein Gigabit (Gb) 1 Milliarde Bits oder 1.000.000.000 (das heißt 109) Bits. Es wird üblicherweise zur Messung der Datenmenge verwendet, die in einer Sekunde zwischen zwei Telekommunikationspunkten übertragen wird. Gigabit-Ethernet (GbE) ist beispielsweise eine Hochgeschwindigkeitsform von Ethernet, einer Technologie für lokale Netzwerke, die Datenübertragungsraten von bis zu 400 Gigabit pro Sekunde (Gb/s) liefern kann.

Einige Quellen definieren ein Gigabit als 1.073.741.824 Bit (etwa 230). Obwohl das Bit eine Einheit des binärenZahlensystems ist, handelt es sich bei Bits in der Datenkommunikation um diskrete Signalimpulse, die traditionell im Dezimalsystem gezählt wurden.

Allerdings gibt es eine Menge Verwirrung über Bit-Präfix-Multiplikatoren und die Unterschiede zwischen dem dezimalen und dem binären Zahlensystem im Allgemeinen, so dass viele unsicher sind, ob ein Gigabit 1 Milliarde Bits oder eher 1,074 Milliarden Bits entspricht.

Gigabit in binären und dezimalen Zahlensystemen

Die kleinste Dateneinheit in der Datenverarbeitung ist das Bit, das entweder den Wert 1 oder 0 hat. Darauf basiert auch das binäre Zahlensystem. Das Problem entsteht, wenn Multiplikatoren verwendet werden, um die Bits zu quantifizieren, und verschiedene Zahlensysteme auf diese Werte angewendet werden.

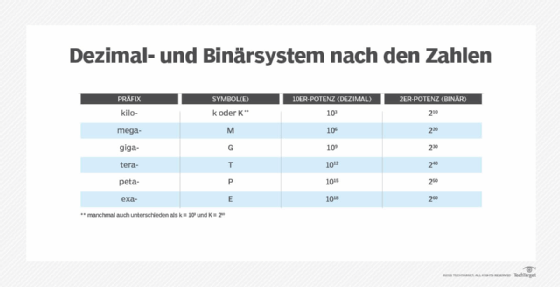

Das Dezimalsystem verwendet Basis-10-Berechnungen, wenn den Bits Multiplikatoren zugewiesen werden. Basis-10-Berechnungen sind recht einfach, da sie demselben System folgen, das wir im Alltag verwenden. Zum Beispiel ist 102gleich 100, 103 gleich 1.000, 104 gleich 10.000 und nach oben entsprechend weiterführend. Wenn wir unsere Stromrechnungen bezahlen, verwenden wir ein Basis-10-Zahlensystem. Ein solches System lässt sich leicht auf die Vorwahlmultiplikatoren übertragen, die häufig für die Datenkommunikation verwendet werden:

- 1 Kilobit (Kb) = 103 Bits

- 1 Megabit (Mb) = 106 Bits

- 1 Gigabit (Gb) = 109 Bits

- 1 Terabit (Tb) = 1012 Bits

- 1 Petabit (Pb) = 1015 Bits

- 1 Exabit (Eb) = 1018 Bits

In diesem System entspricht 1 Gb 109 Bits, was 1 Milliarde Bits dastellt. Einige Quellen verwenden jedoch das Binärsystem anstelle des Dezimalsystems, wenn sie sich auf Datenraten oder -größen beziehen, verwenden aber weiterhin denselben Präfixnamen zur Beschreibung dieser Werte. Im Gegensatz zum Dezimalsystem werden im Binärsystem bei der Zuweisung von Werten Berechnungen zur Basis 2 verwendet, weshalb Gigabit manchmal eher als 1,074 Milliarden Bit oder 230 Bit definiert wird.

Aufgrund dieser Missverständnisse hat sich die Industrie immer mehr auf eine Reihe von Präfix-Multiplikatoren für den Basis-2-Standard verlegt. Die folgenden Multiplikatoren sind zum Beispiel die binären Gegenstücke zu den oben aufgeführten Dezimalmultiplikatoren:

- 1 Kibibit (Kib) = 210 Bits

- 1 Mebibit (Mib) = 220 Bits

- 1 Gibibit (Gib) = 230 Bits

- 1 Tebibit (Tib) = 240 Bits

- 1 Pebibit (Pib) = 250 Bits

- 1 Exbibit (Eib) = 260 Bits

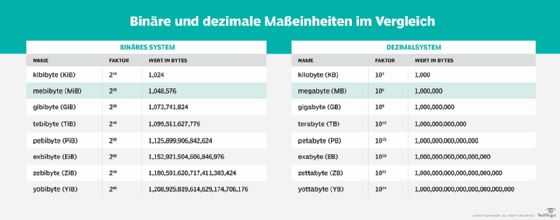

Der Basis-2-Standard wird auch für bytebezogene Multiplikatoren übernommen. So entspricht beispielsweise 1 Gigabyte (GB) 1 Milliarde Byte (109) und 1 Gibibyte (GiB) 1.073.741.824 Byte (wiederum etwa 230).

Trotz der Entwicklung hin zu Multiplikatoren zur Basis 2, wie zum Beispiel Gibibit, verwenden viele Anbieter und andere Quellen weiterhin Namen von Multiplikatoren zur Basis 10 mit Berechnungen zur Basis 2. Aus diesem Grund sollten Personen, die Netzwerk- und Kommunikationssysteme bewerten, sicher sein, dass sie verstehen, wie die Terminologie verwendet wird, damit sie Systeme richtig bewerten und vergleichen können.

Gigabit vs. Gigabyte

Gigabit wird oft mit Gigabyte verwechselt, das im Allgemeinen zur Beschreibung der Datenspeicherung verwendet wird - der Datenmenge, die in einem Gerät gespeichert wird, oder der Kapazität des Geräts, das die Daten speichert. Byte-bezogene Präfixe werden häufig verwendet, weil das Byte in vielen Computerarchitekturen die kleinste adressierbare Speichereinheit ist. Ein Byte enthält 8 Bits, aber diese Bits werden als einzelne Einheit verarbeitet oder mit anderen Bytes kombiniert, um größere Einheiten zu bilden.

Obwohl Byte-bezogene Multiplikatoren im Allgemeinen für ruhende Daten verwendet werden, beziehen sie sich manchmal auf Datenübertragungen oder auf Speicherbandbreite oder -durchsatz. Auch dies kann bei der Bewertung oder dem Vergleich von Systemen oder Diensten zu Verwirrung führen, so dass diejenigen, die diese Systeme bewerten, sicher sein müssen, dass sie auch die in diesem Bereich verwendeten Messgrößen verstehen.