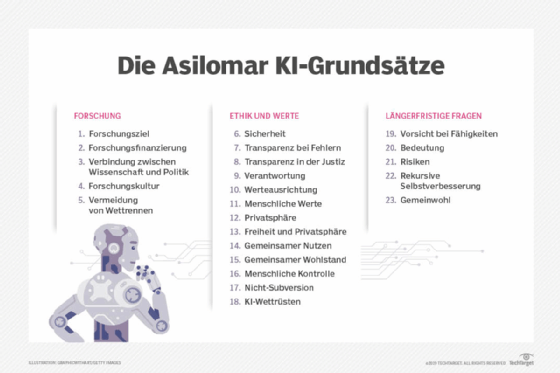

Asilomar KI-Prinzipien

Was sind die Asilomar KI-Prinzipien?

Die Asilomar KI-Prinzipien (oder KI-Grundsätze) sind 23 Richtlinien für die Erforschung und Entwicklung künstlicher Intelligenz (KI). Die Asilomar-Prinzipien beschreiben Entwicklungsfragen, Ethik und Richtlinien für die Entwicklung von KI mit dem Ziel, die Entwicklung nützlicher KI zu lenken. Die Grundsätze wurden auf der Asilomar Conference on Beneficial AI im Jahr 2017 in Pacific Grove, Kalifornien, erstellt. Die Konferenz wurde vom Future of Life Institute organisiert.

Die 23 Grundsätze wurden von einer Gruppe von KI-Forschern, Robotikexperten, Technologieexperten und Rechtswissenschaftlern verschiedener Universitäten und Organisationen entwickelt. Diese Experten organisierten die KI-Grundsätze auf der Asilomar-Konferenz, während sie über die Zukunft der KI und ihre Regulierung diskutierten.

Das Future of Life Institute ist eine gemeinnützige Organisation, die 2014 vom MIT-Kosmologen Max Tegmark, dem Skype-Mitbegründer Jaan Tallinn, dem Physiker Anthony Aguirre, der DeepMind-Forscherin Viktoriya Krakovna und der Postdoktorandin der Tufts University Meia Chita-Tegmark gegründet wurde. Tausende KI- und Robotikforscher haben die Prinzipien unterzeichnet, ebenso wie andere Befürworter aus einer Vielzahl führender KI-Forschungsunternehmen, darunter Google, Apple und OpenAI. Im Jahr 2018 hat der Bundesstaat Kalifornien diese Prinzipien übernommen.

Die Asilomar KI-Prinzipien sind in drei Kategorien unterteilt: Forschung, Ethik und Werte sowie längerfristige Probleme. Oftmals sind die Prinzipien eine klare Aussage über mögliche unerwünschte Folgen, gefolgt von Empfehlungen zur Verhinderung eines solchen Ereignisses.

Forschung

Dieser Unterabschnitt mit fünf Grundsätzen befasst sich mit der Erforschung und Entwicklung von KI sowie mit ihrer Transparenz und ihrem vorteilhaften Einsatz:

- Forschung. Das Ziel der KI-Forschung sollte es sein, nicht unkontrollierte, sondern nützliche Intelligenz zu schaffen. Das bedeutet, dass KI-Forschung immer nutzbringend sein sollte.

- Forschungsfinanzierung. Investitionen in KI sollten mit Mitteln für die Forschung zur Sicherstellung ihres nützlichen Einsatzes einhergehen.

- Wissenschaft und Politik. Es sollte einen konstruktiven und gesunden Austausch zwischen KI-Forschern und politischen Entscheidungsträgern geben.

- Forschungskultur. Unter KI-Forschern und -Entwicklern sollte eine Kultur der Zusammenarbeit, des Vertrauens und der Transparenz gefördert werden.

- Vermeidung eines Wettrennens. Teams, die KI-Systeme entwickeln, sollten aktiv zusammenarbeiten, um bei Sicherheitsstandards keine Abstriche zu machen.

Ethik und Werte

Dieser Unterabschnitt der KI-Grundsätze befasst sich mit der Ethik der KI und den Werten, die bei ihrer Entwicklung vermittelt werden:

- Sicherheit. KI-Systeme sollten während ihrer gesamten Betriebsdauer sicher sein, und zwar nachprüfbar, soweit dies anwendbar und machbar ist.

- Transparenz bei Fehlern. Wenn ein KI-System Schaden verursacht, sollte es möglich sein, den Grund dafür zu ermitteln.

- Transparenz in der Rechtsprechung. Jede Beteiligung eines autonomen Systems an der gerichtlichen Entscheidungsfindung sollte eine zufriedenstellende Erklärung liefern, die von einer zuständigen menschlichen Behörde überprüft werden kann.

- Verantwortung. Die Entwickler und Architekten fortschrittlicher KI-Systeme sind an den moralischen Implikationen ihrer Nutzung, ihres Missbrauchs und ihrer Handlungen beteiligt und haben die Verantwortung und die Möglichkeit, diese Implikationen zu gestalten.

- Werteausrichtung. Hochautonome KI-Systeme sollten so konzipiert werden, dass sichergestellt werden kann, dass ihre Ziele und Verhaltensweisen während ihres gesamten Betriebs mit menschlichen Werten übereinstimmen.

- Menschliche Werte. KI-Systeme sollten so konzipiert und betrieben werden, dass sie mit den Idealen der Menschenwürde, der Menschenrechte, der Freiheiten und der kulturellen Vielfalt vereinbar sind.

- Privatsphäre. Menschen sollten das Recht haben, auf die von ihnen erzeugten Daten zuzugreifen, sie zu verwalten und zu kontrollieren, da KI-Systeme in der Lage sind, diese Daten zu analysieren und zu nutzen.

- Freiheit und Privatsphäre. Die Anwendung von KI auf personenbezogene Daten darf die tatsächliche oder wahrgenommene Freiheit der Menschen nicht unangemessen einschränken.

- Gemeinsamer Nutzen. KI-Technologien sollten so vielen Menschen wie möglich zugutekommen und deren Fähigkeiten erweitern. Dazu gehört beispielsweise der Einsatz von KI zur Erleichterung der Arbeit, zur Optimierung des Energieverbrauchs oder als wissensbasierte Expertensysteme.

- Gemeinsamer Wohlstand. Der durch KI geschaffene wirtschaftliche Wohlstand sollte breit gestreut werden, damit die gesamte Menschheit davon profitiert.

- Menschliche Kontrolle. Menschen sollten entscheiden, wie und ob sie Entscheidungen an KI-Systeme delegieren, um von Menschen gewählte Ziele zu erreichen.

- Keine Subversion. Die durch die Kontrolle hochentwickelter KI-Systeme übertragene Macht sollte die sozialen und staatsbürgerlichen Prozesse, von denen das Funktionieren einer Gesellschaft abhängt, respektieren und verbessern, anstatt sie zu untergraben.

- KI-Wettrüsten. Ein Wettrüsten bei tödlichen autonomen Waffen sollte vermieden werden.

Langfristige Herausforderungen

Dieser Unterabschnitt befasst sich mit der Bedeutung, den Risiken und dem Potenzial, das KI langfristig bieten kann:

- Vorsicht gegenüber KI-Fähigkeiten. Da es keinen Konsens über die Leistungsfähigkeit von KI gibt, sollten Mutmaßungen über die Grenzen zukünftiger KI-Fähigkeiten vermieden werden.

- Bedeutung. Fortgeschrittene KI kann eine tiefgreifende Veränderung in der Geschichte des Lebens auf der Erde darstellen und sollte mit entsprechender Sorgfalt und entsprechenden Ressourcen geplant und umgesetzt werden.

- Risiken. Risiken, die von KI-Systemen ausgehen, insbesondere katastrophale oder existenzielle Risiken, müssen Gegenstand von Planungs- und Minderungsmaßnahmen sein, die in einem angemessenen Verhältnis zu ihren erwarteten Auswirkungen stehen.

- Rekursive Selbstverbesserung. KI-Systeme, die so konzipiert sind, dass sie sich rekursiv selbst verbessern oder selbst replizieren, was zu einer raschen Steigerung der Qualität oder Quantität führen kann, müssen strengen Sicherheits- und Kontrollmaßnahmen unterliegen.

- Gemeinwohl. Superintelligenz sollte nur in den Diensten allgemein geteilter ethischer Ideale und zum Nutzen der gesamten Menschheit und nicht nur eines Staates oder einer Organisation entwickelt werden.